Lakehouse AI: Generative AIアプリケーション構築のためのデータ中心アプローチ

Databricks Model Servingを使用したプライベートLLMのデプロイ

翻訳:Saki Kitaoka. - Original Blog Link

AIモデルを導入してみたものの、実世界で予想外の結果が出たという経験はありませんか?

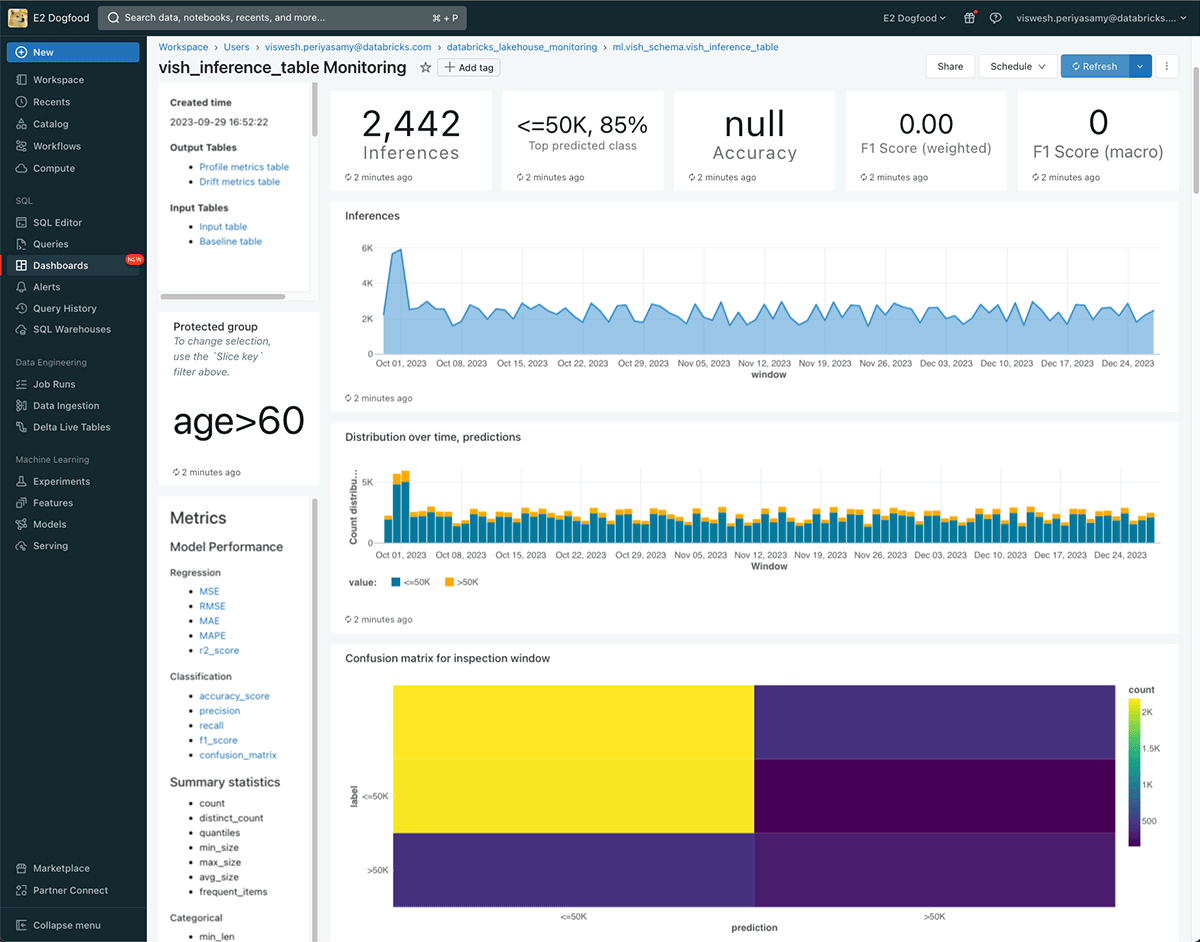

モデルのモニタリングは、そのデプロイと同じくらい重要です。そこで、AIモデルのモニタリングと診断を簡素化するInference Tablesをご紹介します。Inference Tablesを使用すると、 Databricks Model Servingエンドポイントからの入力と予測を継続的にキャプチャし、Unity Catalog Delta Tableに記録することができます。その後、Lakehouse Monitoringなどの既存のデータツールを活用して、AIモデルを監視、デバッグ、最適化できます。

推論テーブルは、LakehouseプラットフォームでAIを実行する際に得られる価値の素晴らしい例です。複雑さやコストを追加することなく、デプロイされたすべてのモデルでモニタリングを有効にすることができます。これにより、問題を早期に検出し、再トレーニングなどのアクションを即座に実行することで、AIモデルから常に最高のビジネス成果を得ることができます。

To enable Inference Tables, fill out the signup form or contact your Databricks representative.

"「Databricks Lakehouse AIは、様々な機械学習モデルをトレーニング、デプロイ、モニタリングするための統一された環境を提供してくれます。推論テーブルを使用することで、デプロイされたモデルの監視とデバッグが可能になり、長期間にわたってモデルのパフォーマンスを維持することができます。これにより、Housing.comでより良いカスタマーエクスペリエンスを提供するために改良されたモデルを提供できるようになりました"— Dr. Anil Goyal, Housing.comの主席データサイエンティスト

推論テーブル(Inference Tables)は、Unity Catalogが管理するDelta Tableで、モデルサービングエンドポイントからのオンライン予測リクエストとレスポンスを保存します。有効化されると、Inference Tablesは、モニタリング、デバッグ、トレーニングコーパスの作成、コンプライアンス監査など、さまざまなユースケースのための強力なツールとなります。推論テーブルは、目的ごとに個別のツールを作成する代わりに、モデルのテーブル表現を提供するため、ML のすべてのステージで一貫したガバナンスとモニタリングのツールを使用できます。

既存お��よび新規のモデル提供エンドポイントにおいて、ワンクリックで推論テーブルを有効にすることができます。予測リクエストとレスポンスがUnity Catalog Governedテーブルに記録されるようになり、これらのテーブルの発見、ガバナンス、チームとの共有が容易になります。

AIとデータ資産の両方のために設計された初のモニタリングソリューションであるLakehouse Monitoringを使用すると、モデルのパフォーマンスとデータのドリフトを継続的に監視できます。Lakehouse Monitoringは、データとMLの品質ダッシュボードを自動的に生成し、関係者と簡単に共有できます。さらに、アラートを有効にすることで、データの基本的なシフトやモデルパフォーマンスの低下に基づいてモデルの再トレーニングが必要なタイミングを知ることができます。この簡素化により、品質はもはや後回しにする必要がなくなり、すべてのエンドポイントで有効にすることができます。

"Databricks Model Servingを使用することで、機械学習モデルのトレーニング、デプロイ、監視、再トレーニングをすべて同じプラットフォーム上で行うことができます。モデルサービング(およびモニタリング)をフィーチャーストアに統合することで、デプロイされたモデルが常に最新で、正確な結果を提供できるようになりました。この合理化されたアプローチにより、可用性や運用上の懸念を心配することなく、AIのビジネスインパクトを最大化することに集中することができます。"— Don Scott, 日立ソリューションズ 製品開発担当副社長

推論テーブルは、必要なすべての重要なデータを記録することにより、デバッグプロセスを簡素化します: HTTP ステータスコード、モデルの実行時間、およびその他のエンドポイント固有の詳細です。一番の利点は 新しいツールを学ぶ必要がありません。Databricks SQLのクエリで推論テーブルを分析したり、高度なポスト分析のためにノートブックでPythonを使用したりすることで、エンドポイントをデバッグできます。

また、推論テーブルの履歴データを使用して、過去のトラフィックを新しいモデルに再生することもできます。この機能�により、モデルのレイテンシーを並べて比較することができます。さらに、このデータをLLM評価スイート(LLM evaluation suite)に結びつけ、安全性と品質についてさまざまなLLMを評価することができます。

Unityカタログのデータを使用すると、推論テーブルとグランドトゥルースラベルを簡単に結合して、モデルを改善するための堅牢なトレーニングコーパスを作成できます。ラベルがない場合は、Labelboxとのパートナーシップを通じてラベルを生成し、推論テーブルと簡単に組み合わせることができます。その後、これらのモデルを微調整したり、Databricks Workflowsを使用して再トレーニングを自動化することもできます。この継続的なフィードバックループにより、モデルから常に最適な予測を得ることができます。