Conjunto de dados distribuído resiliente (RDD)

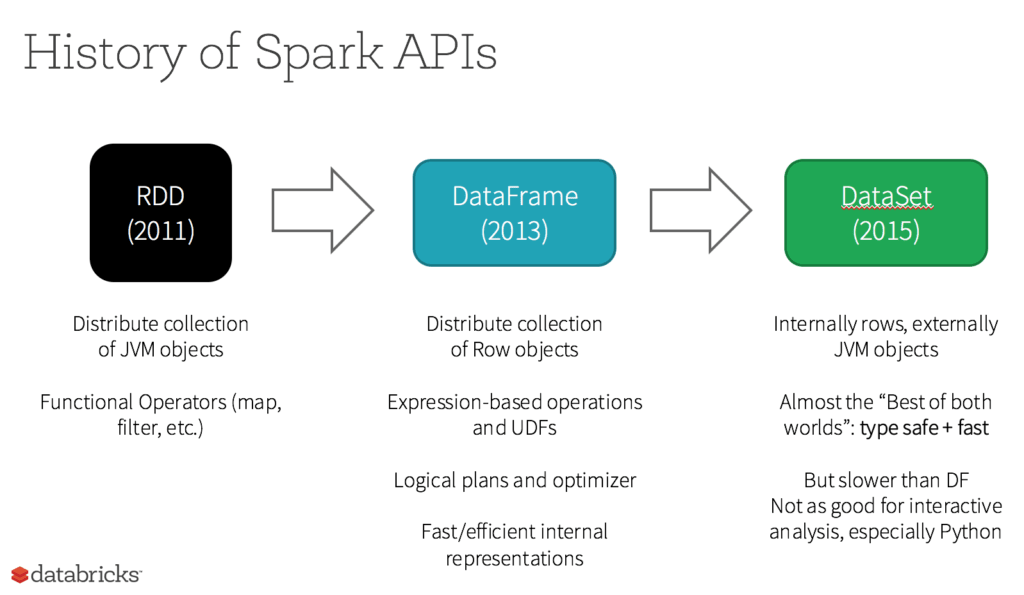

Os conjuntos de dados distribuídos resilientes (RDDs) têm sido a principal API voltada para o usuário do Spark desde seu lançamento. Um RDD é uma coleção imutável de elementos de dados localizados em vários nós em um cluster e pode ser usado juntamente com APIs subjacentes para transformações e outras operações.

Continue explorando

Cinco motivos para usar RDDs

- Para executar transformações, ações e controle de baixo nível em conjuntos de dados;

- Quando seus dados não são estruturados, como streams de mídia ou de texto;

- Para trabalhar com dados em programação funcional em vez de linguagens específicas de domínio;

- Se você não se importar em especificar um esquema, como um formato em colunas, ao manipular ou acessar atributos de dados por nome ou coluna; e

- Se você não precisa dos recursos de otimização e desempenho de DataFrames e conjunto de dados para dados estruturados e semiestruturados.

Qual é a função dos RDDs no Apache Spark 2.0?

Os RDDs são considerados menos importantes? Eles estão ficando obsoletos? A resposta é um NÃO bem enfático! Além disso, você pode alternar perfeitamente entre DataFrames/conjunto de dados e RDDs chamando métodos simples de API, e DataFrames/conjunto de dados são baseados em RDDs.