Como a Home Trust modernizou o processamento em lote com a plataforma de inteligência de dados Databricks e o dbt Cloud

Summary

- A Home Trust migrou para a Plataforma de Inteligência de Dados Databricks e dbt Cloud para superar as limitações de sua solução ETL legada

- A adoção do dbt Cloud facilitou uma melhor colaboração entre as equipes de análise e engenharia

- A Home Trust melhora a experiência do cliente ao aproveitar o Databricks AI/BI Genie para obter insights de seus dados através de consultas em linguagem natural e LLMs para automatizar tarefas como subscrição e geração de e-mails de acompanhamento

Na Home Trust, medimos o sucesso em termos de relacionamentos. Seja trabalhando com indivíduos ou empresas, nos esforçamos para ajudá-los a se manterem “Prontos para o que vem a seguir.”

Manter um passo à frente das necessidades financeiras de nossos clientes significa manter seus dados prontamente disponíveis para análises e relatórios em um armazém de dados corporativo, que chamamos de Plataforma de Análise e Relatórios Domésticos (HARP). Nossa equipe de dados agora usa a Plataforma de Inteligência de Dados Databricks e o dbt Cloud para construir pipelines de dados eficientes para que possamos colaborar em cargas de trabalho de negócios e compartilhá-las com os sistemas parceiros críticos fora da empresa. Neste blog, compartilhamos os detalhes de nosso trabalho com Databricks e dbt e delineamos os casos de uso que estão nos ajudando a ser o parceiro que nossos clientes merecem.

Os perigos do processamento em lote lento

Quando se trata de dados, o HARP é o nosso cavalo de batalha. Mal conseguiríamos administrar nosso negócio sem ele. Esta plataforma engloba ferramentas de análise como Power BI, Alteryx e SAS. Por anos, usamos o IBM DataStage para orquestrar as diferentes soluções dentro do HARP, mas essa solução ETL legada eventualmente começou a ceder sob seu próprio peso. O processamento em lote foi executado durante a noite, terminando tão tarde quanto às 7:00 da manhã e nos deixando pouco tempo para depurar os dados antes de enviá-los para organizações parceiras. Tivemos dificuldades para cumprir nossos acordos de nível de serviço com nossos parceiros.

Não foi uma decisão difícil mudar para a Plataforma de Inteligência de Dados Databricks. Trabalhamos de perto com a equipe do Databricks para começar a construir nossa solução - e tão importante quanto, planejar uma migração que minimizaria as interrupções. A equipe da Databricks recomendou que usássemos o DLT-META, um framework que trabalha com Databricks Delta Live Tables. O DLT-META serviu como nossa especificação de fluxo de dados, o que nos permitiu automatizar os pipelines de dados bronze e prata que já tínhamos em produção.

Ainda enfrentamos o desafio de acelerar uma migração com uma equipe cujas habilidades giravam em torno do SQL. Todas as nossas transformações anteriores em soluções IBM dependiam de codificação SQL. Em busca de uma solução moderna que nos permitisse aproveitar essas habilidades, decidimos pelo dbt Cloud.

Logo desde nosso teste inicial do dbt Cloud, sabíamos que tínhamos feito a escolha certa. Ele suporta uma ampla gama de ambientes de desenvolvimento e fornece uma interface de usuário baseada em navegador, o que minimiza a curva de aprendizado para nossa equipe. Por exemplo, realizamos uma transformação muito familiar baseada em Dimensões Lentamente Mutáveis e reduzimos consideravelmente nosso tempo de desenvolvimento.

Como o lakehouse alimenta nossos processos críticos para a missão

Cada execução de processamento em lote na Home Trust agora depende da Plataforma de Inteligência de Dados Databricks e de nossa arquitetura lakehouse. A casa do lago não apenas garante que podemos acessar dados para relatórios e análises - tão importantes quanto essas atividades são. Ela processa os dados que usamos para:

- Habilitar processos de renovação de empréstimos na comunidade de corretores

- Troca de dados com o Tesouro dos EUA

- Atualizar pontuações FICO

- Envie alertas importantes de fraude empresarial

- Executar nossa fila de recuperação padrão

Em suma, se nosso processamento em lote fosse atrasar, nossa linha de fundo seria afetada. Com o Databricks e o dbt, nosso lote noturno agora termina por volta das 4:00 da manhã, nos dando tempo suficiente para depuração antes de alimentarmos nossos dados em pelo menos 12 sistemas externos. Finalmente temos toda a potência de computação de que precisamos. Não precisamos mais nos apressar para cumprir nossos prazos. Até agora, os custos têm sido justos e previsíveis.

Aqui está como funciona de ponta a ponta:

- Azure Data Factory deposita arquivos de dados no Azure Data Lake Storage (ADLS). Para arquivos de origem SAP, o SAP Data Services deposita os arquivos no ADLS.

- A partir daí, o DLT-META processa as camadas de bronze e prata.

- O dbt Cloud é então usado para transformação na camada de ouro para que esteja pronto para análise downstream.

- Os dados então atingem nossos pipelines designados para atividades como empréstimos, subscrição e recuperação de inadimplência.

- Usamos Databricks Workflows e Azure Data Factory para toda a nossa orquestração entre plataformas.

Nada disso seria possível sem uma intensa colaboração entre nossas equipes de análise e engenharia - o que significa dizer que nada disso seria possível sem o dbt Cloud. Esta plataforma une ambas as equipes em um ambiente onde elas podem realizar seu melhor trabalho. Continuamos adicionando usuários do dbt para que mais de nossos analistas possam construir modelos de dados adequados sem a ajuda de nossos engenheiros. Enquanto isso, nossos usuários do Power BI poderão aproveitar esses modelos de dados para criar relatórios melhores. Os resultados serão maior eficiência e dados mais confiáveis para todos.

A agregação de dados acontece quase suspeitosamente rápido

Dentro da Plataforma de Inteligência de Dados Databricks, dependendo do histórico e do nível de conforto da equipe, alguns usuários acessam o código através de Notebooks enquanto outros usam o Editor SQL.

De longe, a ferramenta mais útil para nós é o Databricks SQL - um armazém de dados inteligente. Antes de podermos alimentar nossos painéis para análises, temos que usar comandos SQL complicados para agregar nossos dados. Graças ao Databricks SQL, muitas ferramentas de análise diferentes, como o Power BI, podem acessar nossos dados porque estão todos em um só lugar.

Nossas equipes continuam a se surpreender com o desempenho dentro do Databricks SQL. Alguns de nossos analistas costumavam agregar dados no Azure Synapse Analytics. Quando começaram a rodar no Databricks SQL, tiveram que verificar novamente os resultados porque não podiam acreditar que um trabalho inteiro foi executado tão rapidamente. Essa velocidade permite que eles adicionem mais detalhes aos relatórios e processem mais dados. Em vez de sentar e esperar que os trabalhos terminem pendentes, eles estão respondendo mais perguntas a partir de nossos dados.

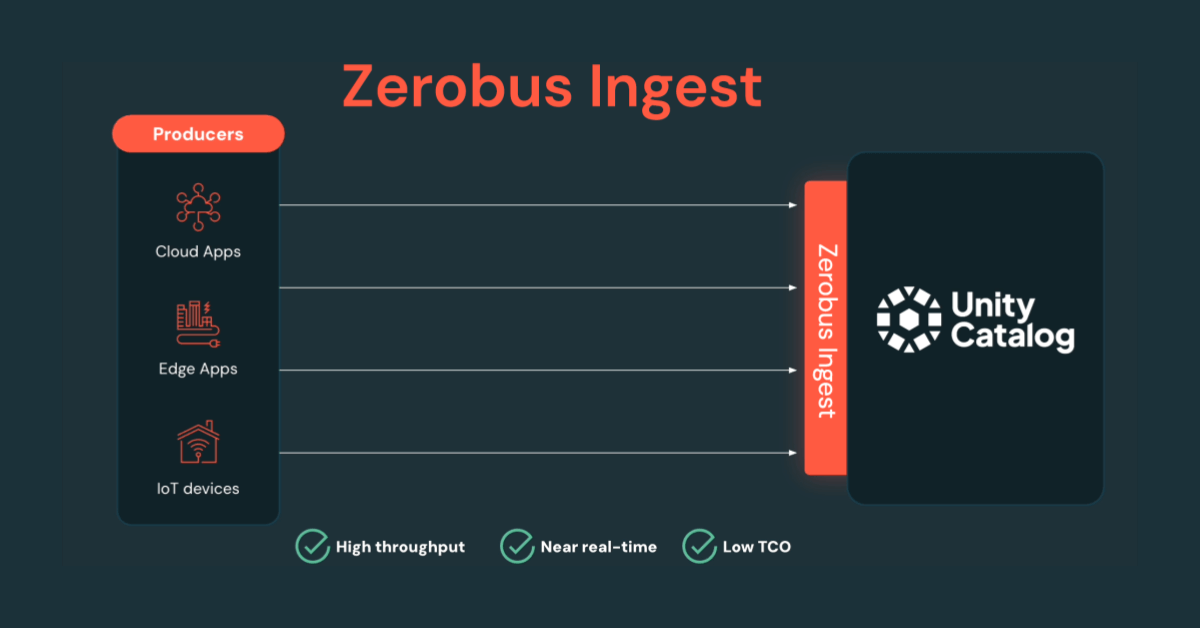

O Catálogo Unity é outra mudança de jogo para nós. Até agora, só implementamos isso para a nossa camada de dados de ouro, mas planejamos estendê-lo para as nossas camadas de prata e bronze eventualmente em toda a nossa organização.

Capacidades de IA integradas fornecem respostas rápidas e simplificam o desenvolvimento

Como todo provedor de serviços financeiros, estamos sempre procurando maneiras de obter mais insights de nossos dados. É por isso que começamos a usar o Databricks AI/BI Genie para interagir com nossos dados através da linguagem natural.

Conectamos o Genie aos nossos dados de empréstimo - nosso conjunto de dados mais importante - após usar o Unity Catalog para mascarar informações pessoalmente identificáveis (PII) e fornecer acesso baseado em funções para a sala Genie. Genie usa IA generativa que entende a semântica única do nosso negócio. A solução continua aprendendo com nosso feedback. Os membros da equipe podem fazer perguntas ao Genie e obter respostas que são informadas por nossos dados proprietários. Genie aprende sobre cada empréstimo que fazemos e pode dizer quantas hipotecas financiamos ontem ou o total de recebíveis pendentes de nosso negócio de cartão de crédito.

Nosso objetivo é usar mais sistemas baseados em NLP como o Genie para eliminar a sobrecarga operacional que vem com a construção e manutenção deles do zero. Esperamos expor o Genie como um chatbot que todos em nossa empresa podem usar para obter respostas rápidas.

Enquanto isso, a Plataforma de Inteligência de Dados Databricks oferece ainda mais capacidades de IA. Databricks Assistant nos permite consultar dados através de Databricks Notebooks e SQL Editor. Podemos descrever uma tarefa em linguagem simples e depois deixar o sistema gerar consultas SQL, explicar segmentos de código e até corrigir erros. Tudo isso nos economiza muitas horas durante a codificação.

Menor sobrecarga significa uma melhor experiência para o cliente

Embora ainda estejamos no nosso primeiro ano com Databricks e dbt Cloud, já estamos impressionados com o tempo e a economia de custos que essas plataformas geraram:

- Menores taxas de licença de software. Com o Catálogo Unity, estamos executando a governança de dados através do Databricks em vez de usar uma plataforma separada. Também eliminamos a necessidade de uma ferramenta ETL legada, executando todas as nossas regras de perfilamento através dos Notebooks Databricks. No total, reduzimos as taxas de licença de software em 70%.

- Processamento em lote mais rápido. Comparado à nossa solução IBM DataStage legada, Databricks e dbt processam nossos lotes 90% mais rápido.

- Codificação mais rápida. Graças à maior eficiência através do Assistente Databricks, nós reduzimos nosso tempo de codificação em 70%.

- Integração mais fácil de novos contratados. Estava ficando difícil encontrar profissionais de TI com 10 anos de experiência com o IBM DataStage. Hoje, podemos contratar novos graduados de bons programas STEM e colocá-los diretamente para trabalhar no Databricks e dbt Cloud. Contanto que eles tenham estudado Python e SQL e usado tecnologias como Anaconda e Jupyter, eles serão uma boa escolha.

- Menos trabalho de subscrição. Agora que estamos dominando as capacidades de IA dentro do Databricks, estamos treinando um grande modelo de linguagem (LLM) para realizar trabalhos de adjudicação. Este projeto sozinho poderia reduzir nosso trabalho de subscrição em 80%.

- Menos tarefas manuais. Usando as capacidades do LLM dentro da plataforma de inteligência de dados Databricks, escrevemos e-mails de acompanhamento para os corretores e os colocamos em nosso sistema CRM como rascunhos. Cada um desses rascunhos economiza alguns minutos valiosos para um membro da equipe. Multiplique isso por milhares de transações por ano, e isso representa uma grande economia de tempo para o nosso negócio.

Com mais de 500 modelos dbt em nossa camada de dados de ouro e cerca de meia dúzia de modelos de ciência de dados no Databricks, a Home Trust está pronta para continuar inovando. Cada uma das melhorias tecnológicas que descrevemos apoia um objetivo inalterado: ajudar nossos clientes a estarem “Prontos para o que vem a seguir.”

Para saber mais, confira este relatório da MIT Technology Review. Apresenta insights de entrevistas aprofundadas com líderes na Apixio, Tibber, Fabuwood, Starship Technologies, StockX, Databricks e dbt Labs.

(This blog post has been translated using AI-powered tools) Original Post

Nunca perca uma postagem da Databricks

O que vem a seguir?

Notícias

December 23, 2024/8 min de leitura