LakeFlow

Ingerir, transformar e orquestrar com uma solução unificada de engenharia de dados

LAKEFLOW NAS MELHORES EMPRESASA solução ponta a ponta para entregar dados de alta qualidade.

Ferramentas que facilitam a criação de pipelines de dados sólidos de analítica e IA para as equipes.Desenvolvimento 85% mais rápido

Redução de 50% nos custos

Redução de 99% na latência do pipeline

2.500 execuções diárias de jobs

A Corning utiliza o LakeFlow para simplificar a orquestração de dados, estabelecendo um processo automatizado e repetível para diversas equipes em toda a organização. Esses fluxos de trabalho automatizados movem grandes quantidades de dados por meio de uma arquitetura medallion, de tabelas de bronze à tabelas de ouro.

Ferramentas unificadas para engenheiros de dados

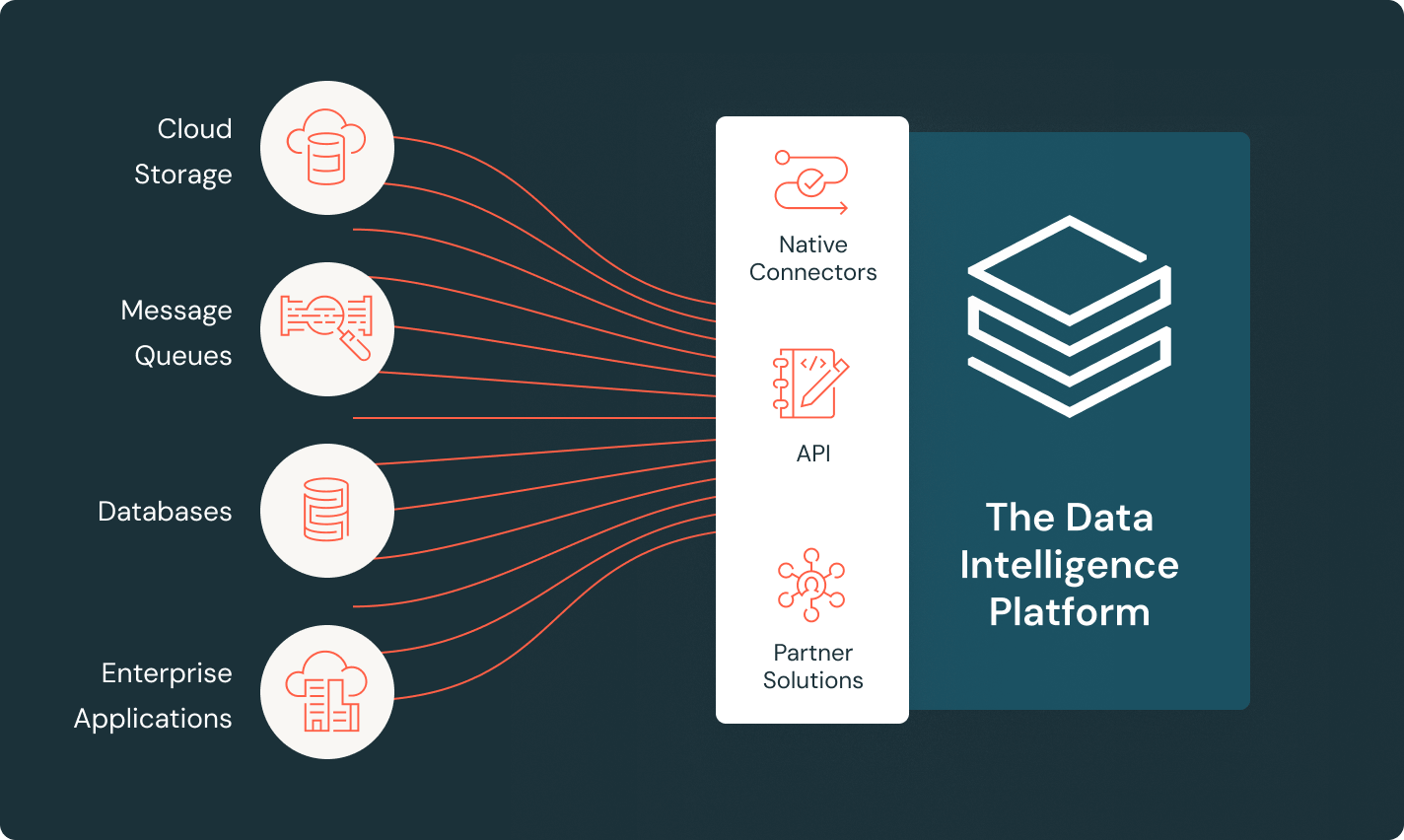

LakeFlow Connect

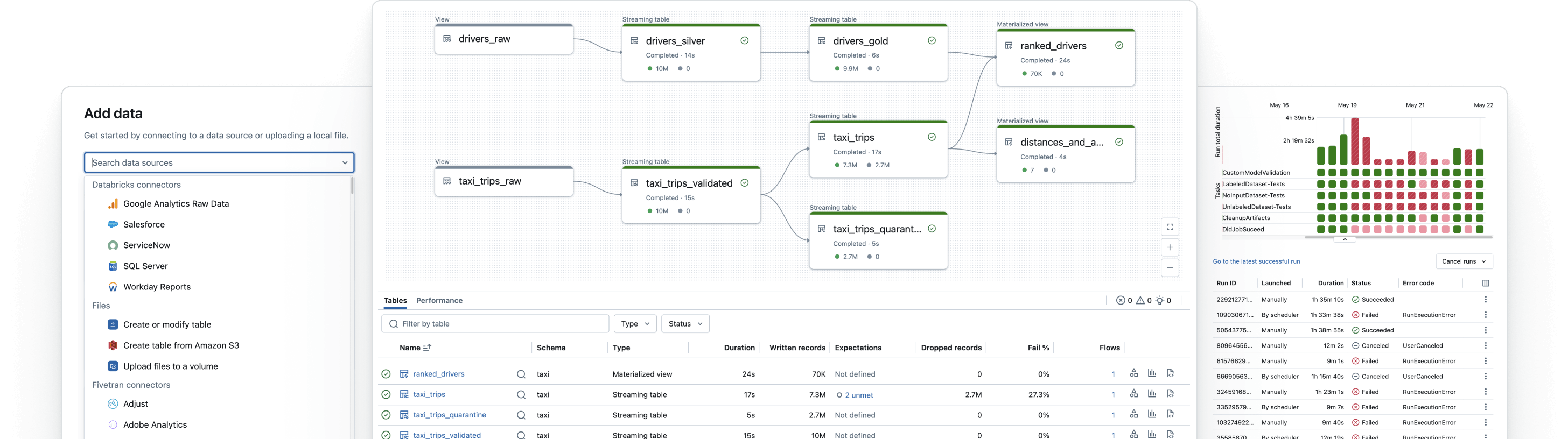

Conectores eficientes de ingestão de dados e integração nativa com o Data Intelligence Platform facilitam o acesso à analítica e IA, com governança unificada.

Spark Declarative Pipelines

Simplifique o ETL em lotes e transmissão com qualidade de dados automatizada, captura de dados de alterações (CDC), ingestão de dados, transformações e governança unificada.

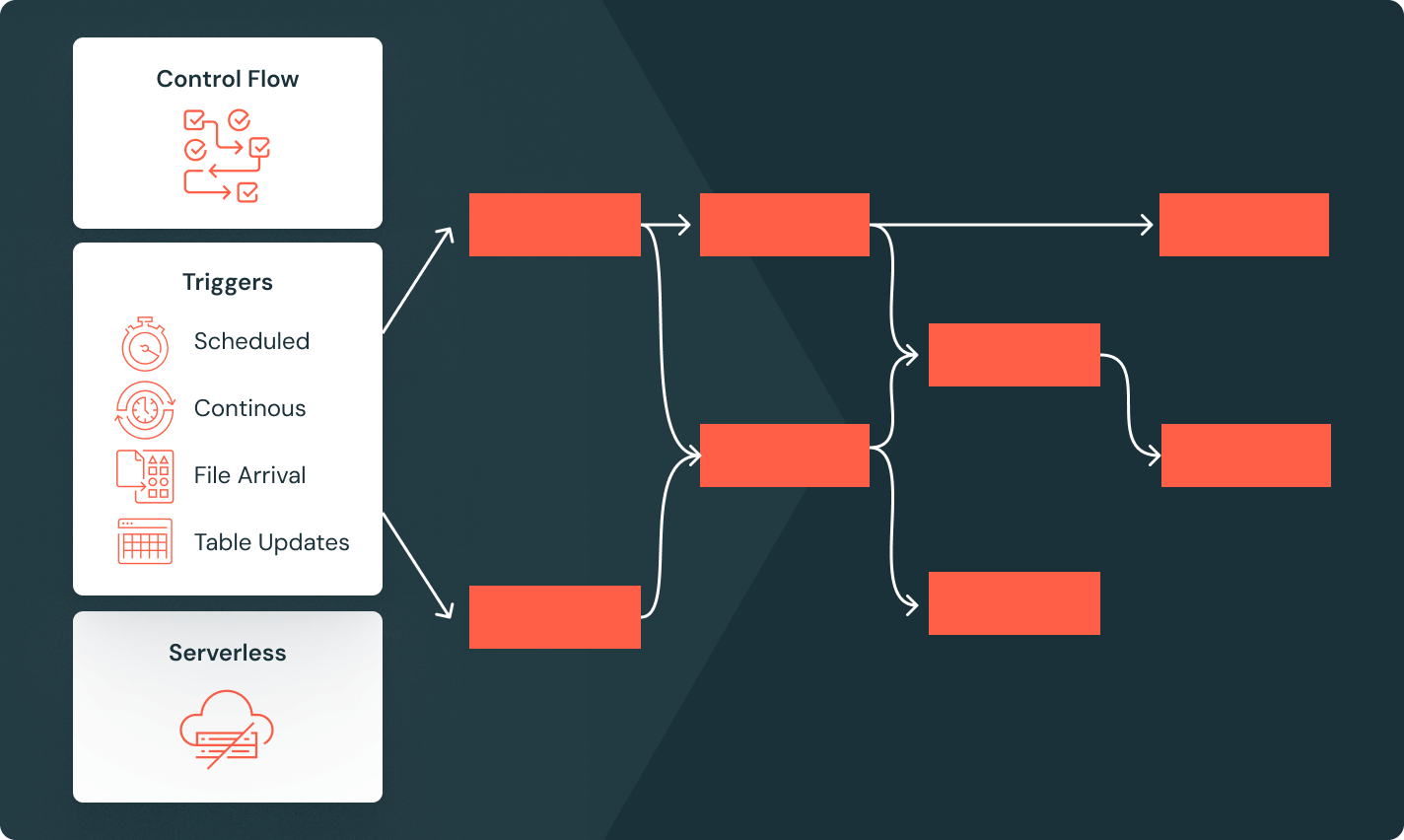

Jobs do Lakeflow

Capacite as equipes para automatizar e orquestrar melhor qualquer fluxo de trabalho de ETL, analítica e IA com observabilidade detalhada, alta confiabilidade e amplo suporte a tipos de tarefas.

Unity Catalog

Governe sem esforço todos os seus ativos de dados com a única solução de governança unificada e aberta do setor para dados e AI, integrada à Databricks Data Intelligence Platform.

Armazenamento lakehouse

Unifique os dados em seu lakehouse, em todos os formatos e tipos, para todas as suas cargas de trabalho de analytics e AI.

Plataforma de inteligência de dados

Aproveite a grande variedade de ferramentas disponíveis na Databricks Data Intelligence Platform para integrar dados e AI em toda a sua organização.

Crie pipelines de dados confiáveis

Desbloqueie o valor dos seus dados, não importa onde eles estejam

Insira todos os seus dados no Data Intelligence Platform usando os conectores do LakeFlow para arquivar fontes, aplicativos empresariais e bancos de dados. Conectores totalmente gerenciados que utilizam processamento incremental de dados oferecem uma ingestão eficiente, e a governança integrada mantém você no controle dos seus dados através do pipeline.

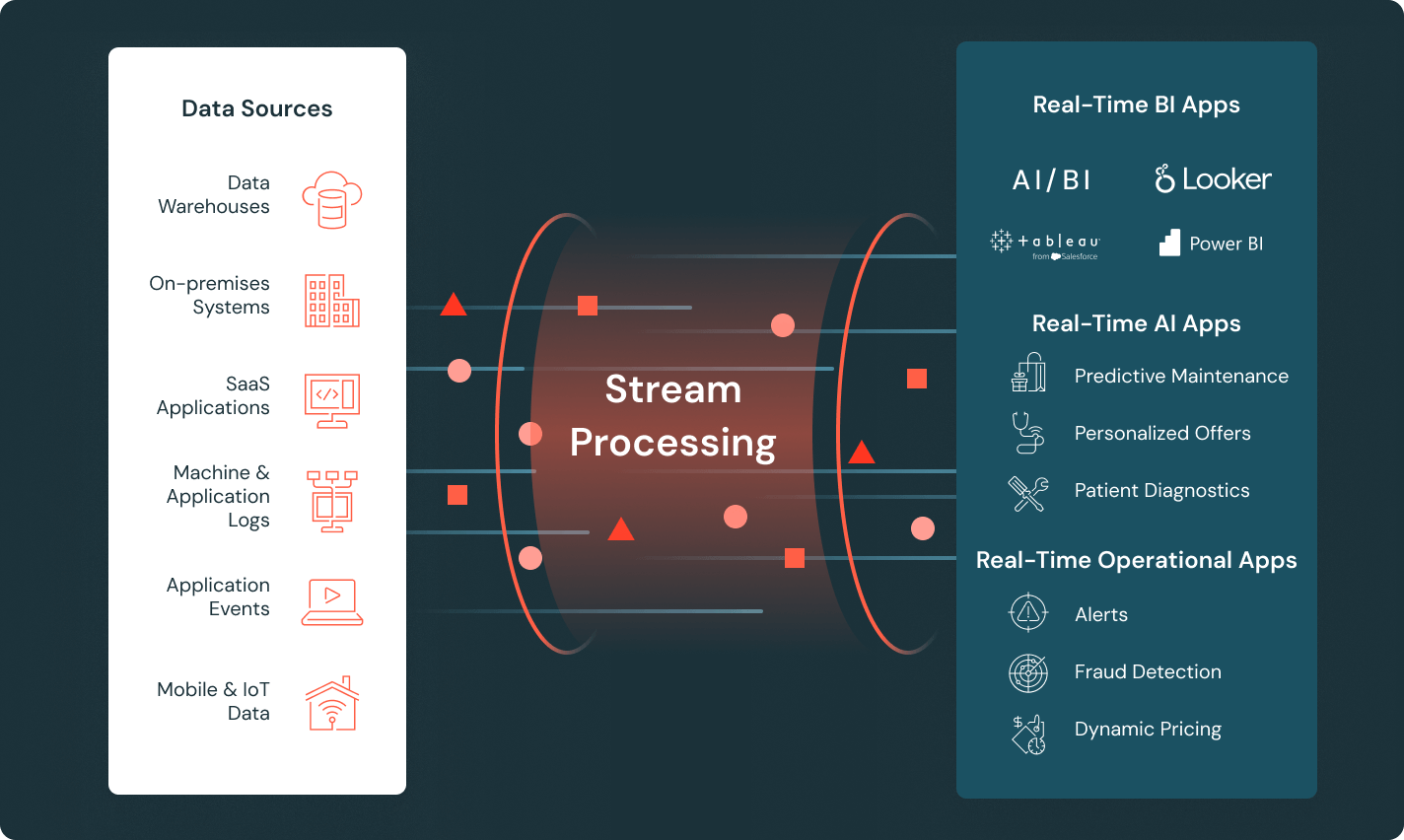

Forneça dados atualizados para obter insights em tempo real

Crie pipelines que processam dados recebidos em tempo real a partir de sensores, fluxos de cliques e dispositivos IoT, alimentando aplicativos em tempo real. Reduza a complexidade operacional com os Spark Declarative Pipelines e use tabelas de transmissão para um desenvolvimento simplificado de pipelines.

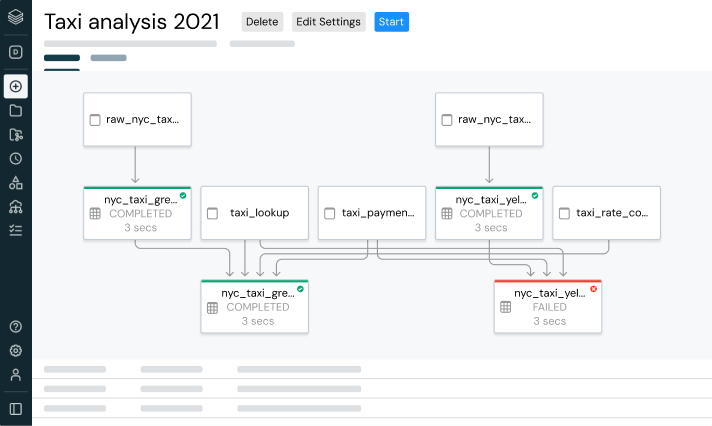

Orquestre fluxos de trabalho complexos com facilidade

Defina fluxos de trabalho confiáveis de analítica e IA com um orquestrador gerenciado integrado à sua plataforma de dados. Implemente DAGs complexos com facilidade usando recursos aprimorados de fluxo de controle, como execução condicional, looping e uma variedade de triggers de job.

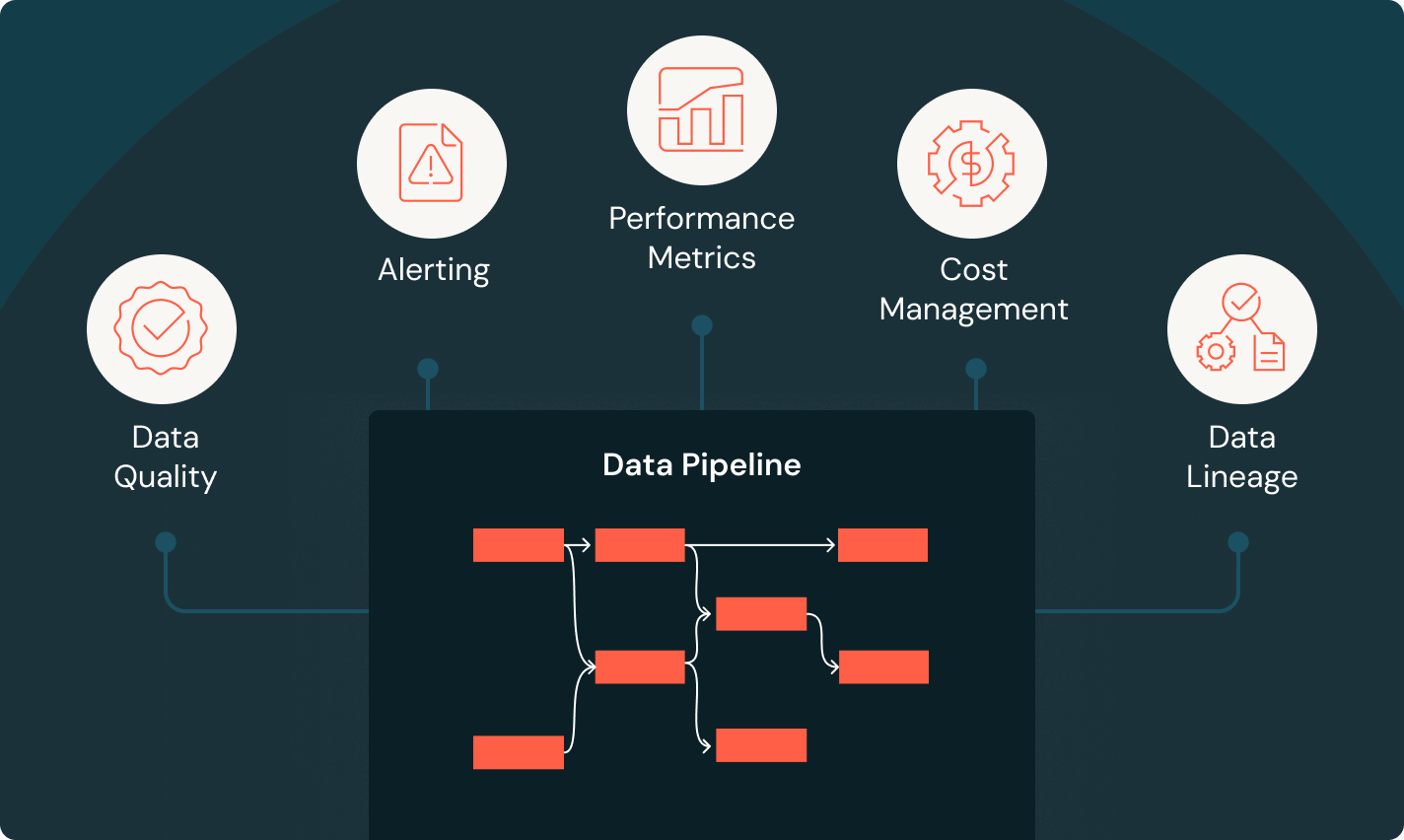

Monitore cada etapa de cada pipeline

Obtenha uma visibilidade completa da saúde do pipeline por meio de métricas abrangentes e em tempo real. Alertas personalizados garantem que você saiba exatamente o momento da ocorrência de problemas, e visuais detalhados mostram a causa principal da falha para que você possa solucioná-la rapidamente. Com acesso a um monitoramento de ponta a ponta, você consegue controlar seus dados e pipelines.

Dê um passo adiante

Conteúdo relacionado

Perguntas frequentes sobre a engenharia de dados

Pronto para se tornar uma empresa de dados + AI?

Dê os primeiros passos na transformação dos seus dados