Aprendizado de Máquina com o Catálogo Unity no Databricks: Melhores Práticas

Summary

- Construa e implante modelos de ML de maneira contínua com o Catálogo Unity, desde o pré-processamento de dados até o treinamento e implantação do modelo.

- Garanta a colaboração segura aproveitando o controle de acesso baseado em funções, clusters de grupos e recursos de governança.

- Otimize recursos de computação com clusters de grupo dedicados e Delta Live Tables para fluxos de trabalho de ML eficientes.

Construir uma plataforma de IA ou ML de ponta a ponta geralmente requer várias camadas tecnológicas para armazenamento, análise, ferramentas de inteligência de negócios (BI) e modelos de ML para analisar dados e compartilhar aprendizados com as funções de negócios. O desafio é implantar controles de governança consistentes e eficazes em diferentes partes com diferentes equipes.

O Catálogo Unity é a camada de metadados centralizada e integrada do Databricks, projetada para gerenciar o acesso aos dados, segurança e linhagem. Também serve como base para busca e descoberta dentro da plataforma. O Catálogo Unity facilita a colaboração entre equipes, oferecendo recursos robustos como controle de acesso baseado em funções (RBAC), rastreamento de auditoria e mascaramento de dados, garantindo que as informações sensíveis sejam protegidas sem prejudicar a produtividade. Ele também suporta os ciclos de vida de ponta a ponta para modelos de ML.

Este guia fornecerá uma visão geral abrangente e diretrizes sobre como usar catálogos unity para casos de uso de aprendizado de máquina e colaboração entre equipes, compartilhando recursos de computação.

Este post de blog leva você através dos passos para o ciclo de vida completo de aprendizado de máquina com as características vantajosas com catálogos de unidade no Databricks.

O exemplo neste artigo usa o conjunto de dados contendo registros para o número de casos do vírus COVID-19 por data nos EUA, com informações geográficas adicionais. O objetivo é prever quantos casos do vírus ocorrerão nos próximos 7 dias nos EUA.

Principais Características para ML no Databricks

A Databricks lançou várias funcionalidades para ter um melhor suporte para ML com o catálogo unity

- Databricks Runtime para Machine Learning (Databricks Runtime ML): automatiza a criação de um cluster com infraestrutura de aprendizado de máquina e aprendizado profundo pré-construída, incluindo as bibliotecas ML e DL mais comuns.

- Clusters de grupo dedicados: crie um recurso de computação Databricks Runtime ML atribuído a um grupo usando o modo de acesso dedicado

- Controle de acesso refinado no modo de acesso delicado: permite controle de acesso refinado em consultas que são executadas no Databricks Runtime ML no modo de acesso dedicado. Isso suportará visões materializadas, tabelas de streaming e visões padrão.

Requisitos

- O espaço de trabalho deve estar habilitado para o Catálogo Unity. Os administradores do espaço de trabalho podem verificar o documento para mostrar como habilitar espaços de trabalho para o catálogo unity.

- Você deve usar o Databricks Runtime 15.4 LTS ML ou superior.

- Um administrador de espaço de trabalho deve habilitar a pré-visualização de clusters de grupo dedicado do Compute usando a interface do usuário de pré-visualizações. Veja Gerenciar pré-visualizações do Databricks.

- Se o espaço de trabalho tiver o Secure Egress Gateway (SEG) ativado, pypi.org deve ser adicionado à lista de domínios permitidos. Veja Gerenciando políticas de rede para controle de saída sem servidor.

Configure um grupo

Para possibilitar a colaboração, um administrador de conta ou um administrador de espaço de trabalho precisa configurar um grupo por

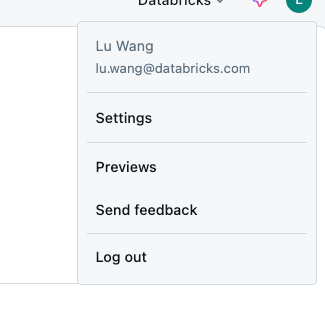

- Clique no seu ícone de usuário no canto superior direito e clique em Configurações

- Na seção “Administração do Espaço de Trabalho”, clique em “Identidade e acesso”, depois clique em “Gerenciar” na seção Grupos

- Clique em “Adicionar grupo”,

- clique em “Adicionar novo”

- Insira o nome do grupo e clique em Adicionar

- Procure pelo seu grupo recém-criado e verifique se a coluna Fonte diz “Conta”

- Clique no nome do seu grupo nos resultados da pesquisa para ir aos detalhes do grupo

- Clique na aba "Membros" e adicione os membros desejados ao grupo

- Clique na aba "Entitlements" e marque tanto o "Workspace access" quanto o "Databricks SQL access" entitlements

- Se você quiser ser capaz de gerenciar o grupo a partir de qualquer conta não administrativa, você pode conceder acesso “Grupo: Gerente” à conta na aba “Permissões”

- NOTA: a conta do usuário DEVE ser membro do grupo para usar clusters de grupo - ser um gerente de grupo não é suficiente.

Habilite clusters de grupo dedicado

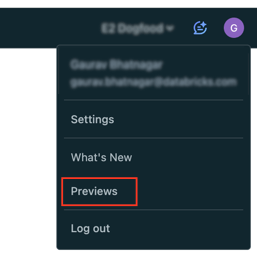

Clusters de grupo dedicado estão em pré-visualização pública, para habilitar o recurso, o administrador do espaço de trabalho deve habilitar o recurso usando a interface do usuário de pré-visualizações.

- Clique no seu nome de usuário na barra superior do espaço de trabalho Databricks.

- No menu, selecione Previews.

- Use a opção Ativar para Computar: Grupos de clusters dedicados para habilitar ou desabilitar pré-visualizações.

Criar Grupo de cálculo

O modo de acesso dedicado é a versão mais recente do modo de acesso para usuário único. Com acesso dedicado, um recurso de computação pode ser atribuído a um único usuário ou grupo, permitindo apenas ao(s) usuário(s) atribuído(s) o acesso para usar o recurso de computação.

Para criar um tempo de execução do Databricks com ML com

- No seu espaço de trabalho Databricks, vá para Computação e clique em Criar computação.

- Marque "Machine learning" na seção Desempenho para escolher o runtime Databricks com ML. Escolha “15.4 LTS” no Databricks Runtime. Selecione os tipos de instância desejados e o número de trabalhadores conforme necessário.

- Expanda a seção Avançada na parte inferior da página.

- Em Modo de acesso, clique em Manual e então selecione Dedicado (anteriormente: Único usuário) no menu suspenso.

- No campo usuário único ou grupo, selecione o grupo que você deseja atribuir a este recurso.

- Configure as outras configurações de computação desejadas conforme necessário e clique em Criar.

Após a inicialização do cluster, todos os usuários do grupo podem compartilhar o mesmo cluster. Para mais detalhes, veja melhores práticas para gerenciar clusters de grupo.

Pré-processamento de Dados via Delta live table (DLT)

Nesta seção, nós iremos

- Leia os dados brutos e salve no Volume

- Leia os registros da tabela de ingestão e use as expectativas do Delta Live Tables para criar uma nova tabela que contém dados limpos.

- Use os registros limpos como entrada para consultas Delta Live Tables que criam conjuntos de dados derivados.

Para configurar um pipeline DLT, você pode precisar das seguintes permissões:

- USE CATALOG, PROCURE pelo catálogo pai

- TODOS OS PRIVILÉGIOS ou USE SCHEMA, CRIE VISÃO MATERIALIZADA, e CRIE privilégios de TABELA no esquema alvo

- TODOS OS PRIVILÉGIOS ou LEIA VOLUME e ESCREVA VOLUME no volume alvo

- Baixe os dados para o Volume: Este exemplo carrega dados de um volume do Catálogo Unity. Substitua <catalog-name>, <schema-name> e <volume-name> pelos nomes do catálogo, esquema e volume para um volume do Catálogo Unity. O código fornecido tenta criar o esquema e o volume especificados se esses objetos não existirem. Você deve ter os privilégios apropriados para criar e escrever em objetos no Catálogo Unity. Veja Requisitos.

- Criar pipeline Para configurar um novo pipeline, faça o seguinte:

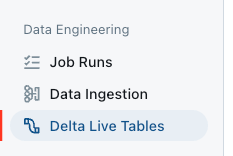

- Na barra lateral, clique em Delta Live Tables na seção Engenharia de Dados.

- Clique em Criar pipeline.

- Em Nome do Pipeline, digite um nome único para o pipeline.

- Selecione a caixa de seleção Serverless.

- Em Destino, para configurar um local do Catálogo Unity onde as tabelas são publicadas, selecione um Catálogo e um Esquema.

- Em Avançado, clique em Adicionar configuração e então defina os parâmetros do pipeline para o catálogo, esquema e volume para os quais você baixou os dados usando os seguintes nomes de parâmetros:

- meu_catálogo

- meu_esquema

- my_volume

- Clique em Criar.

A interface do usuário de pipelines aparece para o novo pipeline. Um notebook de código-fonte é automaticamente criado e configurado para o pipeline.

- Na barra lateral, clique em Delta Live Tables na seção Engenharia de Dados.

- Declare visualizações materializadas e tabelas de streaming. Você pode usar os notebooks Databricks para desenvolver e validar interativamente o código-fonte para os pipelines Delta Live Tables.

- Clique no link sob o campo Código fonte no painel de detalhes do Pipeline para abrir o notebook

- Desenvolva código com Python ou SQL. Para detalhes, veja Desenvolver código de pipeline com Python ou Desenvolver código de pipeline com SQL.

- Clique no link sob o campo Código fonte no painel de detalhes do Pipeline para abrir o notebook

- Inicie uma atualização de pipeline clicando no botão iniciar no canto superior direito do notebook ou na UI do DLT. O DLT será gerado para o catálogo e esquema definido pelo DLT

`<my_catalog>.<my_schema>`.

Treinamento de modelo na visualização materializada do DLT

Vamos lançar um experimento de previsão sem servidor na visualização materializada gerada pelo DLT.

- clique em Experimentos na barra lateral na seção Aprendizado de Máquina

- No bloco Previsão, selecione Iniciar treinamento

- Preencha os formulários de configuração

- Selecione a visualização materializada como os dados de Treinamento:

`<my_catalog>.<my_schema>.covid_case_by_date` - Selecione a data como a coluna de Tempo

- Selecione Dias na Frequência de previsão

- Insira 7 no horizonte

- Selecione casos na coluna alvo na seção Previsão

- Selecione Registro de modelo como

`<my_catalog>.<my_schema>`

- Clique em Iniciar treinamento para iniciar o experimento de previsão.

- Selecione a visualização materializada como os dados de Treinamento:

Após a conclusão do treinamento, os resultados da previsão são armazenados na tabela Delta especificada e o melhor modelo é registrado no Catálogo Unity.

Da página de experimentos, você escolhe entre as seguintes próximas etapas:

- Selecione Ver previsões para ver a tabela de resultados de previsão.

- Selecione o caderno de inferência em lote para abrir um caderno gerado automaticamente para inferência em lote usando o melhor modelo.

- Selecione Criar ponto de atendimento para implantar o melhor modelo em um ponto de atendimento de Model Serving.

Conclusão

Neste blog, exploramos o processo de ponta a ponta de configuração e treinamento de modelos de previsão no Databricks, desde a pré-processamento de dados até o treinamento do modelo. Ao aproveitar catálogos de unidade, clusters de grupo, tabela delta ao vivo e previsão AutoML, conseguimos simplificar o desenvolvimento do modelo e simplificar as colaborações entre as equipes.

(This blog post has been translated using AI-powered tools) Original Post

Nunca perca uma postagem da Databricks

O que vem a seguir?

Produto

June 12, 2024/11 min de leitura