VisitBritain: Extraindo Insights Oportunos sobre o Sentimento do Viajante

Usando LLMs para Tornar Campanhas de Turismo Mais Efetivas

Summary

- VisitBritain transformou sua pesquisa de mercado usando IA para extrair insights acionáveis de dados de pesquisa não estruturados em escala.

- Usando o Databricks Mosaic AI, o VisitBritain aplicou LLMs para análise de sentimento automatizada, pontuação de relevância e classificação de tópicos.

- Integrando a plataforma orientada por IA da Databricks, VisitBritain preparou suas capacidades de pesquisa para se adaptar às tendências de viagem em evolução.

Introdução

VisitBritain é o site oficial para turismo no Reino Unido, projetado para ajudar os visitantes a planejar suas viagens e obter recomendações sobre os principais destinos, tanto históricos quanto modernos. A equipe da VisitBritain enfrentou novos desafios após a pandemia da COVID-19 mudar como e por que as pessoas escolhem visitar o Reino Unido. Outras tendências macro, como as mudanças climáticas (temperaturas mais altas no verão) e demográficas (expectativa de vida aumentada), também estavam impactando as previsões de viagem. VisitBritain sabia que precisava se manter atualizado e adaptar suas abordagens para atender às necessidades em constante mudança dos viajantes. Trabalhando com a Redshift (uma empresa da Accenture), a resposta se tornou clara: a implementação de ferramentas de dados e IA permitiria que eles mudassem de direção rapidamente - e efetivamente.

Pesquisa Primária Fornece Insights Cruciais

Pesquisas primárias com viajantes expandem a compreensão do sentimento do viajante além dos dados de mobilidade (fluxo de pessoas), dados de gastos (empresas de cartão de crédito) e informações de hotéis e voos que exigem um salto inferencial para entender os motivos pelos quais as pessoas viajam. Pesquisas tradicionais de agências terceirizadas muitas vezes ignoram insights valiosos ao se concentrarem em respostas pré-codificadas de múltipla escolha, em vez de respostas abertas. No entanto, os dados de texto livre de respostas abertas apresentam um novo desafio de análise.

Na VisitBritain, queríamos aumentar o número de turistas usando nossos serviços. Contamos com campanhas publicitárias para envolver e inspirar visitantes. Para avaliar o impacto da campanha, realizamos pesquisas de mercado que geram grandes volumes de respostas de texto livre dos turistas. Historicamente, extrair insights dessas respostas tem sido um processo incrivelmente manual e demorado; muitas vezes, os insights chegam tarde demais para ter qualquer impacto nas campanhas atuais. Também não é um processo consistente e imparcial. Respostas em vários idiomas adicionam uma camada extra de complexidade devido ao processo de tradução. O resultado final é uma luta contínua para obter perspectivas e sentimentos matizados dos respondentes às nossas pesquisas.

Precisávamos de uma solução que pudesse simplificar esse processo de análise e melhorar nosso entendimento do sentimento dos turistas para que pudéssemos reforçar a tomada de decisões relacionadas à campanha enquanto eliminamos respostas não informativas.

“Queríamos aproveitar o GenAI para reestruturar nossos dados de sentimento para facilitar o acesso à consulta, mas também para encontrar coisas que de outra forma não saberíamos. Criamos um termômetro de dados instantâneo para nossa pesquisa primária. Em vez de dedicar dias ou até semanas para analisar a qualidade dos dados, podemos obter uma pontuação de qualidade dos dados em segundos.” — Satpal Chana, Diretor Adjunto de Dados, Análises e Insights, VisitBritain

Um Sistema de Agente AI para o Resgate

Para enfrentar o desafio em questão, utilizamos o poder do “Viewpoint”, nossa plataforma de inteligência de dados corporativa personalizada, com o Databricks Mosaic AI que usou vários modelos de linguagem grande (LLMs) como o OpenAI GPT-4 em vez de ferramentas de processamento de linguagem natural (NLP). Fizemos isso por três principais motivos:

- Tempo para implementar: LLMs têm mais probabilidade de funcionar imediatamente e dependem menos de habilidades especializadas

- Reutilização: LLMs podem naturalmente se estender a outros casos de uso que envolvem análise de texto

- Resumo: LLMs são melhores em resumir com precisão o significado pretendido do texto de entrada

Em seguida, preparamos os dados traduzindo-os (quando necessário) e filtrando respostas de baixa qualidade. Em uma pesquisa típica com 1900 visitantes, fizemos 7 perguntas de texto livre, recebemos 27K respostas de texto livre, filtramos quaisquer respostas rotuladas como “ruins” ou “inúteis” e mantivemos respostas rotuladas como “excelentes” ou “vagas”. Por exemplo, uma resposta recebida em alemão que dizia “Mir fallt nichs ein” foi primeiro traduzida para “Não consigo pensar em nada” e depois classificada como inútil.

Para os 48% das respostas que mantivemos, usamos o LLM para então examinar o sentimento, a emoção e os tópicos mencionados. O modelo classificou o sentimento como positivo ou negativo, classificou o conteúdo emocional da resposta e, em seguida, classificou o tópico em uma das três categorias pré-definidas. Finalmente, o LLM classificou os tópicos por prevalência nas respostas. Em seguida, alimentamos as pontuações em tabelas de nível ouro dentro da arquitetura Databricks Medallion. Descobrimos que alguns dos dados mais úteis vieram de respostas críticas. Por exemplo, uma resposta que mencionou o alto custo de uma atividade indicou que deveríamos incluir mais mensagens sobre valor em publicidade futura. Usamos a solicitação de poucos tiros para derivar a pontuação de relevância e a polaridade do sentimento, usando os diferentes LLMs que atribuímos a essas tarefas. Finalmente, pedimos aos LLMs para criar resumos de tópicos e de campanhas das respostas.

Olhando para Trás e para Frente com Databricks

Para avaliar os resultados do nosso sistema de agente AI, tínhamos três opções principais:

- Humano no loop: Uma revisão manual da saída do LLM para ver se é precisa. Este método é eficaz, mas custoso.

- LLM-como-juiz: Avalie as respostas em escala com outro LLM, depois teste esse LLM juiz em um conjunto de dados de amostra para ver se os resultados são satisfatórios.

- Correspondência exata: As respostas são comparadas a um conjunto de dados rotulado e verdadeiro, que deve ser correspondido com base em uma métrica "suficientemente boa", como 90% de precisão.

Além da pontuação de relevância e resumo, contamos principalmente com o LLM como juiz para nossas métricas de avaliação. Tínhamos um conjunto de dados de treinamento que usamos como fonte de verdade ao desenvolver e testar diferentes funcionalidades. Uma vez que estávamos satisfeitos com os resultados iniciais, então os compararíamos com um modelo registrado no conjunto de dados de teste para não estarmos superajustando aos nossos dados de verdade. Em um determinado momento, atingimos um platô em termos da qualidade das respostas. Depois voltamos e revisamos nosso conjunto de dados de verdade, que dependia da revisão humana no loop, e encontramos algumas inconsistências, então voltamos e fizemos algumas correções em como estávamos revisando as respostas com base nos insights de nossos LLMs.

Começamos nossa jornada de transformação de dados cerca de dois anos atrás; tínhamos uma visão clara de onde queríamos que nossos dados estivessem e como queríamos usá-los. Avaliamos várias arquiteturas de dados para ver o que melhor apoiaria nossas necessidades. No final, escolhemos o Databricks devido à força de seu roadmap futuro. Tínhamos confiança de que qualquer recurso relevante que pudéssemos precisar estaria disponível no Databricks no futuro. Essa confiança foi bem colocada, pois conseguimos implantar rapidamente nosso termômetro de dados baseado em GenAI. Também apreciamos a abordagem modular e de código aberto do Databricks, que facilitou muito nosso processo de desenvolvimento e avaliação.

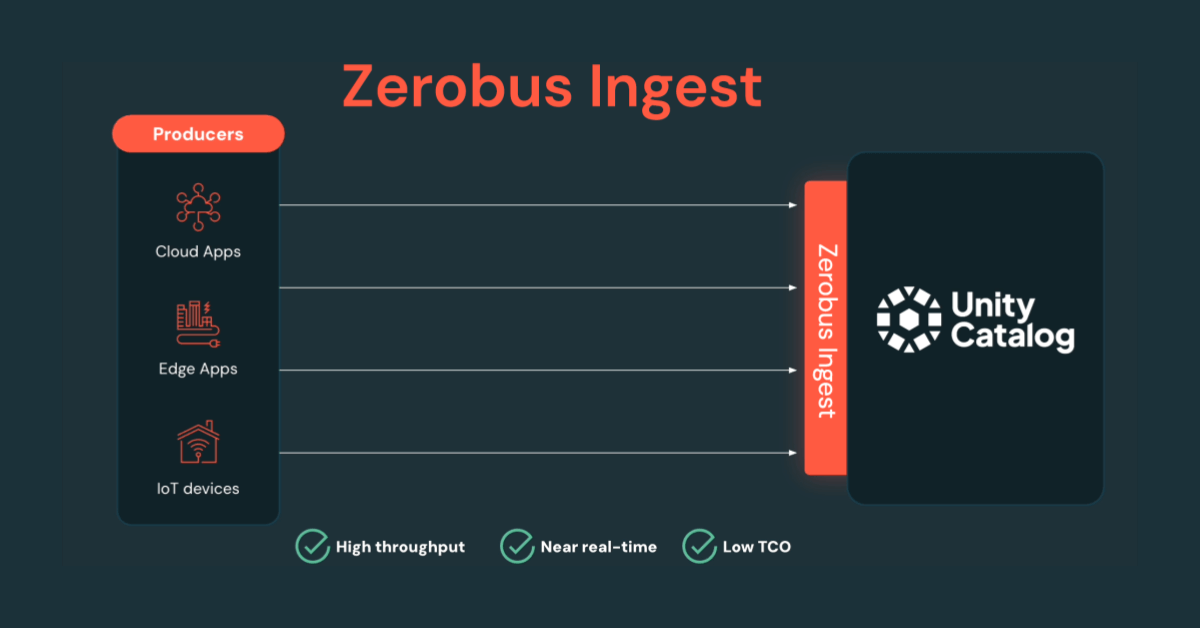

Analisando nossa arquitetura atual, armazenamos dados e contamos com o Unity Catalog para permitir o acesso baseado em permissões para que os usuários possam consultar dados de produção a partir de ambientes de desenvolvimento. O MLflow integrado ao Databricks nos permite comparar facilmente os resultados do LLM lado a lado e usar o LLM como um juiz como uma maneira de baixo código para avaliar dados em escala.

“A Plataforma de Inteligência de Dados da Databricks nos permitiu comparar facilmente diferentes modelos e os tipos de resultados que estávamos obtendo deles.” — Satpal Chana

“A melhor parte deste projeto tem sido obter insights de fontes que nunca teríamos encontrado de outra forma. Até colegas que têm um conhecimento extenso desses ativos de dados estão encontrando coisas que não esperavam encontrar, após apenas uma passagem.” — Satpal Chana

Vimos algum valor inesperado deste projeto; por exemplo, outras equipes podem aproveitar este proof of concept para avaliar respostas a outras pesquisas. Outro benefício tem sido a capacidade de melhorar nosso processo de pesquisa. Agora, quando as pessoas enviam respostas fora de uma lista suspensa, conseguimos obter informações de suas respostas de texto livre que nos ajudam a formular perguntas mais pertinentes no futuro. Olhando para o futuro, o fato de o Databricks estar na vanguarda da inovação é fundamental. Por exemplo, podemos alternar facilmente entre os endpoints do modelo. Isso nos permite iterar na mais recente e melhor tecnologia GenAI, ajudando-nos a atender às necessidades da indústria do turismo no Reino Unido - agora e no futuro.

(This blog post has been translated using AI-powered tools) Original Post

Nunca perca uma postagem da Databricks

O que vem a seguir?

Notícias

December 23, 2024/8 min de leitura