State of Data + AI

La data intelligence e la corsa alla personalizzazione degli LLM

Strategia Data + AI

La corsa delle organizzazioni alla democratizzazione di dati e AI

Tutte le aziende vogliono sfruttare gli effetti dell'AI generativa. Tutte vogliono mettere la potenza della data intelligence nelle mani di tutti i dipendenti. Ma con le informazioni bloccate nei silos e la gestione dei dati suddivisa tra vari strumenti, i team hanno spesso difficoltà ad accelerare questi progetti.

Tra i leader aziendali, la domanda pressante è: qual è il modo migliore e più veloce per democratizzare l'AI?

Il report State of Data + AI fornisce un'istantanea sulle strategie adottate dalle organizzazioni per dare la priorità alle iniziative basate sull'AI. Analizzando i dati di utilizzo anonimi dei 10.000 clienti che oggi si affidano alla Databricks Data Intelligence Platform , tra cui oltre 300 aziende Fortune 500, siamo in grado di fornire una panoramica esclusiva sugli sforzi delle aziende per accelerare l'adozione dell'AI generativa nelle loro attività e degli strumenti che le aiutano a farlo.

Scopri le strategie adottate dalle aziende più innovative per sfruttare con successo il machine learning, usare l'AI generativa e rispondere a esigenze di governance in continua evoluzione. E scopri come la tua azienda può entrare nell'era dell'Enterprise AI sviluppando una strategia dei dati in grado di adattarsi a un panorama in continuo cambiamento.

Ecco un riassunto di ciò che abbiamo scoperto:

L'AI è in produzione

La produzione di modelli AI è più che decuplicata

Da anni le aziende sperimentano il machine learning (ML), una componente fondamentale dell'AI. Molte hanno incontrato difficoltà (silos di dati, flussi di lavoro complessi da implementare, governance) nel tradurre la sperimentazione controllata sul ML in applicazioni del mondo reale in produzione. Oggi assistiamo a un crescente successo di questi sforzi. In tutte le organizzazioni, quest'anno è stato registrato un aumento del 1.018% nella produzione di modelli rispetto all'anno scorso. Addirittura, per la prima volta da quando conduciamo la nostra ricerca, la crescita dei modelli registrati ha superato la crescita degli esperimenti registrati, che sono comunque aumentati del 134%.

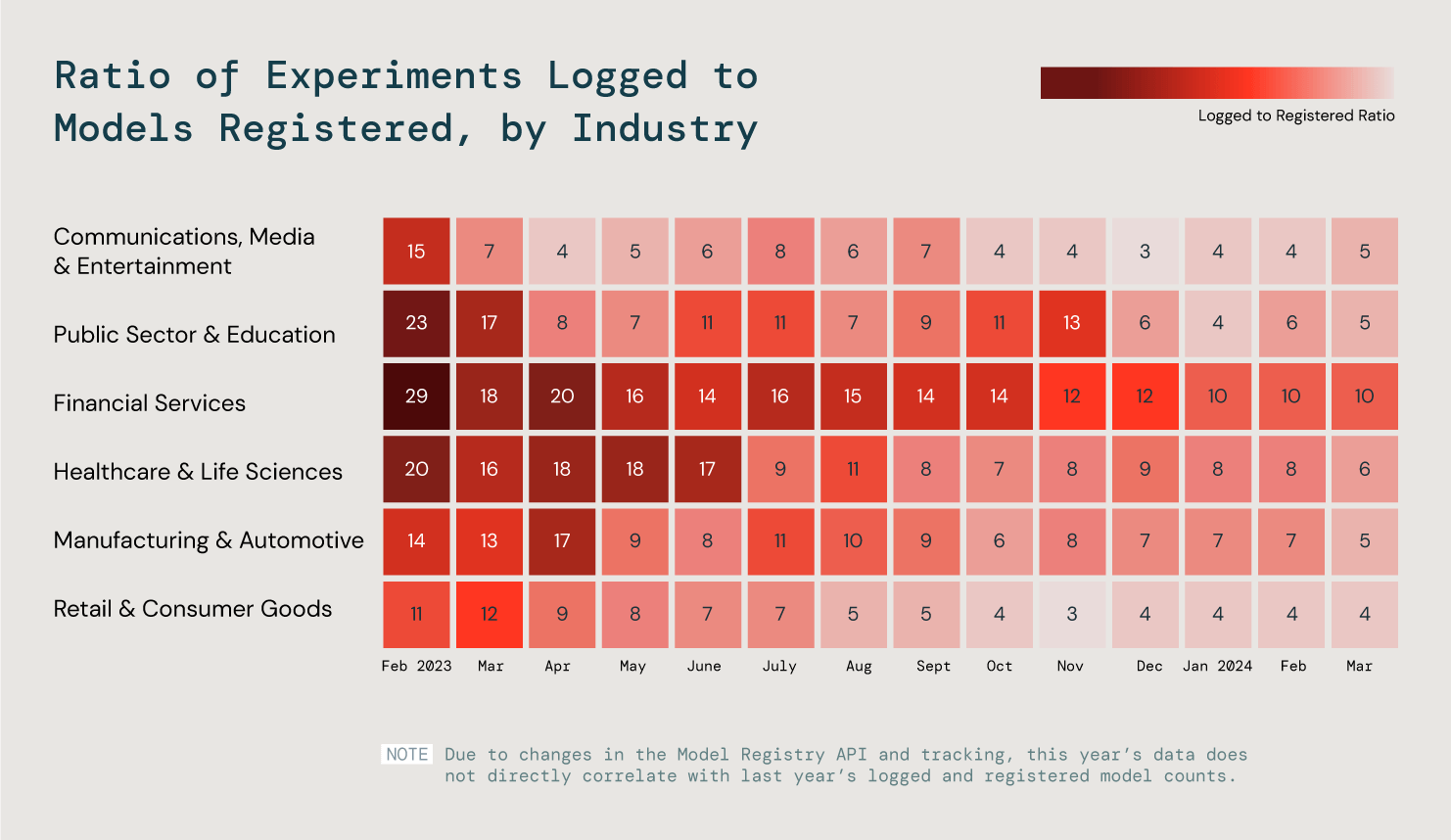

Ma ogni settore industriale ha esigenze e obiettivi diversi in materia di ML. Abbiamo analizzato sei settori industriali chiave per comprendere meglio queste tendenze osservando il rapporto tra modelli caricati e modelli registrati. Cosa è emerso da questa analisi? I nostri tre settori industriali più efficienti mettono in produzione il 25% dei loro modelli.

Abbiamo analizzato il rapporto tra modelli caricati e modelli registrati da tutti i nostri clienti per valutare i progressi nella produzione di ML.

La produzione è il luogo in cui si realizza il vero valore dell'AI , indipendentemente dal fatto che un prodotto sia destinato ai team interni o ai clienti. Prevediamo che il crescente successo del ML contribuirà a spianare la strada a risultati migliori nella creazione di applicazioni GenAI di qualità.

Personalizzazione degli LLM

L'utilizzo dei database vettoriali è aumentato del 377%

Con il maturare delle iniziative di AI generativa, le aziende cercano sempre più di adattare gli LLM esistenti, con i loro dati privati, alle loro esigenze specifiche.

La generazione potenziata dal recupero (RAG) è un meccanismo importante per ottenere prestazioni migliori dagli LLM open source e chiusi. Con la RAG, un database vettoriale viene utilizzato per addestrare i modelli sottostanti su dati privati per generare output più accurati che sono estremamente rilevanti per la specifica attività di un'organizzazione.

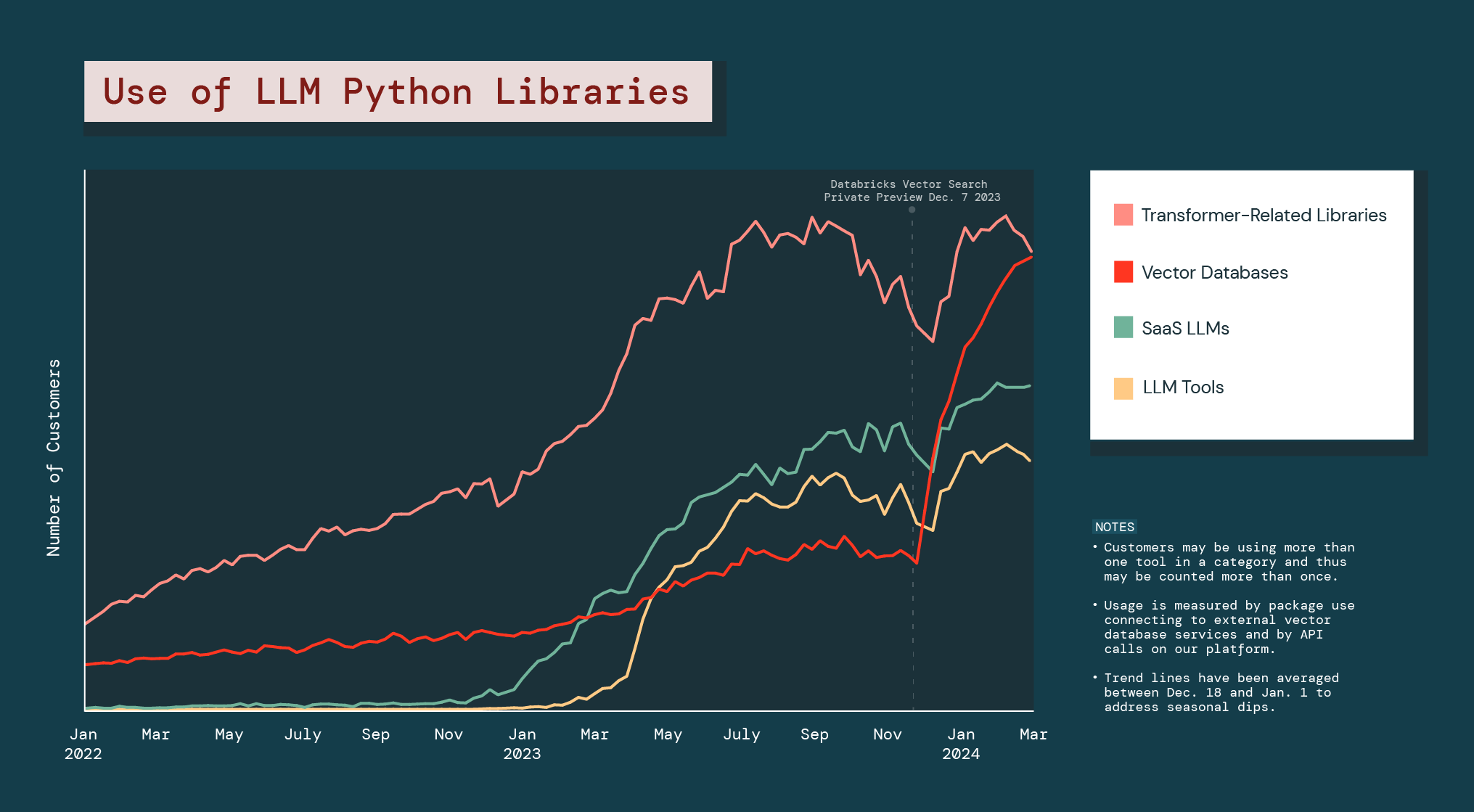

E le aziende si stanno orientando in massa verso questo tipo di personalizzazione. L'utilizzo di database vettoriali è aumentato del 377% nell'ultimo anno.

Dal lancio dell'anteprima pubblica di Databricks Vector Search, l'intera categoria dei database vettoriali è cresciuta del 186%, molto più di qualsiasi altra libreria Python per LLM.

L'esplosione dei database vettoriali indica che le aziende sono alla ricerca di alternative per l'AI generativa che le aiutino a risolvere i problemi o creare opportunità specifiche per la loro attività. Inoltre, suggerisce che le aziende fanno probabilmente affidamento su un mix di diversi tipi di modelli di AI generativa per le loro esigenze.

LLM open source

Le aziende preferiscono i modelli piccoli

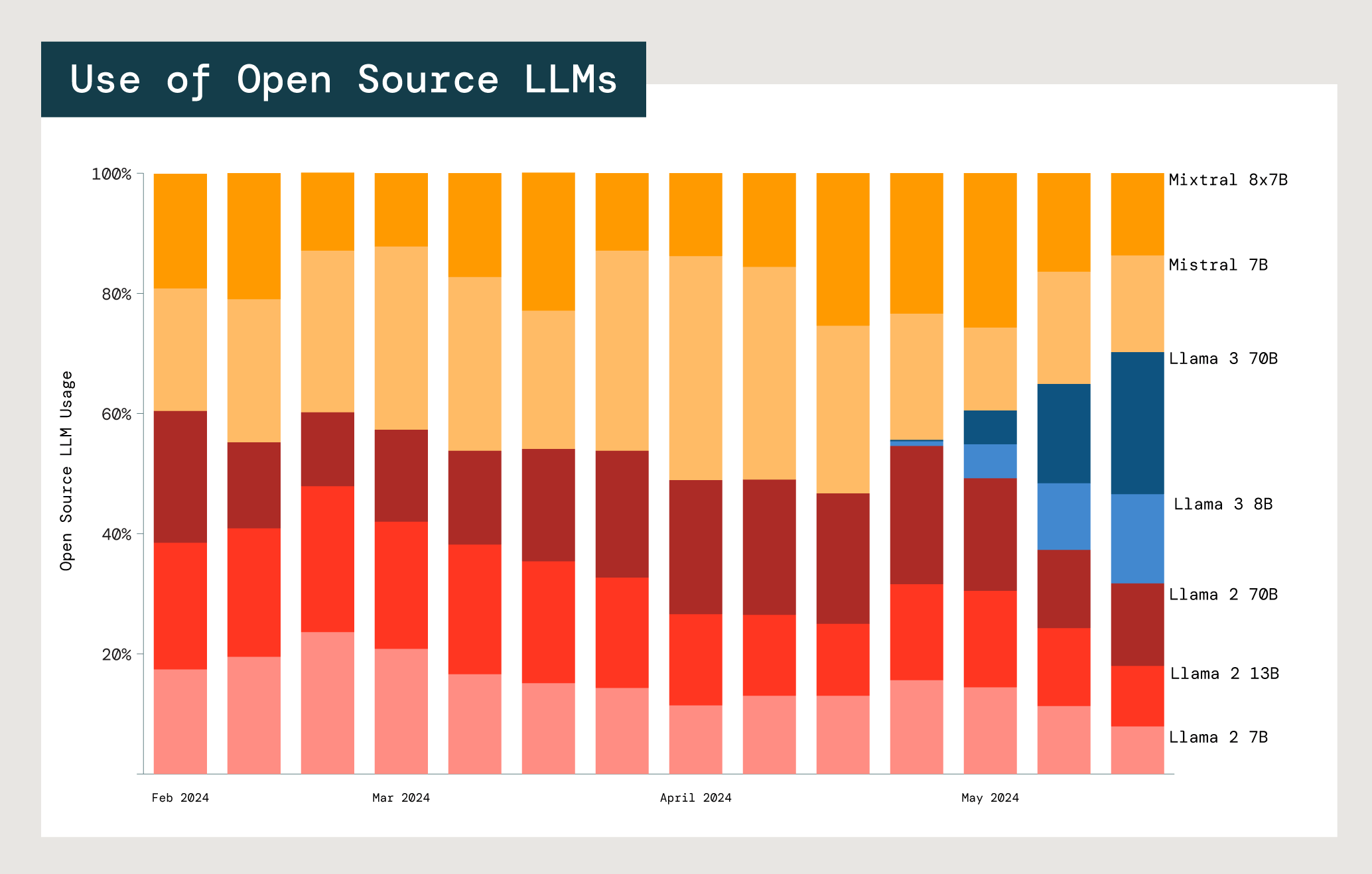

Uno dei principali vantaggi degli LLM open source è la possibilità di personalizzarli per casi d'uso specifici, soprattutto in contesti aziendali. Nella pratica, i clienti spesso sperimentano molti modelli e famiglie di modelli diversi. Abbiamo analizzato l'utilizzo dei modelli open source di Meta Llama e Mistral, i due principali attori del settore.

Adozione relativa dei modelli open source Mistral e Meta Llama nelle API del Foundation Model di Databricks

La scelta di un modello, qualunque esso sia, comporta sempre un compromesso tra costi, latenza e prestazioni. I due modelli Meta Llama 2 più piccoli (7B e 13B) risultano significativamente più utilizzati rispetto al modello più grande, Meta Llama 2 70B. Tra gli utenti Llama e Mistral , il 77% sceglie modelli con massimo 13 miliardi di parametri. Questo dato suggerisce che le aziende valutano costi e benefici delle dimensioni dei modelli quando devono selezionare quello più adatto a un caso d'uso specifico.