O que há de novo com o Databricks SQL, fevereiro de 2025

Novas funcionalidades e melhorias de desempenho para tornar o Databricks SQL mais simples, rápido e econômico

Summary

- A migração alimentada por IA para o Databricks SQL agora está acessível para Oracle, SQL Server, Snowflake, Redshift e mais.

- Nos últimos 5 meses, as cargas de trabalho de BI estão 14% mais rápidas, os trabalhos de ETL são 9% mais rápidos e as cargas de trabalho de exploração melhoraram em 13%.

- Databricks foi nomeada Líder no Quadrante Mágico da Gartner® para Sistemas de Gerenciamento de Banco de Dados em Nuvem pelo quarto ano consecutivo.

Databricks SQL continua a evoluir com novas funcionalidades e melhorias de desempenho projetadas para torná-lo mais simples, rápido e eficiente em termos de custo. Construído na arquitetura do lakehouse dentro da Plataforma de Inteligência de Dados Databricks, é confiável por mais de 11.000 clientes para alimentar suas cargas de trabalho de dados.

Neste blog, vamos abordar as principais atualizações dos últimos três meses, incluindo nosso reconhecimento no Quadrante Mágico da Gartner® 2024 para Sistemas de Gerenciamento de Banco de Dados em Nuvem, melhorias em AI/BI, experiências inteligentes, administração e mais.

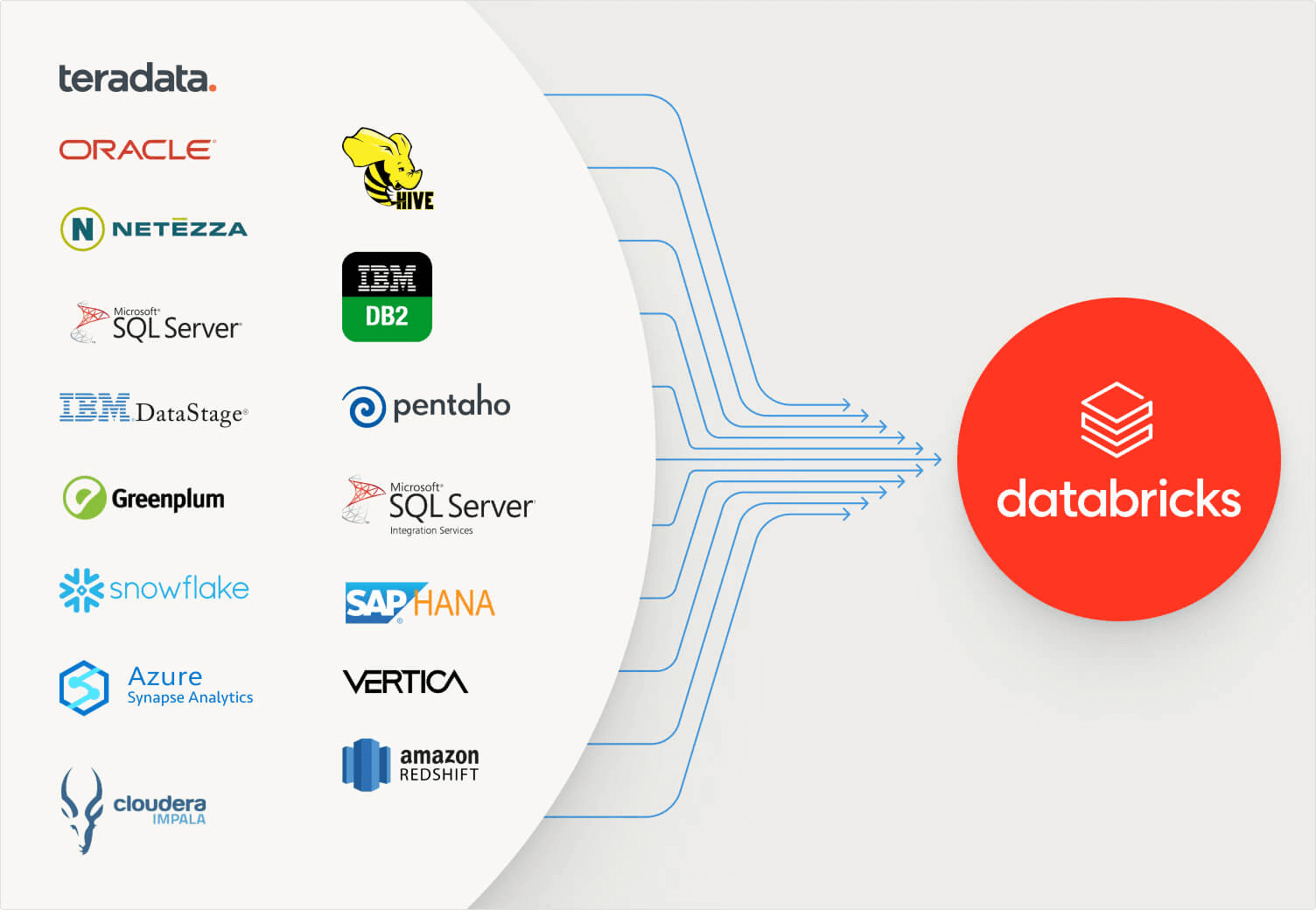

Migrações de dados aceleradas com BladeBridge

A Databricks dá as boas-vindas à BladeBridge, uma provedora comprovada de soluções de migração alimentadas por IA para armazéns de dados corporativos. Juntos, a Databricks e a BladeBridge ajudarão as empresas a acelerar o trabalho necessário para migrar armazéns de dados legados como Oracle, SQL Server, Snowflake e Redshift para o Databricks SQL (DBSQL), o armazém de dados construído na lakehouse definidora de categoria da Databricks. A BladeBridge fornecerá aos clientes uma visão clara do escopo da conversão, transpilação de código configurável, conversão alimentada por LLM e fácil validação de sistemas migrados.

A BladeBridge oferece uma abordagem aprimorada por IA para migrar mais de 20 armazéns de dados legados e ferramentas ETL - incluindo Teradata, Oracle, Snowflake, SQL Server, Amazon Redshift, Azure Synapse Analytics e Hive - mais de 50% mais rápido do que as abordagens tradicionais. Para saber mais, leia o blog do anúncio.

Experiências inteligentes

Estamos focados em tornar a experiência do analista SQL mais intuitiva, eficiente e envolvente. Ao incorporar a IA em nossos produtos, você pode gastar menos tempo em tarefas repetitivas e mais tempo em trabalhos de alto valor.

AI/BI

Desde o lançamento do AI/BI no outono de 2024, implementamos novos recursos no Genie e nos Painéis, com mais a caminho. Atualizações recentes do Painel incluem:

- melhorias na assistência de IA para geração de gráficos

- suporte de copiar e colar para widgets em várias páginas

- tabelas dinâmicas atualizadas e mapas de pontos para melhor exploração de dados

Para o Genie, nós melhoramos:

- question benchmarking para avaliações mais precisas

- visualizações editáveis e redimensionáveis para relatórios flexíveis

- qualidade de resposta, com melhorias na forma como lida com a classificação de resultados e gerenciamento de consultas relacionadas a data e hora

Aprofunde-se nas novas atualizações de AI/BI.

Editor de SQL

Estamos constantemente melhorando a experiência de autoria SQL para ajudá-lo a trabalhar de forma mais eficiente. Uma das maiores atualizações do último trimestre foi o suporte Git para consultas, tornando mais fácil o controle de versão do seu SQL e a integração com pipelines CI/CD.

*O suporte ao Git para consultas está disponível quando o novo editor SQL está ativado.

Também adicionamos novos recursos para otimizar seu fluxo de trabalho:

- Múltiplas declarações de resultados: Visualize e compare as saídas de diferentes instruções SQL lado a lado.

- Filtragem completa da tabela de resultados: Aplique filtros a conjuntos de dados inteiros, não apenas à parte carregada no seu navegador.

- Mudança de aba mais rápida: Até 80% mais rápido para abas carregadas e 62% mais rápido para abas não carregadas, tornando a navegação mais suave.

- Tamanho de fonte ajustável: Você pode alterar rapidamente o tamanho da fonte do editor SQL com atalhos de teclado (Alt + / Alt—no Windows/Linux, Opt + / Opt—no macOS).

- Comentários aprimorados com @mentions: Colabore em tempo real mencionando colegas de equipe diretamente nos comentários usando "@" seguido de seu nome de usuário. Eles receberão notificações por email, mantendo todos informados.

Otimização preditiva da plataforma

Otimizações preditivas usam IA para gerenciar automaticamente o desempenho de todas as suas cargas de trabalho. Estamos constantemente melhorando e adicionando recursos nesta área para eliminar a necessidade de ajustes manuais em toda a plataforma.

Otimização preditiva para estatísticas

O data lakehouse utiliza dois tipos distintos de estatísticas: estatísticas de salto de dados (também conhecidas como estatísticas Delta) e estatísticas do otimizador de consultas. As estatísticas de salto de dados são coletadas automaticamente, mas à medida que os dados crescem e o uso se diversifica, determinar quando executar o comando ANALYZE se torna complexo. Você também precisa manter ativamente as estatísticas do seu otimizador de consultas.

Estamos animados para apresentar a prévia pública do Predictive Optimization para estatísticas. Predictive Optimization agora está geralmente disponível como uma abordagem orientada por IA para simplificar processos de otimização. Este recurso atualmente suporta tarefas essenciais de layout e limpeza de dados, e o feedback inicial dos usuários destaca sua eficácia na simplificação da manutenção rotineira de dados. Com a adição do gerenciamento automático de estatísticas, a Otimização Preditiva oferece valor e simplifica as operações através dos seguintes avanços:

- Seleção inteligente de estatísticas de salto de dados, eliminando a necessidade de gerenciamento de ordem de colunas

- Coleta automática de estatísticas de otimização de consultas, eliminando a necessidade de executar ANALYZE após o carregamento de dados

- Uma vez coletadas, as estatísticas informam as estratégias de execução de consultas e, em média, promovem um melhor desempenho e reduzem custos

Utilizar estatísticas atualizadas melhora significativamente o desempenho e o custo total de propriedade (TCO). A análise comparativa da execução de consultas com e sem estatísticas revelou um aumento médio de desempenho de 22% em todas as cargas de trabalho observadas. Databricks aplica essas estatísticas para refinar os processos de varredura de dados e selecionar o plano de execução de consulta mais eficiente. Esta abordagem exemplifica as capacidades da Plataforma de Inteligência de Dados em entregar valor tangível aos usuários.

Para saber mais, leia este blog.

Melhor relação preço-desempenho

O motor de consulta continua sendo otimizado para escalar os custos de computação com quase linearidade em relação ao volume de dados. Nosso objetivo é um desempenho cada vez melhor em um mundo de concorrência cada vez maior - com latência cada vez menor.

Melhoria de desempenho em todos os aspectos

Databricks SQL teve uma notável melhoria de desempenho de 77% desde o seu lançamento em 2022, entregando consultas de BI mais rápidas, painéis mais responsivos e exploração de dados mais rápida. Nos últimos 5 meses do ano, as cargas de trabalho do BI estão 14% mais rápidas, os trabalhos de ETL são 9% mais rápidos e as cargas de trabalho de exploração melhoraram em 13%. Além disso, implementamos recursos de concorrência aprimorados e compressão avançada em Visualização Privada, garantindo que você economize tanto em tempo quanto em custos.

Databricks nomeada líder no Quadrante Mágico da Gartner® de 2021 para sistemas de gerenciamento de banco de dados em nuvem

Pelo quarto ano consecutivo, a Databricks foi nomeada Líder no Quadrante Mágico da Gartner® 2024 para Sistemas de Gerenciamento de Banco de Dados em Nuvem. Este ano, fizemos avanços tanto na Capacidade de Execução quanto na Integralidade da nossa Visão. A avaliação abrangeu a Plataforma de Inteligência de Dados Databricks em AWS, Google Cloud e Azure, juntamente com outros 19 fornecedores.

Administração e gestão

Estamos expandindo as capacidades para ajudar os administradores de espaço de trabalho a configurar e gerenciar armazéns SQL, incluindo tabelas de sistema e um novo gráfico para solucionar problemas de desempenho do armazém.

Gerenciamento de custos

Para dar a você visibilidade de como sua organização está usando o Databricks, você pode usar os dados de faturamento e custo em suas tabelas de sistema. Para facilitar isso, agora temos um Painel de Custos AI/BI pré-construído. O painel organiza seus dados de consumo usando as melhores práticas para etiquetagem e ajuda você a criar orçamentos para gerenciar seus gastos em um nível de organização, unidade de negócios ou projeto. Você pode então configurar alertas de orçamento quando exceder o orçamento (e rastrear qual projeto / carga de trabalho / usuário gastou demais).

Para mais informações, confira este blog de gerenciamento de custos.

Tabelas do sistema

Recomendamos tabelas do sistema para observar detalhes essenciais sobre sua conta Databricks, incluindo informações de custo, acesso a dados, desempenho da carga de trabalho, etc. Especificamente, são tabelas de propriedade da Databricks que você pode acessar de várias superfícies, geralmente com baixa latência.

Warehouse:

A tabela do sistema de Armazéns (tabela system.compute.warehouses) registra quando os armazéns SQL são criados, editados e excluídos. Você pode usar a tabela para monitorar alterações nas configurações do armazém, incluindo o nome, tipo, tamanho, canal, tags, parada automática e configurações de autoescala do armazém. Cada linha é um instantâneo das propriedades de um armazém SQL em um ponto específico no tempo. Um novo snapshot é criado quando as propriedades mudam. Para mais detalhes, veja a referência da tabela do sistema de armazéns. Este recurso está em Visualização Pública.

Histórico de consultas

A tabela de histórico de consultas (sistema. query.history) inclui registros para consultas executadas usando armazéns SQL ou computação serverless para notebooks e jobs. A tabela consiste em registros de toda a conta de todos os espaços de trabalho na mesma região de onde você acessa a tabela. Este recurso está em Visualização Pública.

Para mais detalhes, veja a referência da tabela do sistema de histórico de consultas.

Gráfico de contagem de consultas concluídas para ajudar a solucionar problemas de desempenho do armazém

Um gráfico de contagem de consultas concluídas (Visualização Pública) agora está disponível na interface do usuário de monitoramento do armazém SQL. Este novo gráfico mostra o número de consultas finalizadas em uma janela de tempo. O gráfico pode ser usado juntamente com as consultas de pico em execução e o gráfico de clusters em execução para visualizar as mudanças na taxa de transferência do armazém à medida que os clusters são ativados ou desativados, dependendo do tráfego de sua carga de trabalho e das configurações do armazém. Para mais informações, veja Monitorar um armazém SQL.

Expansão de regiões e disponibilidade de conformidade para Databricks SQL Serverless

A disponibilidade e conformidade são estendidas para os armazéns sem servidor SQL do Databricks.

- Novas regiões sem servidor:

- GCP agora está geralmente disponível nas sete regiões existentes.

- AWS adiciona a região eu-west-2 para Londres.

- Azure adiciona quatro regiões: França Central, Suécia Central, Alemanha Oeste Central e Emirados Árabes Unidos Norte.

- Conformidade sem servidor por região

- HIPAA: A conformidade com a HIPAA está disponível em todas as regiões onde o SQL Serverless está disponível em todos os provedores de nuvem (Azure, AWS e GCP).

- AWS US-East-1: PCI-DSS, conformidade FedRamp Mod agora GA

- AWS AP-Sudeste-2: conformidade com PCI-DSS e IRAP agora GA

- Segurança serverless

- Private Link: Link privado ajuda você a usar uma rede privada de seus usuários para seus dados e vice-versa. Agora está geralmente disponível.

- O Secure Egress ajuda a controlar com segurança o acesso a dados de saída, garantindo segurança e conformidade. Configurar controles de saída agora está disponível em Visualização Pública.

Integração com a Plataforma de Inteligência de Dados

Essas funcionalidades para o Databricks SQL fazem parte da Plataforma de Inteligência de Dados da Databricks. O Databricks SQL se beneficia das capacidades de simplicidade, governança unificada e abertura da arquitetura do lakehouse da plataforma. A seguir, algumas novas funcionalidades da plataforma benéficas para o Databricks SQL.

Melhorias na linguagem SQL: Colações

Construir aplicações empresariais globais significa lidar com idiomas diversos e entrada de dados inconsistente. As colações simplificam o processamento de dados definindo regras para classificar e comparar textos de maneiras que respeitam a linguagem e a sensibilidade ao caso. As colações tornam os bancos de dados conscientes da linguagem e do contexto, garantindo que eles lidem com o texto como os usuários esperam.

Estamos animados que as colações agora estão disponíveis em Visualização Pública com o Databricks SQL. Leia o blog sobre collations para mais detalhes.

Visões materializadas e tabelas de transmissão

Visões materializadas (MVs) e tabelas de streaming (STs) agora estão Disponíveis Geralmente no Databricks SQL no AWS, Azure e GCP. As tabelas de streaming oferecem ingestão incremental simples de fontes como armazenamento em nuvem e ônibus de mensagens com apenas algumas linhas de SQL. As visões materializadas pré-calculam e atualizam incrementalmente os resultados das consultas para que seus painéis e consultas possam ser executados significativamente mais rápido do que antes. Juntos, eles permitem que você crie pipelines de dados eficientes e escaláveis usando SQL, desde a ingestão até a transformação.

Para mais detalhes, leia o blog de anúncio do MV e ST.

Agendamento mais fácil para tabelas de streaming Databricks SQL e visualizações materializadas

Introduzimos a sintaxe EVERY para agendar atualizações de MV e ST usando DDL. EVERY simplifica a programação baseada em tempo, eliminando a necessidade de escrever expressões CRON complexas. Para usuários que precisam de mais flexibilidade, a programação CRON continuará sendo suportada.

Para mais detalhes, leia a documentação para ALTERAR VISÃO MATERIALIZADA, ALTERAR TABELA DE STREAMING, CRIAR VISÃO MATERIALIZADA e CRIAR TABELA DE STREAMING.

Suporte de tabelas de streaming para consultas de viagem no tempo

Agora você pode usar a viagem no tempo para consultar versões anteriores da tabela de streaming com base em carimbos de data/hora ou versões de tabela (conforme registrado no log de transações). Você pode precisar atualizar sua tabela de streaming antes de usar consultas de viagem no tempo.

Consultas de viagem no tempo não são suportadas para visualizações materializadas.

Suporte ao histórico de consultas para Delta Live Tables

Histórico de Consultas e Perfil de Consulta agora cobrem consultas executadas através de um pipeline DLT. Além disso, as percepções de consulta para as visualizações materializadas (MVs) e tabelas de streaming (STs) do Databricks SQL foram melhoradas. Essas consultas podem ser acessadas a partir da página Histórico de Consultas, juntamente com consultas executadas em Armazéns SQL e Computação Serverless. Elas também são listadas no contexto da interface do usuário do Pipeline, Notebooks e do editor SQL.

Este recurso está disponível em Visualização Pública. Para mais detalhes, veja Acessar histórico de consultas para pipelines Delta Live Table.

Compartilhamento de visualização entre plataformas para Azure Databricks

Os destinatários do Databricks agora podem consultar visualizações compartilhadas usando qualquer recurso de computação do Databricks. Anteriormente, se a conta Azure Databricks do destinatário diferisse do provedor, os destinatários só podiam consultar uma visualização compartilhada usando um armazém SQL sem servidor. Veja Ler visualizações compartilhadas.

O compartilhamento de visualizações agora também se estende aos conectores de compartilhamento aberto. Veja Ler dados compartilhados usando o compartilhamento aberto Delta Sharing (para destinatários).

Esta capacidade agora está em Visualização Pública.

Mais detalhes sobre as novas inovações

Esperamos que você aproveite esta abundância de inovações no Databricks SQL. Você sempre pode verificar esta postagem do What’s New para os três meses anteriores. Abaixo está um inventário completo dos lançamentos sobre os quais blogamos no último trimestre:

- Fevereiro de 2025: Novidades sobre IA/BI -- Fev '25

- Fevereiro de 2025: Dando as boas-vindas à BladeBridge no Databricks: Acelerando as Migrações de Data Warehouse para o Lakehouse

- Janeiro de 2025: Formas fáceis de otimizar seus custos

- Janeiro de 2025: Apresentando Colações para Databricks

- Dezembro de 2024: Databricks nomeada líder no Quadrante Mágico da Gartner de 2024 para Sistema de Gerenciamento de Banco de Dados em Nuvem

- Dezembro de 2024: Guia passo a passo para análise de sentimento do cliente com IA

- Novembro de 2024: Apresentando Estatísticas de Otimização Preditiva

- Novembro de 2024: Novidades nos Painéis de AI/BI - Outono '24

Como sempre, continuamos trabalhando para trazer ainda mais recursos interessantes. Fique atento aos webinars trimestrais de roadmap para saber o que está no horizonte para Armazenamento de Dados e IA/BI. É um momento emocionante para trabalhar com dados, e estamos animados para nos associar a Arquitetos de Dados, Analistas, Analistas de BI e mais para democratizar dados e IA dentro de suas organizações!

O que vem a seguir

Aqui está uma pequena prévia dos recursos em que estamos trabalhando. Nenhuma dessas tem prazos definidos ainda, então não pergunte. :-)

Migre facilmente seu data warehouse para o Databricks SQL

Clientes de todos os tamanhos podem reduzir significativamente os custos e diminuir os riscos ao modernizar sua infraestrutura de dados, afastando-se de plataformas proprietárias, caras e isoladas que definiram a história do armazenamento de dados. Estamos trabalhando na expansão de ferramentas gratuitas para ajudá-lo a analisar o que seria necessário para migrar do seu armazém atual para o Databricks SQL e ajudá-lo a converter seu código para aproveitar os novos recursos do Databricks SQL.

Acelere suas cargas de trabalho de BI

O desempenho é crítico ao carregar painéis de inteligência de negócios. Estamos melhorando a latência das consultas BI a cada trimestre para que você possa potencializar suas ferramentas BI favoritas como Power BI, Tableau, Looker e Sigma com Databricks SQL.

Simplifique a gestão e o monitoramento de armazéns

Estamos investindo em mais recursos e ferramentas para ajudá-lo a gerenciar e monitorar seu armazém de forma fácil. Isso inclui melhorias na tabela do sistema, alterações via UI e nossas APIs.

Para saber mais sobre o Databricks SQL, visite nosso site ou leia a documentação. Você também pode conferir o tour do produto para Databricks SQL. Suponha que você queira migrar seu armazém existente para um armazém de dados serverless de alto desempenho, com uma ótima experiência do usuário e um custo total mais baixo. Nesse caso, o Databricks SQL é a solução — experimente gratuitamente.

Para participar de visualizações privadas ou públicas restritas, entre em contato com sua equipe de conta Databricks.

(This blog post has been translated using AI-powered tools) Original Post

Nunca perca uma postagem da Databricks

O que vem a seguir?

Produto

June 12, 2024/11 min de leitura