새로운 LLMOps 기능이 추가된 MLflow 2.7 소개

프롬프트 엔지니어링 및 AI 게이트웨이 업데이트가 적용된 새로운 UI

(�번역:Sang-bae Lim) Original Blog Link

MLflow 2의 LLMOps 지원의 일환으로, MLflow 2.7에서 프롬프트 엔지니어링을 지원하는 최신 업데이트를 소개합니다.

대화형 프롬프트 인터페이스로 LLM 프로젝트 실행 가능성 평가

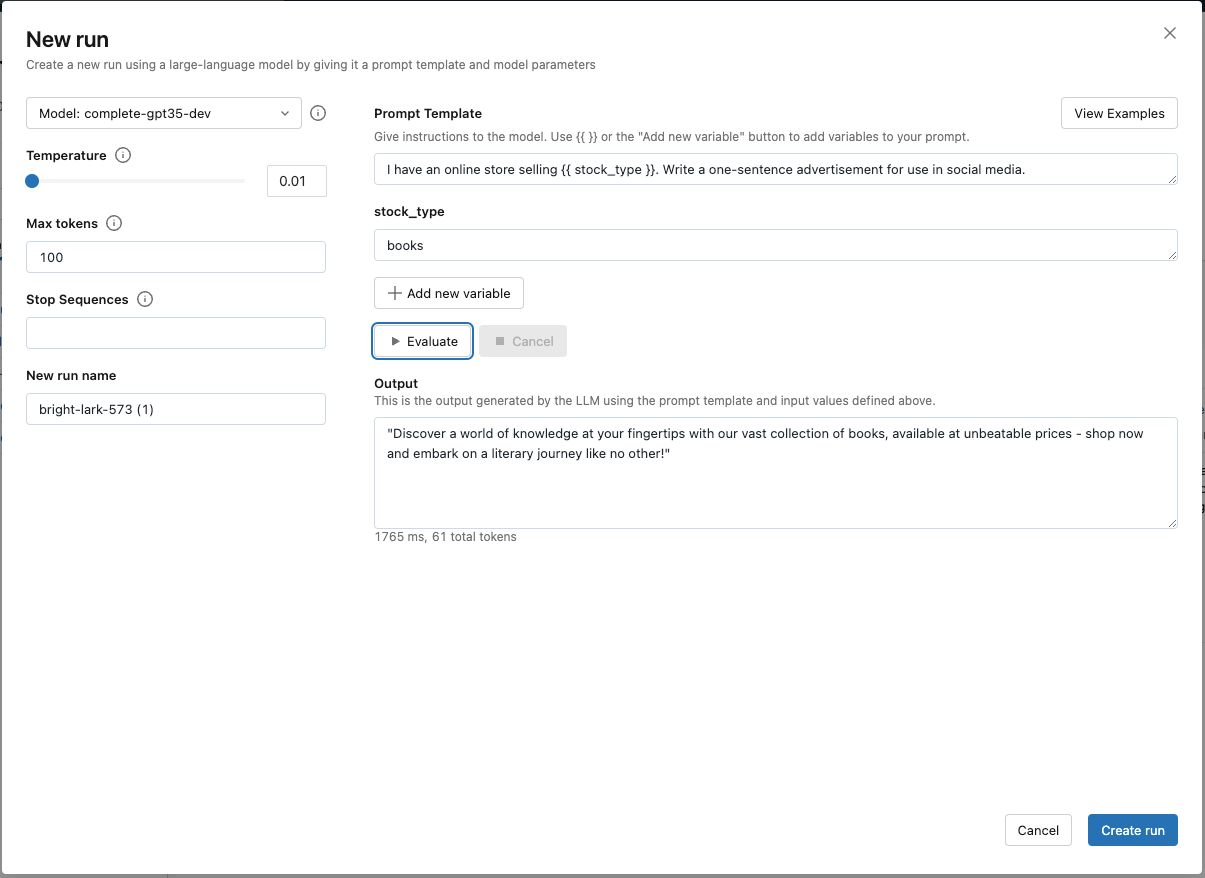

프롬프트 엔지니어링은 대규모 언어 모델(LLM)이 특정 사용 사례에 적합한지 신속하게 평가할 수 있는 효과적인 방법입니다. MLflow 2.7의 새로운 프롬프트 엔지니어링 UI를 통해 비즈니스 이해관계자는 다양한 베이스 모델, 매개변수 및 프롬프트를 실험하여 새 프로젝트를 시작하기에 충분한 결과물이 나오는지 확인할 수 있습니다. 신규 블랭크 실험을 만들거나 기존 실험을 열고 "New Run"을 선택하여 대화형 프롬프트 엔지니어링 도구에 액세스하면 됩니다. 여기에서 미리 보기에 참여하려면 등록하세요.

프롬프트 엔지니어링 실험을 자동으로 추적하여 평가 데이터 세트를 구축하고 베스트 모델 후보를 식별

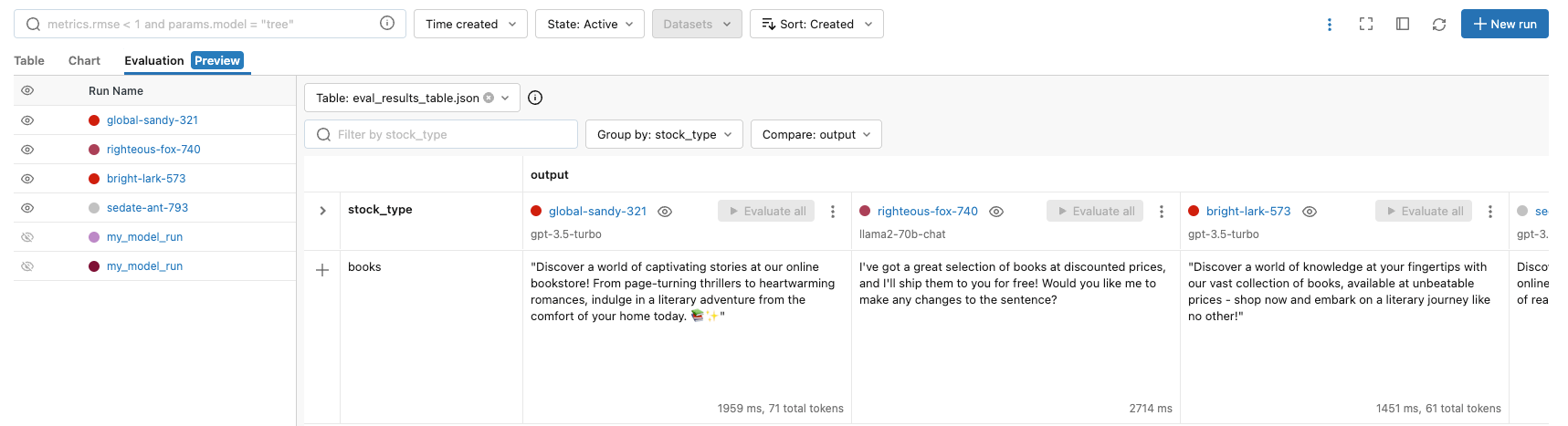

새 프롬프트 엔지니어링 UI에서 사용자는 "Create Run"을 클릭해 결과를 MLflow에 기록하고, 평가 실행을 명확히 추적할 수 있습니다. 이 버튼은 MLflow 모델 및 출력이 평가 테이블에 저장될 때 매개변수, 베이스 모델 및 프롬프트 세트를 추적합니다. 그런 다음 이 테이블을 수동 평가(manual evaluation)에 사용하거나 SQL의 심층 분석을 위해 델타 테이블로 변환하거나 CI/CD 프로세스에서 테스트 데이터 세트로 사용할 수 있습니다.

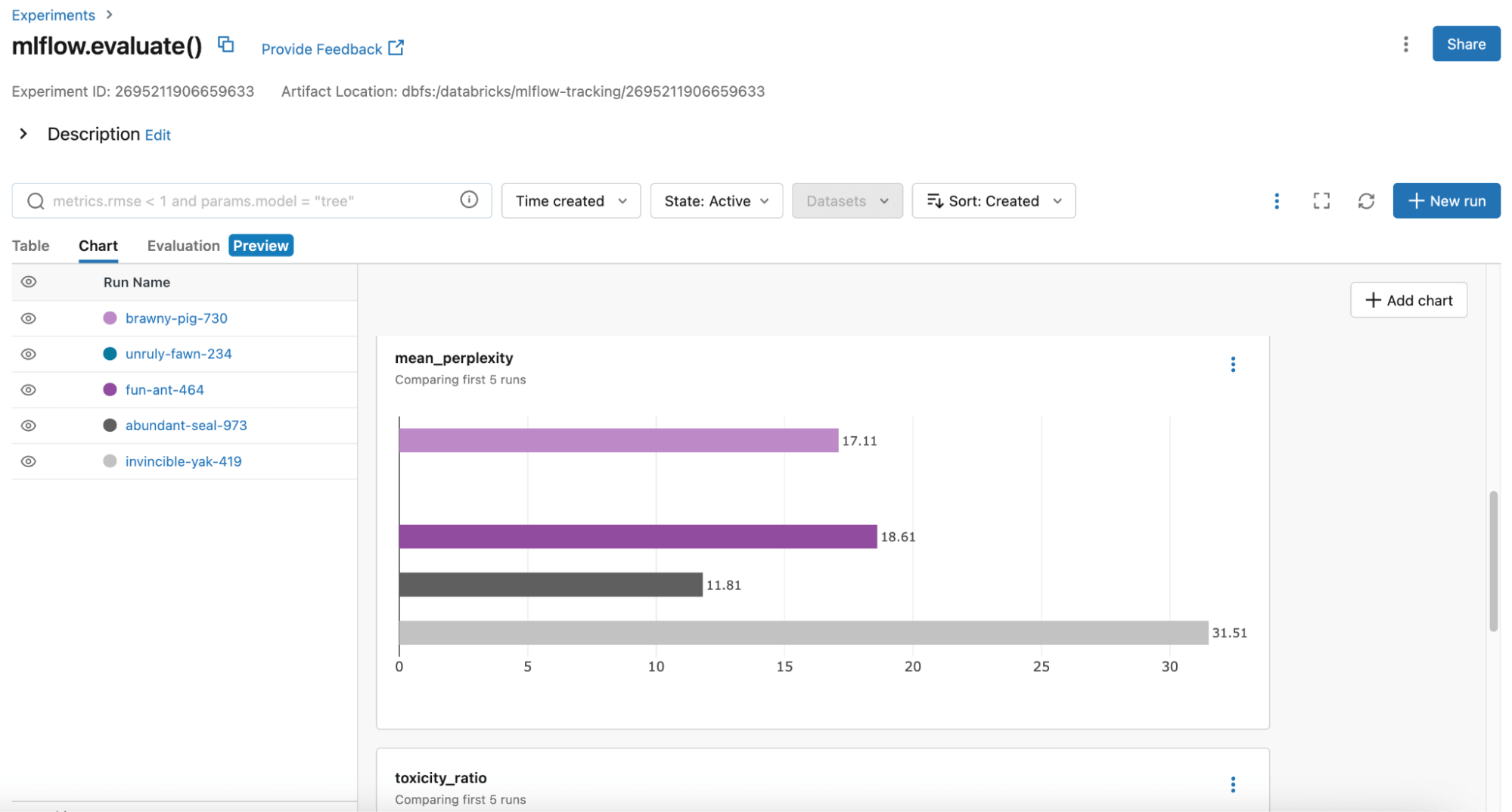

MLflow는 프로덕션에 적합한 모델 후보를 식별할 수 있도록 MLflow Evaluation API에 지속적으로 새로운 메트릭을 추가하고 있으며, 최근에는 toxicity와 perplexity도 지원합니다. 사용자는 MLflow의 Table 또는 Chart 보기 기능을 통해 모델 성능을 비교할 수 있습니다:

MLflow는 운영에 가장 적합한 모델 후보를 식별하는 데 도움이 되는 toxicity 및 perplexity 등 더 많은 메트릭을 MLflow 평가 API에 지속적으로 추가하고 있습니다. 사용자는 MLflow 표 또는 차트 보기를 사용하여 모델 성능을 비교할 수 있습니다:

매개변수, 프롬프트 및 베이스 모델 세트가 MLflow 모델로 기록되어, 배치 추론에서 설정된 매개변수가 있는 베이스 모델에 대한 고정형 프롬프트 템플릿을 배포하거나 데이터브릭스 모델 서빙을 통해 API로 제공할 수 있습니다. MLflow는 모델 버전 관리와 함께 제공되어 LangChain 사용자에게는 특히 유용합니다.

가드레일을 사용해 조직 전체에 애드-혹 실험을 대중화

MLflow 프롬프트 �엔지니어링 UI는 모든 MLflow AI 게이트웨이 경로와 함께 작동합니다. AI 게이트웨이 경로를 사용하여 조직은 SaaS LLM에 대한 거버넌스 및 정책을 중앙 집중화할 수 있습니다. 예를 들어 OpenAI의 GPT-3.5-turbo를 게이트웨이 경로 뒤에 배치하여 해당 경로로 쿼리할 수 있는 사용자 관리, 안전한 자격 증명 관리 제공, 속도 제한을 할 수 있습니다. 이를 통해 남용을 방지하고 플랫폼 팀이 조직 전체에서 LLM에 대한 접근을 대중화할 수 있다는 확신을 가질 수 있습니다.

MLflow AI 게이트웨이는 OpenAI, Cohere, Anthropic, 데이터브릭스 모델 서빙 엔드포인트를 지원합니다. 그러나 일반화 오픈 소스 LLM이 독점적인 일반화 LLM과 점점 더 경쟁이 치열해짐에 따라, 조직은 이러한 오픈 소스 모델을 빠르게 평가하고 실험해보고 싶을 수 있습니다. 이제 MosaicML에서 호스팅하는 Llama2-70b-chat을 호출할 수 있습니다.

여러분의 LLM 개발에 지금 바로 MLFlow을 사용해보세요!

데이터브릭스는 MLflow를 통해 LLM 개발에 필요한 대표적인 워크플로를 빠르게 지원하고 표준화하고 있습니다. 사용 사례에 맞게 MLflow를 사용하는 방법을 알아보려면 이 데모 노트북을 확인하세요. 더 많은 자료를 보려면:

- 여기에서 MLflow AI Gateway 미리 보기(프롬프트 엔지니어링 UI 포함)에 등록하세요.

- 프롬프트 엔지니어링 UI를 시작하려면 MLflow 버전을 업그레이드하고(pip install –upgrade mlflow) MLflow 실험을 생성한 후 “New Run”을 클릭하면 됩니다.

- 동일한 질문 집합에 대해 다양한 모델을 평가하려면 MLflow Evaluation API를 사용하세요.

- MLflow AI Gateway에서 지원하려는 SaaS LLM 엔드포인트가 있는 경우 MLflow 리포지토리에 대한 기여 가이드라인을 준수해주세요. 여러분의 기여를 환영합니다!