Orchestration gérée nativement pour toute charge de trav

Orchestration unifiée des données, de l'analytique et de l'IA sur la Data Intelligence Platform

LES CLIENTS UTILISENT LES TÂCHES LAKEFLOW

Orchestrez n'importe quel flux de travail de données, d'analytique ou d'IA

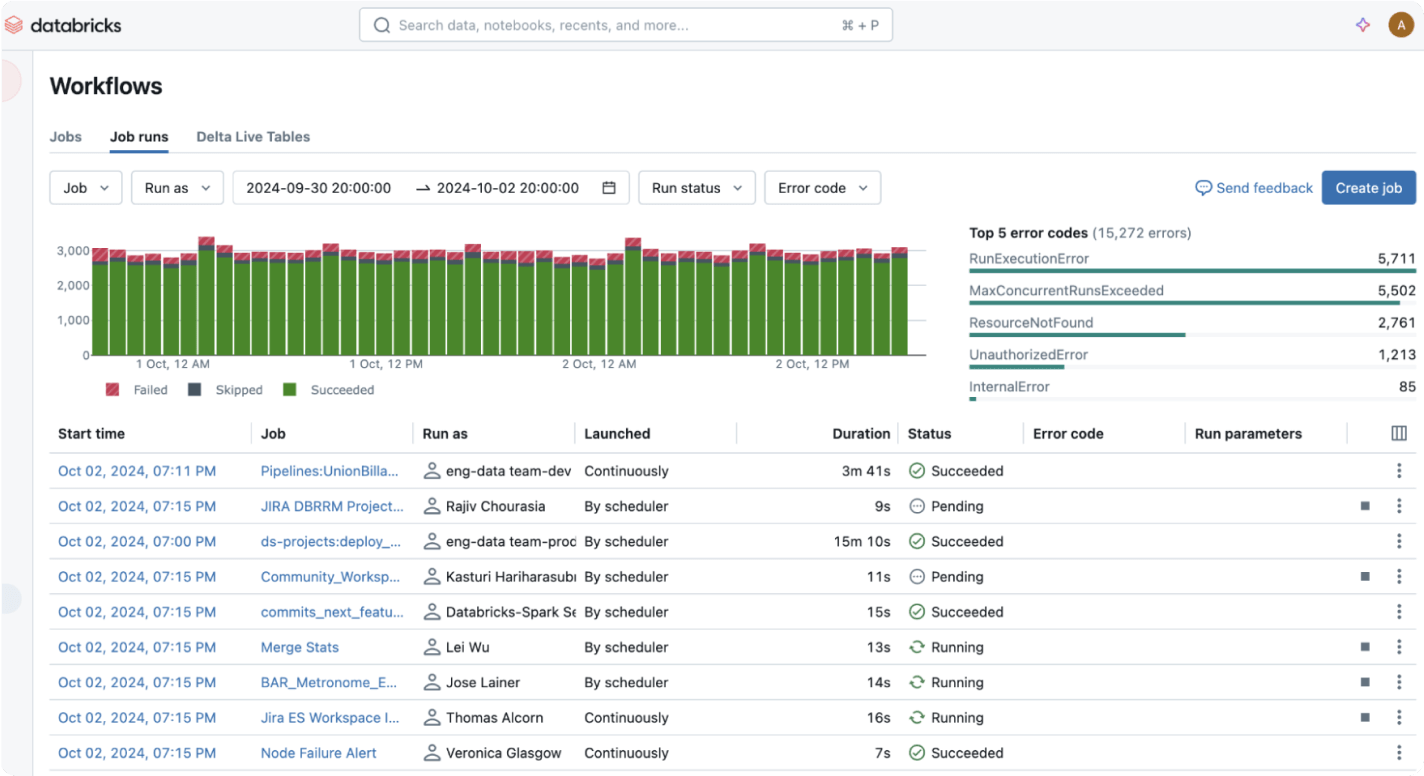

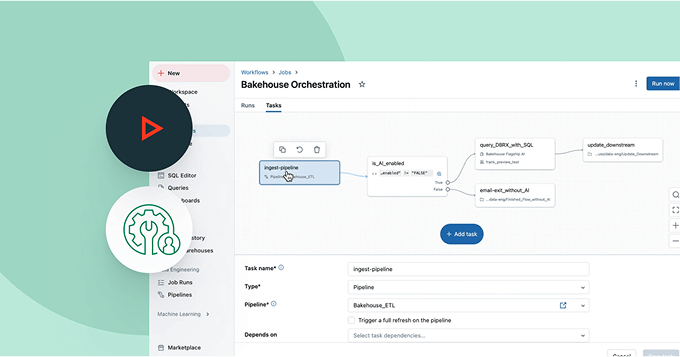

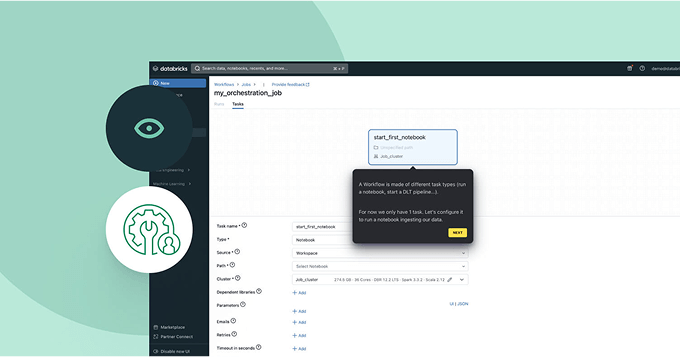

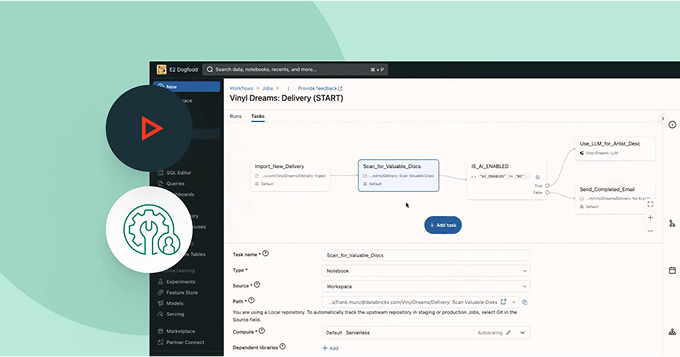

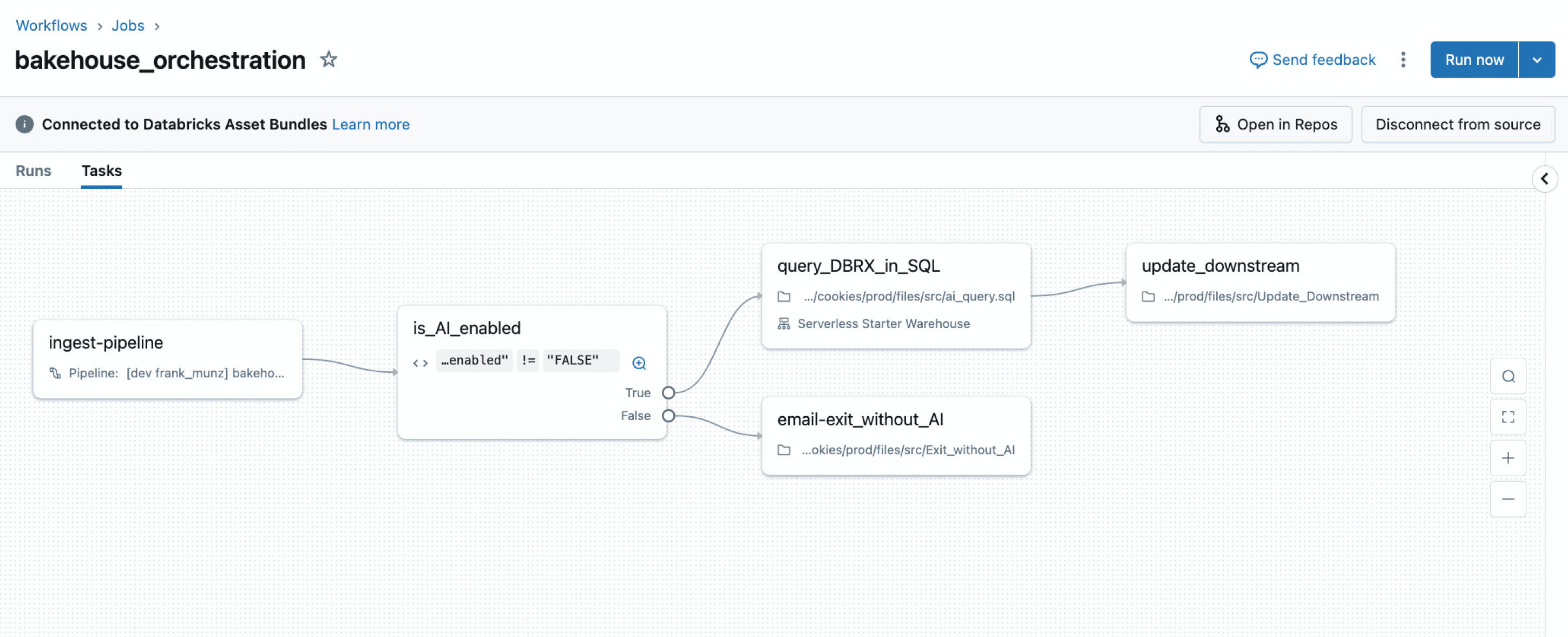

Rationalisez vos pipelines avec un service d'orchestration intégré, fiable et facile à utiliser pour automatiser vos workflows ETL, d'analyse et de ML.Rationalisez et orchestrez vos pipelines de données

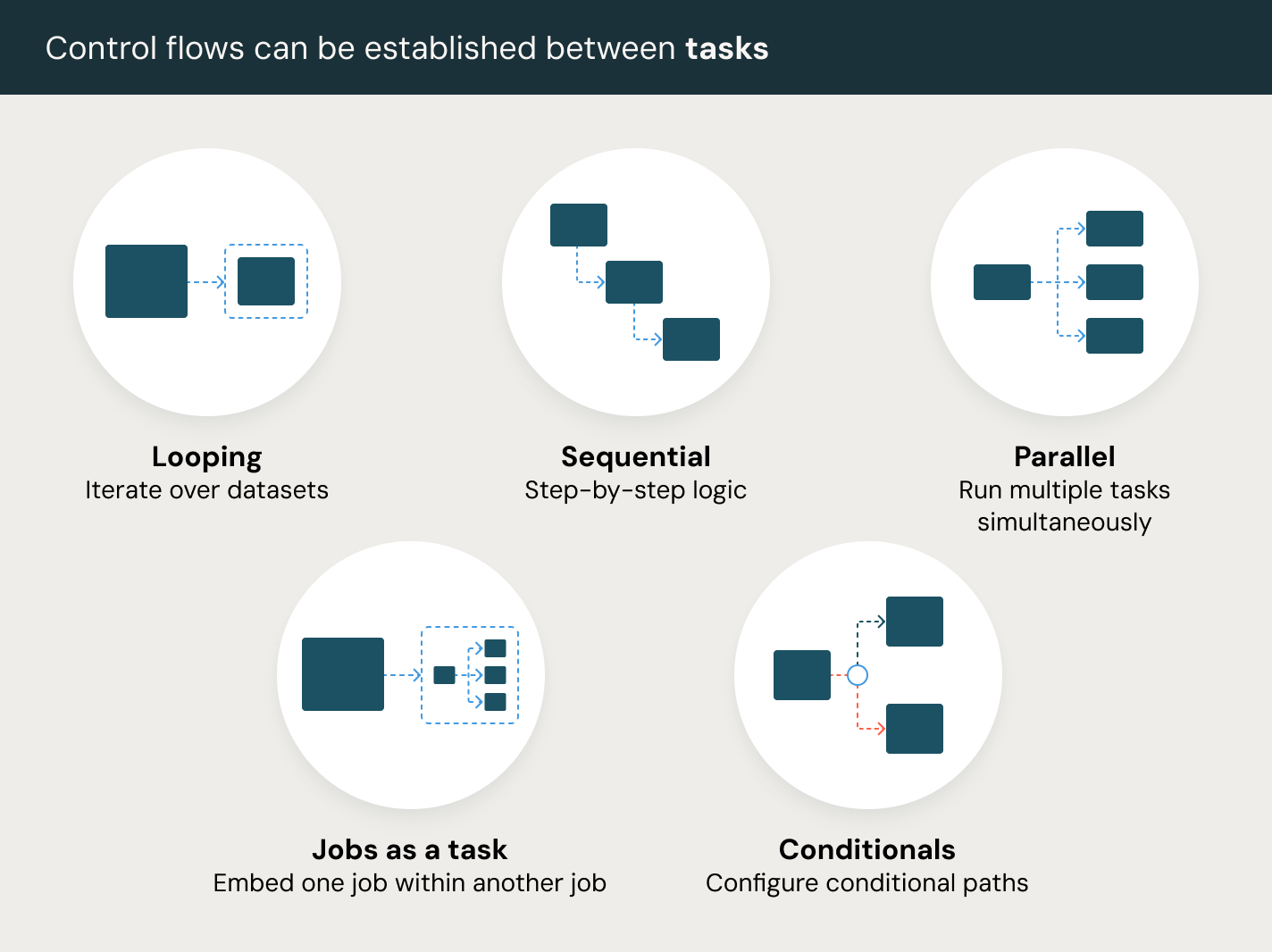

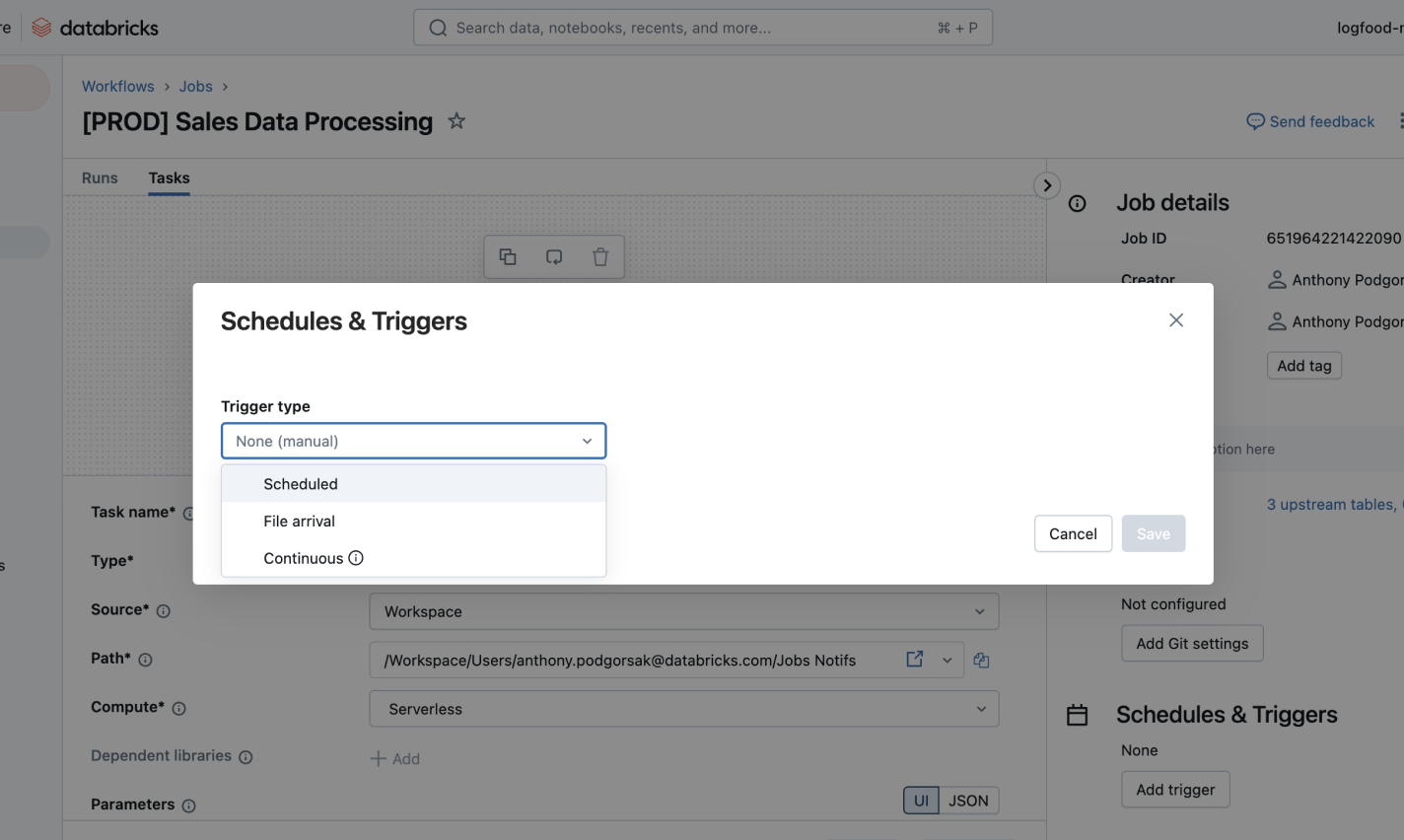

Définissez, gérez et surveillez facilement les tâches à travers les pipelines ETL, d'analytique et d'IA.Débloquez une orchestration sans faille avec des types de tâches polyvalents, y compris des notebooks, SQL, Python et plus encore, pour alimenter n'importe quel flux de travail de données.

Autres fonctionnalités

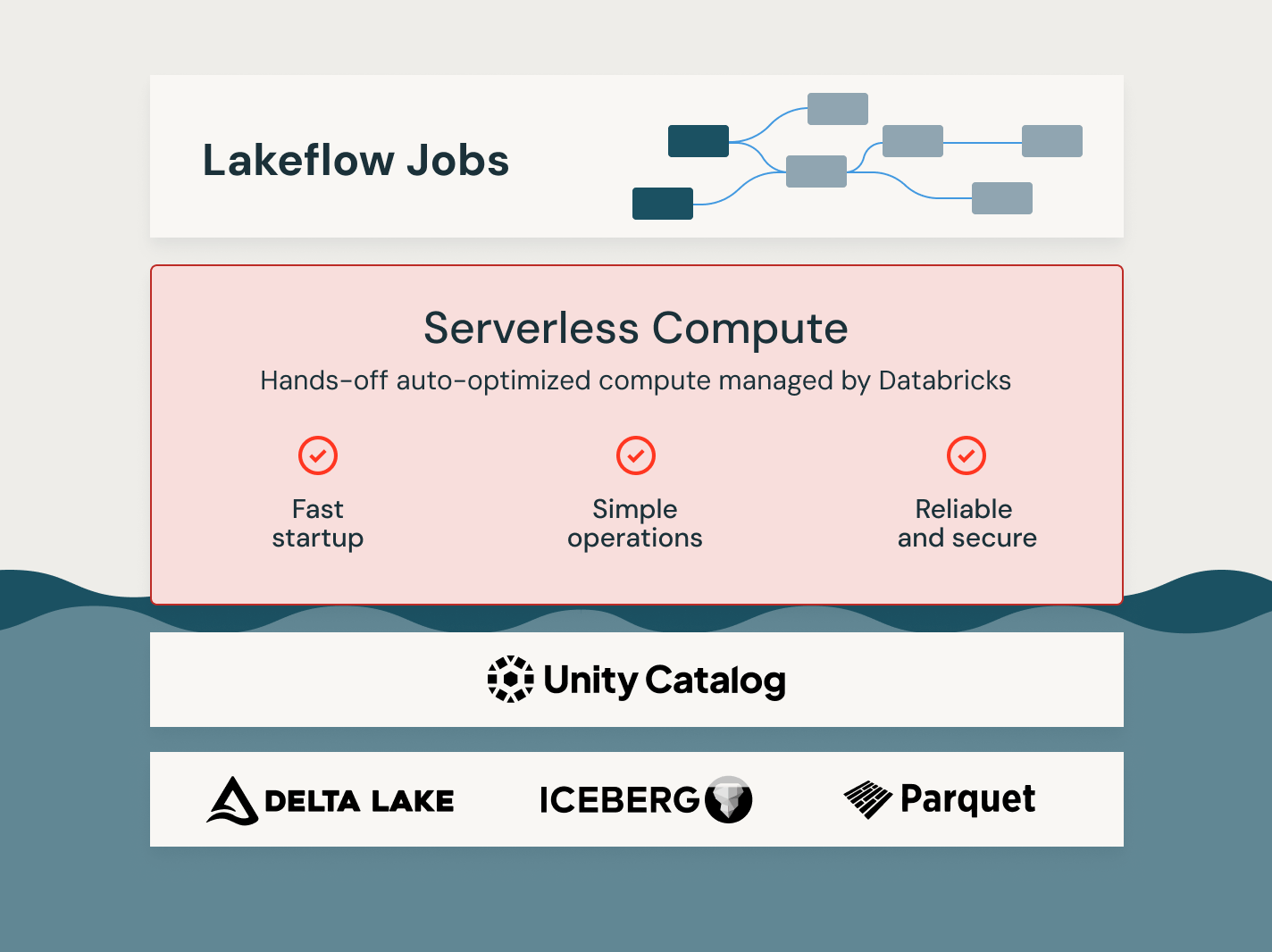

Débloquez la puissance des emplois Lakeflow

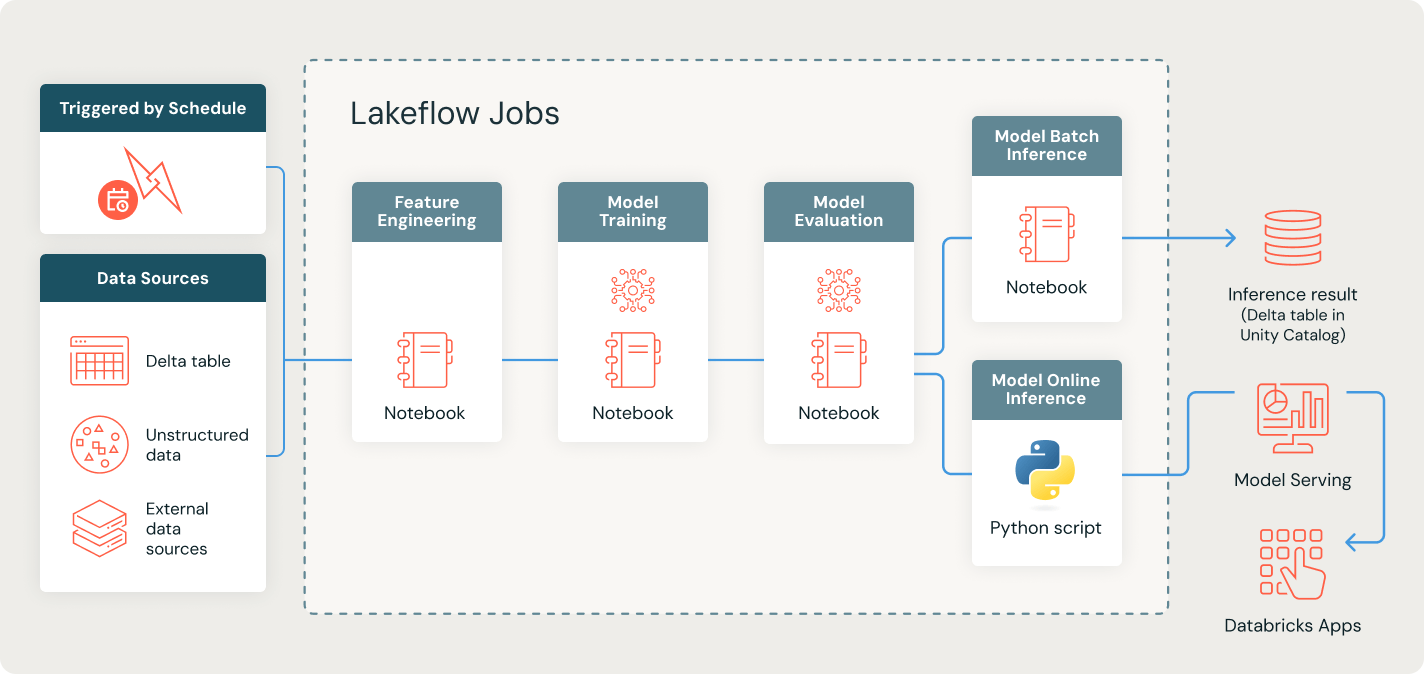

Automatisez et orchestrez votre cycle de vie ML - de la préparation des données à la mise en œuvre

Rationalisez la préparation du modèle d'apprentissage automatique en automatisant le processus de bout en bout d'extraction, de transformation et de préparation des données pour l'entraînement et l'inférence.

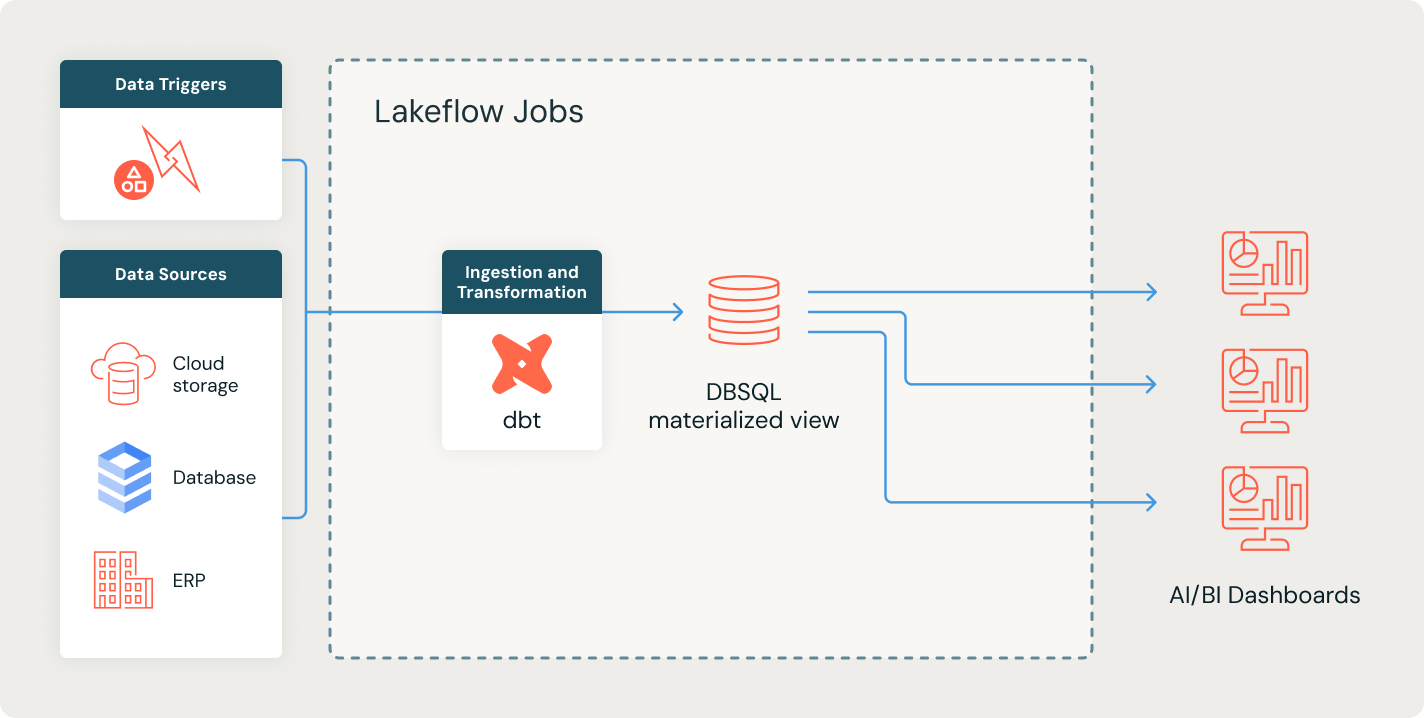

Rationalisez les rapports BI avec des pipelines de données automatisés et fiables

Automatisez la préparation des données pour fournir des informations précises et opportunes à vos outils d'intelligence d'affaires. Simplifiez les flux de travail pour transformer les données et permettre une prise de décision en toute confiance.

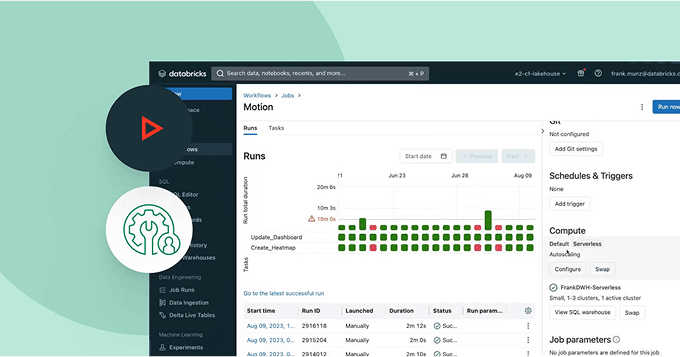

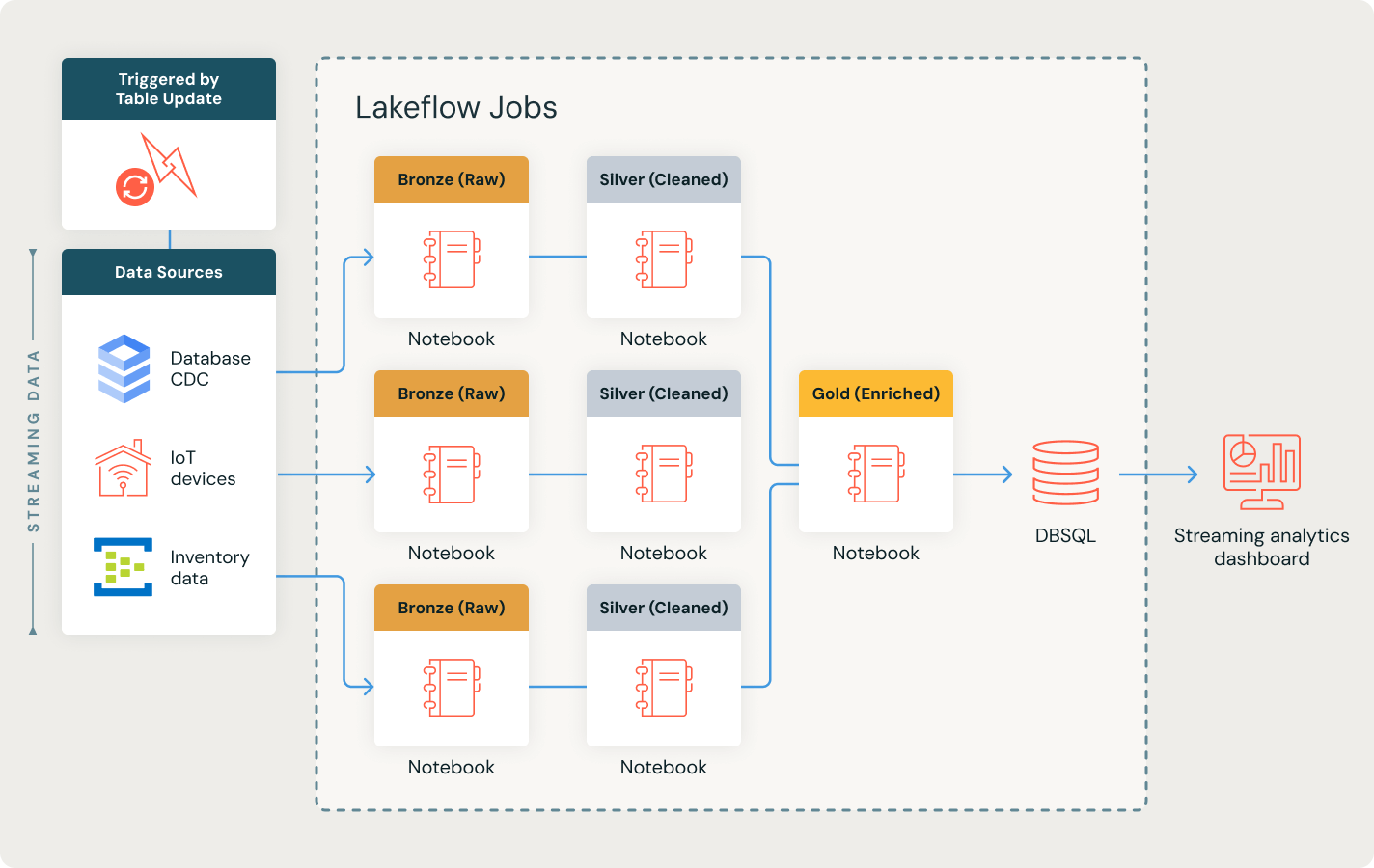

Réagissez instantanément avec des pipelines de données en temps réel

Débloquez des insights en temps réel en orchestrant des pipelines de données complexes avec précision. Traitez sans interruption les données en streaming en utilisant le mode continu, déclenchez des tâches instantanément et permettez une analyse rapide et fiable pour des décisions basées sur les données.

Explorez les démonstrations de Lakeflow Jobs

En savoir plus

Découvrez comment la Databricks Data Intelligence Platform donne du pouvoir à vos équipes data sur l'ensemble de vos charges de travail de données et d'IA.LakeFlow Connect

Avec des connecteurs d'ingestion de données efficaces pour tous les types de source et une intégration native à la Data Intelligence Platform, les équipes accèdent en toute simplicité à l'analytique et à l'IA avec une gouvernance unifiée.

Spark Declarative Pipelines

Fournit des pipelines simplifiés et déclaratifs pour le traitement des données en lots et en continu, garantissant des transformations automatisées et fiables pour les tâches d'analyse et d'IA/ML.

Databricks Assistant

Profitez de l'assistance alimentée par l'IA pour simplifier la programmation, déboguer les flux de travail et optimiser les requêtes en utilisant le langage naturel pour une ingénierie et une analyse de données plus rapides et plus efficaces.

Stockage en lakehouse

Unifiez les données du lakehouse, quels que soient leur format et leur type, pour les mettre à disposition de toutes vos charges d'analytique et d'IA.

Unity Catalog

Encadrez sans problème tous vos assets de données avec la seule solution de gouvernance unifiée et ouverte de l'industrie pour les données et l'IA, intégrée à la Databricks Data Intelligence Platform

La Data Intelligence Platform

Découvrez les avantages de la Databricks Data Intelligence Platform pour vos charges de données et d'IA.

Passez à l'étape suivante

FAQ sur Lakeflow Jobs

Prêts à devenir une entreprise axée sur les données et l'IA ?

Faites le premier pas de votre transformation data