향상된 에이전트 평가 소개

더 쉬운 커스터마이징과 향상된 비즈니스 이해관계자 협업

Summary

- 시범 단계에서 생산 단계까지 - 자동 평가, 전문가 피드백, 그리고 두 단계 모두에서 명확한 반복 경로를 통해 GenAI 채택을 간소화합니다.

- 맞춤형 GenAI 평가 - 사용자 정의 메트릭을 정의하고, 새로운 Guidelines AI Judge를 사용하고, 유연한 입력/출력 스키마로 모든 사용 사례를 평가합니다.

- 원활한 전문가 협업 - 업데이트된 Review App은 피드백 수집과 평가 데이터셋 관리를 간소화합니다.

(이 글은 AI의 도움을 받아 번역되었습니다. 원문이 궁금하시다면 여기를 클릭해 주세요)

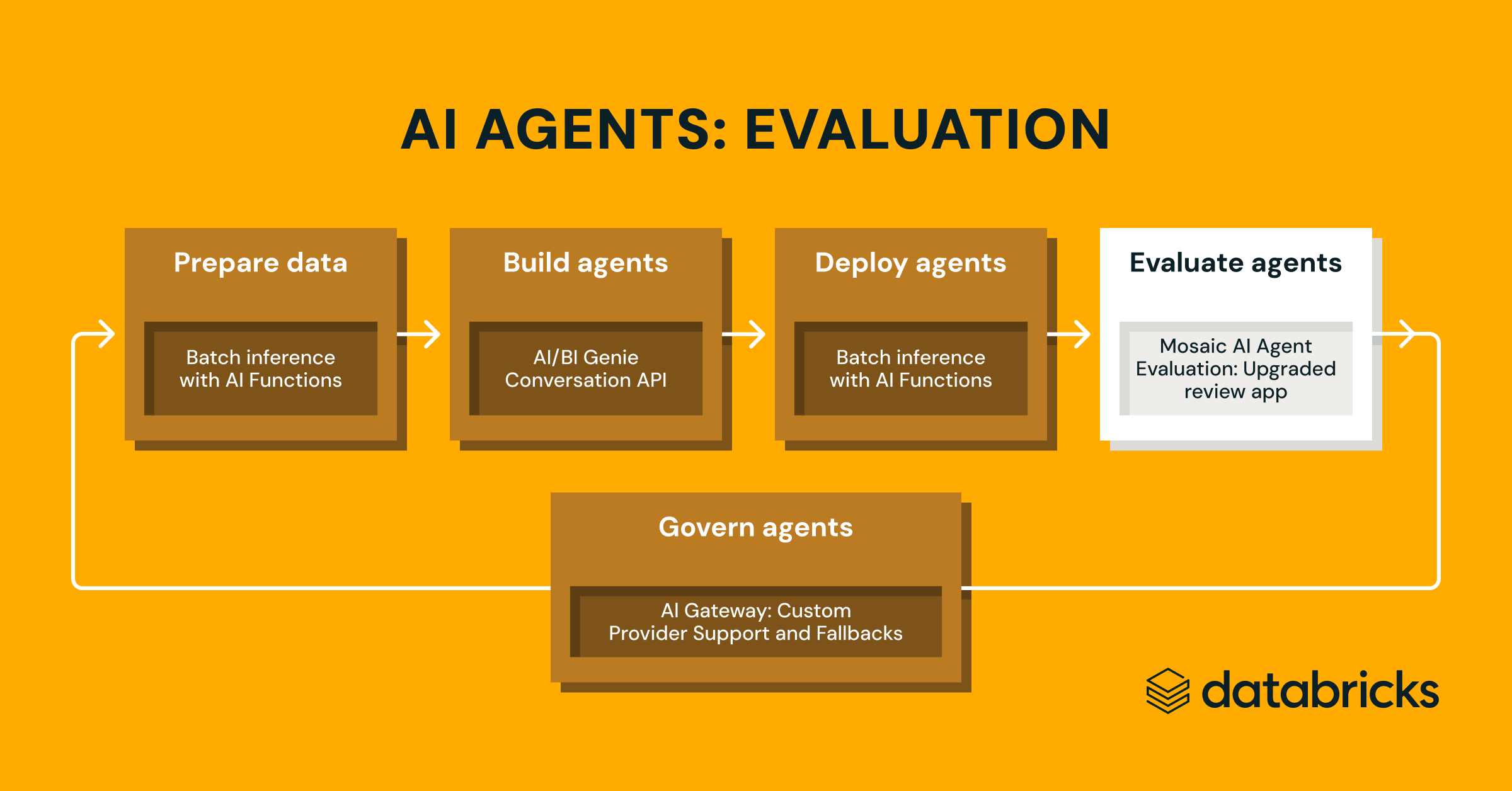

이번 주 초, Databricks에서 새로운 에이전트 개발 기능을 발표했습니다. 수백 명의 고객 의견을 통해 시범 단계를 넘어서는 데 두 가지 주요 어려움이 있음을 확인했습니다. 첫째, 고객들은 자신들의 모델의 생산성능에 대한 확신이 부족합니다. 둘째, 고객들은 반복하고 개선하는 명확한 경로를 가지고 있지 않습니다. 이 두 가지 요소가 종종 프로젝트가 정체되거나 팀이 주제 전문가를 찾아 모델 출력을 수동으로 평가하는 비효율적인 과정으로 이어집니다.

오늘, 우리는 새로운 Public Preview 기능을 확장하여 Mosaic AI Agent 평가의 이러한 도전 과제를 해결하고 있습니다. 이 개선으로 팀은 사용자 정의 자동 평가와 간소화된 비즈니스 이해관계자 피드백을 활용해 GenAI 애플리케이션을 보다 효과적으로 이해하고 개선할 수 있습니다.

- 도메인 전문가와 협업: Review App과 새로운 평가 데이터셋 SDK를 이용해 전문가 피드백을 수집하고 GenAI 앱 로그에 라벨을 붙이며, Delta 테이블과 Unity Catalog 기반 평가 데이터셋을 향상시킵니다.

- 자동 평가 맞춤 설정: Guideline AI 판사로 GenAI 앱을 자연어 규칙에 따라 평가하며, 사용자 정의 Python 평가로 비즈니스 핵심 지표를 정의할 수 있습니다.

이 기능들을 직접 체험하려면 샘플 노트북을 참고하세요.

GenAI 평가를 귀사의 비즈니스 요구에 맞게 사용자 정의하세요

GenAI 애플리케이션과 에이전트 시스템은 벡터 데이터베이스와 도구를 사용하는 기본 아키텍처부터 실시간 또는 배치 방식의 배포 방법에 이르기까지 다양한 형태로 존재합니다. Databricks에서는, 특정 도메인의 작업을 성공적으로 수행하려면 기업 데이터를 효과적으로 활용해야 한다는 것을 알게 되었습니다. 이러한 다양성은 동등하게 유연한 평가 접근법을 요구합니다.

오늘, 우리는 Mosaic AI Agent 평가에 대한 업데이트를 소개하며, 이는 매우 사용자 정의 가능하게 만들어졌으며, 어떤 종류의 GenAI 애플리케이�션이나 에이전트 시스템에 대한 도메인 특정 애플리케이션의 성능을 측정하는 데 도움이 될 수 있도록 설계되었습니다.

AI 판사 가이드라인: 자연어를 사용하여 GenAI 앱이 가이드라인을 준수하는지 확인합니다

저희의 카탈로그를 확장하여 내장형, 연구에 최적화된 LLM 판사들을 제공하며, 이들은 최고 수준의 정확성을 제공합니다. 이제 저희는 Guidelines AI Judge (Public Preview)를 소개하게 되어 개발자들이 평가에 간단한 언어 체크리스트나 루브릭을 사용하는 데 도움이 됩니다. 가끔 채점 노트라고도 불리는 가이드라인은 교사들이 기준을 정의하는 방식과 유사합니다 (예: “에세이는 5개의 문단을 가져야 한다”, “각 문단은 주제 문장을 가져야 한다”, “각 문장의 마지막 문단은 문단에서 제기된 모든 주장을 요약해야 한다”, …).

작동 원리: Agent 평가를 구성할 때 지침을 제공하면, 각 요청에 대해 자동으로 평가됩니다.

가이드라인 예시:

- 응답은 전문적이어야 합니다.

- 사용자가 두 제품을 비교하도록 요청하면, 응답은 표를 표시해야 합니다.

왜 중요한가요: 가이드라인은 이해하기 쉬운, 구조화된 평가 루브릭을 통해 비즈니스 이해관계자와의 평가 투명성과 신뢰를 향상시키며, 앱의 응답에 대한 일관되고 투명한 점수를 제공합니다.

가이드라인이 평가를 향상시키는 방법에 대한 자세한 내용은 문서 를 참조하세요

사용자 정의 지표: Python에서 비즈니스 요구에 맞게 지표를 정의합니다.

사용자 정의 지표를 사용하면 사용자 정의 평가 기준 을 AI 애플리케이션에 대해 기본 제공 지표 및 LLM 판사를 넘어서 정의할 수 있습니다. 이를 통해 입력, 출력, 추적을 비즈니스 요구 사항에 따라 프로그래밍 방식으로 평가할 수 있는 완전한 제어권을 갖게 됩니다. 예를 들어, SQL 생성 에이전트의 쿼리가 테스트 데이터베이스에서 실제로 성공적으로 실행되는지 확인하는 사용자 정의 지표를 작성하거나, 제공된 문서와 답변 사이의 일관성을 측정하는 데 사용되는 기본 제공 groundness 판사를 사용자 정의하는 지표를 작성할 수 있습니다.

작동 원리: Python 함수를 작성하고, @metric로 장식하고, 이를 mlflow.evaluate(extra_metrics=[..])에 전달합니다. 함수는 풍부한 정보 를 액세스 할 수 있습니다. 이 정보에는 각 레코드에 대한 요청, 응답, 전체 MLflow Trace, 트레이스에서 후처리된 사용 가능하고 호출된 도구 등이 포함됩니다.

왜 중요한가요: 이 유연성은 비즈니스 특정 규칙이나 고급 검사를 자동 평가의 일급 메트릭으로 정의할 수 있게 해줍니다.

사용자 정의 지표를 정의하는 방법에 대해서는 우리 문서를 통해 확인할 수 있습니다.

임의의 입력/출력 스키마

실제 GenAI 워크플로우는 채팅 애플리케이션에만 국한되지 않습니다. 문서를 입력하고 주요 정보의 JSON을 반환하는 배치 처리 에이전트가 있을 수 있거나, LLMI를 사용하여 템플릿을 작성할 수 있습니다. 에이전트 평가는 이제 임의의 입력/출력 스키마를 평가하는 것을 지원합니다.

작동 원리: 직렬화 가능한 Dictionary (예: dict[str, Any])를 mlflow.evaluate()의 입력으로 전달합니다.

왜 중요한가요: 이제 에이전트 평가를 통해 모든 GenAI 애플리케이션을 평가할 수 있습니다.

임의의 스키마에 대해 더 자세히 알아보려면 우리의 문서를 참조하세요.

도메인 전문가와 협력하여 레이블 수집

자동 평가만으로는 고품질의 GenAI 앱을 제공하는 데 충분하지 않습니다. GenAI 개발자들은 종종 자신들이 구축하고 있는 사용 사례의 도메인 전문가가 아니기 때문에, 비즈니스 이해 관계자와 협력하여 자신들의 GenAI 시스템을 개선하는 방법이 필요합니다.

Review App: 맞춤형 레이블링 UI

저희는 Agent Evaluation Review App을 업그레이드하여, 도메인 전문가로부터 평가 데이터셋을 구축하거나 피드백을 수집하는 데 도움이 되는 사용자 정의 피드백을 쉽게 수집할 수 있게 했습니다. Review App은 Databricks MLFlow GenAI 생태계와 통합되어 개발자 ⇔ 전문가 간 협업을 단순화하면서도 완전히 사용자 정의 가능한 UI를 제공합니다.

이제 리뷰 앱에서 다음을 할 수 있습니다:

- 피드백 또는 예상 레이블 수집: GenAI 앱에서 개별 생성물에 대한 좋아요 또는 싫어요 피드백을 수집하거나, 평가 데이터셋을 구축하기 위해 예상 레이블을 수집하여 단일 인터페이스에서 평가 데이터셋을 구축합니다.

- 라벨링을 위한 모든 트레이스 전송: 개발, 사전 생산, 또는 생산에서 도메인 전문가 라벨링을 위한 트레이스를 전달합니다.

- 라벨링 사용자 정의: 라벨링 세션에서 전문가에게 제시되는 질문을 맞춤 설정하고, 수집할 라벨과 설명을 정의하여 데이터가 사용자의 특정 도메인 활용 사례에 정확히 부합하도록 설정합니다.

예시: 개발자는 생산 GenAI 앱에서 잠재적으로 문제가 될 수 있는 흔적을 찾아 도메인 전문가에게 검토를 위해 해당 흔적을 보낼 수 있습니다. 도메인 전문가는 링크를 받아 멀티턴 채팅을 검토하고, 어시스턴트의 답변이 관련 없는 곳을 라벨링하고, 평가 데이터셋을 구성하기 위해 예상 응답을 제공합니다.

왜 중요한가요: 도메인 전문가 라벨과의 협업을 통해 GenAI 앱 개발자들은 사용자에게 더 높은 품질의 애플리케이션을 제공할 수 있으며, 이는 비즈니스 이해관계자들이 배포된 GenAI 애플리케이션이 고객에게 가치를 제공하고 있다는 데 대한 더 높은 신뢰를 줍니다.

"브리지스톤에서는 데이터를 활용하여 GenAI 사용 사례를 추진하고 있으며, Mosaic AI Agent Evaluation은 GenAI 초기화가 정확하고 안전한지 확인하는 데 중요한 역할을 하고 있습니다. 리뷰 앱과 평가 데이터셋 도구를 통해 더 빠르게 반복하고 품질을 향상시키며 비즈니스의 신뢰를 얻을 수 있었습니다.” — Coy McNew, Lead AI Architect, Bridgestone

자세한 내용은 우리의 문서를 참고하여 업데이트된 리뷰 앱 사용법을 익혀보세요.

평가 데이터셋: GenAI의 테스트 스위트

평가 데이터셋은 GenAI의 "단위" 및 "통합" 테스트에 해당하는 것으로 등장하여, 개발자들이 GenAI 애플리케이션의 품질과 성능을 검증하고 프로덕션에 배포하기 전에 도움을 줍니다.

Agent Evaluation의 Evaluation Dataset, Unity Catalog에서 관리되는 Delta Table로 노출되어, 평가 데이터의 수명 주기를 관리하고, 다른 이해관계자와 공유하며, 접근을 관리할 수 있습니다. Evaluation Datasets를 사용하면, Review App에서 레이블을 쉽게 동기화하여 평가 워크플로우의 일부로 사용할 수 있습니다.

작동 방식: SDK를 사용하여 평가 데이터셋을 생성한 다음, 프로덕션 로그에서 추적을 추가하거나 Review App에서 도메인 전문가 레이블을 추가하거나 합성 평가 데이터를 추가합니다.

왜 중요한가요: 평가 데이터셋을 사용하면 생산에서 확인한 문제를 반복적으로 수정하고 새 버전을 출시할 때 회귀가 없음을 보장할 수 있습니다. 이는 비즈니스 이해관계자들이 앱이 가장 중요한 테스트 케이스에서 작동한다는 확신을 줍니다.

"Mosaic AI Agent Evaluation 리뷰 앱은 평가 데이터셋을 생성하고 관리하는 것을 크게 간편하게 만들어, 우리 팀이 데이터를 다루는 것보다 에이전트 품질을 개선하는 데 집중할 수 있게 했습니다. 내장된 합성 데이터 생성 기능을 통해, 우리는 수동 라벨링을 기다리지 않고 빠르게 테스트하고 반복할 수 있습니다 - 이로 인해 제품 출시까지의 시간을 50% 단축시킬 수 있습니다. 이로 인해 우리의 작업 흐름이 간소화되고 AI 시스템의 정확성이 향상되었습니다. 특히 고객 서비스 센터를 지원하기 위해 구축된 AI 에이전트에서 그렇습니다.” — Chris Nishnick, Director of Artificial Intelligence at Lippert

GenAI 앱을 평가하고 개선하는 방법에 대한 엔드-투-엔드 워크스루 (샘플 노트북 포함)

이제 이러한 기능들이 베타 테스터나 최종 사용자에게 출시된 GenAI 앱의 품질을 개선하는 데 어떻게 도움이 될 수 있는지 살펴보겠습니다.

> 이 과정을 직접 거쳐보려면, 우리의 문서에서 이 블로그를 노트북으로 가져올 수 있습니다.

아래 예제는 Databricks에 대한 질문에 답하는 데 도움이 되도록 배포된 간단한 도구 호출 에이전트를 사용합니다. 이 에이전트는 몇 가지 간단한 도구와 데이터 소스를 가지고 있습니다. 이 에이전트가 어떻게 구축되었는지에 대한 초점을 맞추지 않을 것이지만, 이 에이전트를 구축하는 방법에 대한 심층적인 안내를 원한다면, GenAI 앱 개발자 워크플로우를 참조하십시오. 이 워크플로우는 GenAI 앱 개발의 종단간 과정을 안내합니다 [AWS | Azure].

MLflow로 에이전트를 계측하세요

먼저, MLflow 추적을 추가하고 Databricks에 추적을 로그로 기록하도록 설정합니다. 앱이 에이전트 프레임워크로 배포된 경우 이 작업은 자동으로 수행되므로, 앱이 Databricks 외부에 배포된 경우에만 이 단계가 필요합니다. 우리의 경우, LangGraph를 사용하고 있으므로, MLFlow의 자동 로깅 기능을 활용할 수 있습니다.

MLFlow는 LangChain, LangGraph, OpenAI 등 대부분의 인기 있는 GenAI 라이브러리에서 자동 로깅을 지원합니다. 만약 당신의 GenAI 앱이 지원되는 GenAI 라이브러리 중 어느 것도 사용하지 않는다면 , 수동 추적을 사용할 수 있습니다:

프로덕션 로그 검토

이제 에이전트에 대한 생산 로그를 몇 가지 검토해 봅시다. 에이전트가 에이전트 프레임워크로 배포된 경우 payload_request_logs 추론 테이블 을 쿼리하고 databricks_request_id:로 몇 가지 요청을 필터링할 수 있습니다.

우리는 MLflow Trace 를 통해 각 제품 로그를 검사할 수 있습니다:

이 로그에서 평가 데이터셋을 생성하세요

에이전트와 우리의 비즈니스 요구 사항을 평가하기 위한 지표를 정의하세요

이제, 우리는 Agent 평가의 내장 판사들(새로운 가이드라인 판사 포함)과 사용자 정의 지표를 결합하여 평가를 진행할 것입니다:

- 사용 가이드라인:

- 에이전트가 가격 관련 질문에 대답을 거부하는 것이 올바른가요?

- 에이전트의 응답이 사용자에게 관련이 있습니까?

- 사용하기 사용자 정의 지표:

- 에이전트가 선택한 도구가 사용자의 요청에 주어진 논리적인가요?

- 에이전트의 응답은 도구의 출력에 기반을 두고 있고, 환영하는 것이 아닌가요?

- 에이전트의 비용과 지연 시간은 얼마나 됩니까?

이 블로그 게시물의 간결함을 위해 위의 메트릭 중 일부만 포함되었지만, 데모 노트북에서 전체 정의를 볼 수 있습니다

평가를 실행합니다

이제, 우리는 Agent Evaluation의 MLflow와의 통합을 사용하여 이러한 메트릭을 우리의 평가 세트에 대해 계산할 수 있습니다.

이 결과를 보면 몇 가지 문제가 있습니다:

- 에이전트가 질문에 합계가 필요할 때 multiply 도구를 호출했습니다.

- 스파크에 대한 질문은 우리의 데이터셋에 표현되지 않아 관련 없는 응답이 나왔습니다.

- LLM은 가격에 대한 질문에 응답하며, 이는 우리의 가이드라인을 위반합니다.

품질 문제 해결

이 두 가지 문제를 해결하기 위해 우리는 다음을 시도할 수 있습니다:

- LLM이 가격 질문에 응답하지 않도록 시스템 프롬프트를 업데이트합니다

- 덧셈을 위한 새 도구 추가

- 최신 스파크 버전에 대한 문서를 추가합니다.

그런 다음 우리는 문제가 해결되었는지 확인하기 위해 평가를 다시 실행합니다:

문제를 수정한 후 이를 생산에 다시 배포하기 전에 이를 이해당사자와 확인하세요

이제 문제를 해결했으니, 우리가 수정한 질문을 이해당사자에게 공개하여 그들이 고품질인지 확인하도록 리뷰 앱을 사용합시다. 우리는 도메인 전문가가 검토하는 동안 식별하는 피드백과 추가 가이드라인을 모두 수집하기 위해 리뷰 앱을 사용자 정의할 것입니다

우리는 Review App을 회사의 SSO에 있는 모든 사람과 공유할 수 있으며, 그들이 Databricks 작업 공간에 접근 권한이 없더라도 가능합니다.

마지막으로, 우리는 수집한 레이블을 평가 데이터셋에 동기화하고 도메인 전문가가 제공한 추가 지침 및 피드백을 사용하여 평가를 다시 실행할 수 있습니다.

그것이 확인되면, 우리는 우리의 앱을 다시 배포할 수 있습니다!

다음에는 무엇이 오나요?

우리는 이미 다음 세대의 기능에 대해 작업 중입니다.

첫째, Agent Evaluation과��의 통합을 통해, GenAI를 위한 Lakehouse 모니터링, GenAI 앱 성능(지연 시간, 요청 볼륨, 오류) 및 품질 지표(정확도, 정확성, 준수)의 생산 모니터링을 지원합니다. Lakehouse 모니터링을 사용하여 GenAI 개발자는 다음을 수행할 수 있습니다:

- 품질과 운영 성능(지연 시간, 요청 볼륨, 오류 등)을 추적합니다.

- 제작 트래픽에서 드리프트나 회귀를 감지하기 위해 LLM 기반 평가를 실행하세요.

- 개별 요청을 깊게 파고들어 에이전트 응답을 디버그하고 개선합니다.

- 실제 로그를 평가 세트로 변환하여 지속적인 개선을 추진합니다.

두 번째, MLflow Tracing [오픈 소스 | Databricks], 는 Open Telemetry 관찰 가능성에 대한 산업 표준 위에 구축되었으며, Databricks에서 배포되지 않은 경우에도 모든 GenAI 앱에서 관찰 가능성 (트레이스) 데이터를 수집하는 데 지원합니다. 몇 줄의 복사/붙여넣기 코드로, 어떤 GenAI 앱이나 에이전트도 도구로 사용할 수 있고, 트레이스 데이터를 Lakehouse에 저장할 수 있습니다.

이러한 기능을 시도하려면, 계정 팀에 문의하십시오.

시작하기

생산 중인 AI 에이전트를 모�니터링하든, 평가를 커스터마이징하든, 비즈니스 이해관계자와의 협업을 간소화하든, 이러한 도구들은 더욱 신뢰할 수 있고, 고품질의 GenAI 애플리케이션을 구축하는 데 도움이 될 수 있습니다.

시작하려면 문서를 확인하세요:

- 위의 데모 노트북 을 시도해 보세요

- 모자이크 AI 에이전트 평가 리뷰 앱

- MLflow 추적

- 모자이크 AI 에이전트 평가 사용자 정의 지표

- Mosaic AI Agent Evaluation 가이드라인 판사

데모 비디오를 시청하세요.

그리고 AI 에이전트에 대한 간결한 가이드 를 확인하여 GenAI ROI를 최대화하는 방법을 배우세요.