Apache Spark™ 구조화된 스트리밍에서 transformWithState 소개

유연하고 확장 가능한 상태 유지 스트리밍 쿼리 구축

발행일: February 24, 2025

작성자: 아니쉬 슈리곤데카르, 보 가오, Craig Lukasik, 에릭 마르나디, 제이 팔라니아판, 징 잔, 정택 임, 카르틱 라마사미, Neil Ramaswamy, Praveen Gattu, 탕감 바이야푸리

Summary

- 더 유연한 상태 유지 처리 - transformWithState는 유연한 상태 관리, 복합 데이터 유형, 이벤트 기반 프로그래밍을 통해 Apache Spark™ 구조화된 스트리밍을 향상시킵니다.

- 향상된 성능 & 간소화 - TTL 기반 상태 만료, 복합 유형, 연산자 연결, 원활한 상태 초기화와 같은 기능은 복잡성을 줄이고 효율성을 향상시킵니다.

- 미래 준비 & 확장 가능 - 기본 스키마 진화와 Databricks 기능과의 깊은 통합은 신뢰할 수 있고 확장 가능한 스트리밍 애플리케이션을 보장합니다.

(이 글은 AI의 도움을 받아 번역되었습니다. 원문이 궁금하시다면 여기를 클릭해 주세요)

소개

상태 유지 스트림 처리는 지금까지 본 이벤트를 기반으로 상태를 유지하면서 실시간으로 연속적인 이벤트 스트림을 처리하는 것을 의미합니다. 이를 통해 시스템은 이벤트 스트림에서 시간에 따른 변화와 패턴을 추적하고, 이 정보를 기반으로 결정을 내리거나 조치를 취할 수 있습니다.

Apache Spark 구조화된 스트리밍에서 상태 유지 스트림 처리는 내장 연산자(윈도우 집계, 스트림-스트림 조인, 중복 제거 등)를 사용하여 사전 정의된 로직을 지원하고, flatMapGroupWithState 또는 mapGroupWithState 를 사용하여 임의의 로직을 지원합니다. 임의의 로직을 통해 사용자들은 파이프라인에서 사용자 정의 상태 조작 코드를 작성할 수 있습니다. 그러나, 스트리밍의 기업에서의 채택이 증가함에 따라, 더 복잡하고 정교한 스트리밍 애플리케이션들은 개발자들이 상태 유지 스트리밍 파이프라인을 작성하는 것을 더 쉽게 만들기 위해 여러 추가 기능을 요구합니다.

이러한 새롭고 성장하는 상태 유지 스트리밍 애플리케이션 또는 운영적 사용 사례를 지원하기 위해, Spark 커뮤니티는 transformWithState라는 새로운 Spark 연산자를 도입하고 있습니다. 이 연산자를 사용하면 유연한 데이터 모델링, 복합 유형, 타이머, TTL, transformWithState 이후의 상태 유지 연산자 연결, 스키마 진화, 다른 쿼리에서 상태 재사용, Unity Catalog, Delta Live Tables, Spark Connect 등 다양한 Databricks 기능과의 통합이 가능해집니다. 이 연산자를 사용하면 고객들은 Scala, Java 또는 Python과 같은 인기 있는 언어를 사용하여 mission-critical하고 복잡한 상태 유지 운영 사용 사례를 Databricks 플랫폼에서 안정적이고 효율적으로 개발하고 실행할 수 있습니다.

상태 유지 스트림 처리를 사용한 응용 프로그램/사용 사례

많은 이벤트 기반 애플리케이션 은 상태 유지 계산을 수행하여 액션을 트리거하거나 일반적으로 Apache Kafka/Apache Pulsar/Google Pub-Sub 등의 다른 이벤트 로그/메시지 버스에 기록되는 출력 이벤트를 의존합니다. 이러한 애플리케이션은 보통 규칙을 검증하고, 이상을 감지하고, 세션을 추적하는 등의 상태 기계를 구현하며, 이는 주로 다음을 기반으로 하류 시스템에서 액션을 트리거하는 데 사용되는 파생 결과를 생성합니다:

- 입력 이벤트

- 상태

- 시간 (처리 시간 및 이벤트 시간과 함께 작업할 수 있는 능력)

- 출력 이벤트

이러한 애플리케이션의 예로는 사용자 경험 추적, 이상 탐지, 비즈니스 프로세스 모니터링, 그리고 결정 트리가 있습니다.

transformWithState 소개: 더 강력한 상태 유지 처리 API

Apache Spark는 이제 transformWithState를 도입하여, 복잡한 실시간 스트리밍 애플리케이션을 더 유연하고 효율적이며 확장 가능하게 만드는 차세대 상태 유지 처리 연산자를 제공합니다. 이 새로운 API는 상태 관리, 이벤트 처리, 타이머 관리 및 스키마 진화에 대한 고급 기능을 제공하여 사용자가 복잡한 스트리밍 로직을 쉽게 구현할 수 있게 합니다.

고수준 디자인

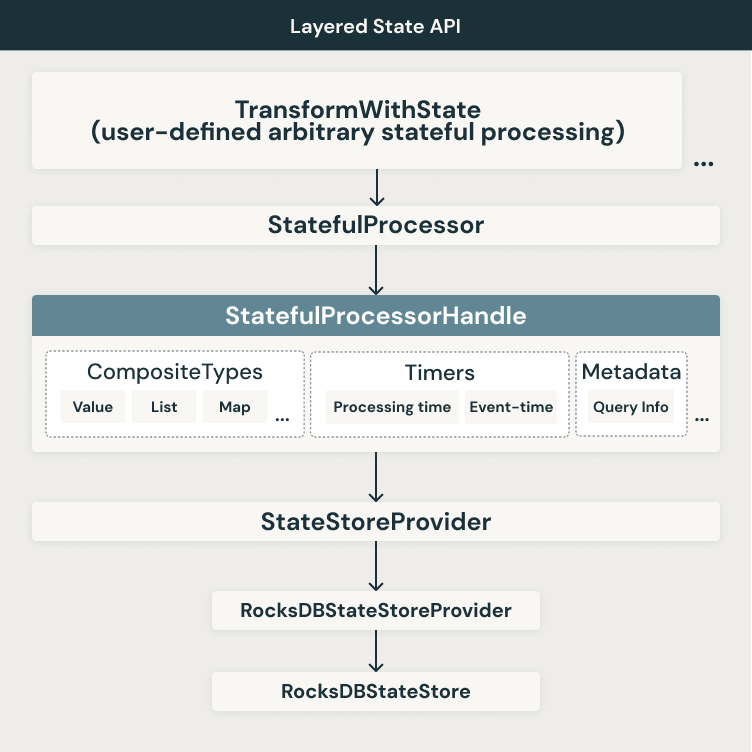

우리는 앞서 언급한 제한 사항을 해결하기 위해 새로운 계층화된, 유연한, 확장 가능한 API 접근법을 도입하고 있습니다. 아래에는 계층화된 아키텍처와 각 계층에서의 관련 기능을 보여주는 고수준 아키텍처 다이어그램이 표시됩니다.

�그림에서 볼 수 있듯이, 우리는 현재 사용 가능한 상태 백엔드를 계속 사용합니다. 현재 Apache Spark는 두 가지 상태 저장 백엔드를 지원합니다:

- HDFSBackedStateStoreProvider

- RocksDBStateStoreProvider

새로운 transformWithState 연산자는 처음에는 RocksDB 상태 저장소 공급자에서만 지원될 예정입니다. 우리는 범위 스캔, 병합 연산자 등의 다양한 RocksDB 기능을 사용하여 transformWithState 내에서 사용되는 다양한 기능에 대한 최적의 성능을 보장합니다. 이 계층 위에, 우리는 복합 유형, 타이머, 쿼리 메타데이터 등을 처리하는 데 StatefulProcessorHandle을 사용하는 또 다른 추상화 계층을 구축합니다. 연산자 수준에서는, 이러한 강력한 스트리밍 애플리케이션을 제공하는 데 사용되는 애플리케이션 로직을 포함할 수 있는 StatefulProcessor의 사용을 가능하게 합니다. 마침내 DataFrame API를 기반으로 한 Apache Spark 쿼리 내에서 StatefulProcessor를 사용할 수 있습니다.

다음은 transformWithState 연산자를 사용한 Apache Spark 스트리밍 쿼리의 예입니다:

transformWithState와 함께하는 주요 기능

상태 변수를 사용한 유연한 데이터 모델링

transformWithState를 사용하면, 사용자는 객체 지향 프로그래밍 모델에 기반한 StatefulProcessor 내에서 여러 독립적인 상태 변수 를 정의할 수 있습니다. 이 변수들은 개인 클래스 멤버처럼 작동하여, 단일 상태 구조를 필요로 하지 않는 세분화된 상태 관리를 가능하게 합니다. 이를 통해 새로운 체크포인트 디렉토리에서 쿼리를 다시 시작하지 않고 상태 변수를 추가하거나 수정함으로써 �애플리케이션 로직을 시간이 지남에 따라 쉽게 발전시킬 수 있습니다.

이벤트 기반 처리를 위한 타이머와 콜백

이제 사용자는 타이머를 등록하여 이벤트 기반 애플리케이션 로직을 트리거할 수 있습니다. API는 처리 시간 (벽시계 기반)과 이벤트 시간 (열 기반) 타이머를 모두 지원합니다. 타이머가 발화하면, 콜백이 발행되어 효율적인 이벤트 처리, 상태 업데이트, 및 출력 생성이 가능합니다. 타이머를 나열하고, 등록하고, 삭제하는 기능은 이벤트 처리에 대한 정확한 제어를 보장합니다.

복합 데이터 유형에 대한 기본 지원

복합 데이터 구조에 대한 내장 지원으로 상태 관리가 이제 더 직관적입니다:

- ValueState: 그룹화 키 당 하나의 값을 저장합니다.

- ListState: 키 당 값 목록을 유지하며, 효율적인 추가 작업을 지원합니다.

- MapState: 효율적인 포인트 조회를 가진 각 그룹화 키 내의 키-값 저장을 가능하게 합니다

Spark는 이러한 상태 유형을 자동으로 인코딩하고 유지하여 수동 직렬화의 필요성을 줄이고 성능을 향상시킵니다.

TTL을 이용한 자동 상태 만료

준수 및 운영 효율성을 위해, transformWithState 는 상태 변수에 대한 기본 생존 시간 (TTL) 지원을 도입합니다. 이를 통해 사용자는 만료 정책을 정의할 수 있으며, 이는 오래된 상태 데이터가 자동으로 제거되도록 보장하며 수동 정리를 필요로 하지 않습니다.

transformWithState 이후의 연산자 연결

이 새로운 API를 사용하면, 이벤트 시간을 시간 모드로 사용할 때조차 transformWithState 이후에 상태 유지 연산자를 연결할 수 있습니��다. 출력 스키마에서 이벤트 시간 열을 명시적으로 참조함으로써, 하위 연산자는 늦은 레코드 필터링 및 상태 퇴거를 원활하게 수행할 수 있습니다. 이는 여러 파이프라인과 외부 저장소를 포함하는 복잡한 우회 방법의 필요성을 제거합니다.

간소화된 상태 초기화

사용자는 기존 쿼리에서 상태를 초기화할 수 있어 스트리밍 작업을 다시 시작하거나 복제하기가 더 쉬워집니다. API는 상태 데이터 소스 리더와의 원활한 통합을 허용하여, 복잡한 마이그레이션 과정 없이 새로운 쿼리가 이전에 작성된 상태를 활용할 수 있게 합니다.

상태 유지 쿼리를 위한 스키마 진화

transformWithState 는 스키마 진화를 지원하여 다음과 같은 변경을 허용합니다:

- 필드 추가 또는 제거

- 필드 재정렬

- 데이터 유형 업데이트

Apache Spark는 자동으로 호환되는 스키마 업데이트를 감지하고 적용하여, 쿼리가 동일한 체크포인트 디렉토리 내에서 계속 실행될 수 있도록 합니다. 이로 인해 전체 상태 재구축 및 재처리의 필요성이 제거되어, 다운타임과 운영 복잡성이 크게 줄어듭니다.

상태 데이터 소스 리더와의 네이티브 통합

더 쉬운 디버깅과 관찰을 위해, transformWithState 는 상태 데이터 소스 리더와 기본적으로 통합되어 있습니다. 사용자는 상태 변수를 검사하고 상태 데이터를 직접 쿼리하여 문제 해결 및 분석을 간소화할 수 있으며, readChangeFeed 등의 고급 기능을 포함합니다.

가용성

transformWithState API는 현재 No-Isolation 및 Unity Catalog 전용 클러스터에서 Databricks Runtime 16.2 릴리스와 함께 사용 가능합니다. Unity Catalog 표준 클러스터와 서버리스 컴퓨트에 대한 지원이 곧 추가될 예정입니다. 또한 이 API는 Apache Spark™ 4.0 릴리스에서 오픈 소스로 사용 가능할 예정입니다.

결론

우리는 새로운 transformWithState API에 포함된 모든 기능 개선이 Apache Spark DataFrame API의 편안함과 사용 편의성 내에서 신뢰할 수 있고, 확장 가능하며, 고객과 사용자에게 가장 중요한 사용 사례를 지원하는 중요한 운영 작업 부하를 구축하는 데 도움이 될 것이라고 믿습니다. 중요한 것은, 이러한 변경 사항이 Apache Spark 구조화된 스트리밍에서 기본 제공 및 새로운 상태 유지 연산자에 대한 미래의 개선을 위한 기반을 마련한다는 것입니다. 우리는 지난 몇 년 동안 Apache Spark™ 구조화된 스트리밍에서의 상태 관리 개선에 대해 기대하고 있으며, 가까운 미래에 이 영역에서 계획된 로드맵 개발을 기대하고 있습니다.

상태 유지 스트림 처리 및 Databricks에서의 transformWithState에 대해 더 자세히 알아볼 수 있습니다.