Natürlich verwaltete Orchestrierung für jede Arbeitslast

Einheitliche Orchestrierung für Daten, Analytics und KI auf der Data Intelligence Platform

KUNDEN, DIE LAKEFLOW JOBS VERWENDEN

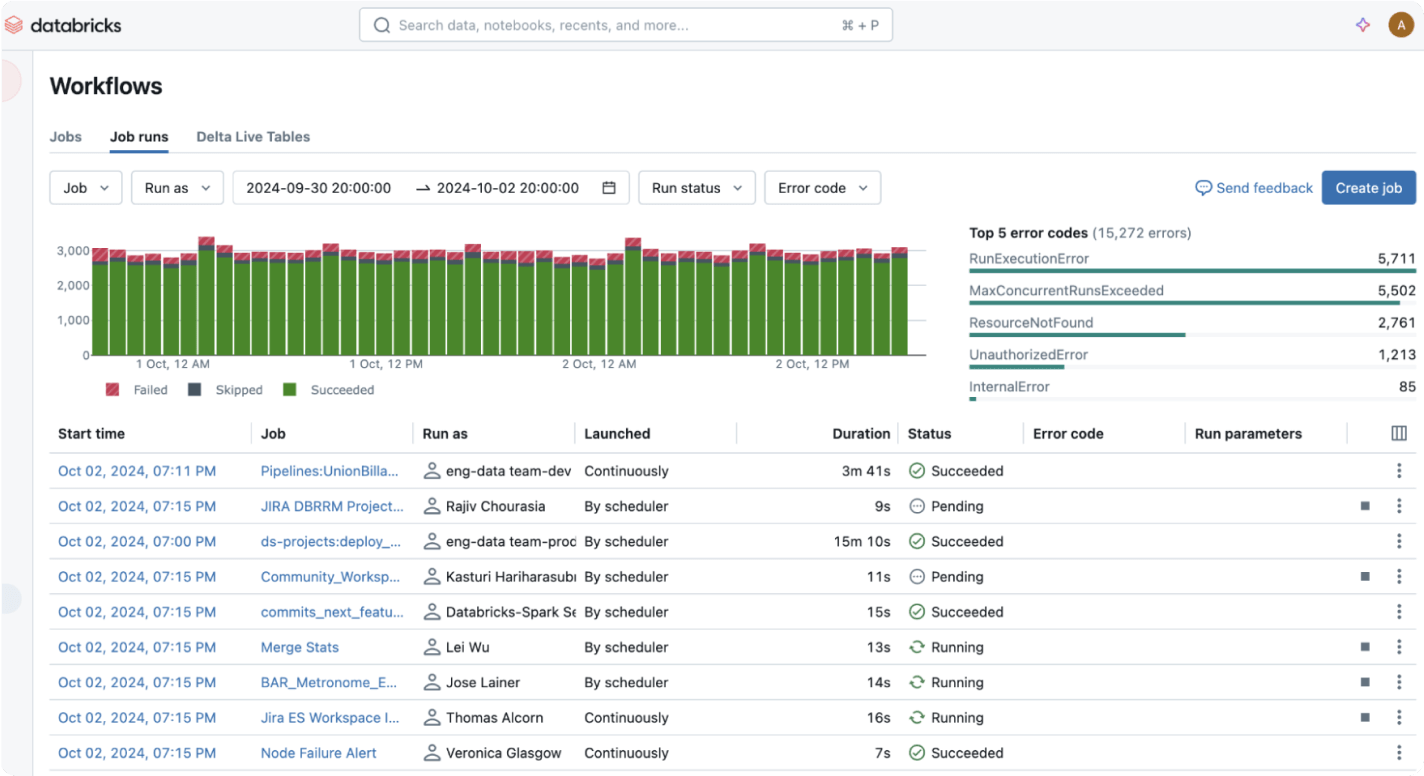

Orchestrieren Sie jeden Daten-, Analytik- oder KI-Workflow

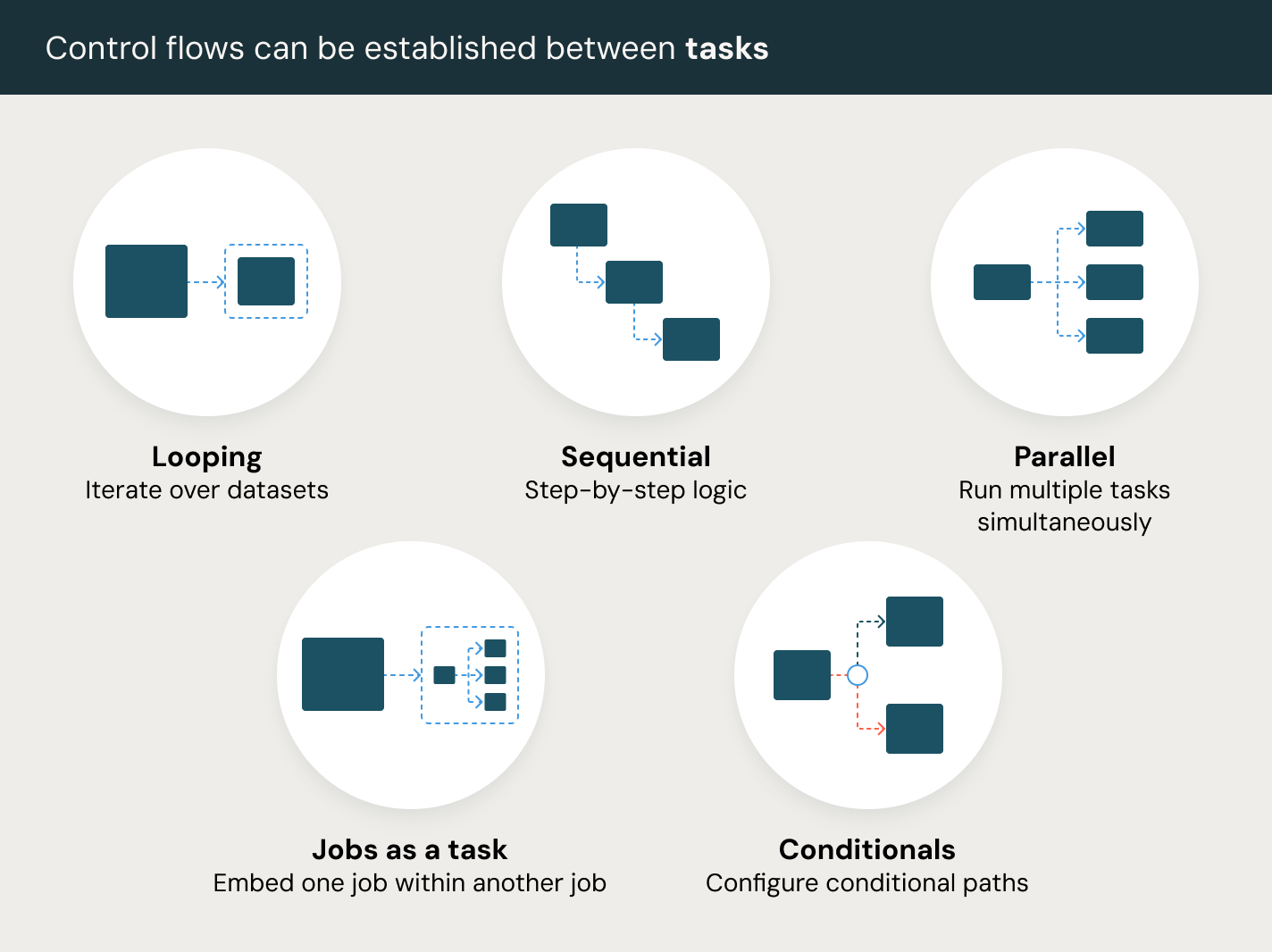

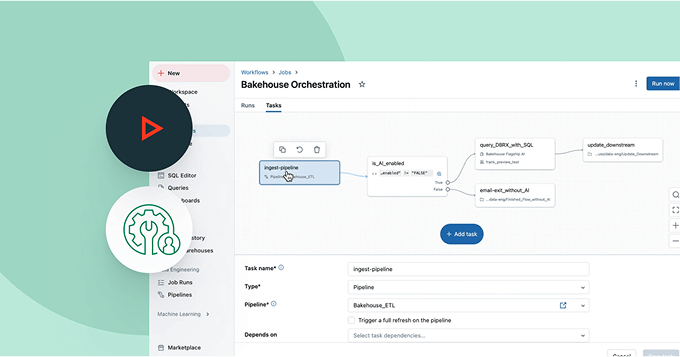

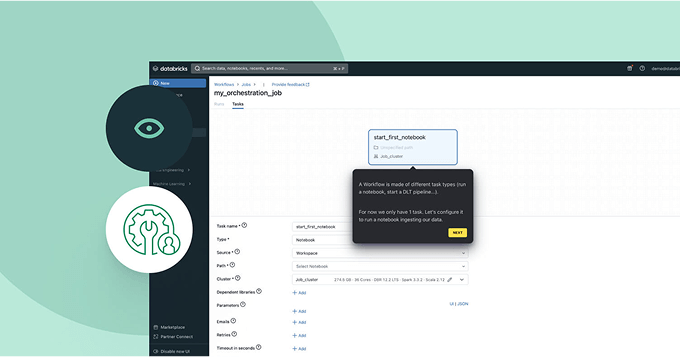

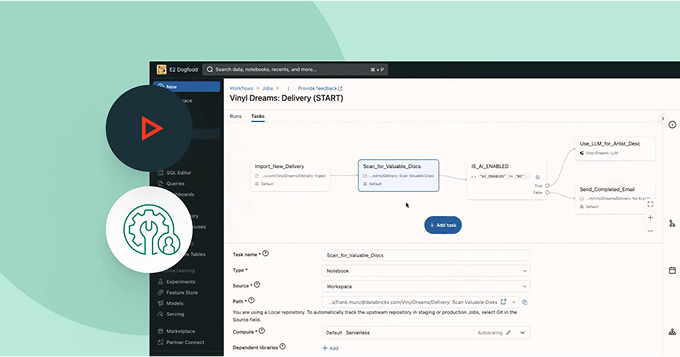

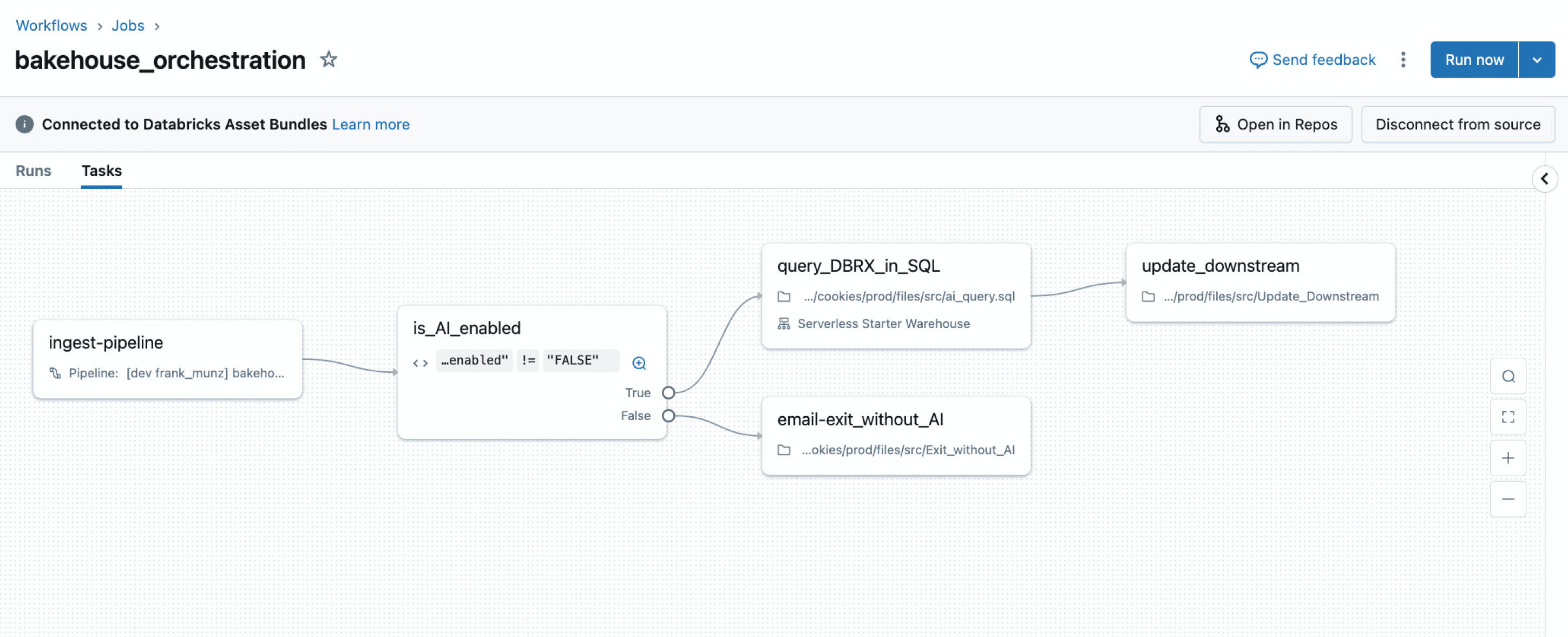

Vereinfachen Sie Ihre Pipelines mit einem integrierten Orchestrierungsdienst zur einfachen und zuverlässigen Automatisierung von ETL-, Analyse- und ML-Workflows.Vereinfachen und orchestrieren Sie Ihre Datenpipelines

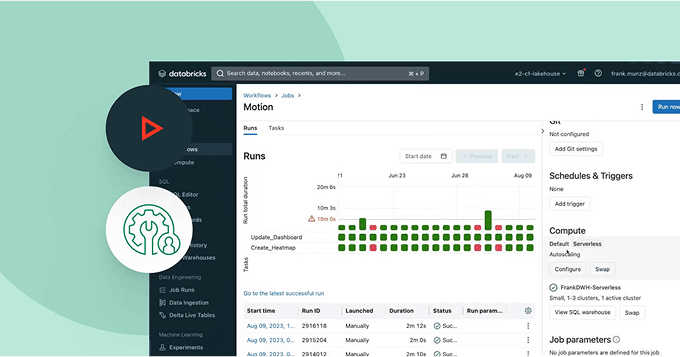

Definieren, verwalten und überwachen Sie Jobs einfach über ETL, Analytik und KI-Pipelines.Nutzen Sie nahtlose Orchestrierung mit vielseitigen Aufgabentypen, einschließlich Notebooks, SQL, Python und mehr, um jeden Datenworkflow zu unterstützen.

Weitere Funktionen

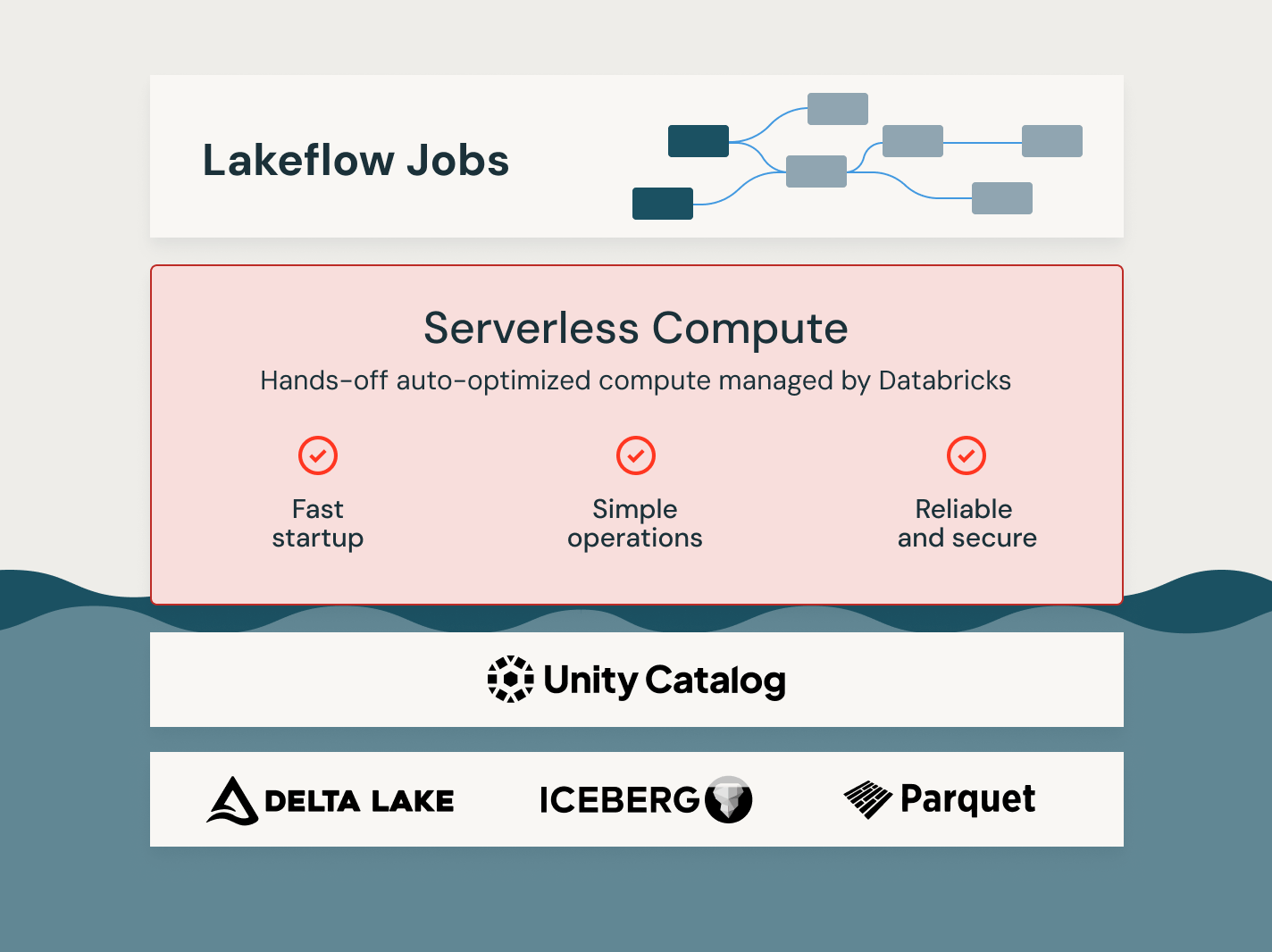

Nutzen Sie die Kraft von Lakeflow Jobs

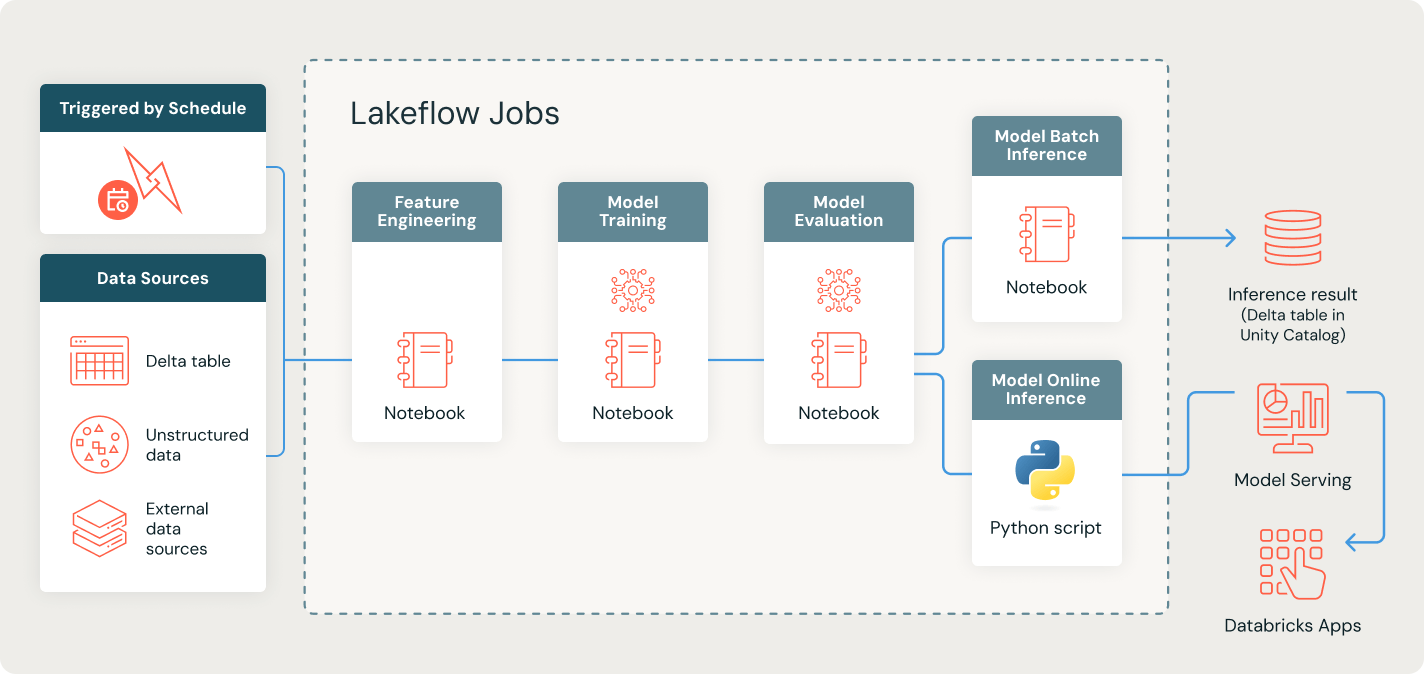

Automatisieren und orchestrieren Sie Ihren ML-Lebenszyklus - von der Datenvorbereitung bis zur Bereitstellung

Vereinfachen Sie die Vorbereitung von Machine-Learning-Modellen, indem Sie den End-to-End-Prozess des Extrahierens, Transformierens und Vorbereitens von Daten für das Training und die Inferenz automatisieren.

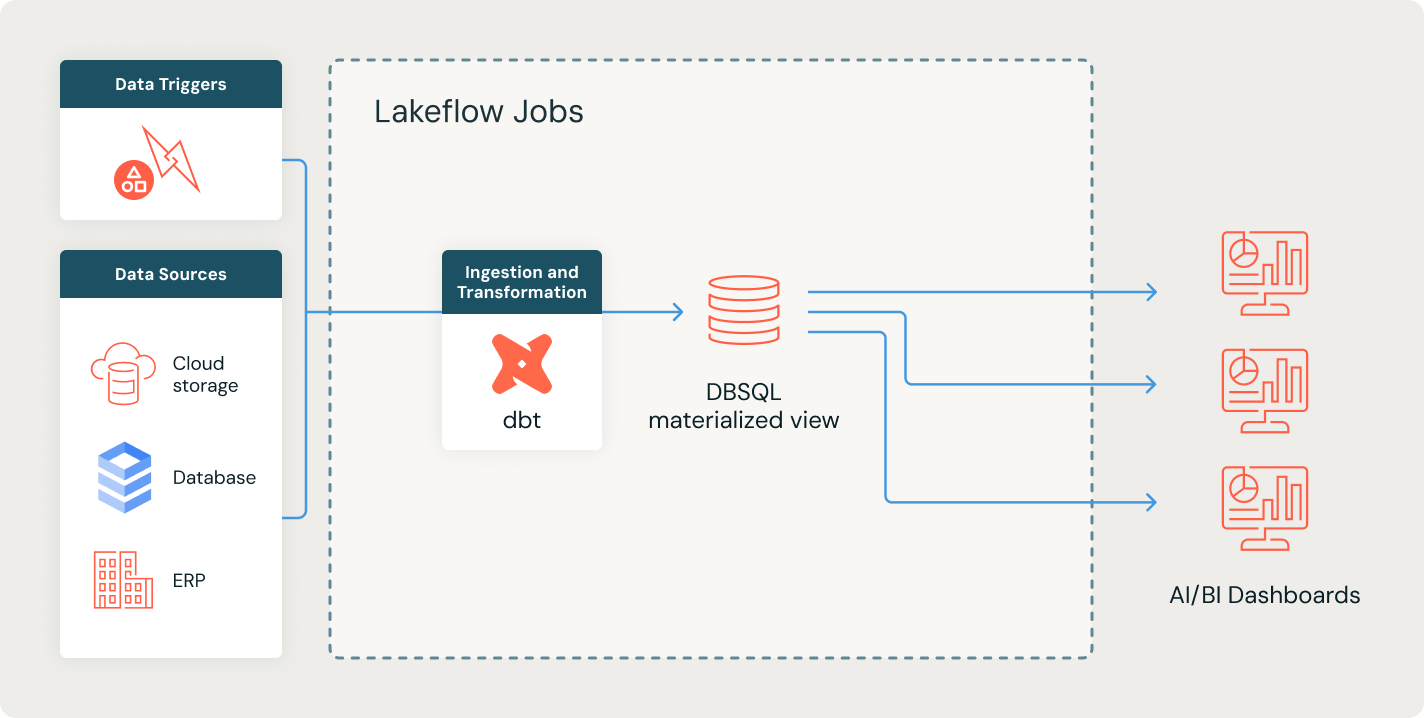

Vereinfachen Sie BI-Berichte mit automatisierten, zuverlässigen Datenpipelines.

Automatisieren Sie die Datenvorbereitung, um genaue und zeitnahe Erkenntnisse für Ihre Business-Intelligence-Tools zu liefern. Vereinfachen Sie Arbeitsabläufe, um Daten zu transformieren und selbstbewusste Entscheidungsfindung zu ermöglichen.

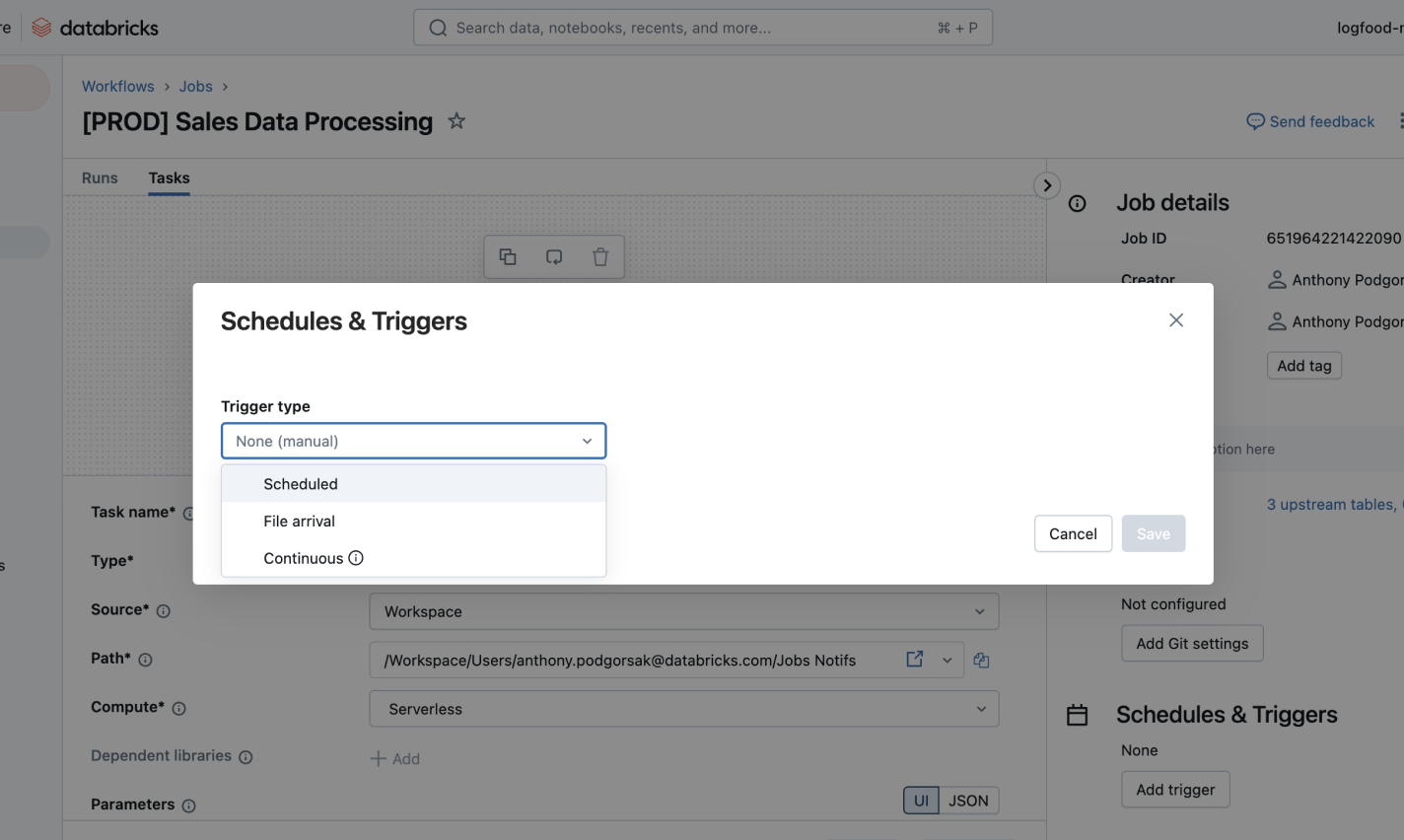

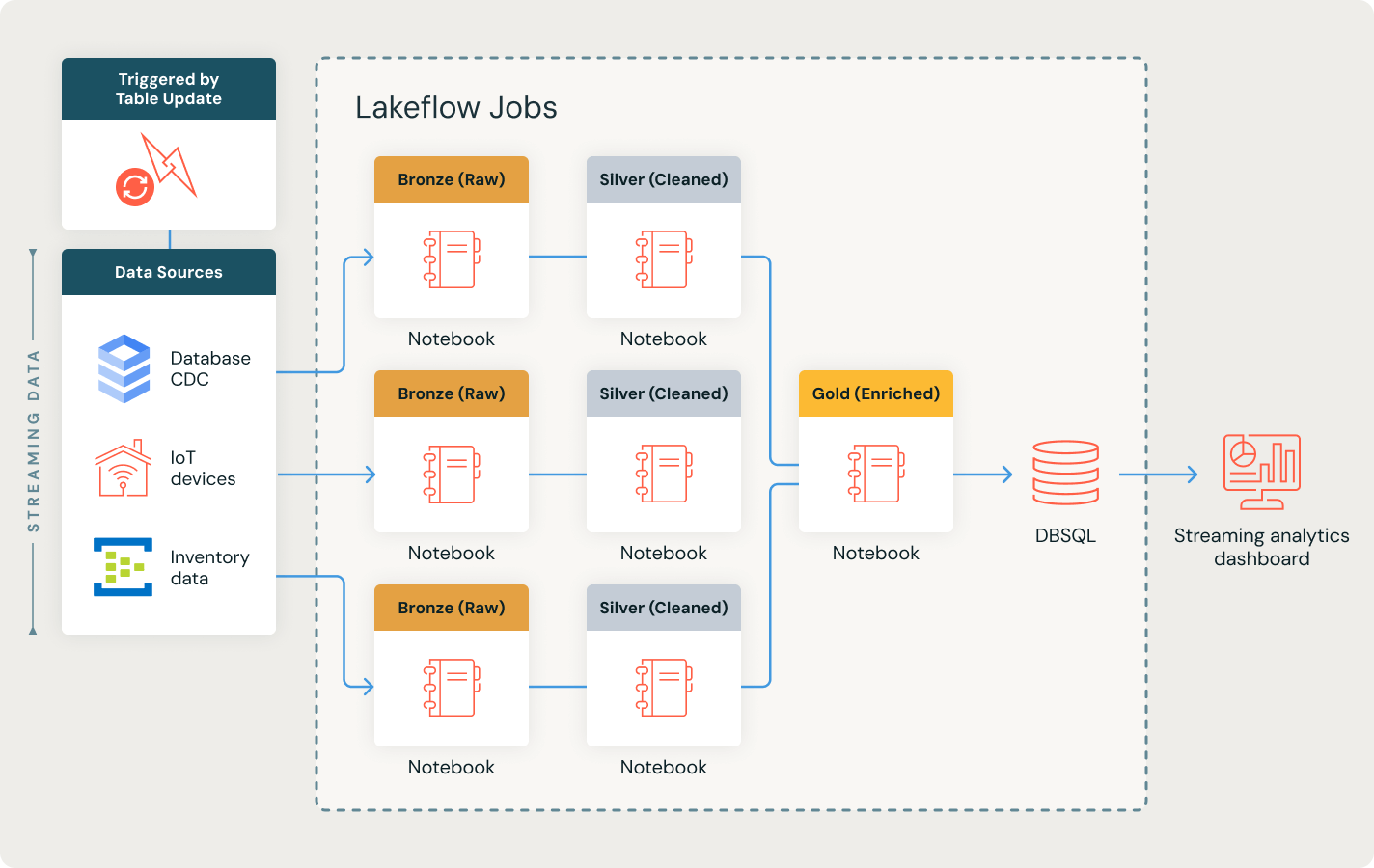

Reagieren Sie sofort mit Echtzeit-Datenpipelines

Entsperren Sie Echtzeit-Einblicke, indem Sie komplexe Datenpipelines mit Präzision orchestrieren. Verarbeiten Sie nahtlos Streaming-Daten im kontinuierlichen Modus, lösen Sie Aufgaben sofort aus und ermöglichen Sie schnelle, zuverlässige Analysen für datengesteuerte Entscheidungen.

Erkunden Sie Lakeflow Jobs Demos

Mehr entdecken

Erfahren Sie mehr darüber, wie die Databricks Data Intelligence Platform Ihre Datenteams bei all Ihren Daten- und KI-Workloads unterstützt.LakeFlow Connect

Effiziente Konnektoren für die Datenaufnahme aus beliebigen Quellen und native Integration mit der Data Intelligence Platform erschließen einen einfachen Zugang zu Analytik und KI mit einheitlicher Governance.

Spark Declarative Pipelines

Liefert vereinfachte, deklarative Pipelines für die Batch- und Streaming-Datenverarbeitung und gewährleistet automatisierte, zuverlässige Transformationen für Analyse- und KI/ML-Aufgaben.

Databricks Assistant

Nutzen Sie KI-gestützte Unterstützung, um das Programmieren zu vereinfachen, Arbeitsabläufe zu debuggen und Abfragen mit natürlicher Sprache zu optimieren, für eine schnellere und effizientere Datenverarbeitung und -analyse.

Lakehouse-Speicherung

Vereinheitlichen Sie die Daten in Ihrem Lakehouse format- und typenübergreifend für alle Ihre Analytics- und KI-Workloads.

Unity Catalog

Regulieren Sie alle Ihre Datenressourcen nahtlos mit der branchenweit einzigen einheitlichen und offenen Governance-Lösung für Daten und KI, die in die Data Intelligence Platform von Databricks integriert ist.

Die Data Intelligence Platform

Erfahren Sie mehr darüber, wie die Databricks Data Intelligence Platform Ihre Daten- und KI-Workloads unterstützt.

Wagen Sie den nächsten Schritt

Lakeflow Jobs FAQ

Möchten Sie ein Daten- und KI-Unternehmen werden?

Machen Sie die ersten Schritte Ihrer Datentransformation