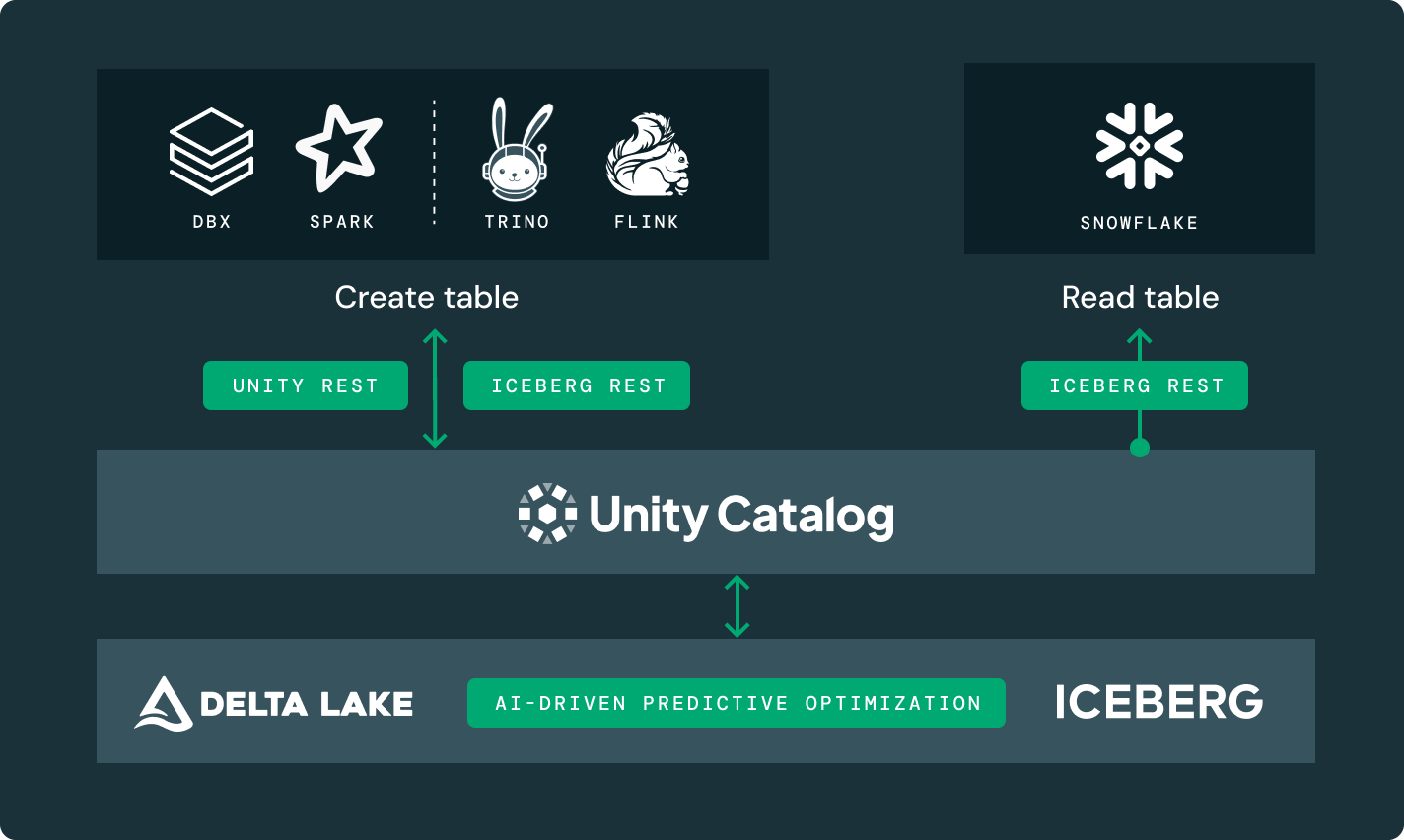

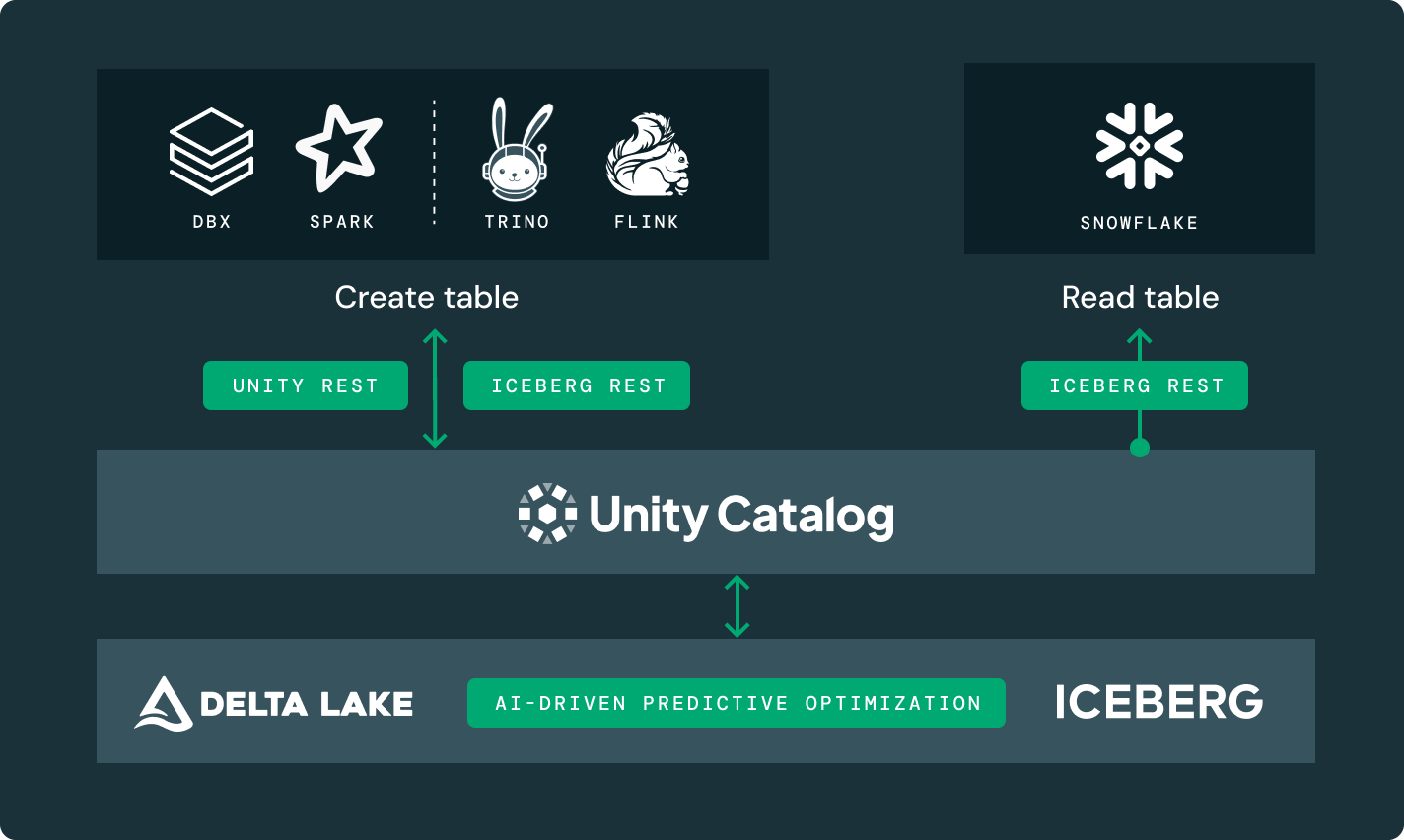

Entwickelt für offenen, intelligenten Datenspeicher

Wählen Sie Speicherort und -format selbst bei voller Kontrolle und Portabilität Ihrer Daten.

ERFOLGREICHE TEAMS NUTZEN DATA INTELLIGENCELakehouse-Speicher, der flexibel und schnell ist

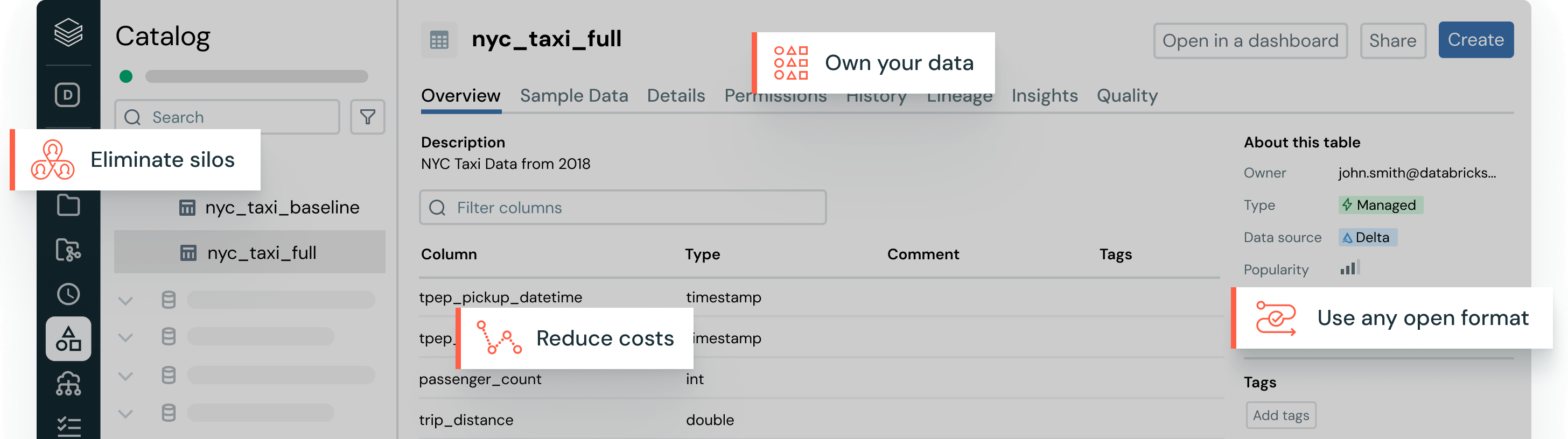

Beseitigen Sie Datenmanagement-Probleme mit offenen Tabellenformaten, zentralisierter Governance und automatischen Datenoptimierungen.Ihre Daten, auf Ihre Weise

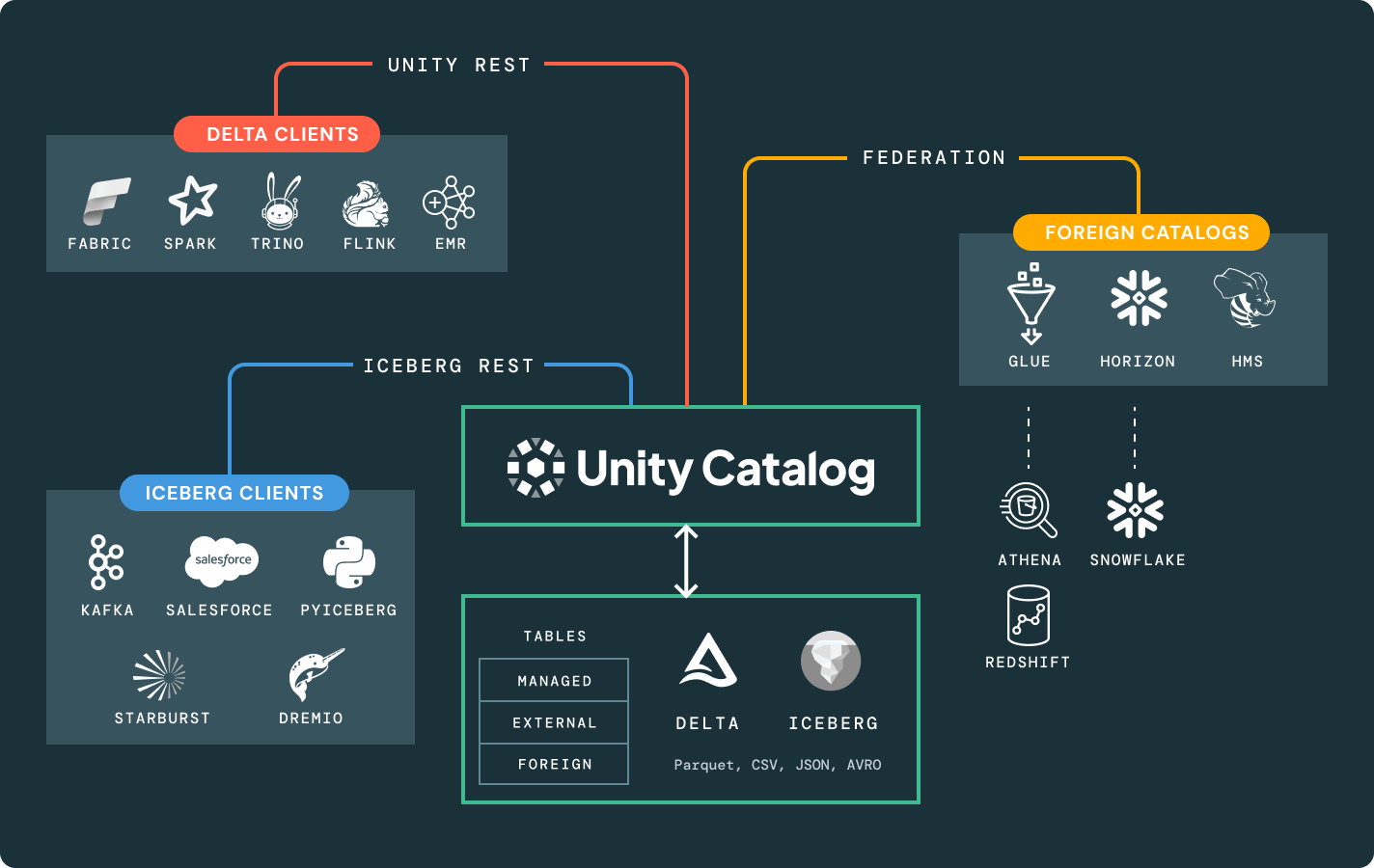

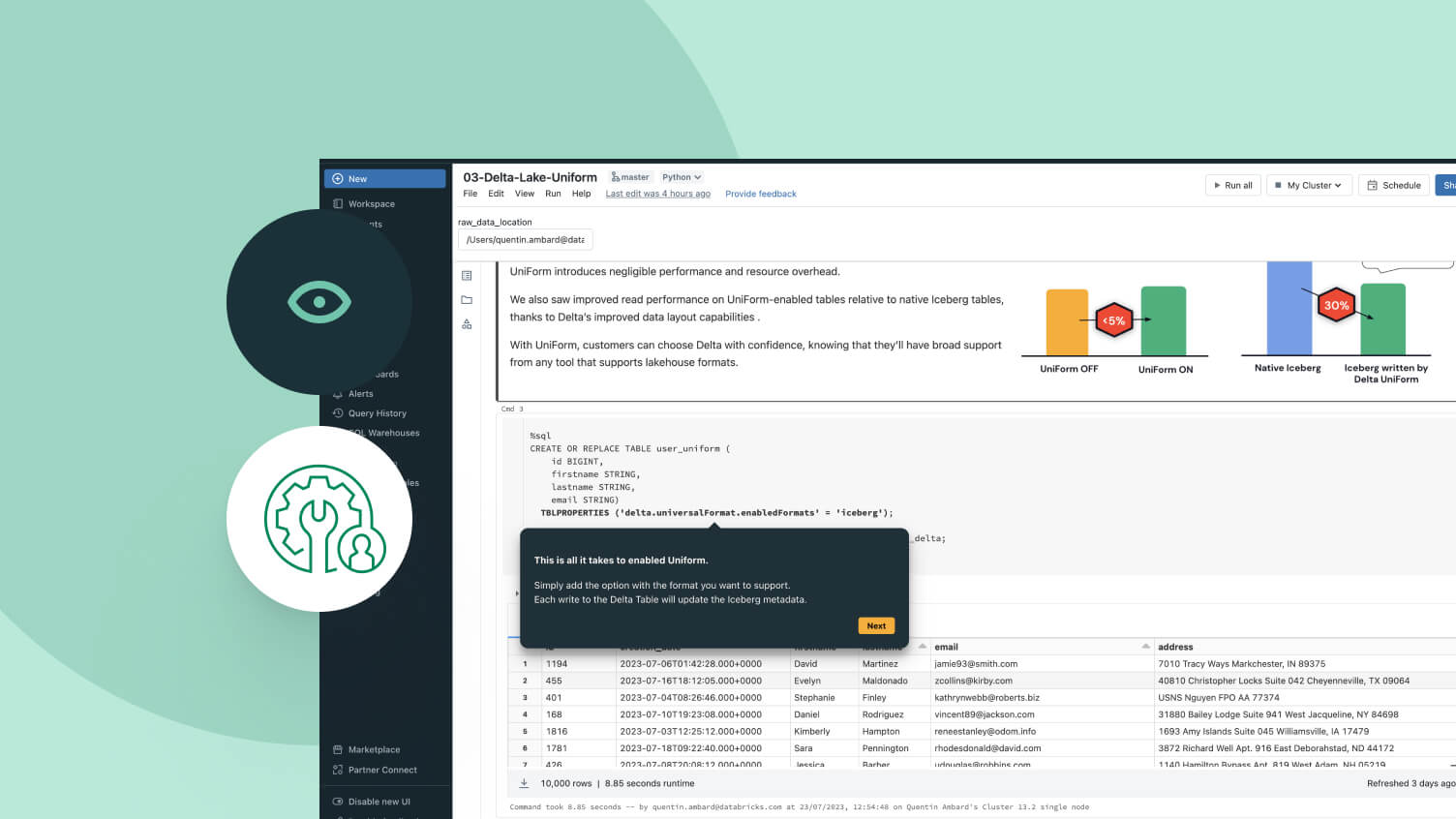

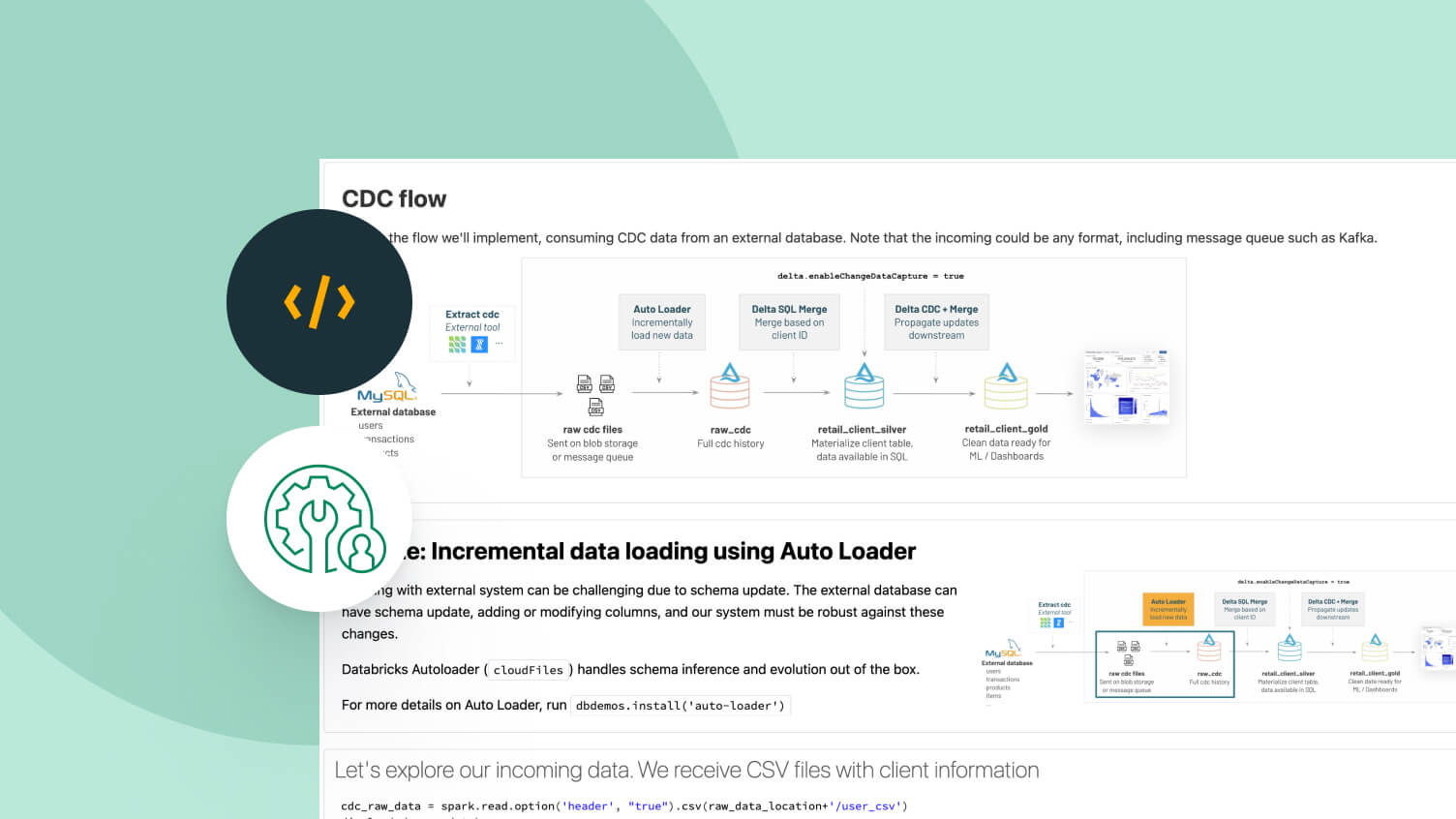

Wählen Sie den Speicherort und das offene Format, das für Sie funktioniert. Halten Sie Ihre Daten portabel, ohne Anbieterbindung.Best-in-Class-Lese- und Schreibperformance für Delta Lake und Apache Iceberg™-Tabellen, direkt aus der Box, mit Speicheroptimierungen, die in keinem anderen Lakehouse verfügbar sind.

Weitere Funktionen

Für alle Ihre Analyse- und KI-Workloads

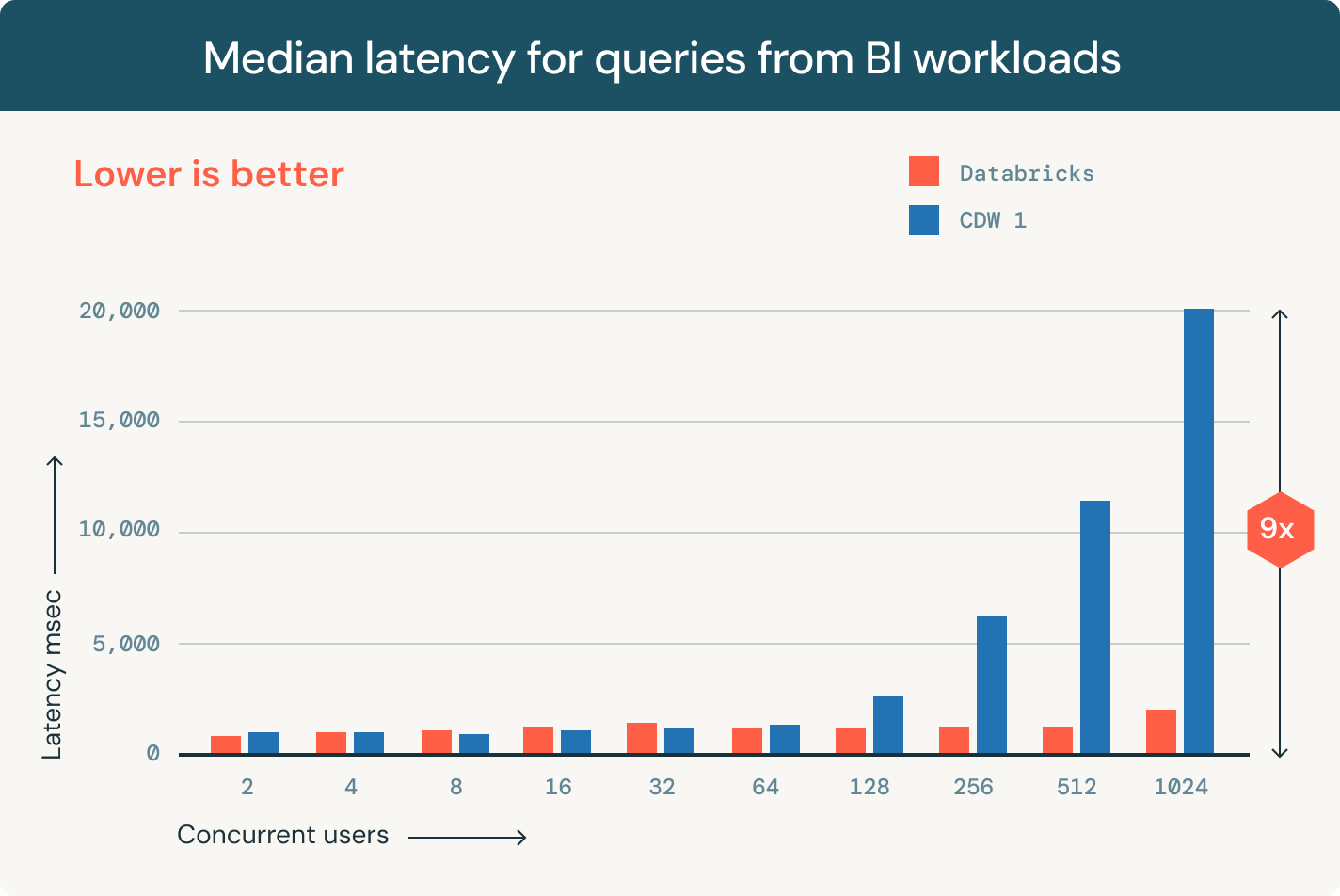

Führen Sie Analysen und BI-Workloads direkt auf Ihrem Daten-See aus

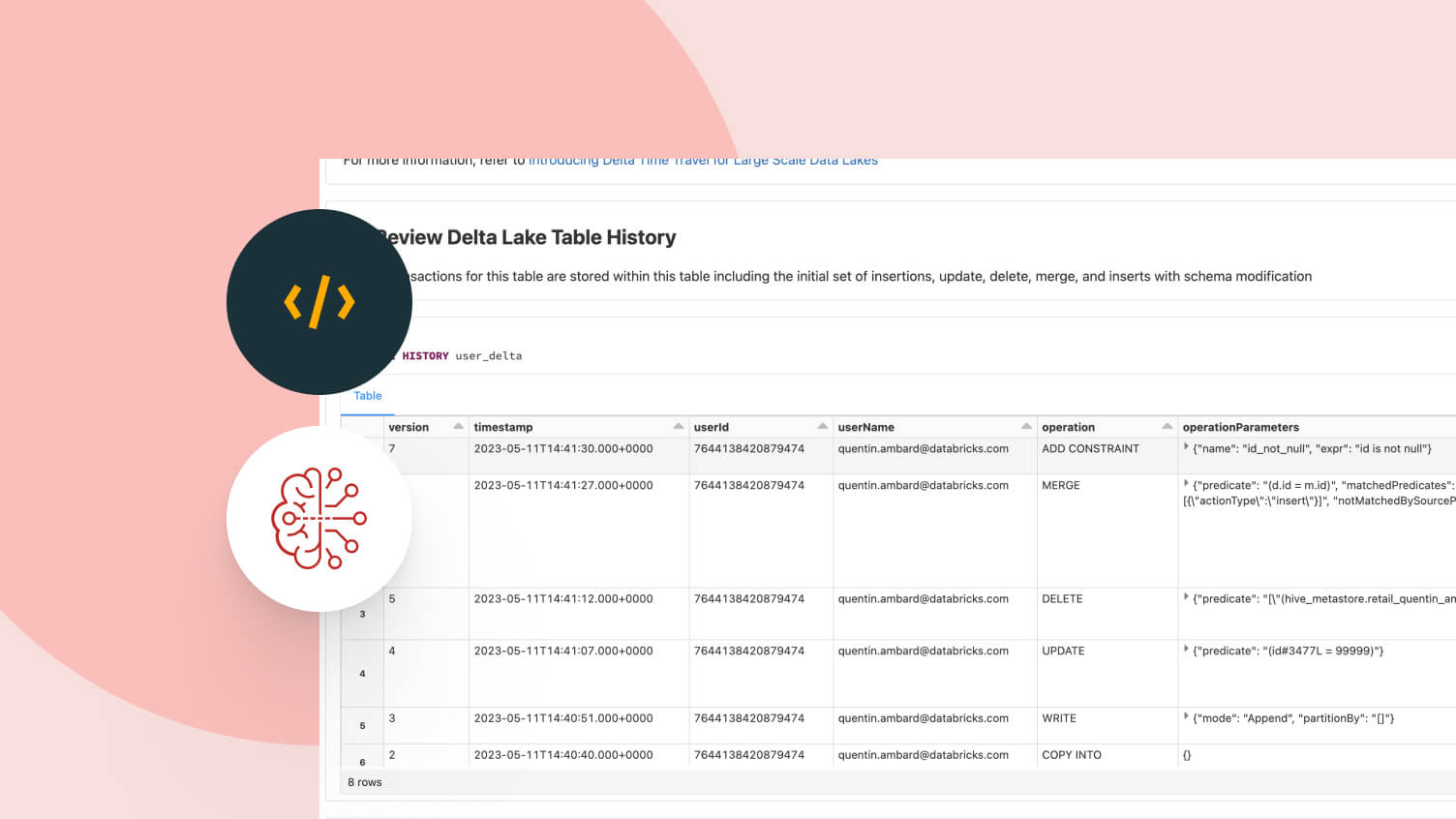

Mit Delta Lake können Sie eine Multicloud-Lakehouse-Architektur betreiben, die Data-Warehousing-Leistung zum günstigen Data-Lake-Preis bietet. Profitieren Sie von einem bis zu 6-mal besseren Preis-Leistungs-Verhältnis für SQL-Workloads im Vergleich zu herkömmlichen Cloud-Data-Warehouses.

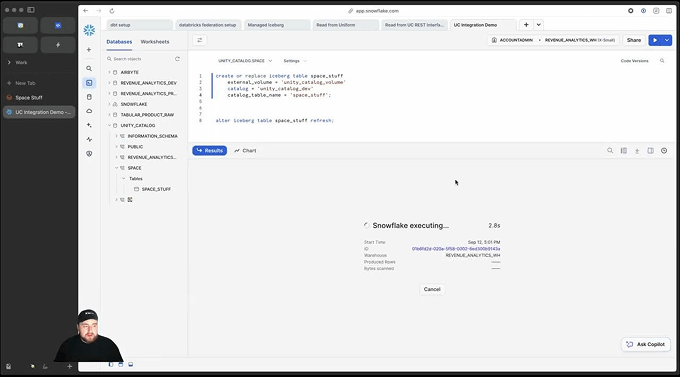

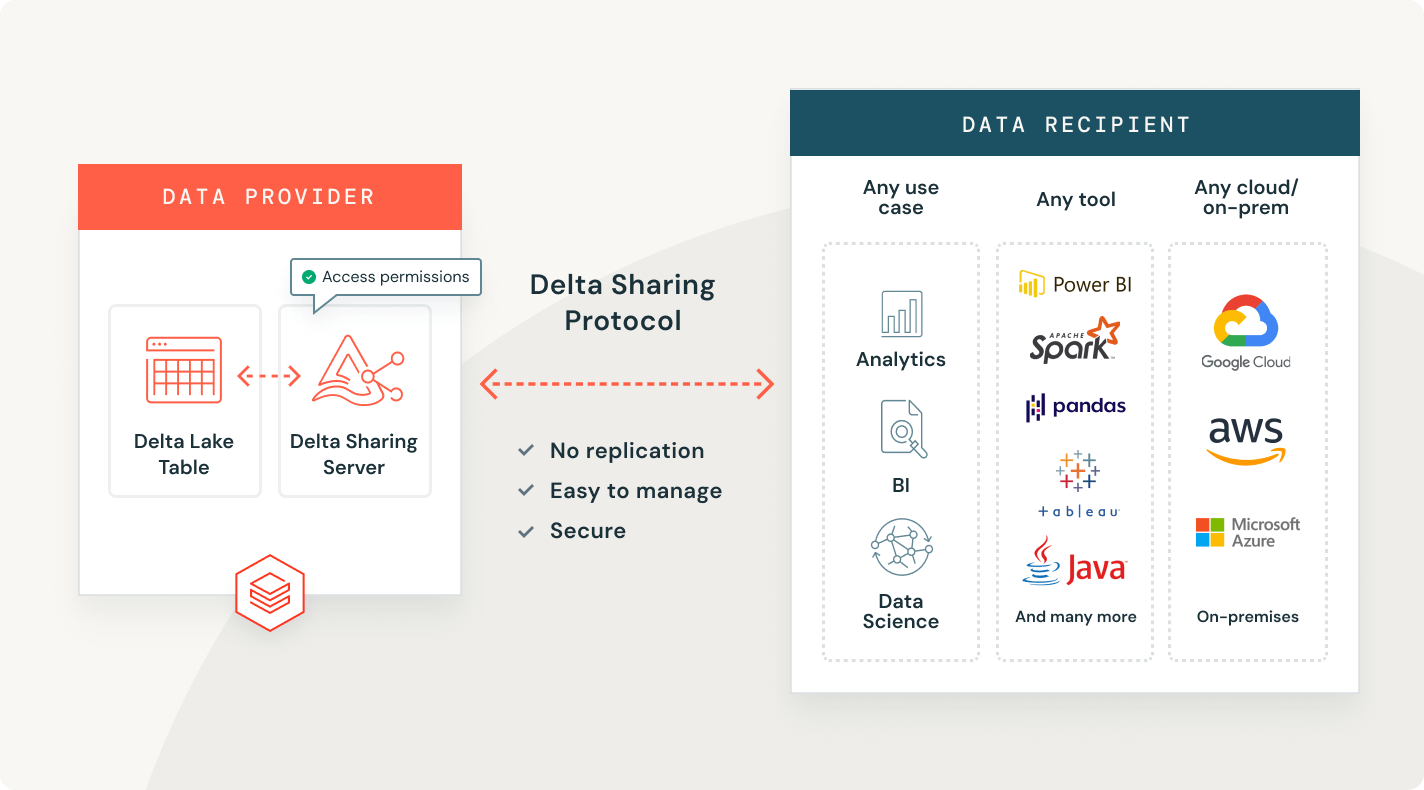

Live-Daten teilen

Sie können vorhandene Daten in Delta Lake oder Apache Iceberg mit jeder Datenplattform, Cloud oder Region teilen, ohne Kopien erstellen zu müssen.

Erkunden Sie Delta Lake Demos

Entdecken, verwalten und teilen Sie Ihre Daten- und KI-Ressourcen

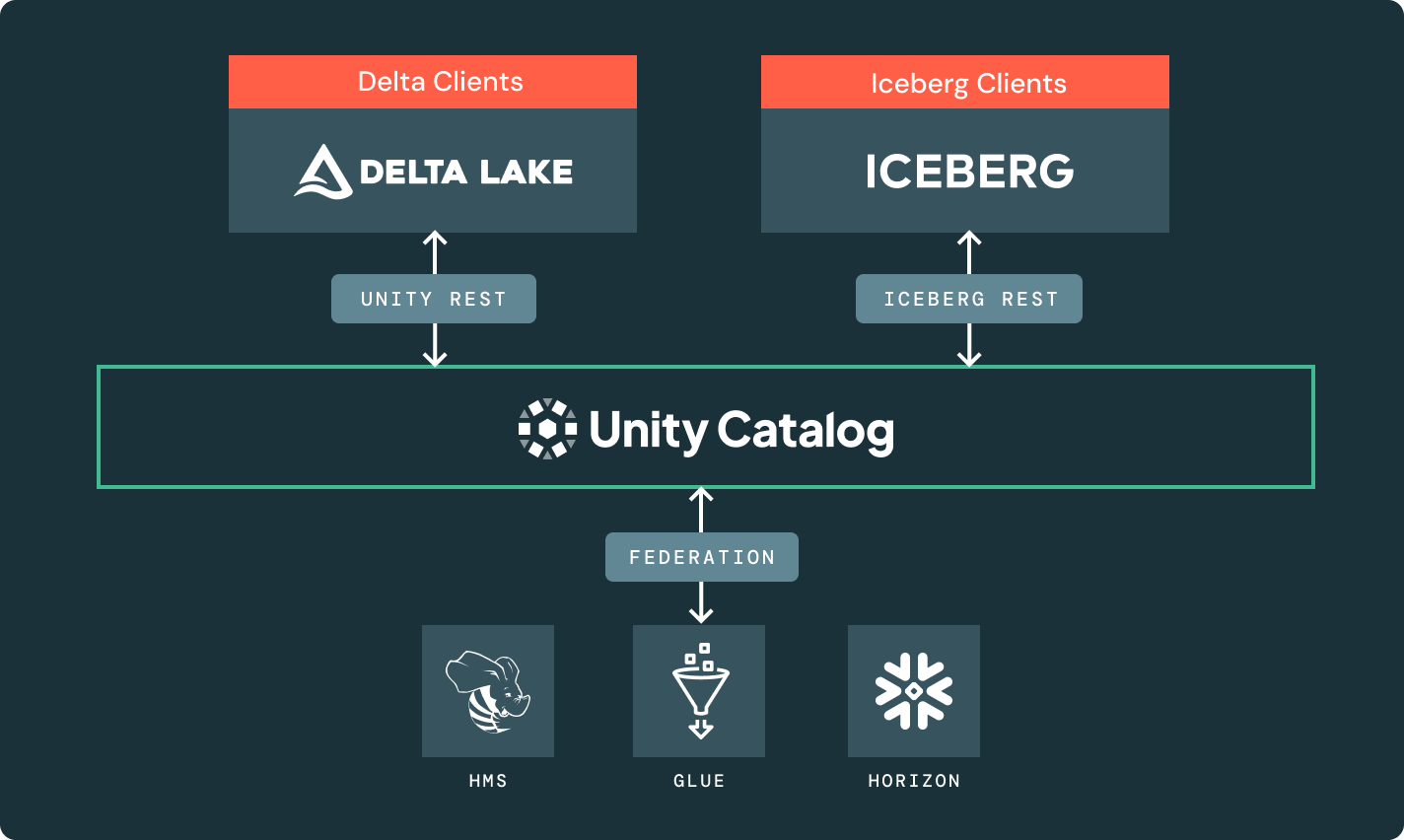

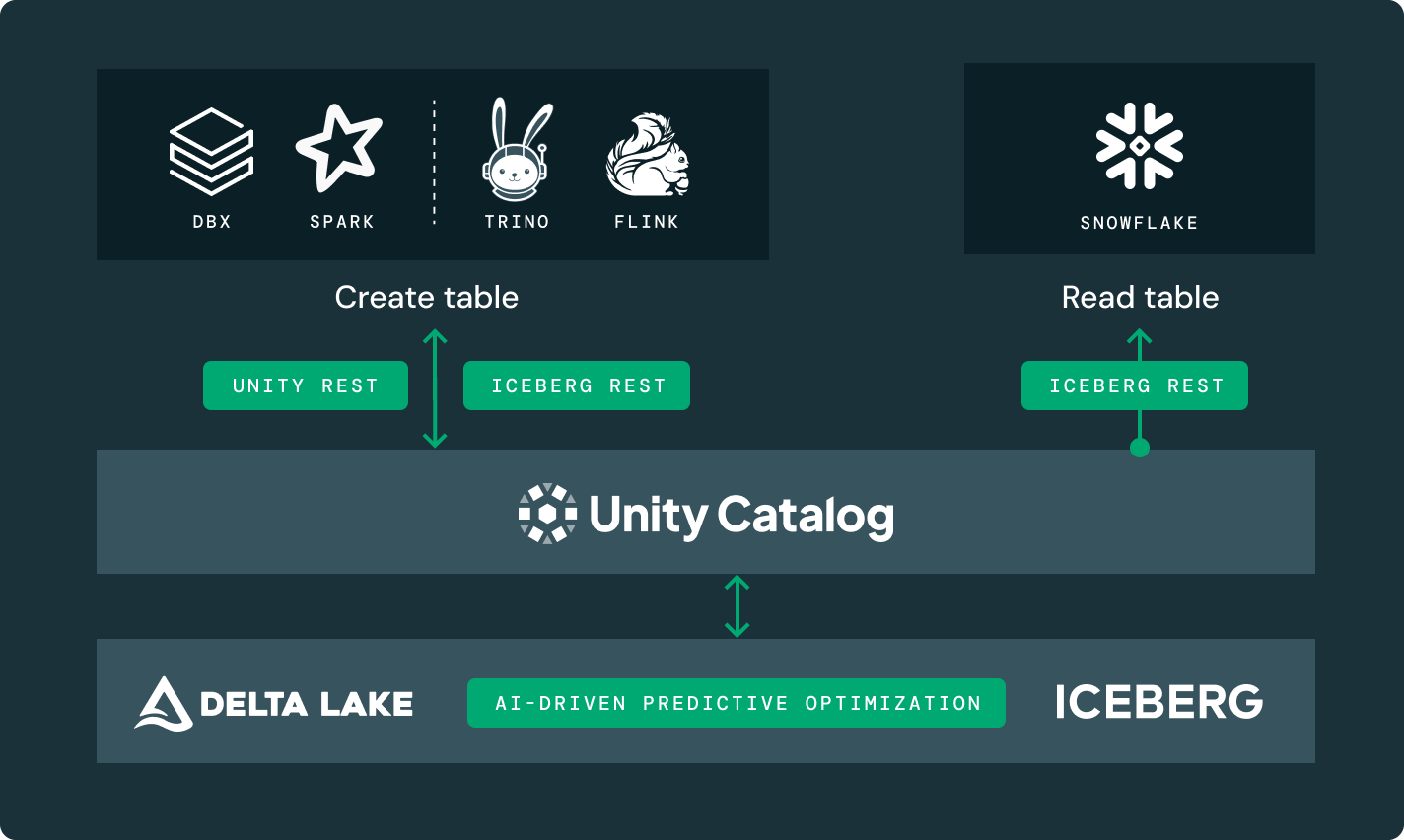

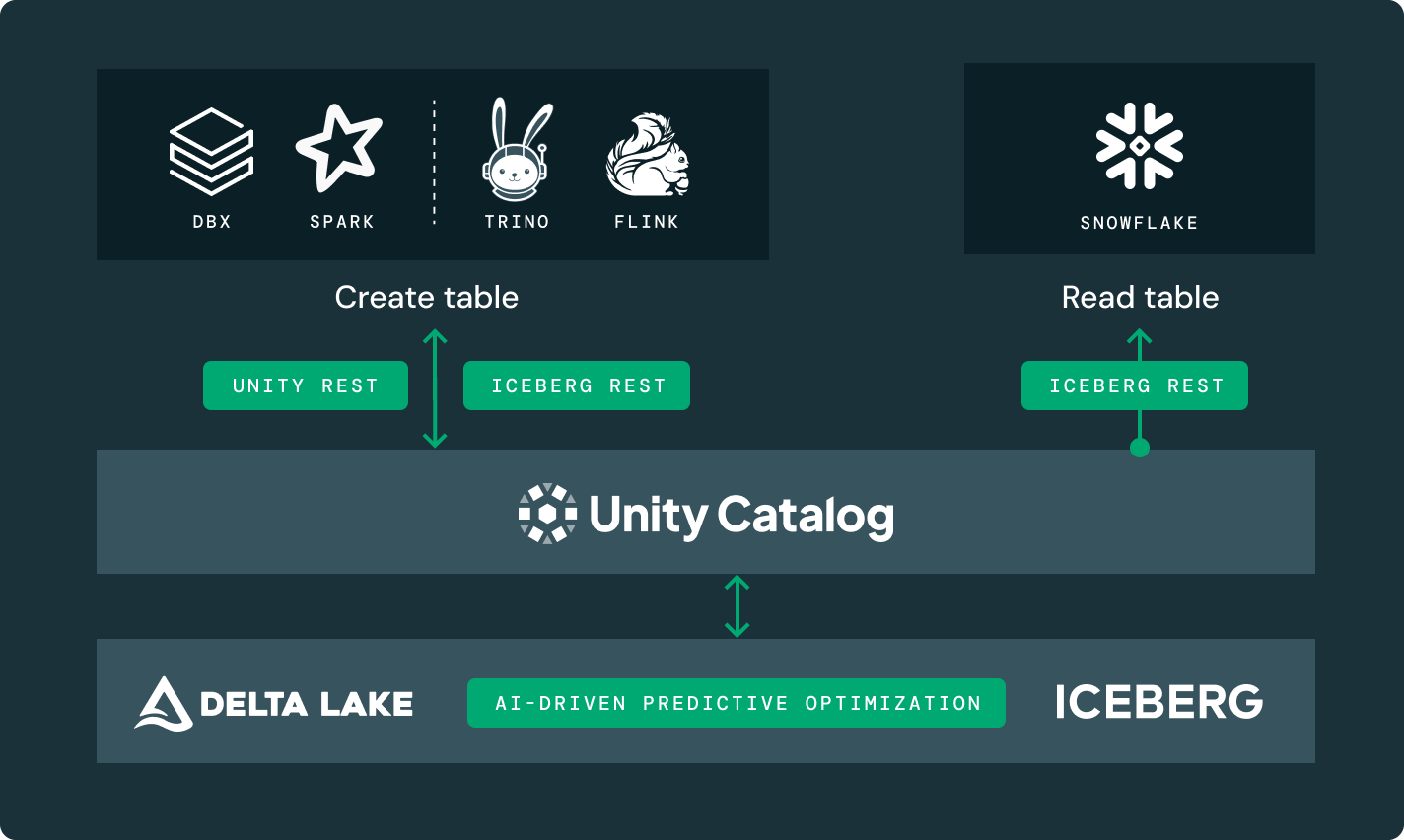

Erfahren Sie mehr darüber, wie die Databricks Data Intelligence Platform Ihre Datenteams bei all Ihren Daten- und KI-Workloads unterstützt.Unity Catalog

Die einzige einheitliche und offene Governance-Lösung der Branche für Daten und KI, integriert in die Databricks Data Intelligence Platform.

Delta-Freigabe

Der erste Open-Source-Ansatz zum Datenaustausch über Daten, Analytik und KI. Teilen Sie Live-Daten sicher über Plattformen, Clouds und Regionen hinweg.

Data Intelligence Platform

Entdecken Sie die gesamte Bandbreite der auf der Databricks Data Intelligence Platform verfügbaren Tools zur nahtlosen Integration von Daten und KI in Ihrem Unternehmen.

Mehr Informationen

FAQ zur Lakehouse-Speicherung

Möchten Sie ein Daten- und KI-Unternehmen werden?

Machen Sie die ersten Schritte Ihrer Transformation