IDE-Integrationen von Databricks

In Ihrer Lieblings-IDE im Lakehouse entwickeln

Einführung

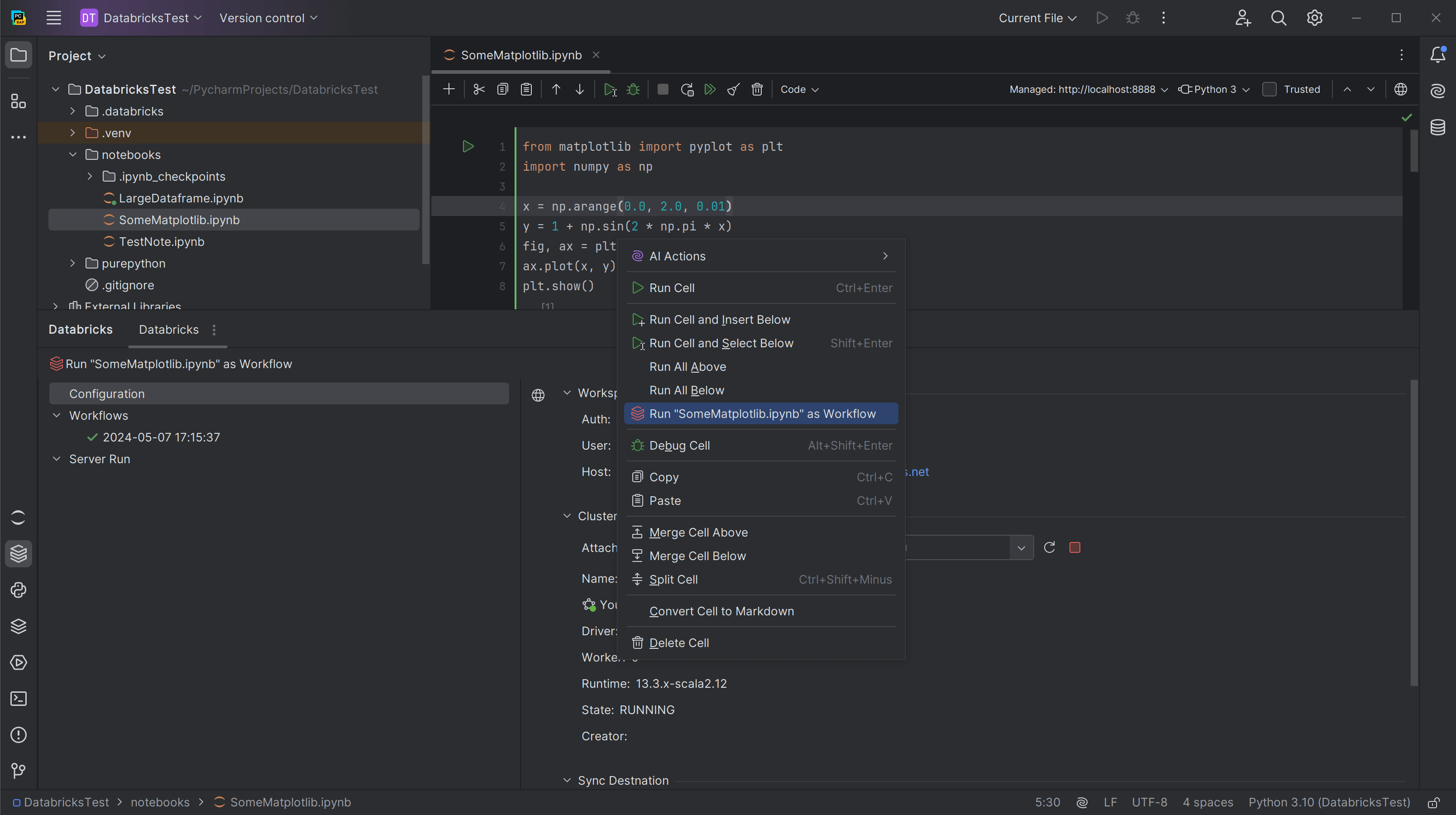

Databricks bietet Entwicklern und Teams, die IDEs bevorzugen und über bestehende Software-Engineering-Workflows verfügen, eine vollständige Entwicklungsumgebung an. Mit unseren offiziellen IDE-Integrationen werden alle zentralen Funktionen von Databricks in Ihrer IDE zugänglich: sichere Workspace-Anbindung, Cluster, Daten usw. Sie wurden speziell für IDE-Workflows entwickelt und bieten Unterstützung für Ihre bevorzugten Editorfunktionen, uneingeschränkten Zugriff auf Git-Tools, lokale Unit-Tests und Debugging von Code, der in Ihrem Cluster läuft.

Die gesamte Leistung von Databricks – in Ihrer IDE

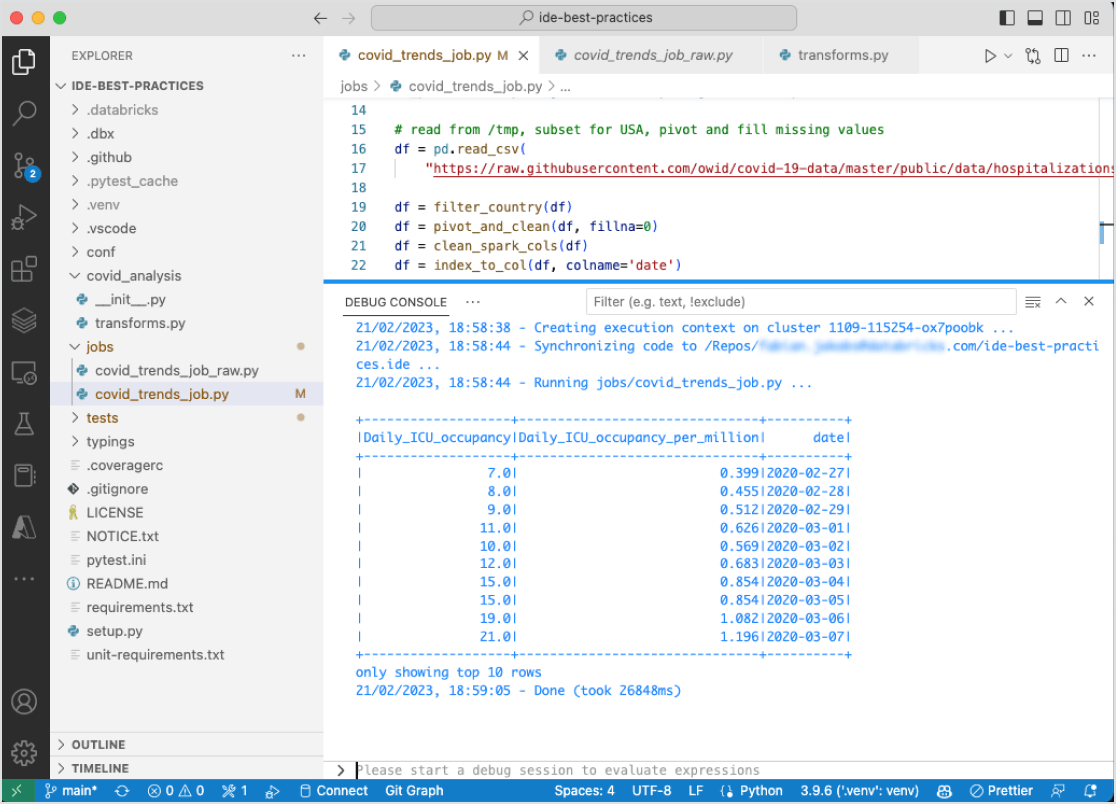

Nutzen Sie die Möglichkeiten von Databricks Lakehouse in Ihrer IDE. Sie können Ihre Daten- und KI-Anwendungen unterstützt von der Leistungsfähigkeit von Databricks erstellen. Stellen Sie eine Verbindung mit Ihren Workspaces her, um mit Ihrem Team zusammenzuarbeiten. Führen Sie Ihren Code auf Clustern aus, um umfassenden Zugriff zu erhalten und auch umfangreiche Datenanwendungen nutzen zu können. Schließlich können Sie auch bequem aus Ihrer IDE auf alle Ihre Daten im Lakehouse zugreifen.

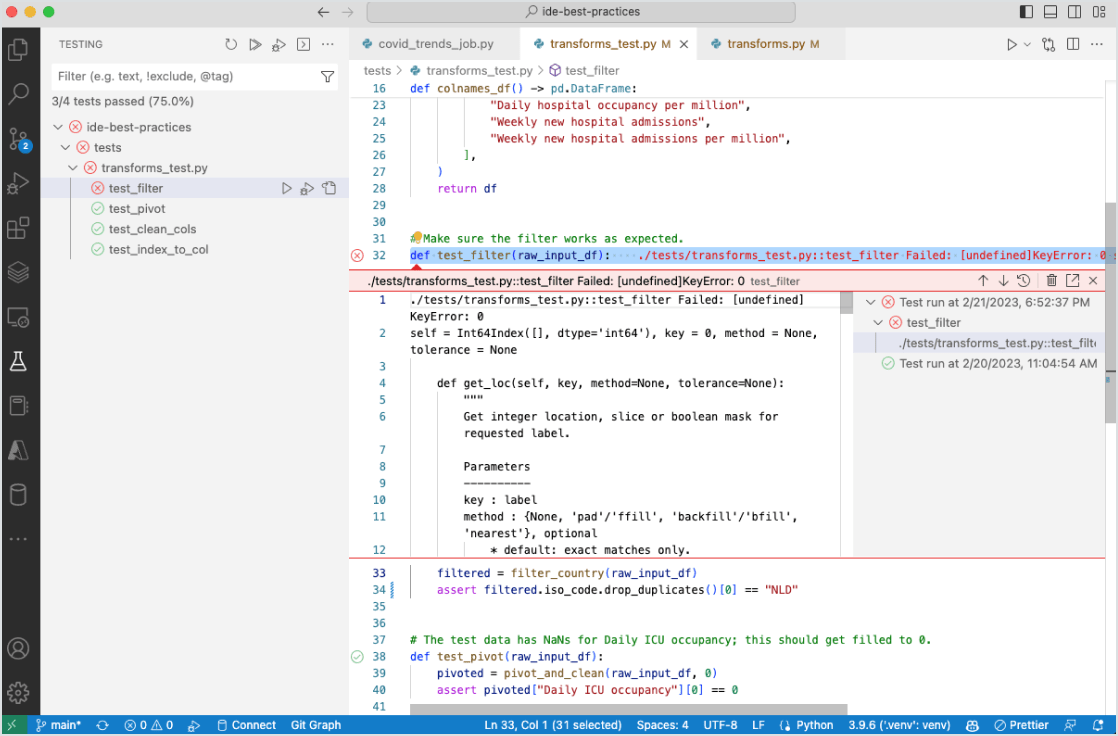

Einzigartige IDE-Funktionen nutzen

Die Databricks-Integrationen sind so aufgebaut, dass sie die Möglichkeiten von IDEs – z. B. Versionskontrolle, Unit-Tests und Debugging – nutzen können. Sie können alle vertrauten Aufgaben in Ihrer IDE erledigen – wie Refactoring, Codenavigation, Codeassistenten und mehr – und gleichzeitig mit lokalen Unit-Tests schnell iterieren.