Zu Databricks migrieren

Modernisieren Sie Ihre Datenplattform durch einen Umstieg auf die Databricks Data Intelligence Platform.

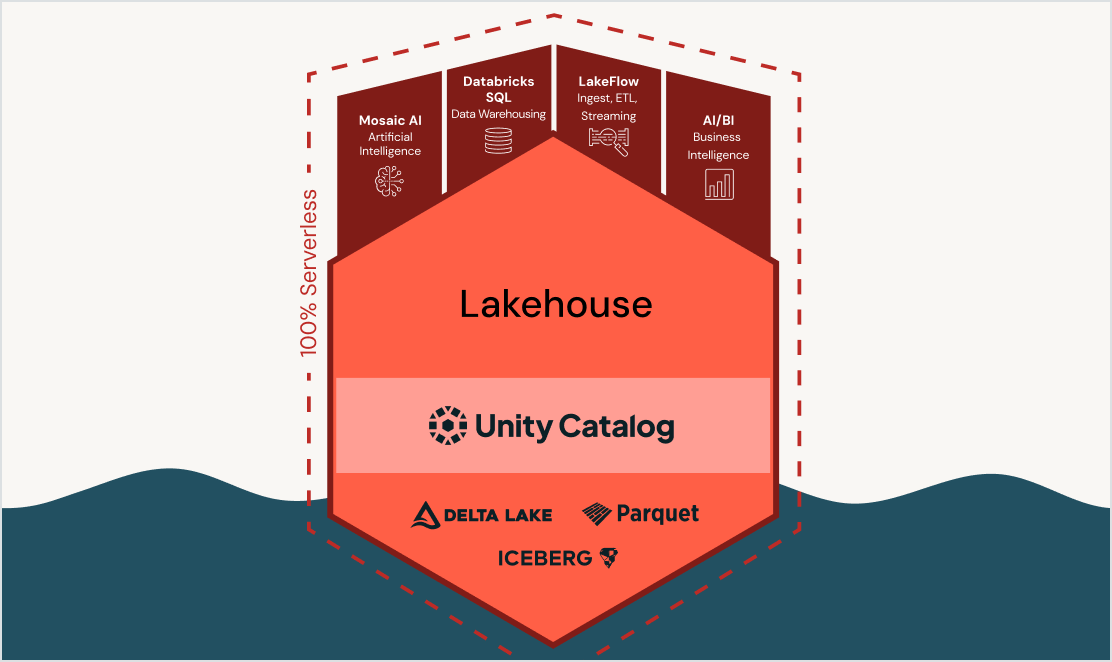

Durch eine Migration von Ihrem Enterprise Data Warehouse auf die Databricks Data Intelligence Platform können Sie Kosten senken, Innovation beschleunigen und Ihre Datenplattform vereinfachen. Sie können dann alle Daten-, Analytics- und KI-Workloads auf einer modernen, einheitlichen Plattform ausführen, die auf offenen Standards basiert und durch einen gemeinsamen Governance-Ansatz abgesichert ist.

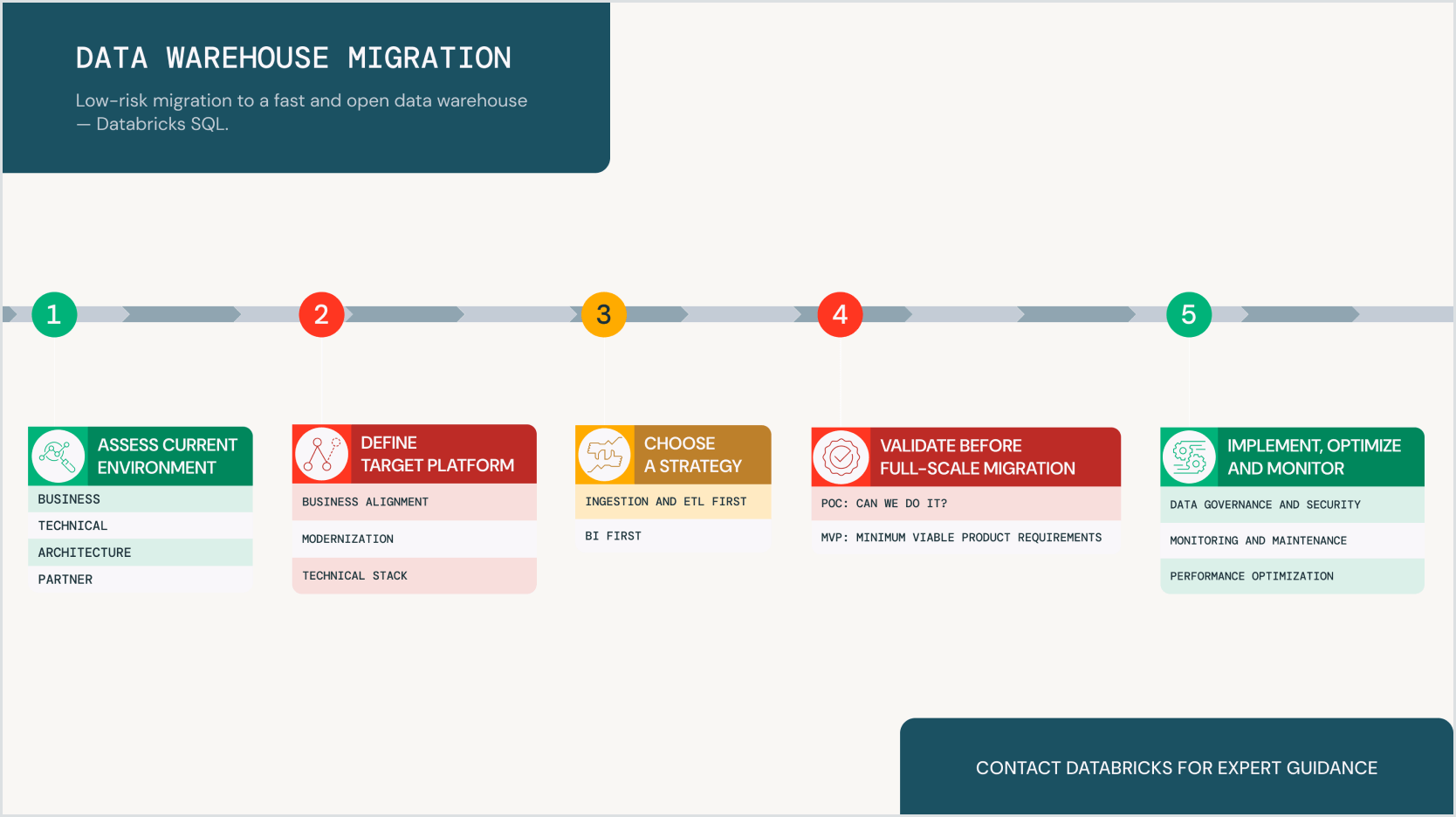

Risikoarme Migration zu einem schnellen und offenen Data Warehouse

Herkömmliche Data Warehouses sind teuer. Und deswegen wird es Zeit für etwas Neues.Tools und Accelerators von Databricks und unseren Partnern

Daten einfach erfassen oder zusammenführen

Erfassen Sie Ihre Daten mit Databricks LakeFlow Connect.

Führen Sie Ihre Datenquellen – wie SQL Server, Teradata und Oracle – über Lakehouse Federation in Databricks zusammen.

Bewährte Strategien für Skalierbarkeit, Kosteneffizienz und AI-Innovation

Die Migration zu einer modernen Plattform wie die Databricks Data Intelligence Platform bietet Ihnen elastische Skalierbarkeit, reduzierte Kosten, integrierte Sicherheit und die Möglichkeit, Open-Source-Technologien nahtlos zu integrieren – ganz ohne Vendor-Lock-in. Befolgen Sie diese bewährte Migrationsstrategie und erfahren Sie:

- Warum die Modernisierung Ihres Data Warehouses entscheidend für Skalierbarkeit, Kosteneinsparungen und fortgeschrittene Analysen ist

- Welche strukturierte Migrationsstrategie Databricks für einen reibungslosen Übergang ermöglicht

- Wie Sie Risiken dank Proof of Concepts (POCs), MVPs und Databricks-nativen Tools minimieren

Migration beschleunigen, um Daten und KI-gestützte Ergebnisse schneller liefern zu können

Gesamtbetriebskosten senken und Betriebseffizienz steigern

Der Aufbau von ETL-Pipelines oder die Implementierung von maschinellem Lernen auf Snowflake erfordert die Nutzung und Verwaltung zusätzlicher Tools. Mit der Zeit wird Ihre Architektur so immer kostspieliger und komplexer. Mit der Databricks Data Intelligence Platform erhalten Sie dagegen eine leistungsstarke und wirtschaftliche ETL-Lösung mit nativer KI-Unterstützung.

Daten- und KI-Journey planen und umsetzen

Projekte schneller erfolgreich abschließen – dank erstklassigem Fachwissen in den Bereichen Data Engineering, Data Science und Projektmanagement.

Die Experten für die Databricks Data Intelligence Platform vom Databricks Professional Services Migration Team liefern Ihnen dank eines präskriptiven Ansatzes handfeste Ergebnisse. Die Vorgehensweise steigert den Wert Ihrer vorhandenen Daten- und Pipeline-Investitionen und gewährleistet eine nahtlose Migration. Darüber hinaus stellt Ihnen das Team Best Practices zur Verfügung, mit denen Sie Risiken und Kosten reduzieren können. Die Fachexperten von Databricks können gemeinsam mit Ihrem Team oder den von Ihnen ausgewählten SI-Partnern Architektur-, Planungs-, Design- und Implementierungsservices erbringen, um den Erfolg sicherzustellen.

Kundenberichte

Migrationstools

Umfassende Data-Warehouse-Migrationen zu Databricks

Vereinfachen und beschleunigen Sie die Migration von Data Warehouses zu Databricks SQL – Legacy-Quellsystemen wie Oracle, Teradata, Snowflake, Amazon Redshift, Microsoft SQL Server und vielen weiteren. Auch Ihre bestehenden ETL-Codes lassen sich migrieren. Databricks verfügt über ein kostenloses Migrationswerkzeug, Lakebridge.