Databricks Connect “v2” でどこからでも Databricks を使用しよう

公開日: April 18, 2023

によって ステファニア・レオーネ、マーティン・グルンド、ウラディスラフ・マンティック=ルーゴ、Niranjan Jayakar による投稿

Original Blog : Use Databricks from anywhere with Databricks Connect “v2”

翻訳: junichi.maruyama

この度、Databricks Connect "v2 "のパブリックプレビューを発表することができ、開発者はどこでも動作するアプリケーションからDatabricksのパワーを利用できるようになりました。

これまで、SQL以外の言語からDatabricksにリモートで接続する方法はありませんでした。Databricks Connect libraryをアプリケーションに組み込み、Databricks Lakehouseに接続するだけです!

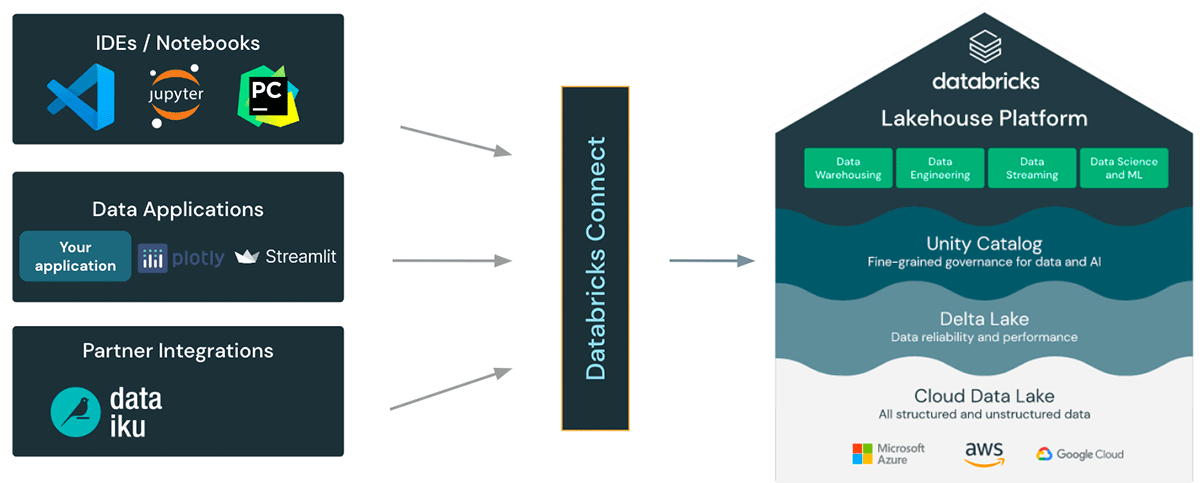

Databricks Connectは、データ実務家にとっていくつかの新しい機能とユースケースを解放します: 開発者は、選択した IDE を使用して、Databricks のワークスペースでインタラクティブにコードを開発およびデバッグすることができます。パートナーはDatabricksと簡単に統合し、Databricks Lakehouseの全機能を使用することができます。そして、誰でも数行のコードでDatabricksの上にアプリケーションを構築することができます!

オープンソースのSpark Connectをベースに構築

DBR 13以降、Databricks ConnectはオープンソースのSpark Connect上に構築されるようになりました。Spark Connectは、DataFrame APIと未解決の論理計画をプロトコルとして使用してSparkクラスタへのリモート接続を可能にするApache Spark™用の非連結クライアント・サーバアーキテクチャを導入しています。Spark Connectをベースとしたこの「v2」アーキテクチャにより、Databricks Connectはシンプルで使いやすいシンクライアントになります!IDE、ノートブック、あらゆるアプリケーションなど、Databricksに接続するためのあらゆる場所に組み込むことができ、顧客やパートナーは、あなたのDatabricks Lakehouseをベースにした新しい(インタラクティブな)ユーザー体験を構築することができます!

Databricksで数行のコードでインタラクティブなデータアプリを作る

JDBCドライバのように、Databricks Connect libraryはあらゆるアプリケーションに組み込んでDatabricksと対話することができます。

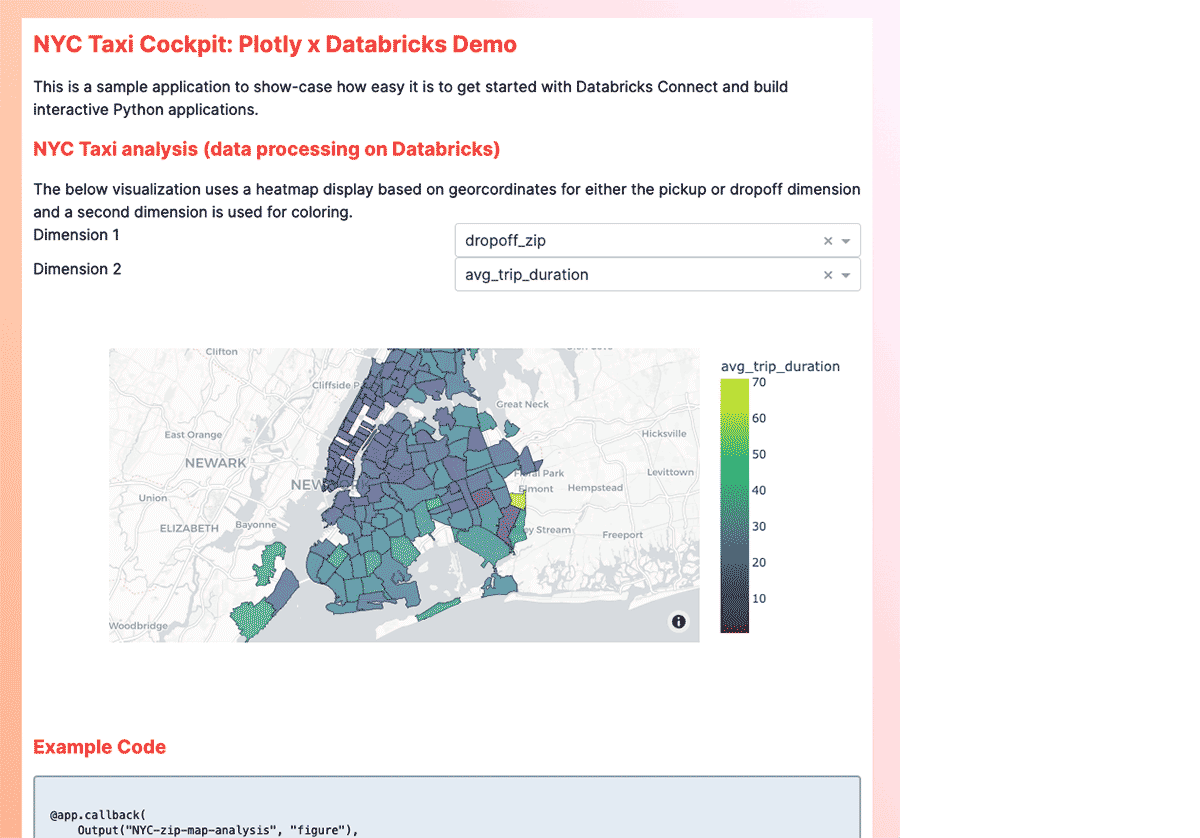

例えば、PlotlyやStreamlitなどのフレームワークをベースにしたインタラクティブなデータアプリケーションを、わずか数行のコードで構築することができます。私たちは、Databricks NYC Taxiデータセット(github project)に基づいて、ニューヨークのタクシー旅行をインタラクティブにクエリして視覚化するデータアプリケーションの例を構築しました。

DatabricksからNYCのトリップデータを取得し、Dash appで可視化するためのコードスニペットを紹介します。

あらゆるIDEからインタラクティブに開��発・デバッグが可能

IDEは、ソースコード管理、モジュール式コードレイアウト、リファクタリングサポート、統合ユニットテストなど、大規模なコードベースに対するソフトウェアエンジニアリングのベストプラクティスを開発者が使用できるようにします。Databricks Connectを使用すると、開発者はIDEのネイティブな実行およびデバッグ機能を使用して、Databricksクラスタ上でインタラクティブにコードを開発およびデバッグすることができ、コードがより効率的に、より高品質で開発されることを確認できます。

"Databricks Connect "v2 "は、シェルのデータエンジニアとデータサイエンティストがDatabricks環境およびUnityカタログとやりとりする方法を簡素化し、改善するものです。ユーザーが好む統合開発環境(IDE)でのSparkコードの開発をスピードアップし、コードの各行をステップスルーすることで、より速く簡単にデバッグすることが可能になります。DB Connect "v2 "はインストールが簡単なため、AIワークロードの一部をDatabricksにオフロードする必要があるエッジデバイスや、ビジネスユーザーの日常ツールにDatabricksの拡張性を組み込むなど、どこからでもSparkを利用できるようになる可能性がさらに高まります。" - シェル社チーフデジタルテクノロジーアドバイザー Bryce Bartmann氏

新しいDatabricks VS Code Extensionは、Databricks Connectを使用して、Databricks上のユーザーコードの組み込みデバッグを提供します。Databricks Connectは、他のIDEからも使用することができます。開発者は 'databricks-connect>=13.0' を pip install して、Databricks クラスタへの接続文字列を設定するだけです!

Databricks Connectでパートナーとの統合を容易に

パートナー企業は、Databricks Connect libraryを自社製品に簡単に組み込むことができ、Databricks Lakehouseとの深い統合や新しい体験を構築できます。

例えば、パートナーであるDataiku(SQLとPythonを使用してワークフローを視覚的に定義しスクリプト化するローコードプラットフォーム)は、Databricks Connectを使用してDatabricks Lakehouse上でPySparkレシピを直接実行します。

"DataikuとDatabricksの統合は、ビジネスユーザーとテクニカルユーザーの両方にとって、使いやすいアナリティクスとAIのソリューションを提供します。Databricks Connect "v2 "の発売により、当社のお客様はDatabricksを使用して、Dataikuで構築したビジュアルとコードベースの両方のワークフローを実行し、AIによる価値実現までの時間を加速させることができるようになりました。" - ポール=アンリ・ヒンセラン(フィールドエンジニアリング担当副社長

Databricks Connectを今すぐ始める!

Databricks Connectクライアントライブラリは、本日よりダウンロード可能です。DBR 13クラスタに接続し、開始します!

AWSと Azure向けのDatabricks Connectのドキュメントをご覧いただき、お気に入りのIDEからコードをデバッグしたり、インタラクティブなデータアプリを構築したりして、試してみてください!また、Databricks CommunityでDatabricks Connectに関するフィードバックをお待ちしています。

ScalaやStreamingのサポートなど、Databricks Connectのさらなるアップデートや改良にご期待ください!