トップチームはデータインテリジェンスで成功を収めますフレキシブルで高速なLakehouseストレージ

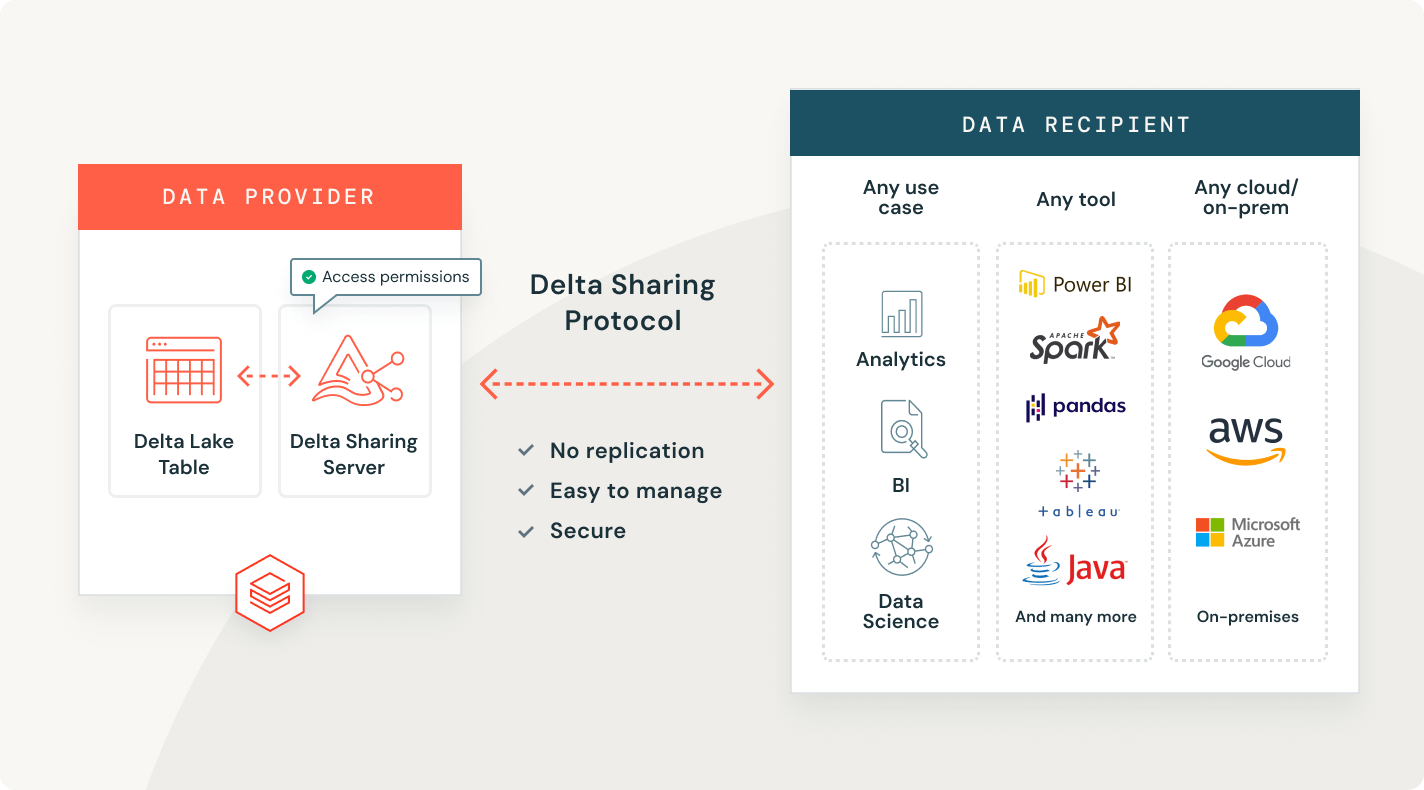

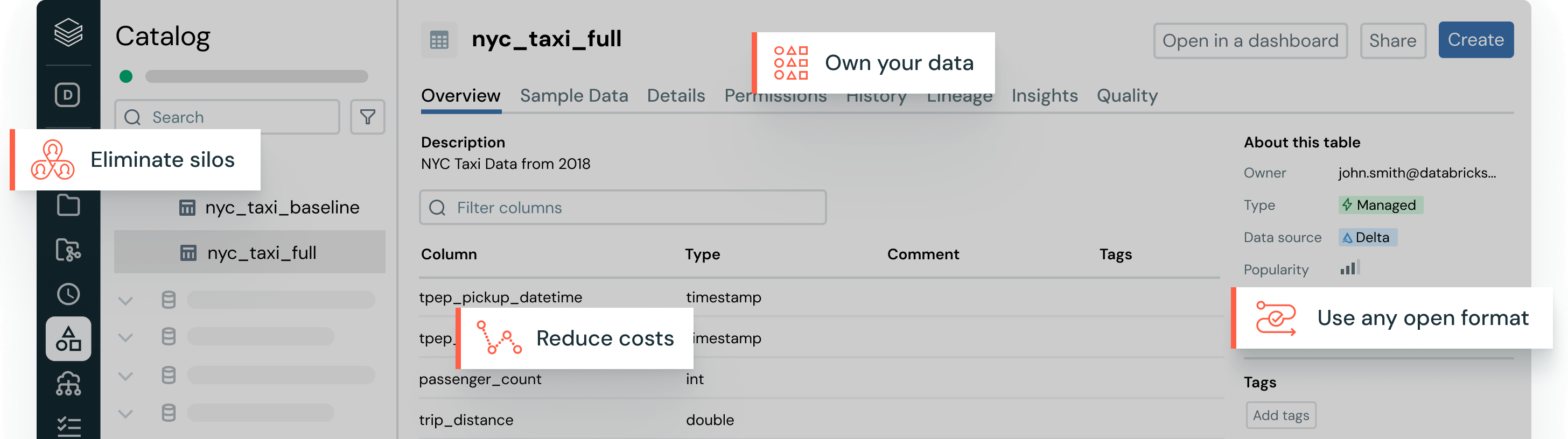

オープンテーブル形式、集中化されたガバナンス、自動データ最適化により、データ管理の頭痛の種を解消します。あなたのデータ、あなたの方法

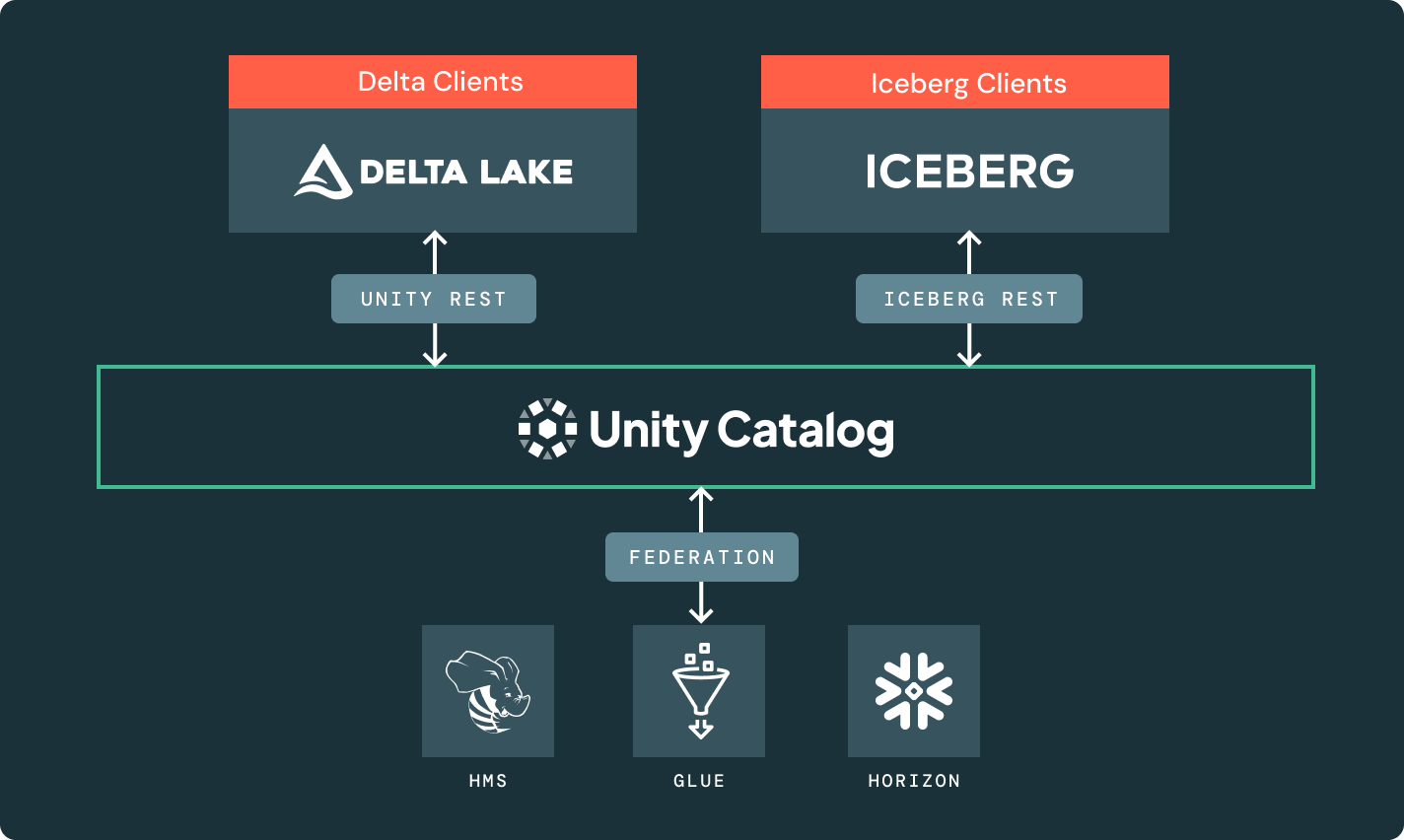

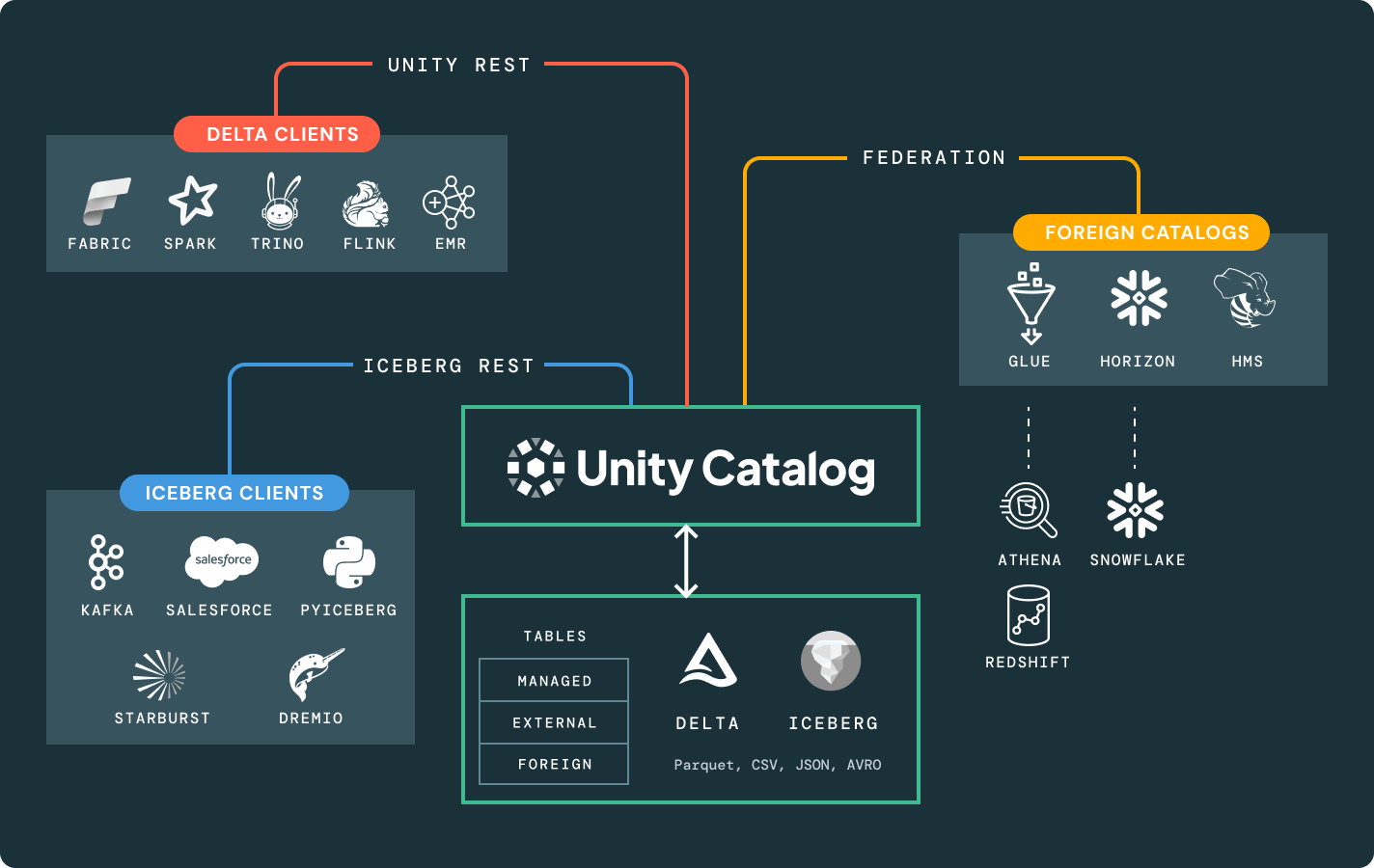

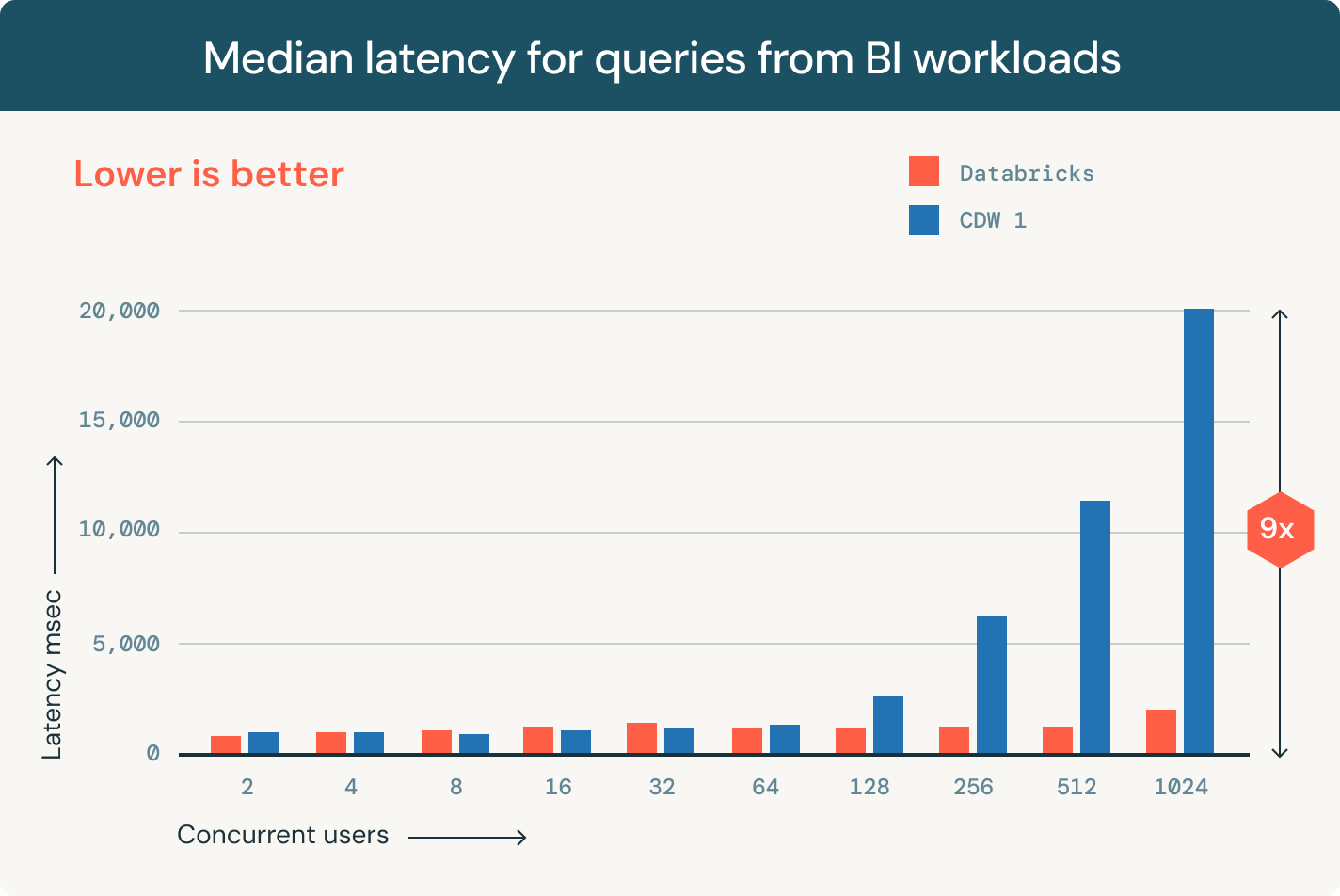

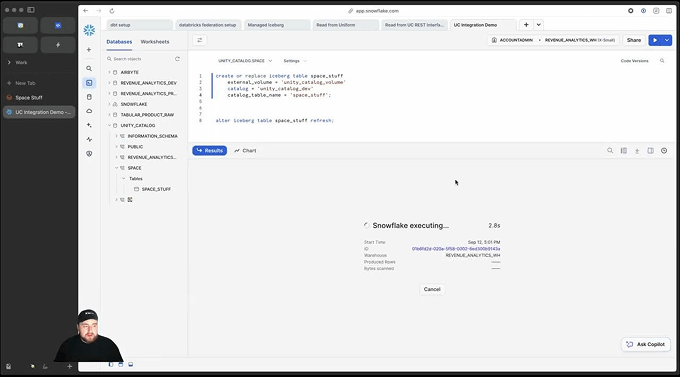

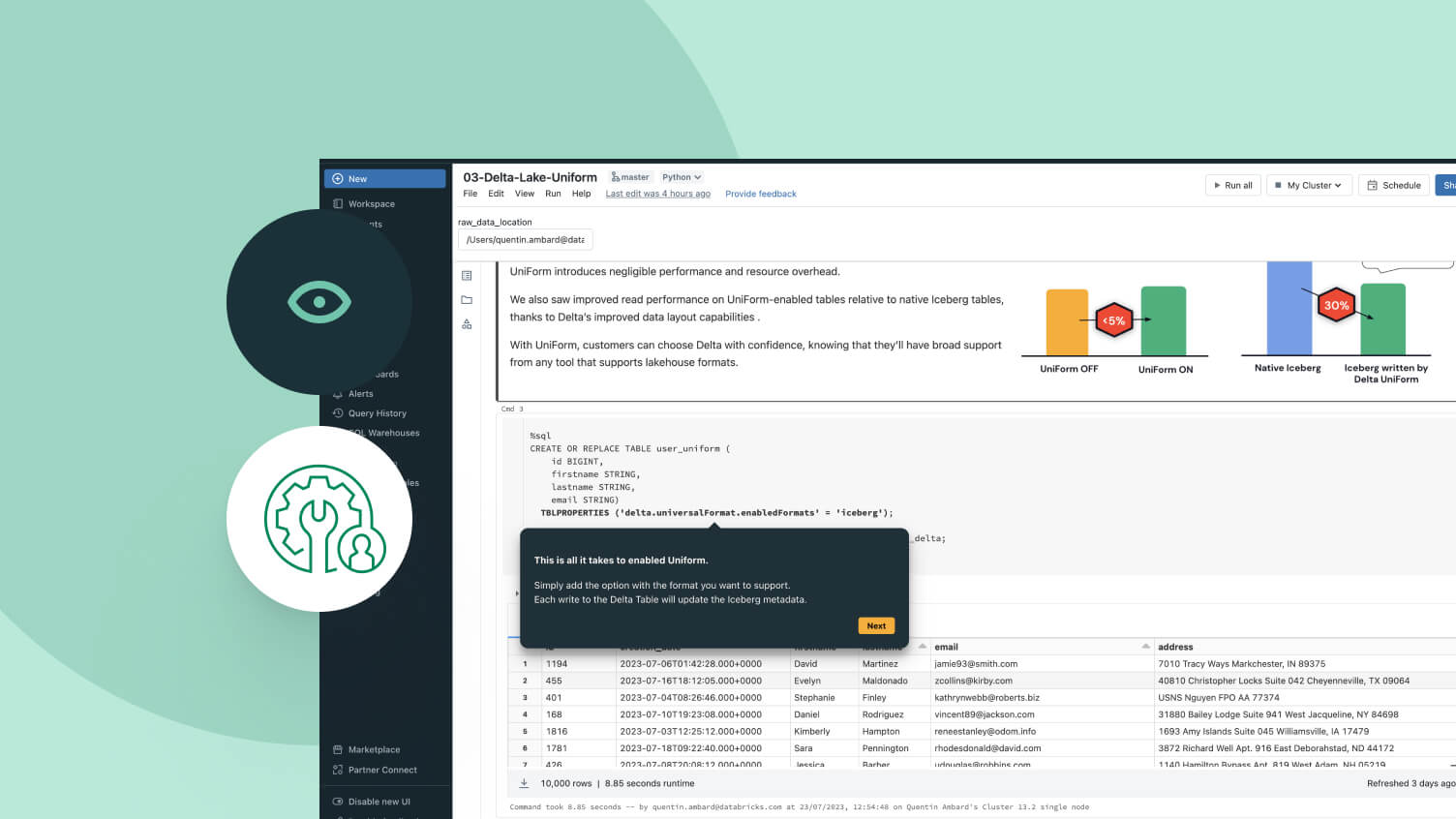

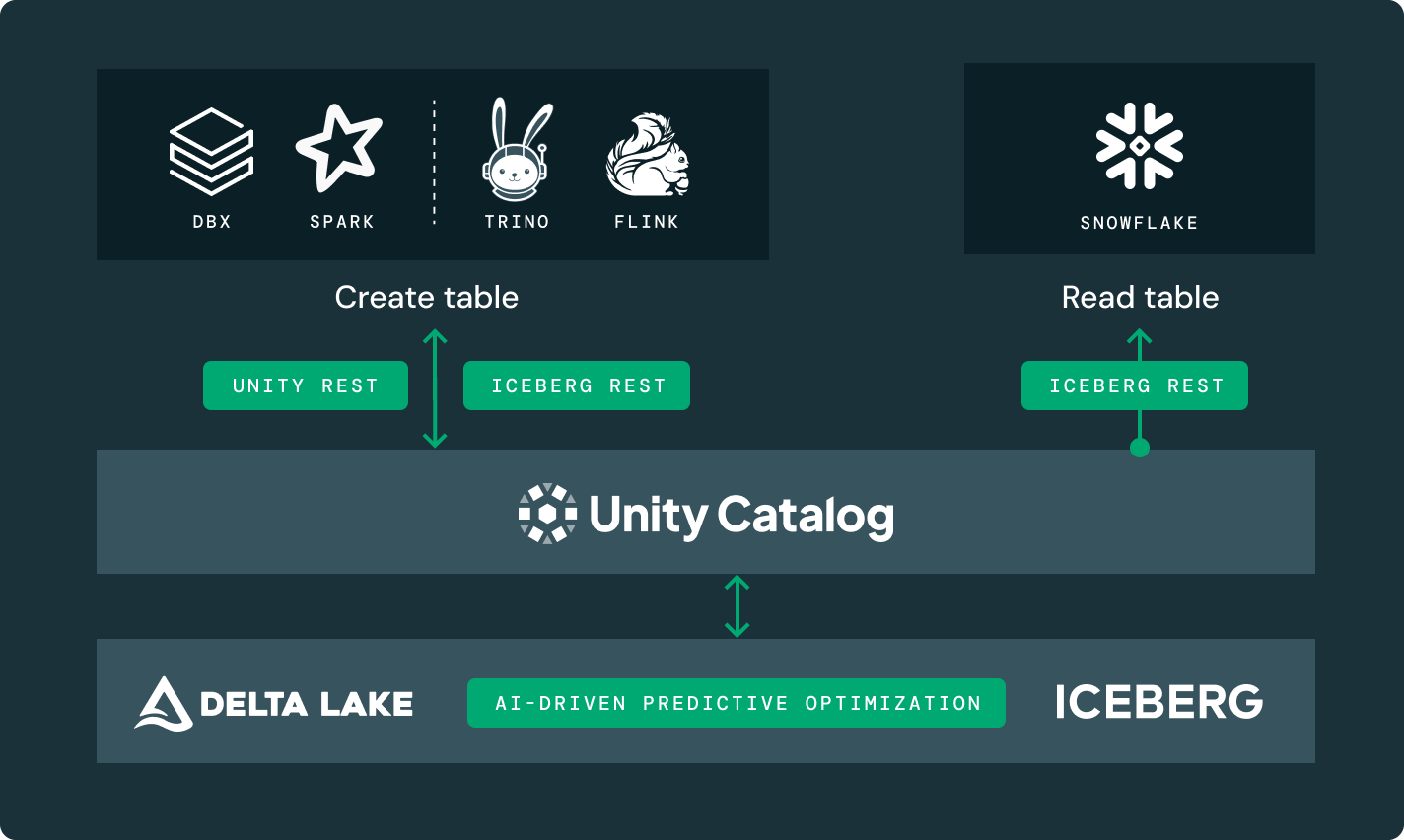

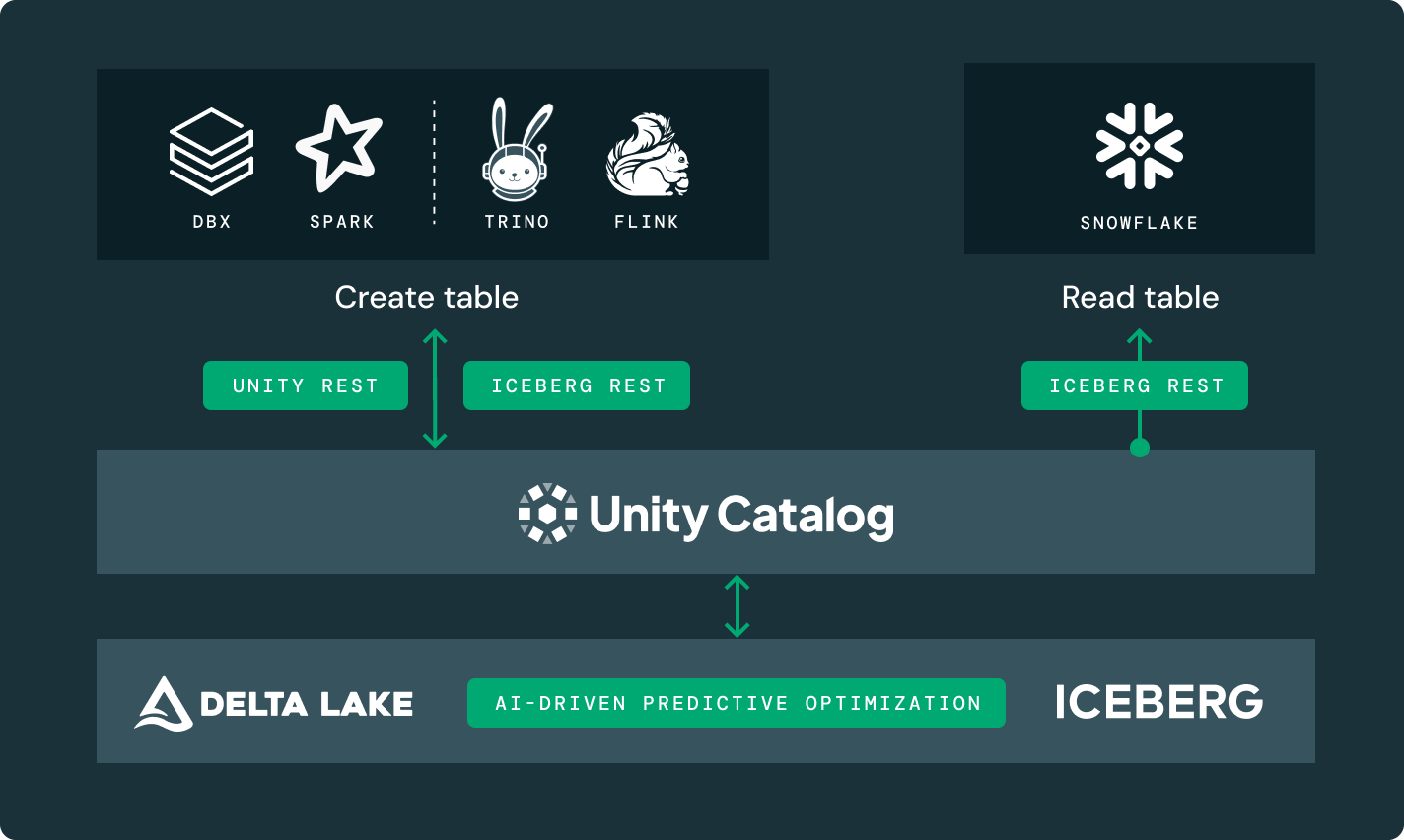

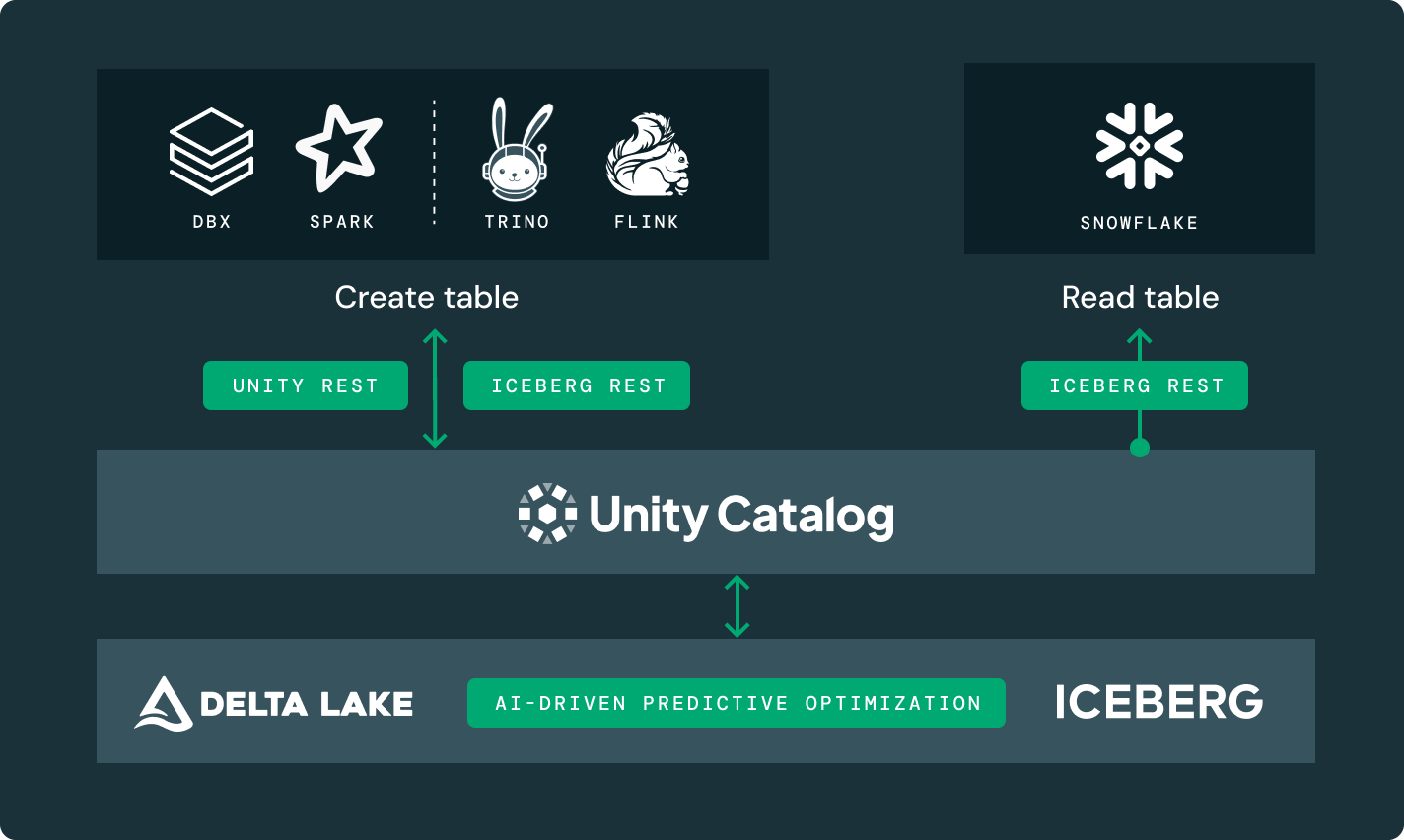

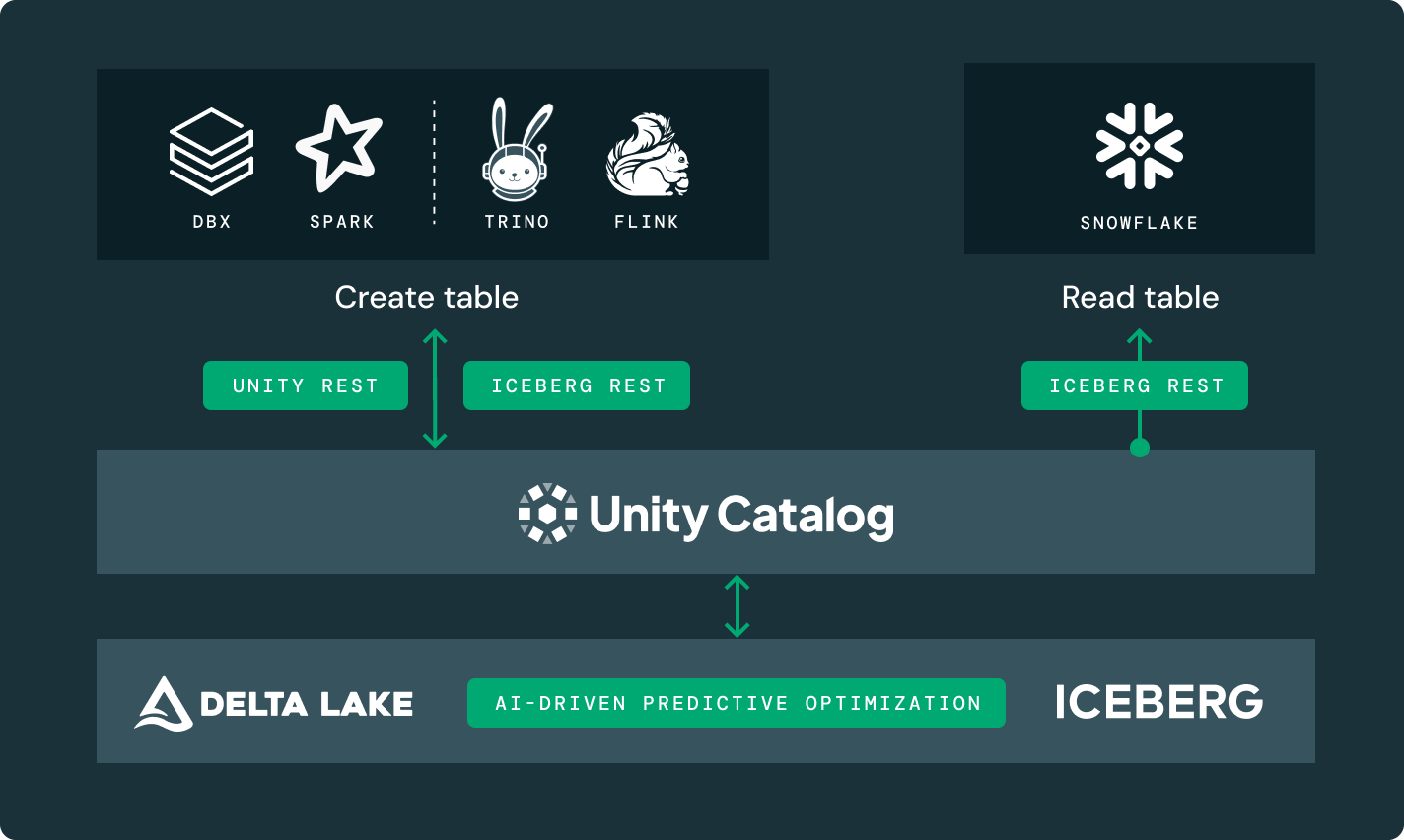

あなたに適したストレージの場所とオープンフォーマットを選択してください。ベ��ンダーロックインなしで、データをポータブルに保つ。Delta LakeとApache Iceberg™テーブルのための最高クラスの読み書き性能を、他のどのレイクハウスでも利用できないストレージ最適化と共に、箱から出してすぐに提供します。

その他の機能

あなたのすべての分析とAIのワークロードに対して

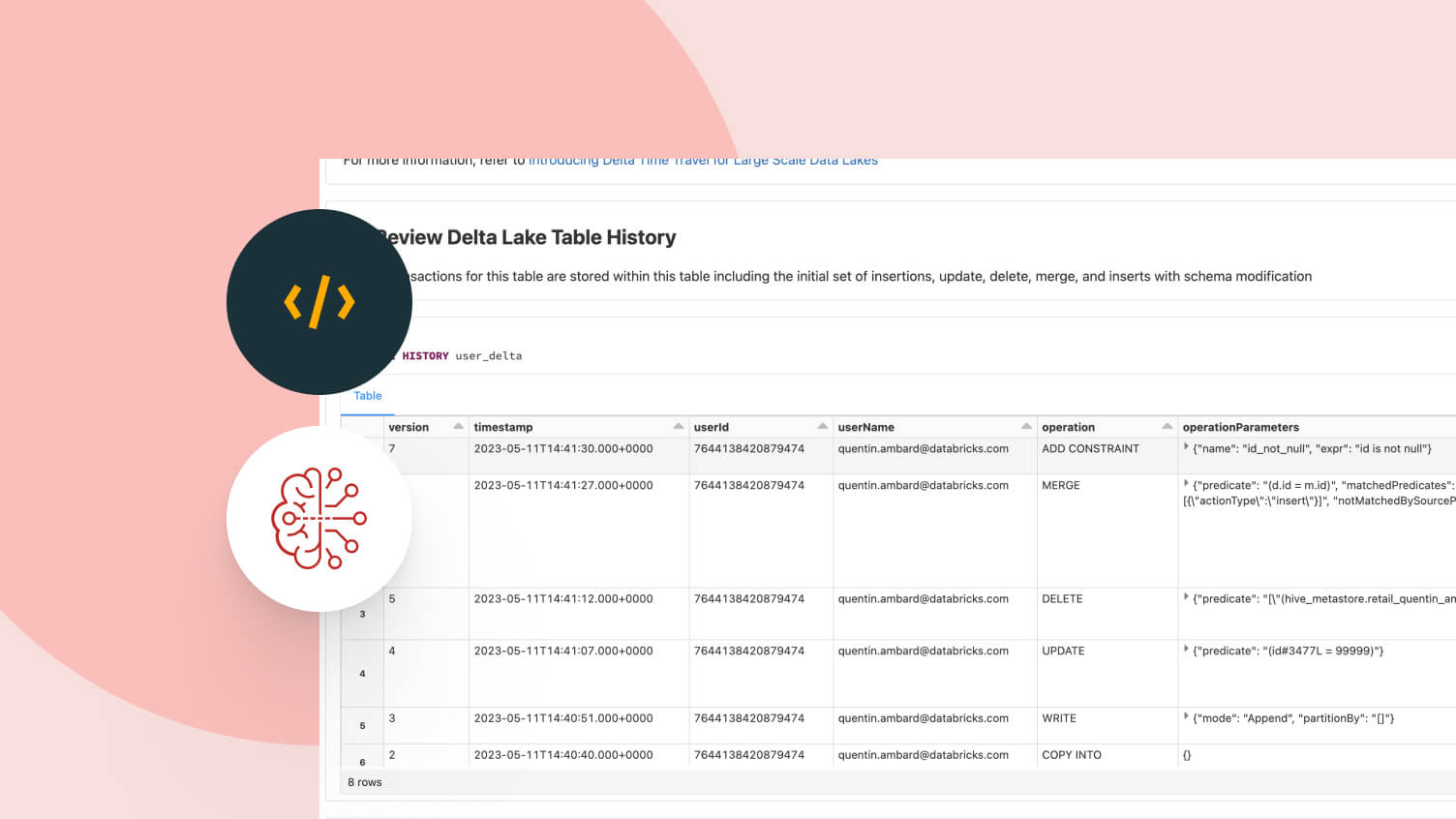

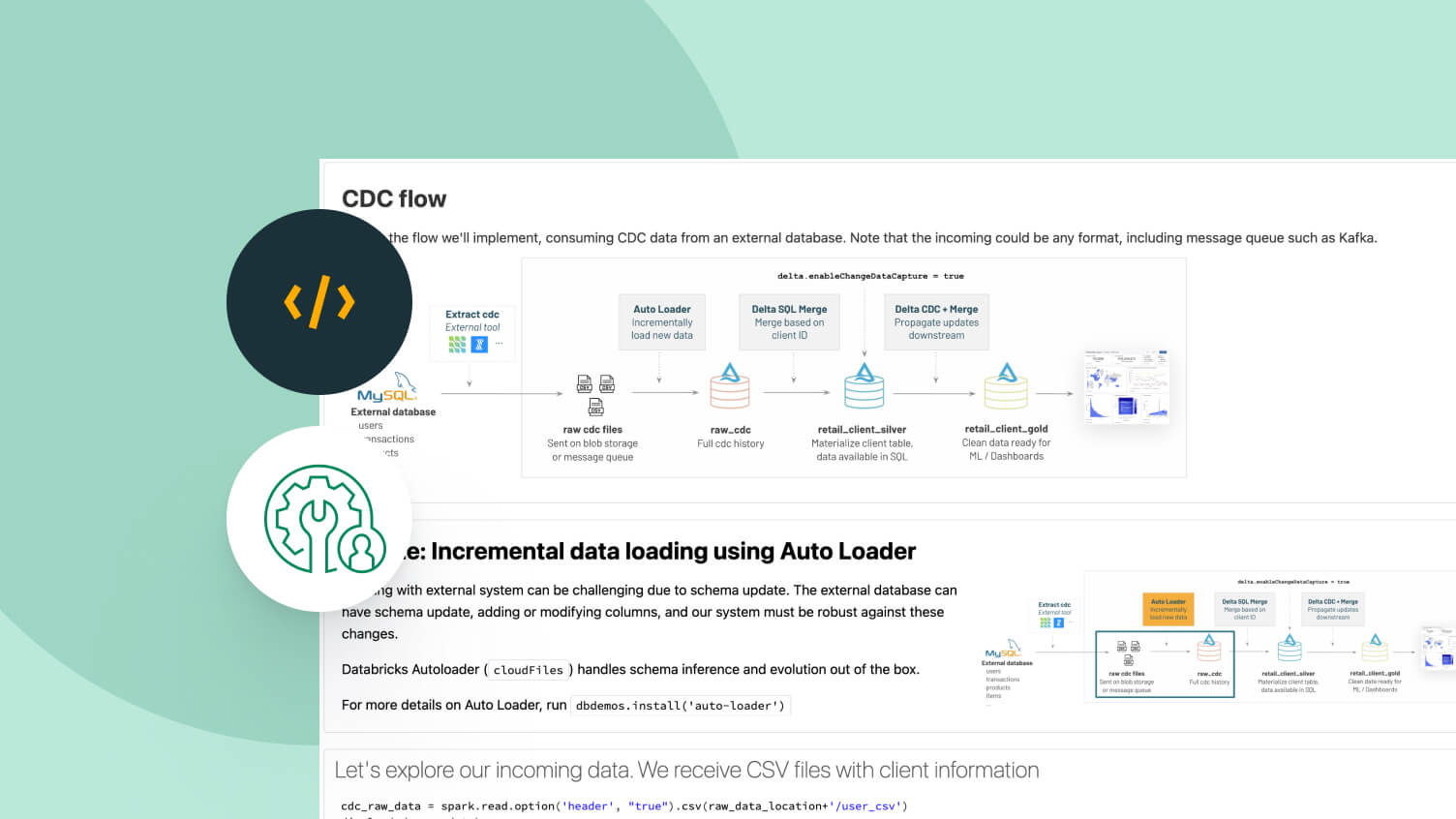

信頼性の高いデータパイプラインを構築し、管理する

管理テーブルは、バッチテーブルとストリーミングソースおよびシンクの両方として機能します。ストリーミングデータの取り込み、バッチ履歴バックフィル、対話型クエリは全てすぐに動作し、Spark の構造化ストリーミングと直接統合されます。