ビッグデータ分析とは何ですか?

IoTデバイス、ソーシャルメディア、eコマースからの膨大で多様なデータセットを調査して、隠れたパターン、相関関係、実用的な洞察を発見します。

Summary

- 機械学習、自然言語処理、ディープラーニングなどの高度な技術を用いて、テラバイトからゼタバイトまでの構造化データ、半��構造化データ、非構造化データを分析します。

- Hadoop、Spark、Hiveなどの分散フレームワークを活用し、ネットワーク全体のデータ処理を実現することで、従来のETLの限界や低速なバッチ処理を克服します。

- クラウドコンピューティングによるコスト削減、インメモリ分析によるリアルタイムの意思決定、新製品、市場動向、顧客の嗜好の特定を支援します。

データ分析とビッグデータ分析の違い

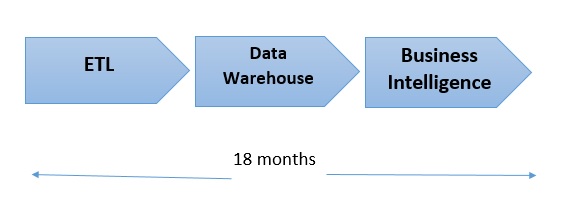

Hadoop が開発される以前は、最新のストレージと計算システムの基盤となる技術には限りがあり、企業での分析はスモールデータに制限されていました。しかし、このような比較的簡易な形式でも、特に新しいデータソースの統合においては、分析が困難なケースが生じていました。従来のデータ分析は構造化データのテーブルで構成されたリレーショナルデータベース(SQL データベースなど)の使用に依存しています。データを分析用のデータベースに取り込む前に、未加工データの各バイトを特定の方法でフォーマットする必要があります。フォーマットとは一般的に ETL(抽出、変換、ロード)として知られるプロセスの実行ですが、この 3 段階ある ETL プロセスの最大の問題点は、膨大な時間と新規データソースごとの処理などの労力を費やさなければならないことです。データサイエンティストやデータエンジニアによる実行または変更に最長 18か月を要することもあります。 ETL が完了し、データがいったんデータベースに取り込まれた後は、ほとんどの場合、データアナリストは簡単にそのデータの照会や分析ができました。しかし、その後、インターネット、eコマース、ソーシャルメディア、モバイルデバイス、マーケティングオートメーション、モノのインターネット(IoT)デバイスなどの登場により、未加工データのサイズ、量、複雑さが増大し、ほとんどの企業では通常業務の中でデータ分析が困難になりました。

ETL が完了し、データがいったんデータベースに取り込まれた後は、ほとんどの場合、データアナリストは簡単にそのデータの照会や分析ができました。しかし、その後、インターネット、eコマース、ソーシャルメディア、モバイルデバイス、マーケティングオートメーション、モノのインターネット(IoT)デバイスなどの登場により、未加工データのサイズ、量、複雑さが増大し、ほとんどの企業では通常業務の中でデータ分析が困難になりました。

ビッグデータ分析とは

ビッグデータ分析とは、 eコマース、モバイルデバイス、ソーシャルメディア、IoT などのさまざまなソースから生成された大規模で多様なデータセット、ビッグデータを検証することで、一般的に複雑なプロセスです。ビッグデータ分析とは、さまざまなデータソースの統合、非構造化データの構造化データへの変換、ネットワーク全体にデータ処理を分散処理基盤を使って知見を生成するアナティクスであり、機械学習などのデータサイエンス手法も含みます。デジタルデータの量は急増しており、2 年ごとに倍増しています。ビッグデータ分析とは、この増大するデータソースを管理・分析するために異なる手法を採用したソリューションです。従来のデータ分析の原則は今でも一般的に適用されますが、大規模で複雑なビッグデータ分析には、ペタバイト規模の構造化・非構造化データの保存および処理を可能にする新たな手法の開発が必要でした。高速化と大容量ストレージの必要性は��、技術的な空白を生み出しましたが、データウェアハウス、データレイク、 NoSQL のような非リレーショナルデータベースなどの新しいストレージ方法や、オープンソースの Apache Hadoop、Spark、Hive のようなデータ処理、データ管理技術およびフレームワークによってすぐに解決されました。ビッグデータ分析では、高度な分析技術を活用し、さまざまなソースからの構造化、半構造化、非構造化データ、テラバイトやゼタバイト級のサイズの膨大なビッグデータセットを分析します。

ビッグデータ分析における主なデータタイプ

- Webデータ:顧客レベルのWeb行動データ(訪問、ページビュー、検索、購買など)

- テキストデータ:最大かつ広範囲に使用されている非構造化データタイプで、電子メール、ニュース記事、Facebookのニュースフィード、Wordドキュメントなどのテキストソースから生成されるデータ

- 時間および位置情報、地理空間データ:GPS、携帯電話、Wi-Fi接続により、時間や位置情報は興味深いデータのソースとして増加しています。これには、地理情報システムから生成された道路、建物、住所、人物、職場、輸送ルートに関連する地理データなどが含まれます。

- リアルタイムメディア:リアルタイムデータソースには、リアルタイムストリーミングデータやイベントベースデータが含まれます。

- スマートグリッドとセンサデータ:自動車、原油パイプライン、風力タービンなどのセンサデータは、高頻度で収集されます。

- ソーシャルネットワークデータ:Facebook、LinkedIn、Instagramなどのソーシャルネットワーキングサイトからの非構造化テキスト(コメント、いいね、など)で、急増しているデータタイプです。リンク分析により、特定ユーザーのネットワークを探し出すことも可能です。

- リンクトデータ:このタイプのデータは、HTTP、RDF、SPARQL、URLなどの標準的なWebテクノロジを使用して収集されています。

- ネットワークデータ:FacebookやTwitterなどの巨大ソーシャルネットワークや、インターネット、電話網、輸送網などの技術ネットワークに関連するデータです。

ビッグデータ分析は、企業がデータを活用し、自然言語処理、深層学習、機械学習などの高度なデータサイエンス技術や手法を使用して、隠れたパターン、未知の相関関係、市場動向、消費者嗜好を明らかにし、新たな機会を特定し、アナティクスにより、隠れたパターンや相関を明らかにし、より情報に基づく意思決定を支援します。

ガートナー®: Databricks、クラウ��ドデータベースのリーダー

ビッグデータ分析のメリット

- コスト削減:アマゾンウェブサービス(AWS)、Microsoft Azure、Apache Hadoop、Spark、Hiveなどのクラウドコンピューティングやストレージ技術により、大規模なデータセットの保存や処理にかかるコストを削減し企業を支援します。

- 意思決定の改善:Sparkの高速性とインメモリ分析で、新しいデータソースを迅速に分析する機能を組み合わせることで、企業はリアルタイムでの意思決定に必要な即時性のある実用的な洞察を生成できます。

- 新製品とサービス開発の促進:ビッグデータ分析のツールの活用により、企業は顧客ニーズの分析精度を高め、顧客が求める製品やサービスを提供しやすくなります。

- 不正検出:ビッグデータ分析は、すでに金融サービス業界で不正防止に活用されていますが、あらゆる業種でもその重要性と利活用度が高まっています。

FAQ

1. データ分析とビッグデータ分析の違いは?

ビッグデータ分析は、非構造化を含む大規模・多様データを統合し、分散��処理などの専用技術でAnalyticsを行う点が大きく異なります。

2. なぜ従来のETLがボトルネックになる?

新しいデータソースごとに整形・変換が必要で、開発や変更に時間と労力がかかり、スケールしにくいからです。

3. ビッグデータ分析で何が得られる?

隠れたパターンや相関、市場動向の発見、意思決定の高速化、不正検出、新製品・サービス開発などに繋がります(データサイエンス(Data Science)の手法も活用)。