LAKEFLOW SPARK DECLARATIVE PIPELINES

高信頼性データパイプラインを容易に構築

ETLのバッチとストリーミング処理が簡素化し、自動化による信頼性と質の高い組み込みデータが伴います。

トップチームはインテリジェントなデータパイプラインで成功を収めていますデータパイプラインのベストプラクティス、コード化

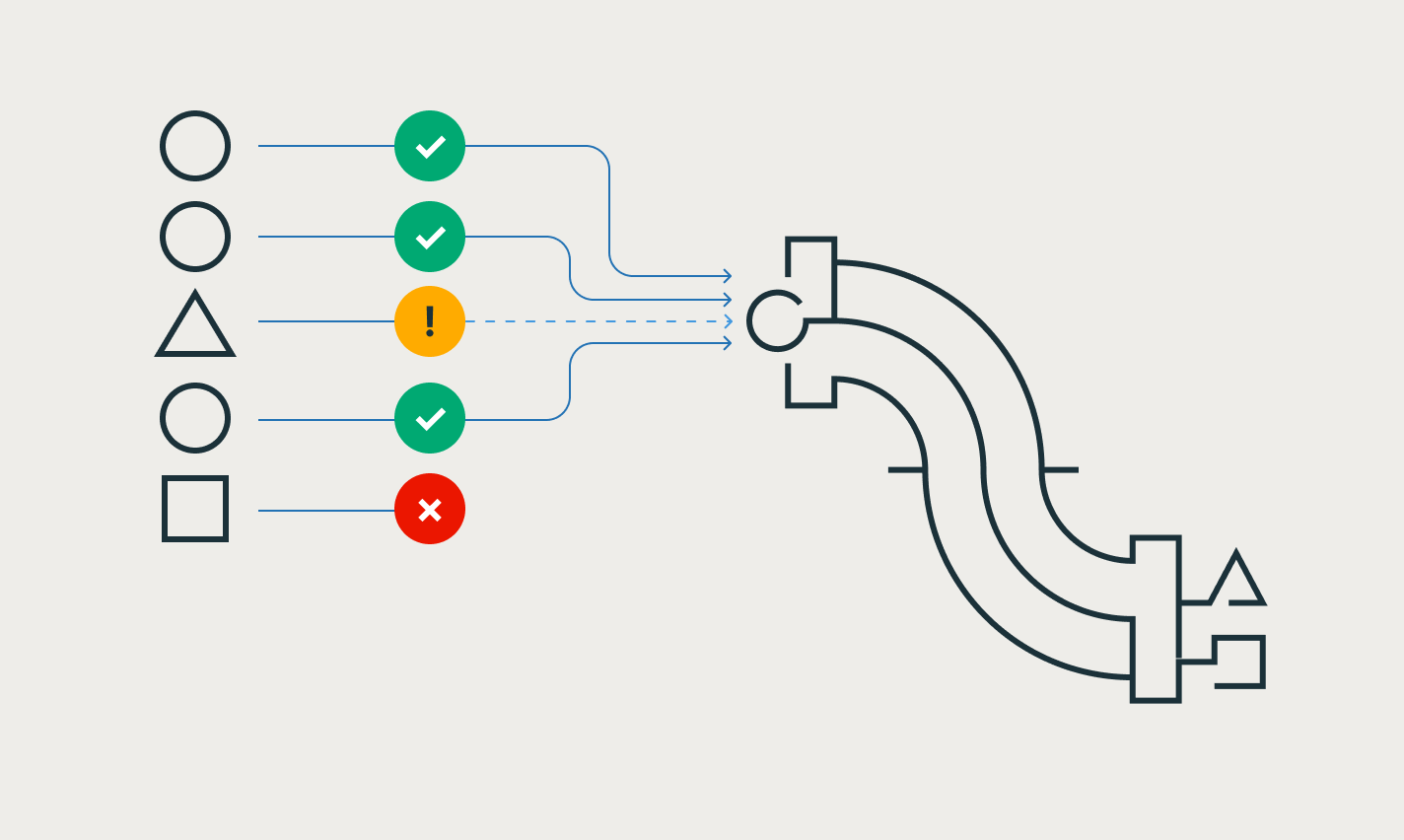

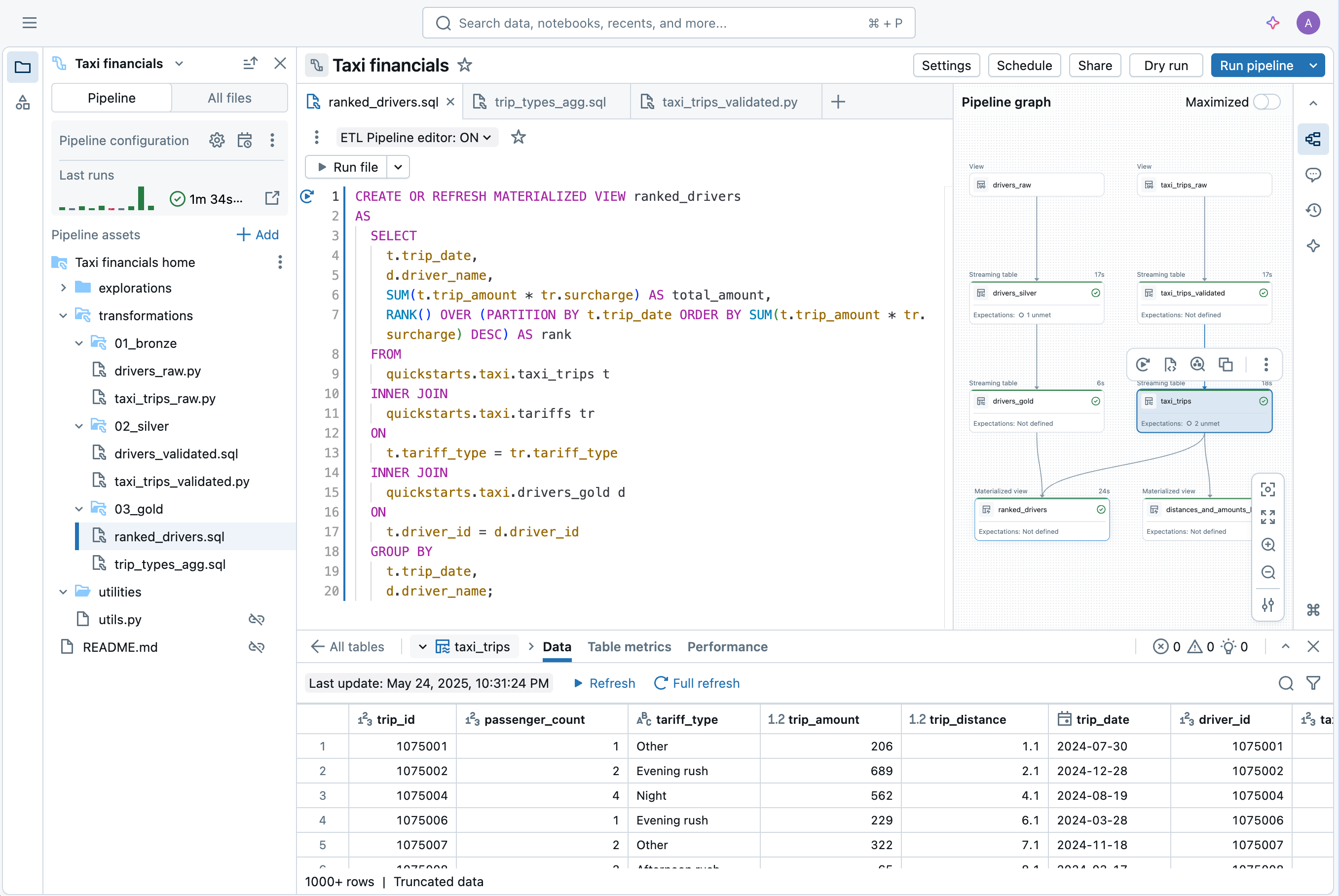

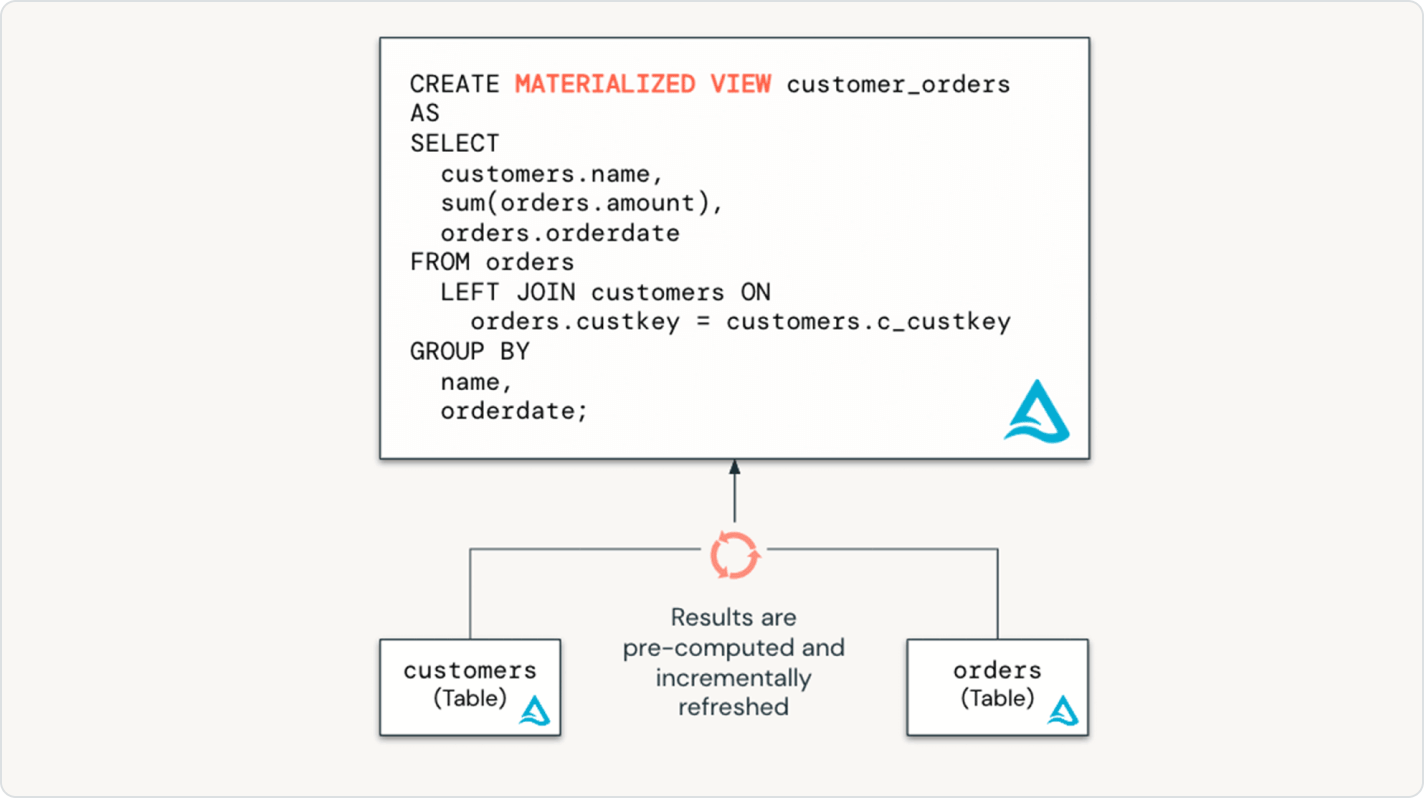

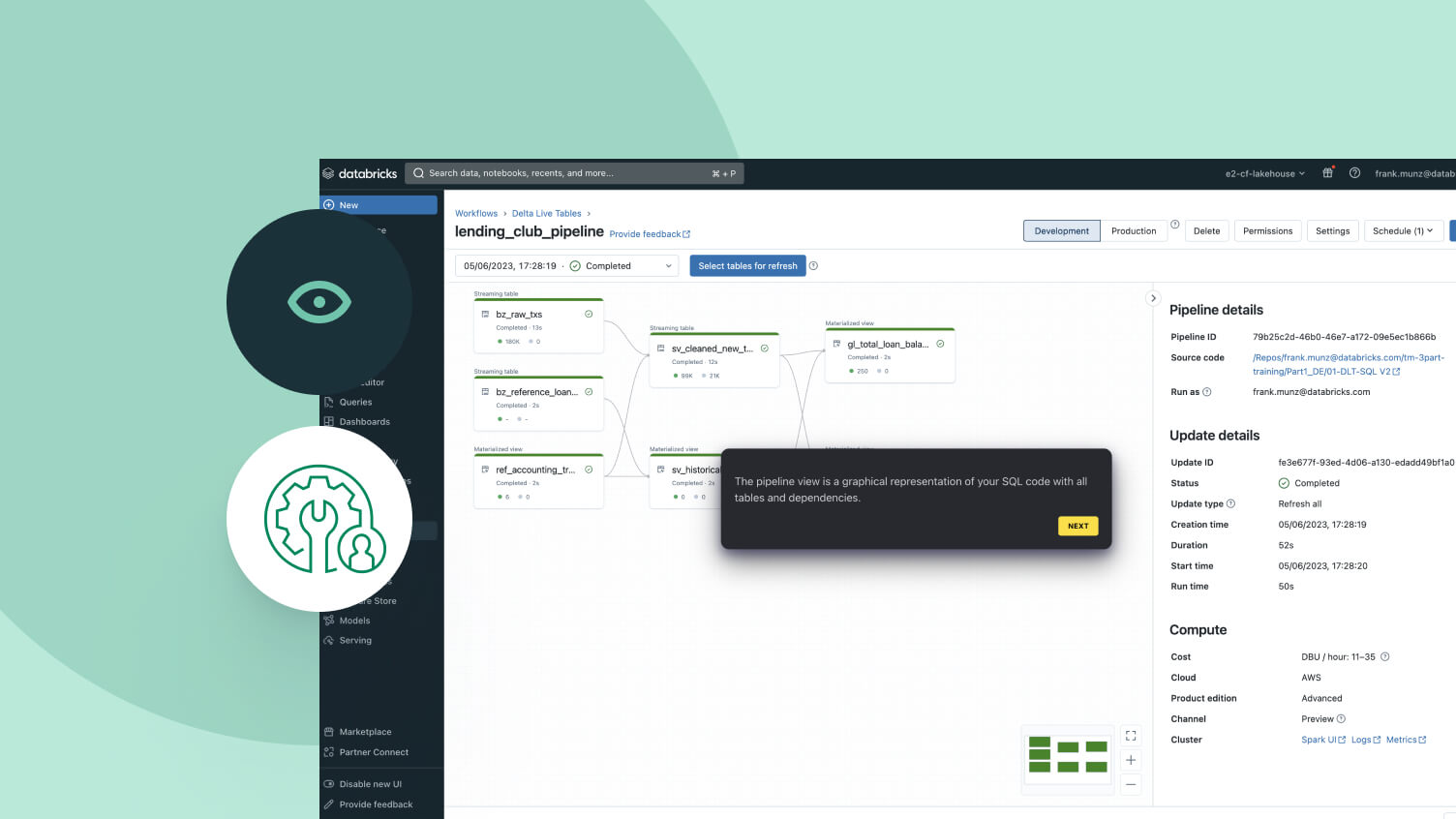

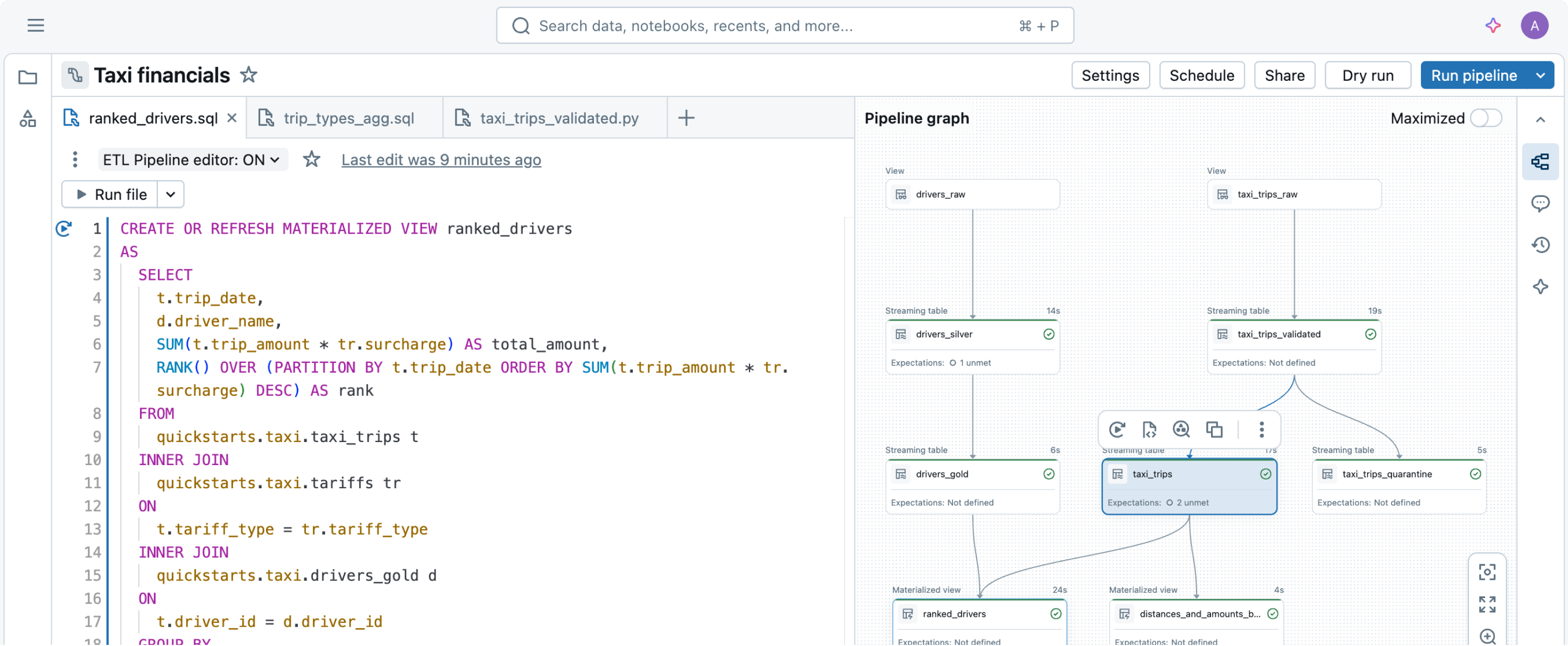

必要なデータ変換を単に宣言するだけで、Spark Declarative Pipelinesが残りの部分を処理します。データパイプラインを簡素化するために構築

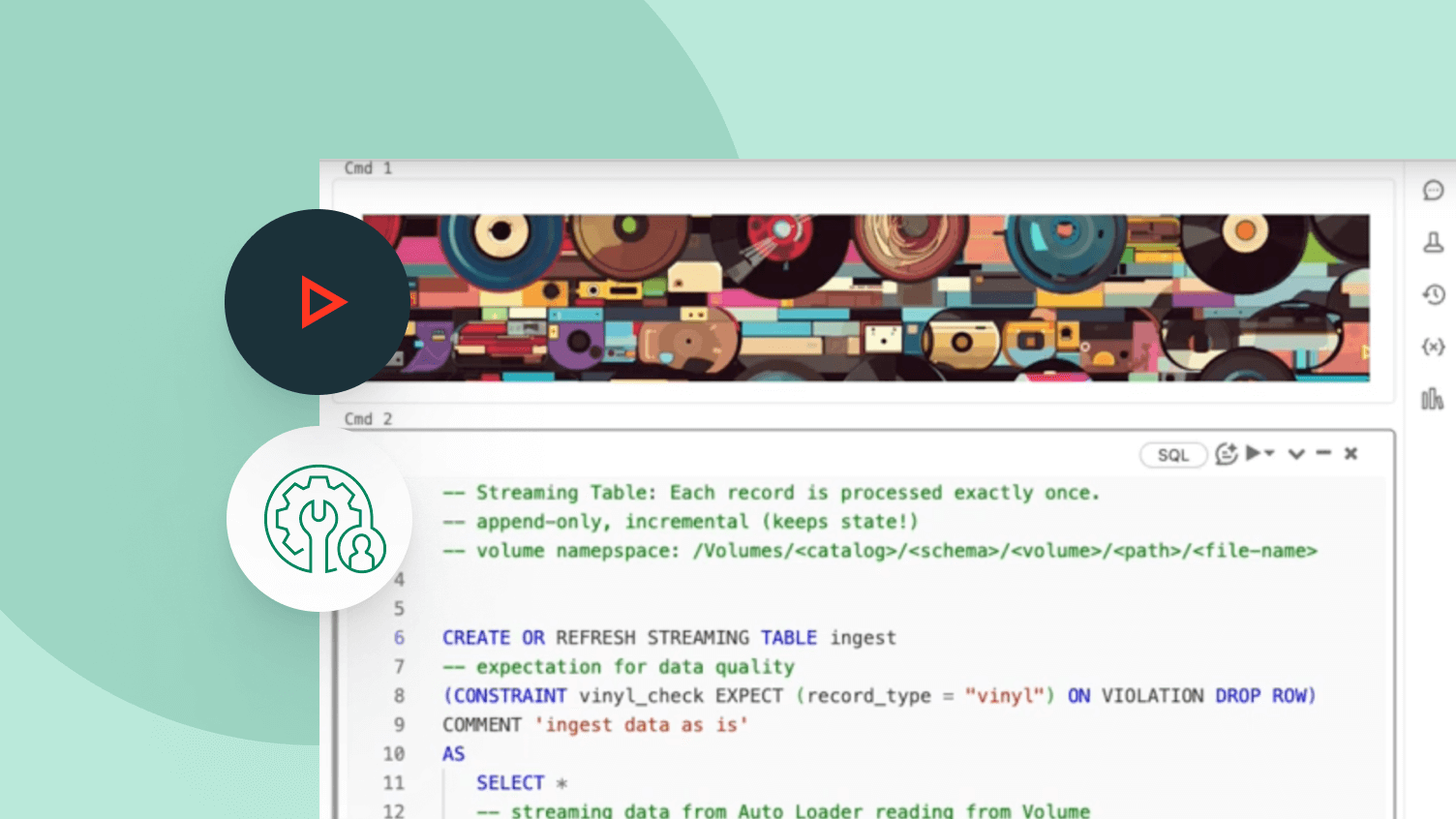

データパイプラインの構築と運用は難しいことがありますが、必ずしもそうである必要はありません。Spark Declarative Pipelinesは強力なシンプルさを備えて構築されているため、数行のコードだけで堅牢なETLを実行できます。

その他の機能

データパイプラインを効率化します

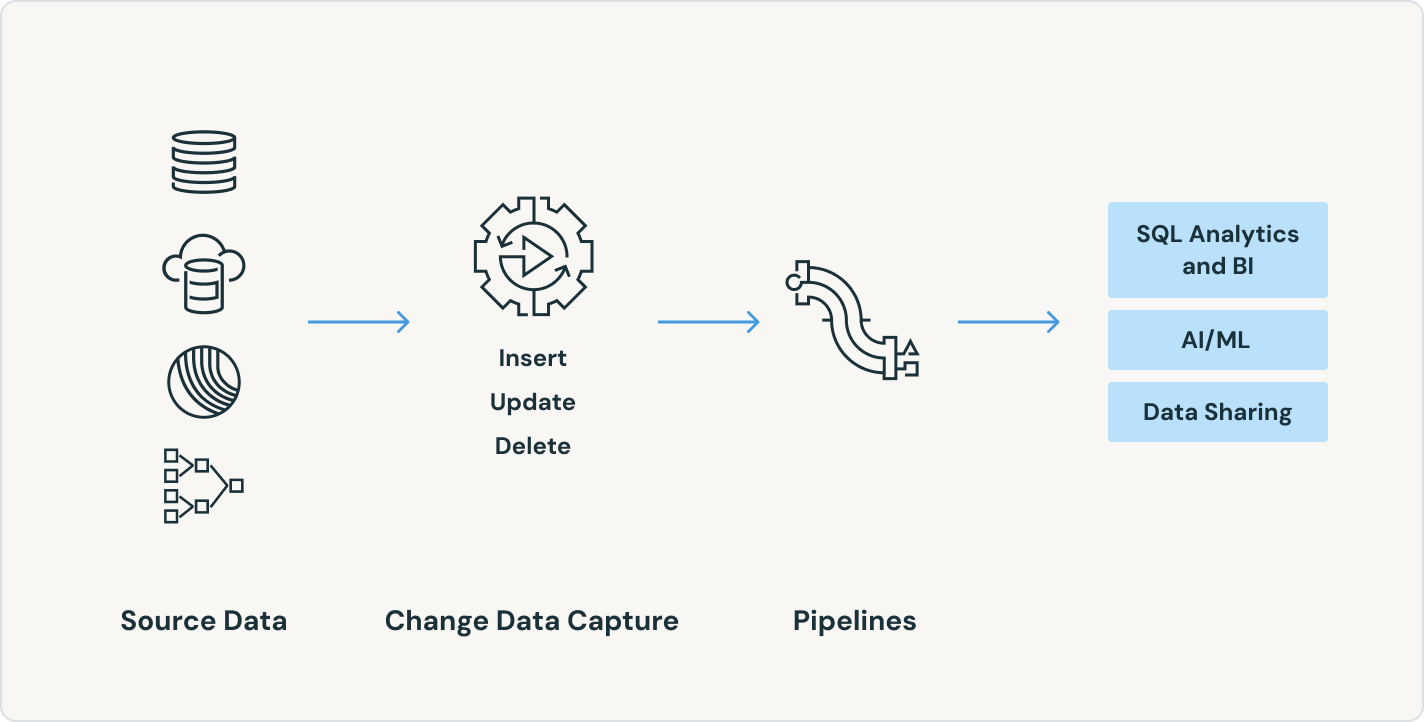

ソース、変換、および目的地を簡素化します

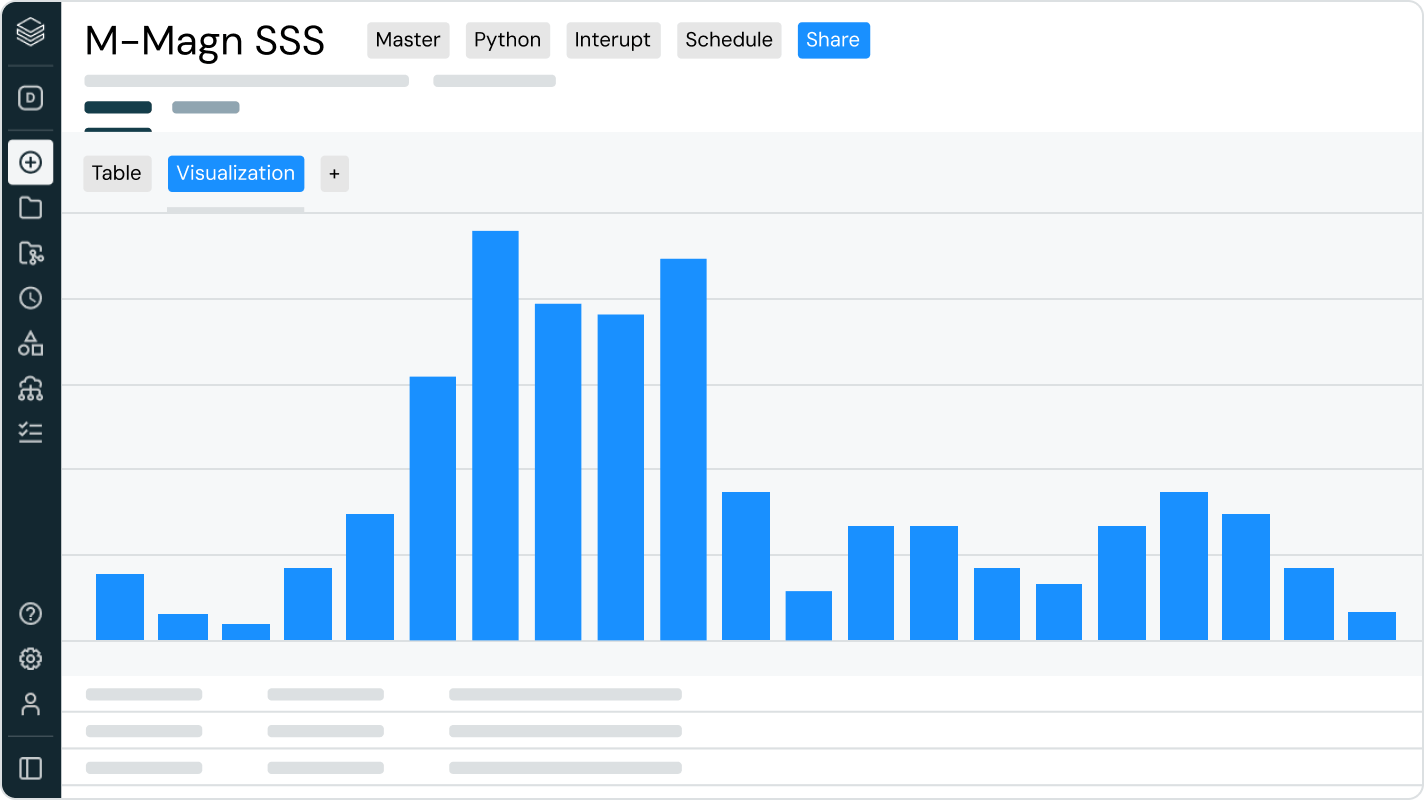

宣言的プログラミングにより、数行のコードだけでデータインテリジェンスプラットフォーム上のETLの力を引き出すことができます。

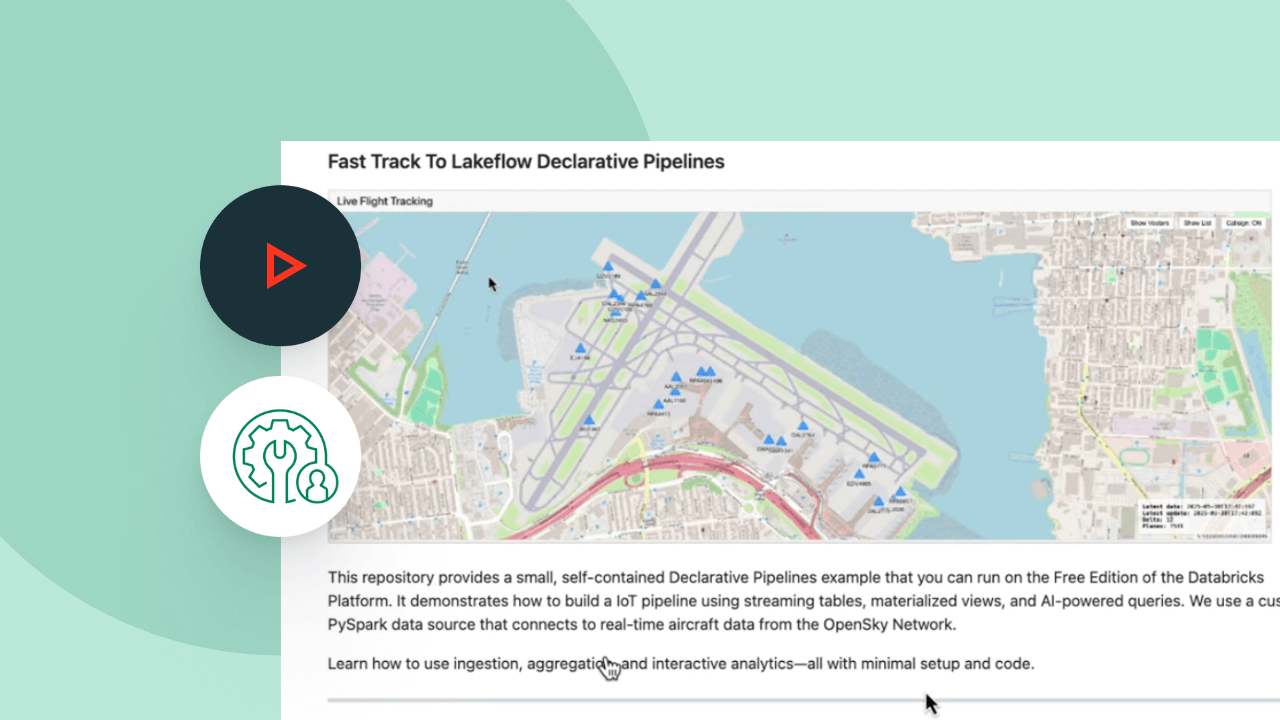

Spark Declarative Pipelinesのデモを探索します

使用量に応じた価格設定で、支出を抑制

使用した製品に対する秒単位での課金となります。さらに詳しく

Data Intelligence Platform上の他の統合された、インテリジェントなオファリングを探索してみてください。LakeFlow Connect

任意のソースからの効率的なデータ取り込みコネクタとData Intelligence Platformとのネイティブな統合により、統一されたガバナンスを持つ分析とAIへの簡単なアクセスが可能になります。

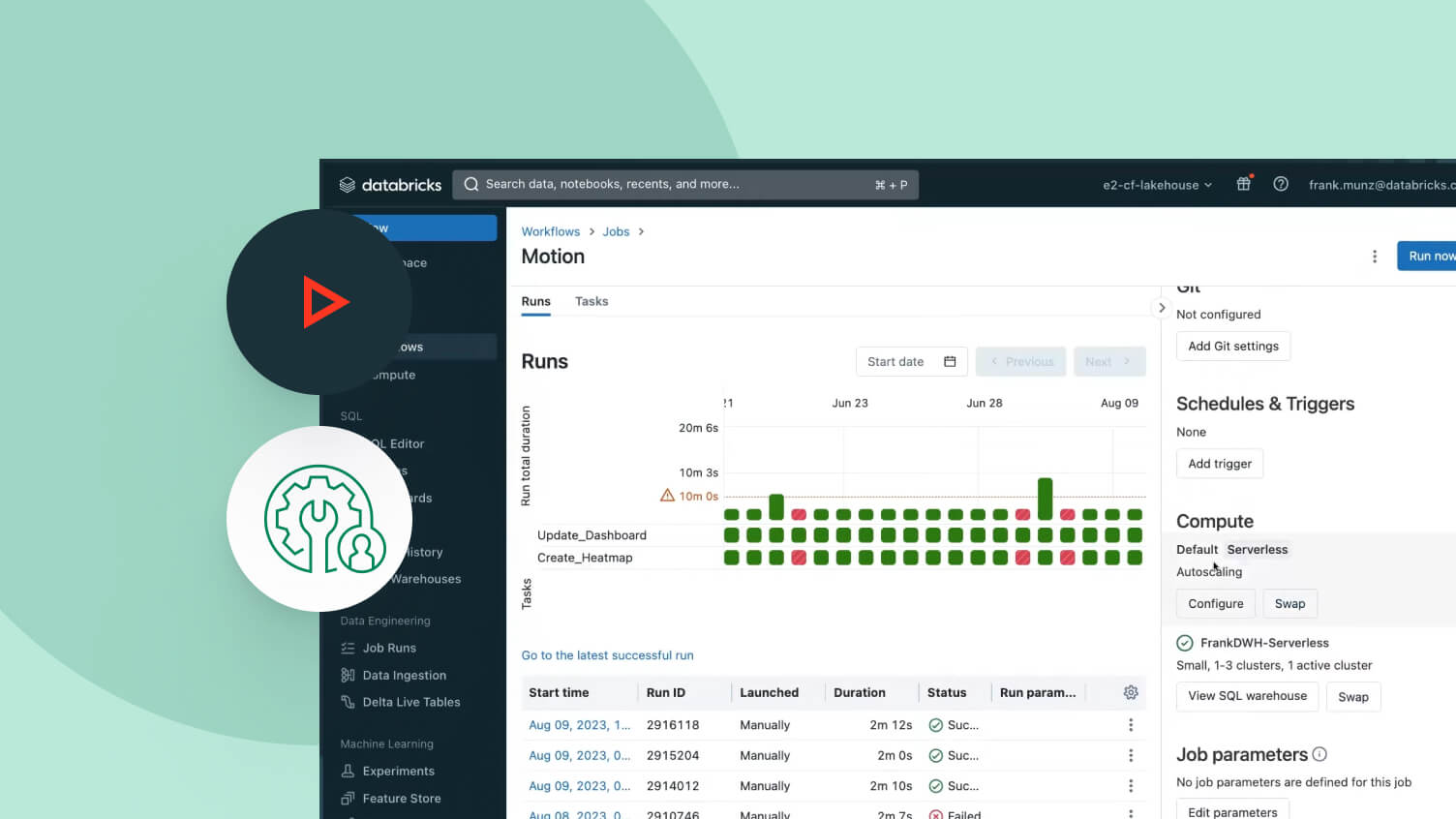

Lakeflowジョブ

ETL、分析、および機械学習パイプラインのマルチタスクワークフローを簡単に定義、管理、監視します。サポートされるタスクタイプの幅広い範囲、深い観察能力、高い信頼性により、データチームは任意のパイプラインをより効果的に自動化し、調整することができ、生産性を向上させることができます。

レイクハウスストレージ

あなたのレイクハウス内のデータを統一し、すべての形式とタイプを通じて、あなたの分析とAIワークロードのために。

Unity Catalog

業界唯一の統一されたオープンなガバナンスソリューションであるDatabricks Data Intelligence Platformに組み込まれた、データとAIのガバナンスをシームレスに行います。

データインテリジェンスプラットフォーム

Databricks データ・インテリジェンス・プラットフォームは、さまざまなデータ・AI のワークロードを支援しています。詳しい内容は、下記のページをご覧ください。