LAKEFLOWを使用しているトップ企業高品質なデータを提供するためのエンドツーエンドのソリューション。

すべてのチームが信頼性の高いデータパイプラインを構築するのを容易にするツールデータエンジニアのための統一ツール

LakeFlow Connect

効率的なデータ取り込みコネクタとData Intelligence Platformとのネイティブ統合により、統一されたガバナンスとともに分析とAIへの簡単なアクセスが可能になります。

Spark Declarative Pipelines

自動化されたデータ品質、変更データキャプチャ(CDC)、データ取り込み、変換、統一ガバナンスを用いてバッチおよびストリ��ーミングETLを簡素化します。

Lakeflowジョブ

チームが深い観察可能性、高い信頼性、広範なタスクタイプのサポートを持つ任意のETL、分析、AIワークフローをより良く自動化し、調整するための装備を提供します。

Unity Catalog

業界唯一の統一されたオープンなガバナンスソリューションであるDatabricks Data Intelligence Platformに組み込まれた、データとAIのガバナンスをシームレスに行います。

レイクハウスストレージ

あなたのレイクハウス内のデータを統一し、すべての形式とタイプを通じて、あなたの分析とAIワークロードのために。

データインテリジェンスプラットフォーム

Databricks データ・インテリジェンス・プラットフォームで利用可能なあらゆるツールを活用し、組織全体のデータと AI をシームレスに統合できます。

信頼性の高いデータパイプラインを構築します

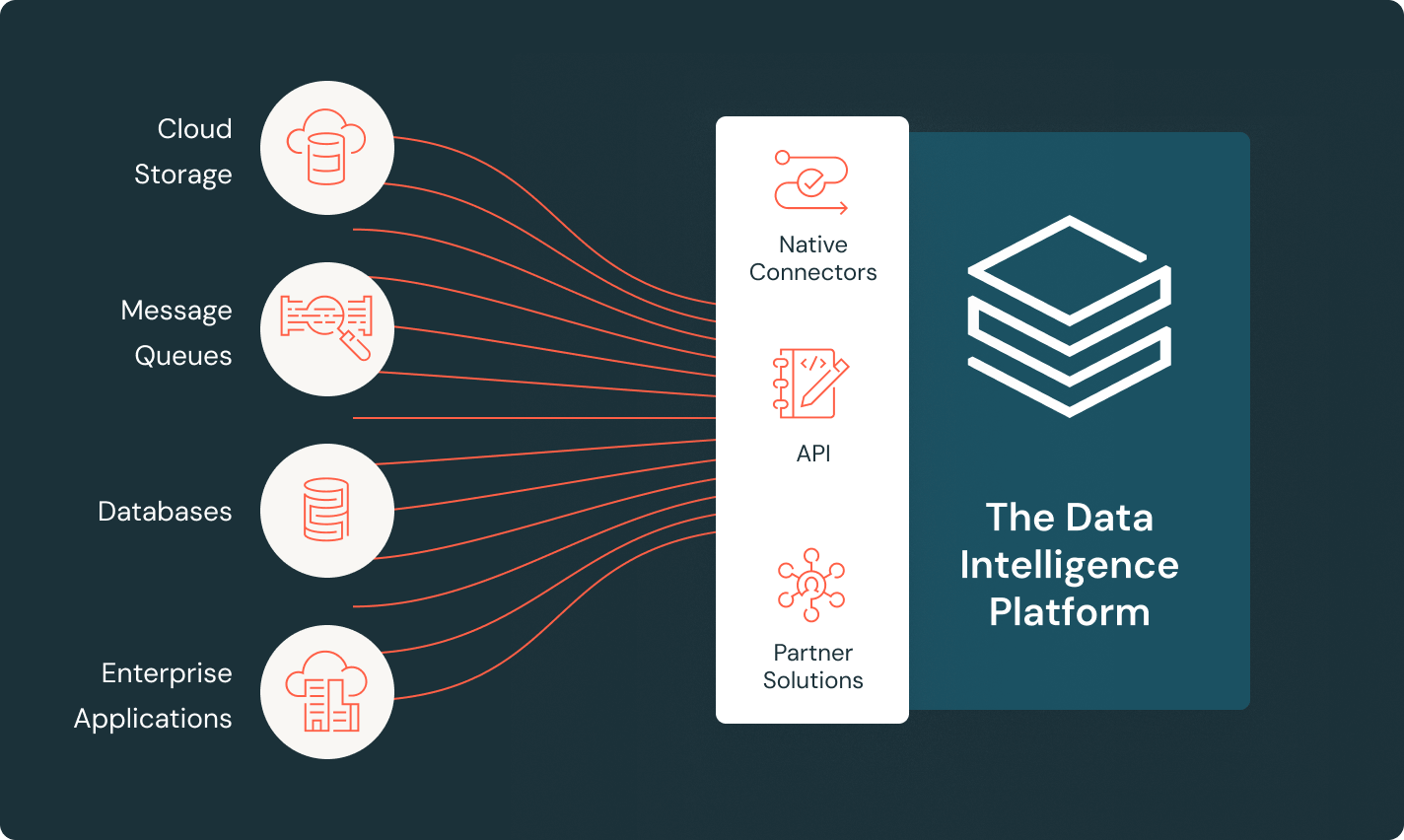

データがどこにあってもその価値を引き出します

Lakeflowのコネクタを使用して、ファイルソース、エンタープライズアプリケーション、データベースからすべてのデータをData Intelligence Platformに取り込みます。完全に管理されたコネクタは、効率的な取り込みを提供し、組み込みのガバナンスはパイプライン全体でデータをコントロールします。

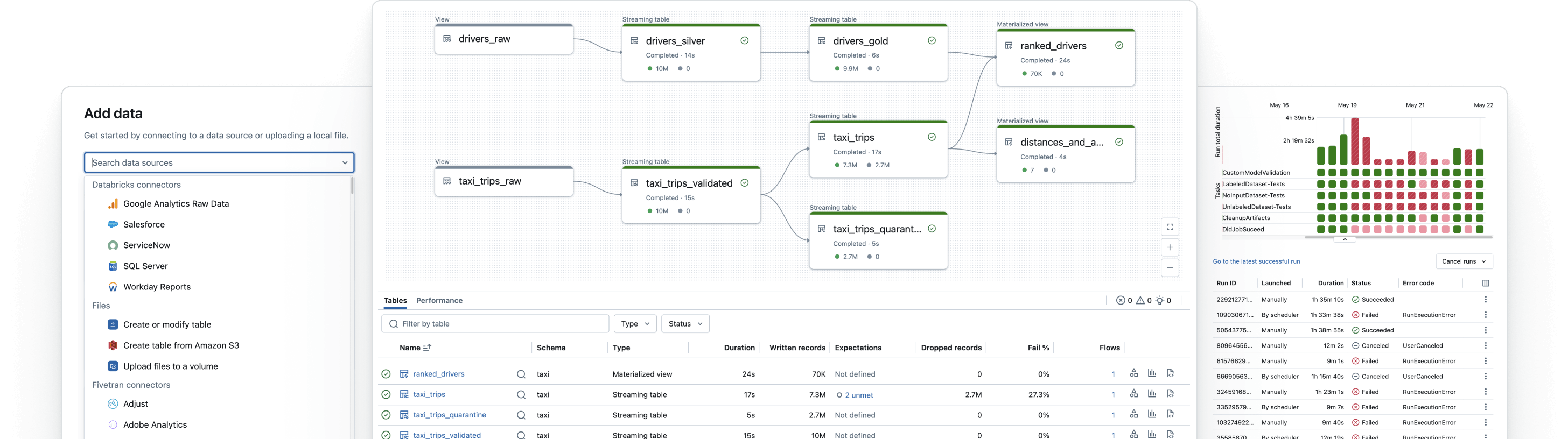

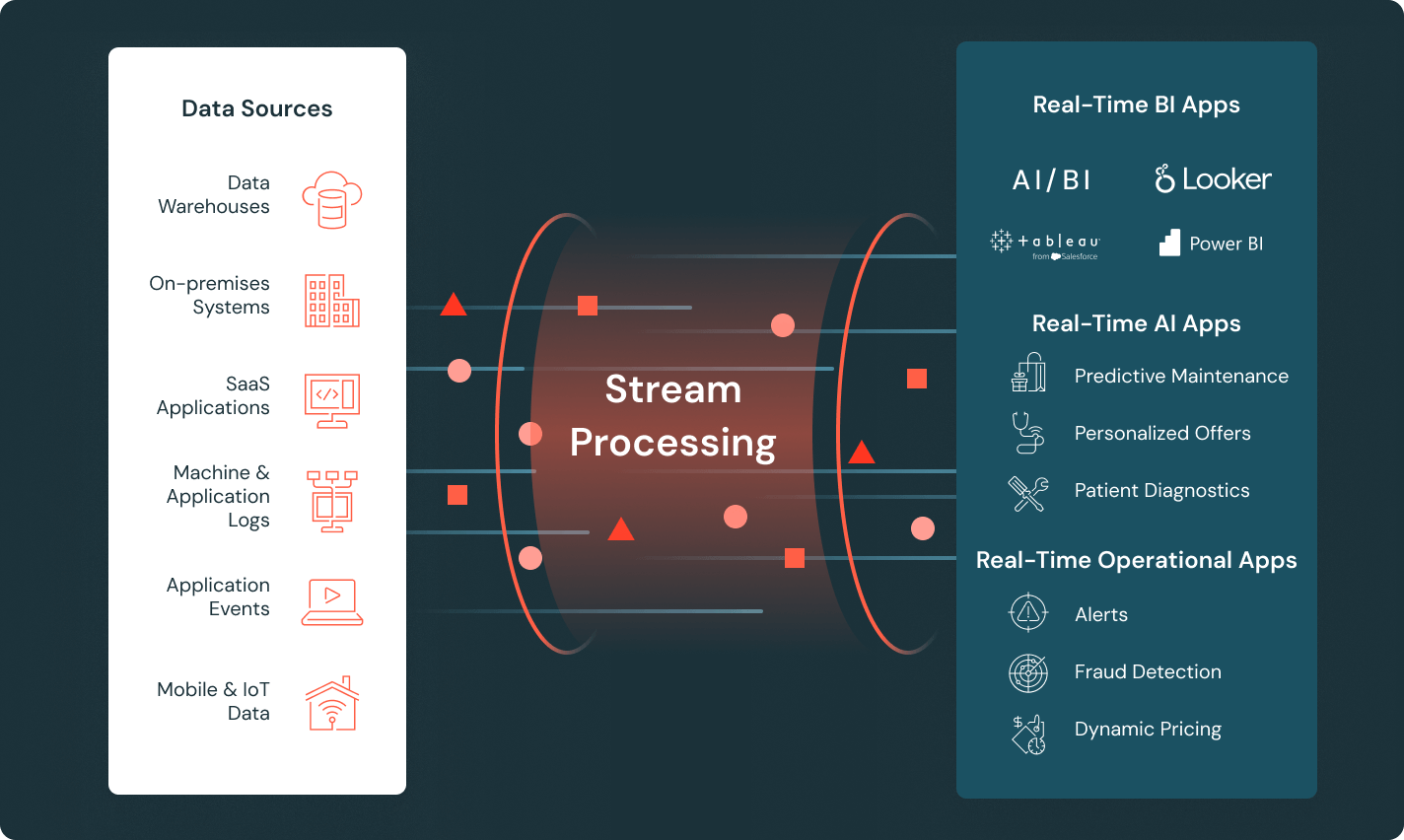

リアルタイムの洞察のための新鮮なデータを提供する

センサー、クリックストリーム、IoTデバイスからリアルタイムで到着するデータを処理するパイプラインを構築し、リアルタイムアプリケーションにフィードします。Spark Declarative Pipelinesを使用して運用の複雑さを減らし、パイプライン開発を簡素化するためのストリーミングテーブルを使用します。

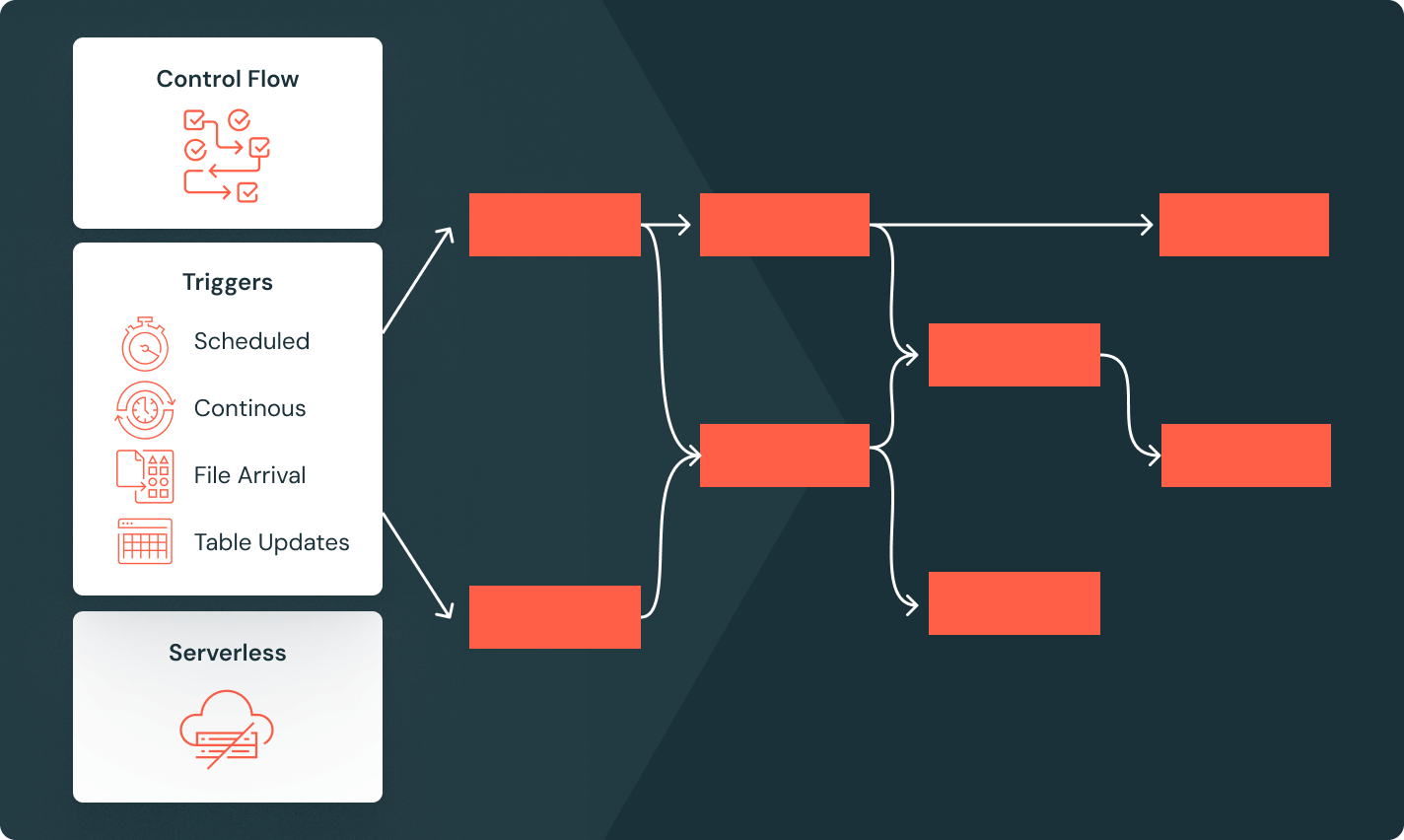

複雑なワークフローを簡単に管理する

データプラットフォームと統合された管理オーケストレータを使用して、信頼性の高い分析とAIワークフローを定義します。条件付き実行、ループ、さまざまなジョブトリガーなどの強化された制御フロー機能を使用して、複雑なDAGを簡単に実装します。

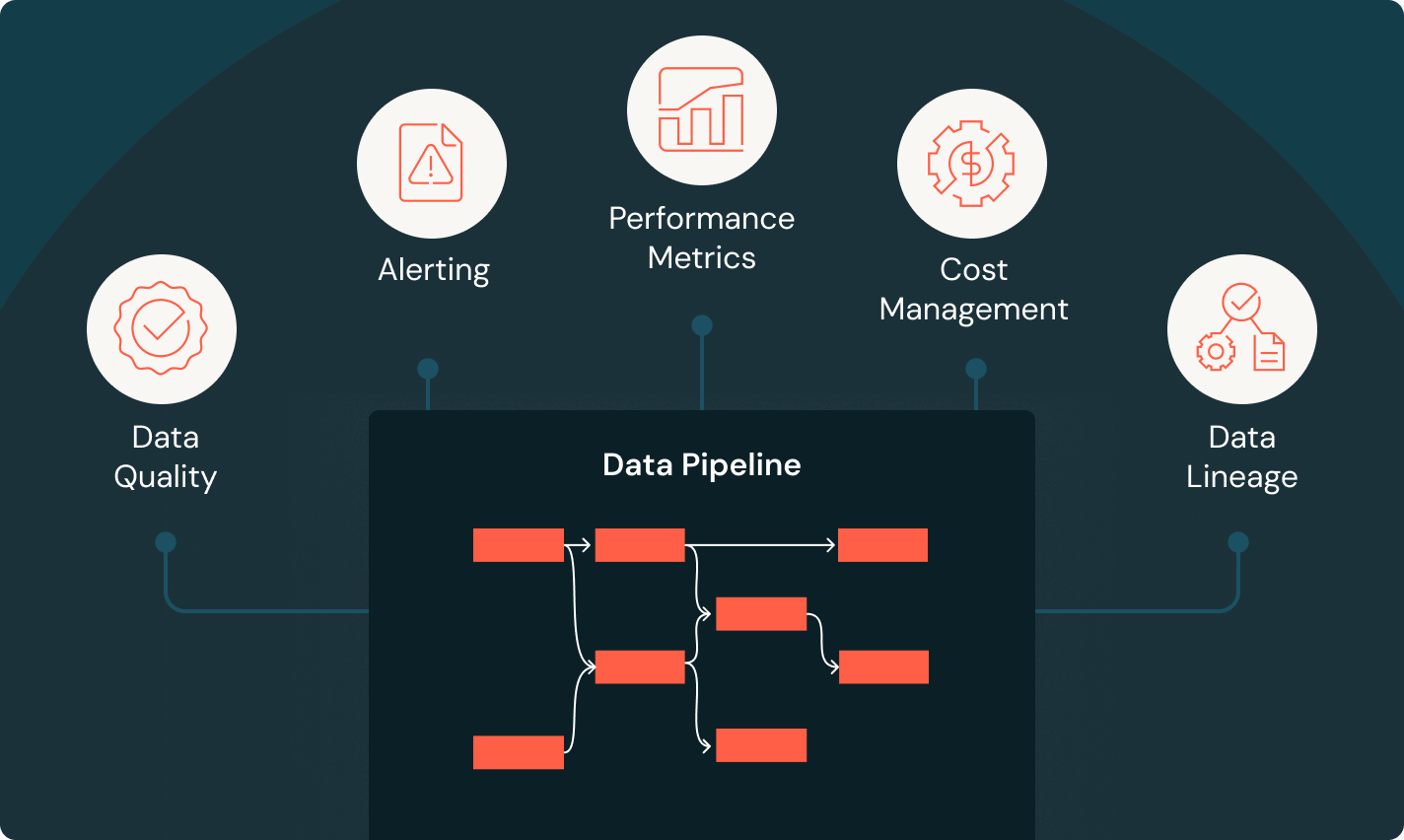

すべてのパイプラインのすべてのステップを監視します

パイプラインの健康状態をリアルタイムで完全に観察することができます。カスタムアラートは問題が発生したときに正確に知ることを保証し、詳細なビジュアルは失敗の根本原因を特定するので、迅速にトラブルシューティングが可能です。エンドツーエンドの監視にアクセスがあると、データとパイプラインをコントロールすることができます。