Es ist an der Zeit, Ihre Beziehung zu Hadoop zu überdenken

Da Unternehmen im vergangenen Jahr gezwungen waren, sich an eine verteilte Remote-Belegschaft anzupassen, hat sich die Cloud-Einführung um +14 % in einem beispiellosen Tempo beschleunigt. Das Ergebnis lag 2 % oder 13 Mrd. US-Dollar über den Prognosen für 2020 aus der Zeit vor der Pandemie – und in den nächsten Jahren stehen möglicherweise Migrationen von On-Premises in die Cloud im Wert von über 600 Mrd. US-Dollar an. Durch diese Verlagerung in die Cloud gewinnt eine neue Generation von Daten- und Analyseplattformen zunehmend an Bedeutung, um Innovationen voranzutreiben und digitale Transformationsstrategien in Unternehmen umzusetzen. Viele Unternehmen haben jedoch immer noch mit der Komplexität, der nicht skalierbaren Infrastruktur und dem hohen Wartungsaufwand ihrer Legacy- Hadoop -Umgebungen zu kämpfen und opfern letztendlich den Wert ihrer Daten und riskieren im Gegenzug ihren Wettbewerbsvorteil. Um diese Herausforderung zu meistern und weitere (manchmal verborgene) Möglichkeiten in ihren Daten zu erschließen, setzen Unternehmen auf offene, einfache und kollaborative cloudbasierte Daten- und Analyseplattformen wie die Databricks Lakehouse Platform. In diesem Blog erfahren Sie, welche Herausforderungen Unternehmen dazu bewegen, moderne cloudbasierte Lösungen zu erkunden, und welche Rolle die Lakehouse-Architektur dabei spielt, die nächste Welle datengesteuerter Innovationen anzustoßen.

Unerfüllte Versprechen von Hadoop

Hadoops verteiltes Dateisystem (HDFS) war bei seiner Einführung eine bahnbrechende Technologie und wird eine Ikone im Verlauf der Datenverarbeitung bleiben. Durch seine Einführung waren Unternehmen nicht mehr an die Grenzen relationaler Datenbanken gebunden, was zur Entstehung moderner Big-Data-Speicher und schließlich zu Cloud-Data-Lakes führte. Trotz all seines Ruhms und der Fanfaren bis zum Jahr 2015 hatte Hadoop Schwierigkeiten, das wachsende Potenzial aller Datentypen zu unterstützen – insbesondere auf Enterprise Scale. Als sich die Datenlandschaft und die damit verbundenen Geschäftsanforderungen weiterentwickelten, hatte Hadoop letztendlich Schwierigkeiten, seine Versprechen weiterhin zu halten. Infolgedessen haben Unternehmen begonnen, cloudbasierte Alternativen zu erkunden, und die Migrationsrate von Hadoop in die Cloud nimmt stetig zu.

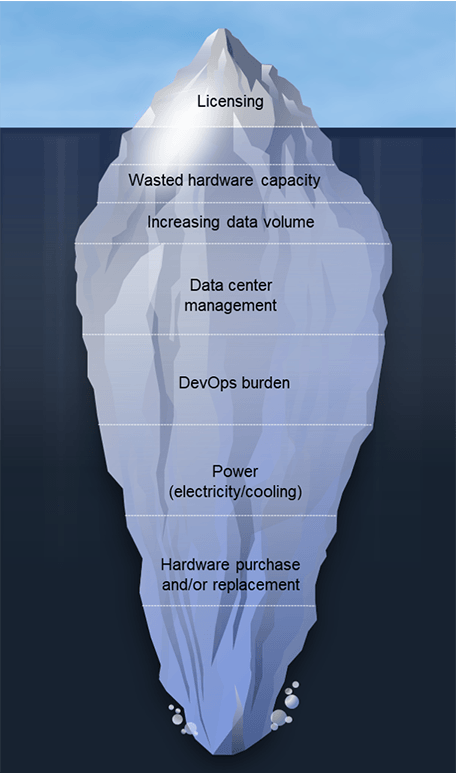

Teams migrieren aus verschiedenen Gründen von Hadoop; oft ist es eine Kombination aus „Push“- und „Pull“-Faktoren. Einschränkungen bei bestehenden Hadoop-Systemen und hohe Lizenz- und Verwaltungskosten drängen Teams dazu, Alternativen zu erkunden. Sie werden auch von den neuen Möglichkeiten angezogen, die moderne Cloud-Datenarchitekturen bieten. Obwohl die Architekturanforderungen je nach Unternehmen variieren, sehen wir mehrere gemeinsame Faktoren, die Kunden zu der Erkenntnis bringen, dass es an der Zeit ist, sich zu verabschieden. Dazu gehören:

- Verschwendete Hardwarekapazität: Überkapazitäten sind bei On-Premises-Implementierungen eine Selbstverständlichkeit, damit Sie für Ihre Spitzenlastzeiten hochskalieren können. Das Ergebnis ist jedoch, dass ein Großteil dieser Kapazität inaktiv bleibt, aber weiterhin zu den Betriebs- und Wartungskosten beiträgt.

- Skalierungskosten summieren sich schnell: Die Entkopplung von Speicher und compute ist in einer on-premises Hadoop-Umgebung nicht möglich, sodass die Kosten mit den Datensätzen wachsen. Berücksichtigen Sie dabei die schnelle Digitalisierung infolge der COVID-19-Pandemie und die globale Wachstumsrate. Studien deuten darauf hin, dass die Gesamtmenge der weltweit erstellten, erfassten, kopierten und genutzten Daten von 2020 bis 2024 auf 149 Zettabyte ansteigen wird, ein prognostizierter Anstieg von 152,5 %. In einer Welt des Hyperdatenwachstums können die Kosten schnell ausufern.

- DevOps-Aufwand: Basierend auf den Erfahrungen unserer Kunden können Sie von 4 bis 8 Vollzeitmitarbeitern pro 100 Knoten ausgehen.

- Erhöhte Stromkosten: Rechnen Sie mit bis zu 800 $ pro Server jährlich, basierend auf Verbrauch und Kühlung. Das sind 80.000 $ pro Jahr für einen Hadoop-Cluster mit 100 Knoten!

- Kosten für neue und Ersatzhardware: Dies macht ~20 % der TCO aus, was den Verwaltungskosten der Hadoop-Cluster entspricht.

- Softwareversions-Upgrades: Diese Upgrades sind oft vorgeschrieben, um den Supportvertrag beizubehalten, und diese Projekte dauern monatelang, liefern wenig neue Funktionalität und binden wertvolle Bandbreite der Datenteams.

Zusätzlich zu all den oben genannten Herausforderungen gibt es echte Bedenken hinsichtlich der langfristigen Zukunftsfähigkeit von Hadoop. Im Jahr 2019 kam es zu einem massiven Zerfall im Hadoop-Bereich. Google, dessen bahnbrechendes Paper zu MapReduce aus dem Jahr 2004 die Grundlage für die Entwicklung von Apache Hadoop bildete, hat die Nutzung von MapReduce vollständig eingestellt, wie Urs Hölzle, SVP of Technical Infrastructure bei Google, tweetete. Es gab auch einige sehr hochkarätige Fusionen und Übernahmen in der Welt von Hadoop. Des Weiteren hat 2020 ein führender Hadoop-Anbieter sein Produktset von einem Hadoop-zentrierten Ansatz abgewandt, da Hadoop mittlerweile als „eher eine Philosophie als eine Technologie“ gilt. Schließlich kündigte die Apache Software Foundation 2021 die Einstellung von zehn Projekten aus dem Hadoop-Ökosystem an. Diese zunehmenden Bedenken, gepaart mit der beschleunigten Notwendigkeit der Digitalisierung, haben viele Unternehmen dazu veranlasst, ihre Beziehung zu Hadoop neu zu bewerten.

Der Wandel hin zur Lakehouse-Architektur

Eine Lakehouse-Architektur ist die ideale Datenarchitektur für datengesteuerte Organisationen. Es kombiniert die besten Eigenschaften von Data Warehouses und Data Lakes, um eine einzige hochleistungsfähige Lösung für alle Daten-Workloads bereitzustellen. Die Lakehouse-Architektur unterstützt eine Vielzahl von Anwendungsfällen, z. B. Streaming-Datenanalysen für BI, Data Science und KI. Warum lieben Kunden die Databricks Lakehouse Platform?

- Ganz einfach. Ob Daten, Analytics oder KI:

alles auf einer einzigen Plattform - Es ist offen. Vereinheitlichen Sie Ihr Datenökosystem mit offenen Standards und Formaten.

- Es ist kollaborativ. Ihre Datenteams vereinen, damit sie über den gesamten Daten- und KI-Workflow hinweg zusammenarbeiten können

Eine Lakehouse-Architektur kann im Vergleich zu herkömmlichen Hadoop-Umgebungen, die Unternehmen zur Einführung der Cloud drängen, erhebliche Vorteile bieten. Dazu gehören auch Kunden, die versucht haben, Hadoop in der Cloud zu verwenden, aber nicht die erwarteten oder gewünschten Ergebnisse erzielen. Wie R. Tyler Croy, Director of Engineering bei Scribd, erklärt: „Databricks versprach eine Optimierung von 30 % bis 50 % für die meisten herkömmlichen Apache Spark™-Workloads. Aus Neugier habe ich mein Kostenmodell überarbeitet, um den Preis von Databricks und die potenziellen Optimierungen der Spark-Jobs zu berücksichtigen. Nachdem ich die Zahlen angepasst hatte, stellte ich fest, dass Databricks bei einer Optimierungsrate von 17 % unsere Infrastrukturkosten für Amazon Web Services (AWS) so stark senken würde, dass sich die Kosten für die Databricks-Plattform selbst amortisieren würden. Nach unserer ersten Evaluierung war ich bereits von den Features und den Verbesserungen der Entwicklergeschwindigkeit, die Databricks bieten würde, überzeugt. Als ich die Zahlen in meinem Modell durchging, wurde mir klar, dass ich es mir nicht leisten konnte, Databricks nicht einzuführen!“

Scribd ist damit nicht allein: Zu den weiteren Kunden, die von Hadoop auf die Databricks Lakehouse Platform migriert sind, gehören:

- H&M verarbeitet täglich riesige Datenmengen von über 5.000 Filialen in über 70 Märkten mit Millionen von Kunden. Ihre Hadoop-basierte Architektur führte zu Herausforderungen im Umgang mit den Daten. Die Skalierung gestaltete sich ressourcenintensiv und kostspielig, es traten Probleme bei der Datensicherheit auf, der Betrieb ließ sich zur Unterstützung von Data-Science-Initiativen aus verschiedenen Datenquellen nur schwer skalieren, und die Time-to-Market wurde durch erhebliche DevOps-Verzögerungen verlangsamt. Es dauerte ein ganzes Jahr von einer Idee bis zur Produktion. Mit Databricks profitiert H&M von einer verbesserten betrieblichen Effizienz, indem die Betriebskosten um 70 % gesenkt, die teamübergreifende Zusammenarbeit verbessert und der Geschäftserfolg durch schnellere Time-to-Insight gesteigert werden.

- Viacom18 muss täglich mehrere Terabyte Daten über Zuschauer verarbeiten, um die Programmierung zu optimieren Mit dem auf einer On-Premises-Installation von Hadoop aufsetzenden Data Lake war es nicht möglich, rollierende Datenbestände für 90 Tage SLA-konform zu verarbeiten, weswegen die geschäftlichen Anforderungen nicht erfüllt werden konnten. Mit Databricks konnten sie die Kosten durch schnellere Abfragezeiten und geringeren DevOps-Aufwand trotz steigender Datenmengen erheblich senken. Steigerung der Teamproduktivität um 26 % mit einer vollständig verwalteten Plattform, die ETL, Analytics und ML in großem Umfang unterstützt

- Die Reckitt Benckiser Group (RB) hatte Schwierigkeiten mit der Komplexität der Bedarfsprognose für 500.000 Geschäfte. Sie verarbeiten täglich über 2 TB Daten in 250 Pipelines. Die Legacy-Hadoop-Infrastruktur erwies sich als komplex, schwerfällig, kostspielig in der Skalierung und hatte mit Leistungsproblemen zu kämpfen. Mit Databricks realisierte RB eine 10-mal höhere Kapazität zur Unterstützung des Geschäftsvolumens, eine Datenkomprimierung von 98 % von 80 TB auf 2 TB, wodurch die Betriebskosten gesenkt wurden, und eine 2-mal schnellere Performance der Datenpipeline für 24x7-Jobs.

Hadoop wurde nie für den Betrieb in Cloud-Umgebungen entwickelt. Während cloudbasierte Hadoop-Dienste im Vergleich zu ihren on-premises-Pendants schrittweise Verbesserungen aufweisen, bleiben beide im Vergleich zur Lakehouse-Architektur zurück. Beide Hadoop-Instanzen weisen eine geringe Performance, eine niedrige Produktivität und hohe Kosten auf und sind nicht in der Lage, anspruchsvollere Datenanwendungsfälle im großen Maßstab zu bewältigen.

Zukunftssicherheit für Ihr daten-, analyse- und KI-gesteuertes Wachstum

Entscheidungen zur Cloud-Migration sind geschäftliche Entscheidungen. Sie zwingen Unternehmen, sich die Realität der Bereitstellung ihrer aktuellen Systeme genau anzusehen und zu bewerten, was sie für ihre kurz- und langfristigen Ziele erreichen müssen. Da Investitionen in KI weiter an Fahrt gewinnen, müssen Führungskräfte aus den Bereichen Daten, Analytik und Technologie eine entscheidende Rolle dabei spielen, über die bestehende Hadoop-Architektur hinauszudenken und sich die Frage zu stellen: „Bringt uns das dorthin, wo wir hin müssen?“

Wenn die Ziele klar sind, ergeben sich wichtige technische Details wie das Technologie-Mapping, die Bewertung der Cloud-Ressourcennutzung und des Kosten-Performance-Verhältnisses sowie die Strukturierung eines Migrationsprojekts, das Fehler und Risiken minimiert. Am wichtigsten ist jedoch, dass Sie datengesteuert zu der Überzeugung gelangen, dass es an der Zeit ist, Ihre Beziehung zu Hadoop neu zu bewerten. Erfahren Sie mehr darüber, wie die Migration von Hadoop die Geschäftsergebnisse für Ihre Datenanwendungsfälle beschleunigen kann.

1. Quelle: Gartner Market Databook, Goldman Sachs Global Investment Research

(Dieser Blogbeitrag wurde mit KI-gestützten Tools übersetzt.) Originalbeitrag

Verpassen Sie keinen Beitrag von Databricks

Was kommt als Nächstes?

Líder de dados

November 6, 2025/8 min de leitura

Potencializando a criação de modelos de AI: paralelismo de dados e de tarefa com Ray e Databricks

Líder de dados

December 4, 2025/3 min de leitura