Einheitliche und offene Governance für Daten und KI

Beseitigen Sie Silos, vereinfachen Sie die Governance und beschleunigen Sie Erkenntnisse im groß

ERFOLGREICHE TEAMS SETZEN AUF EINHEITLICHE UND OFFENE GOVERNANCESteuern, entdecken, überwachen und teilen – alles an einem Ort

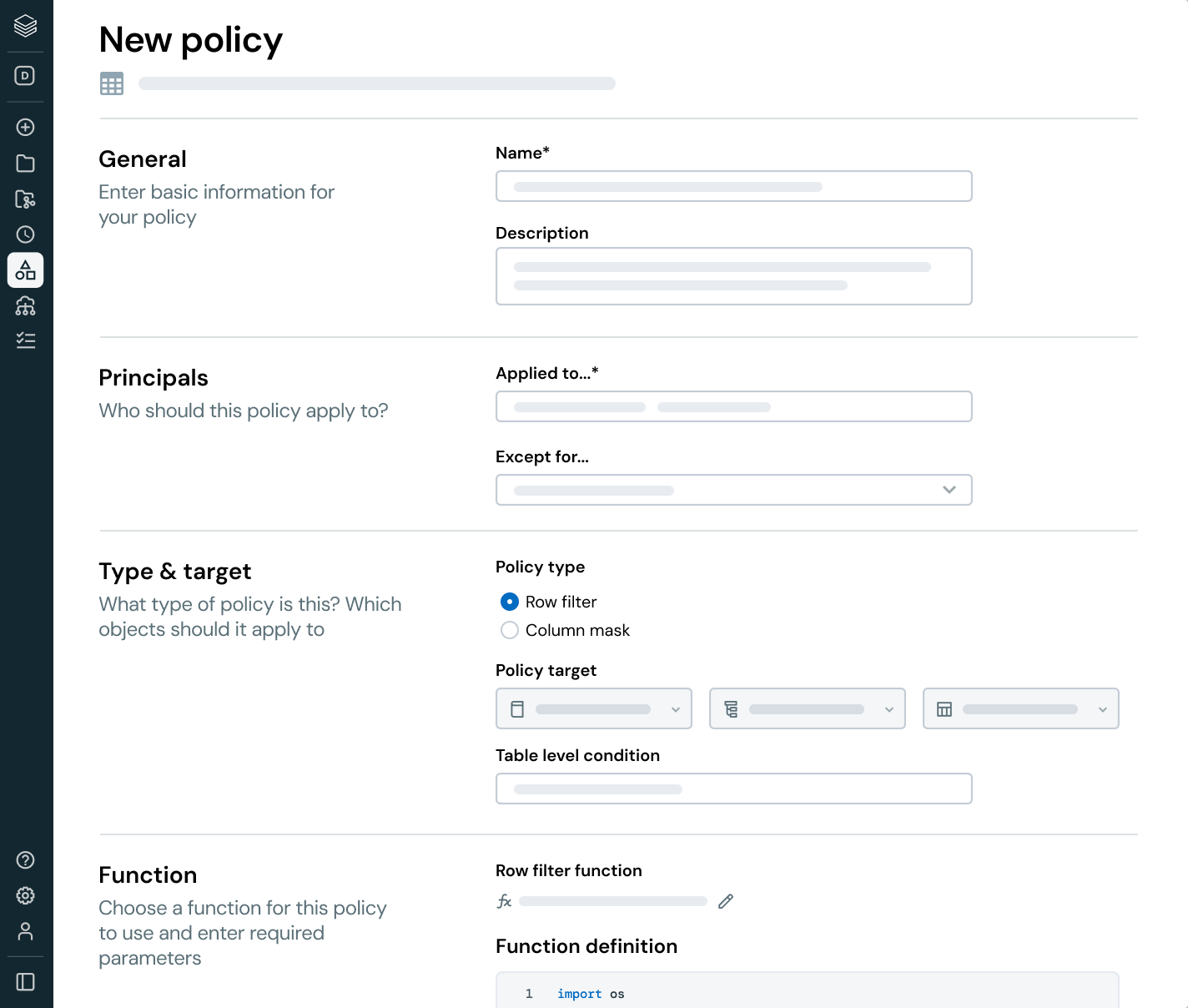

Vereinheitlichen Sie Ihre Datenlandschaft, optimieren Sie die Einhaltung von Vorschriften und erzielen Sie schnellere, vertrauenswürdige Erkenntnisse mit offener, intelligenter Governance über alle Daten- und KI-Ressourcen hinweg.Integrierte intelligente Governance

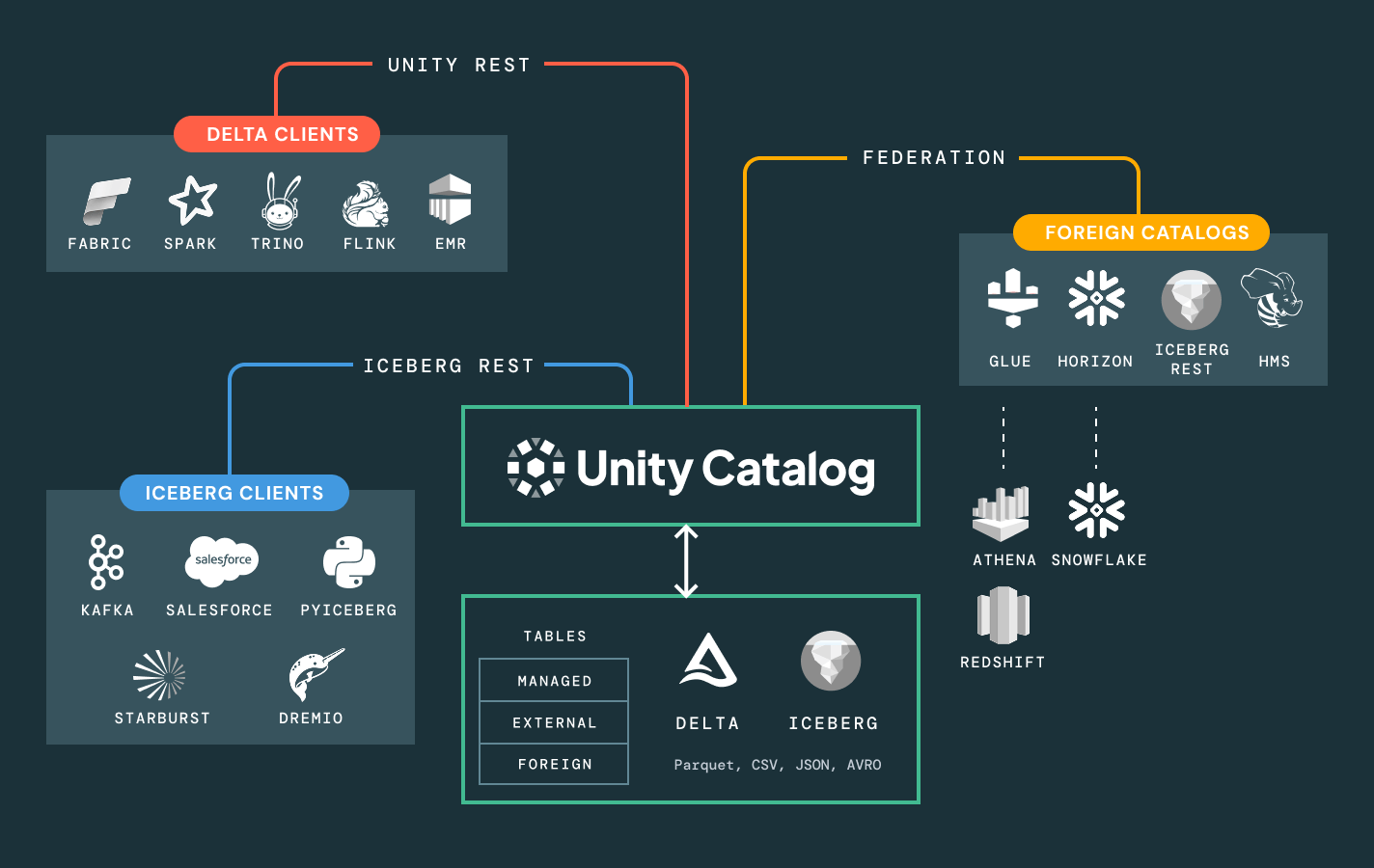

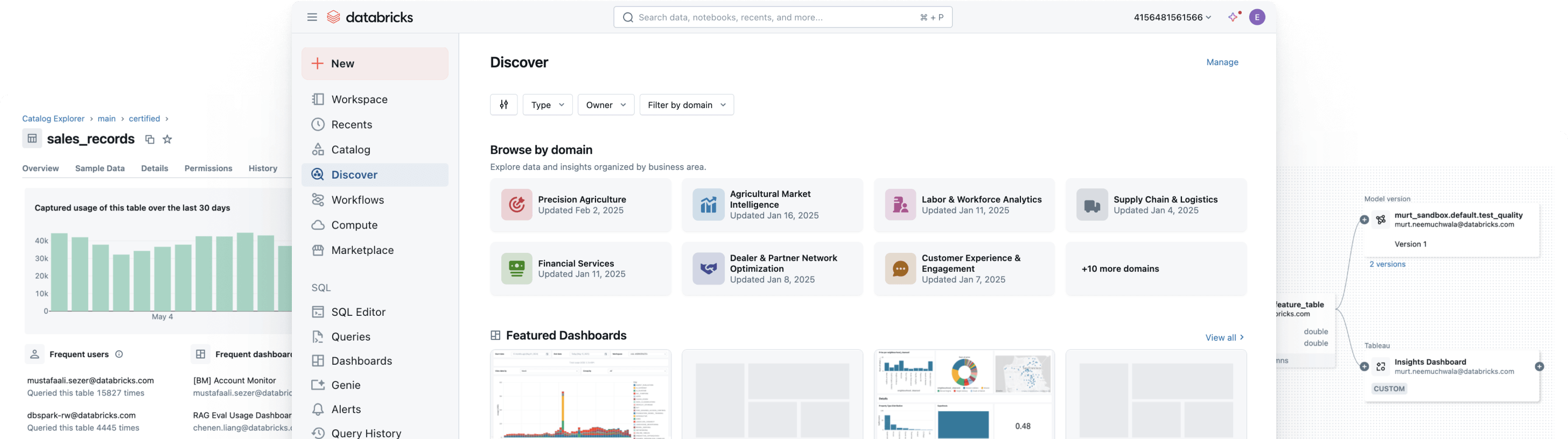

Vereinfachen Sie die Data Discovery, Compliance und Überwachung über Ihr gesamtes Daten- und KI-Portfolio hinweg mit intelligenter Governance.Einheitlicher Katalog für alle strukturierten Daten, unstrukturierten Daten, Geschäftskennzahlen und KI-Modelle über offene Datenformate wie Delta Lake, Apache Iceberg, Hudi, Parquet und mehr.

Weitere Funktionen

Maximieren Sie den Business Value Ihrer Daten durch konsistente, zentrale Governance.

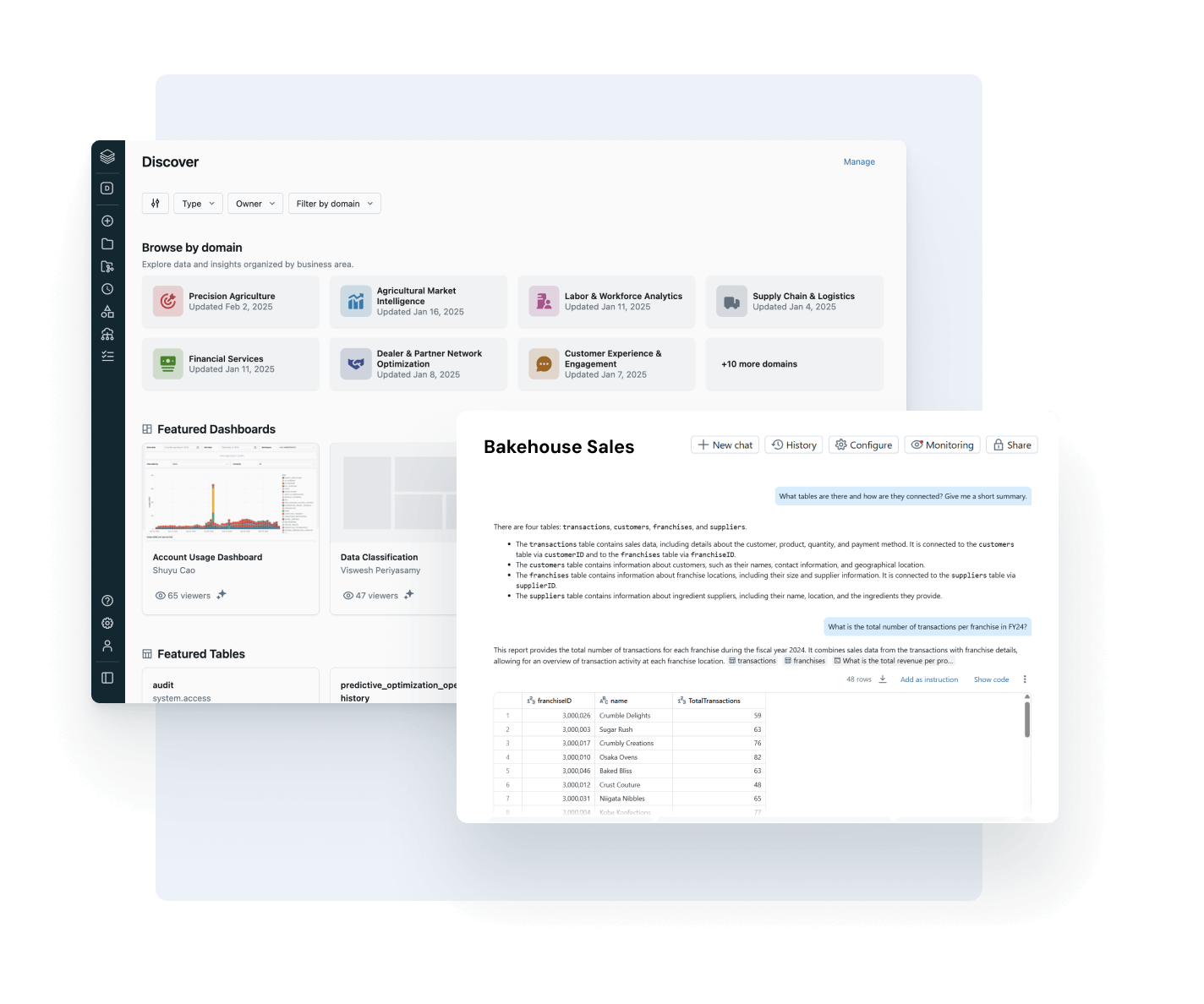

Befähigen Sie jeden Anwender, vertrauenswürdige, relevante Daten zu finden und zu nutzen.

Machen Sie Ihre wertvollsten Datenressourcen leicht auffindbar und verständlich – unternehmensweit.

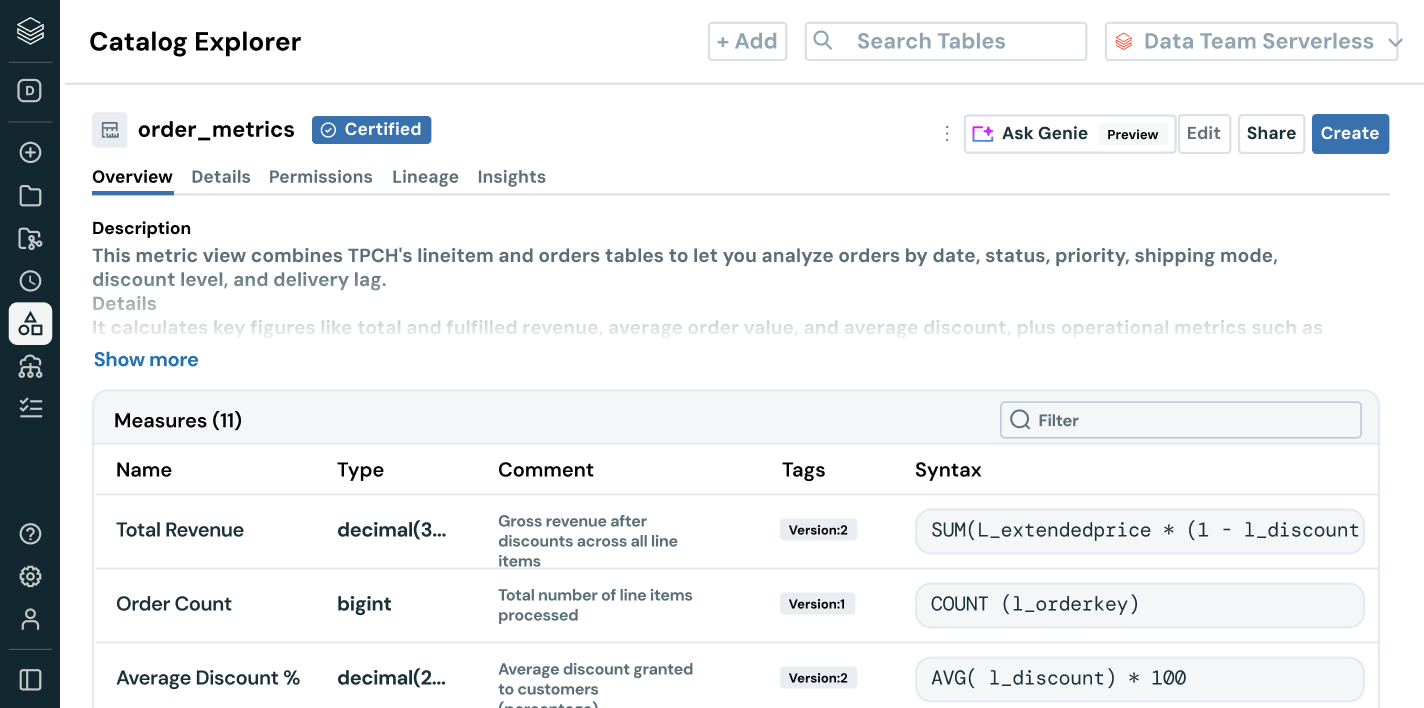

- Automatisch kuratierte Empfehlungen rücken verlässliche Datenressourcen mit hohem Mehrwert in den Fokus.

- KI-gestützte Dokumentation, Tags und Nutzungsanalysen liefern wertvollen Kontext.

- Gesteuerte Business-Semantik stellt konsistente und vertrauenswürdige Kennzahlen team- und toolübergreifend bereit.

- Die Konversations-Schnittstelle mit AI/BI Genie hilft Business-Anwendern bei der Datenexploration, ohne dass SQL erforderlich ist.

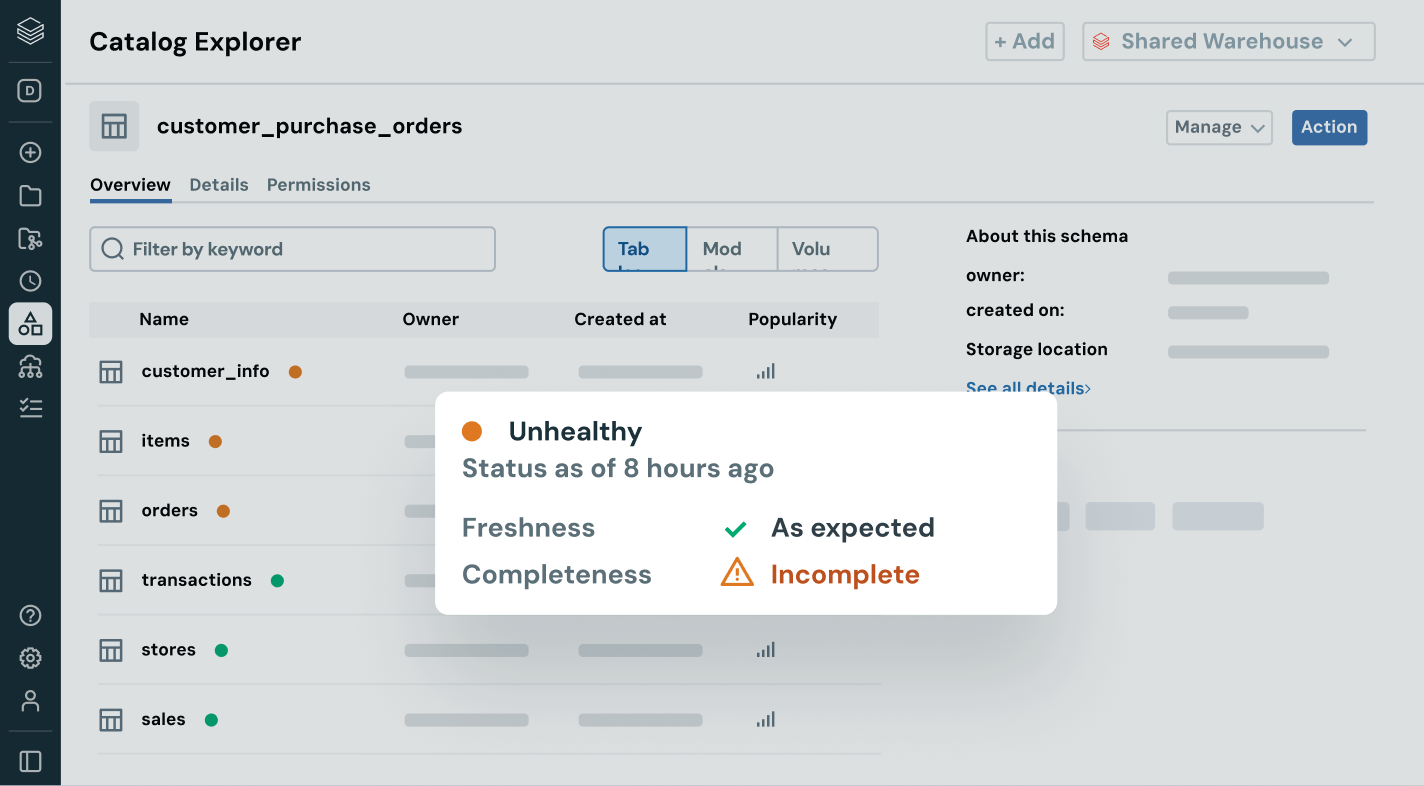

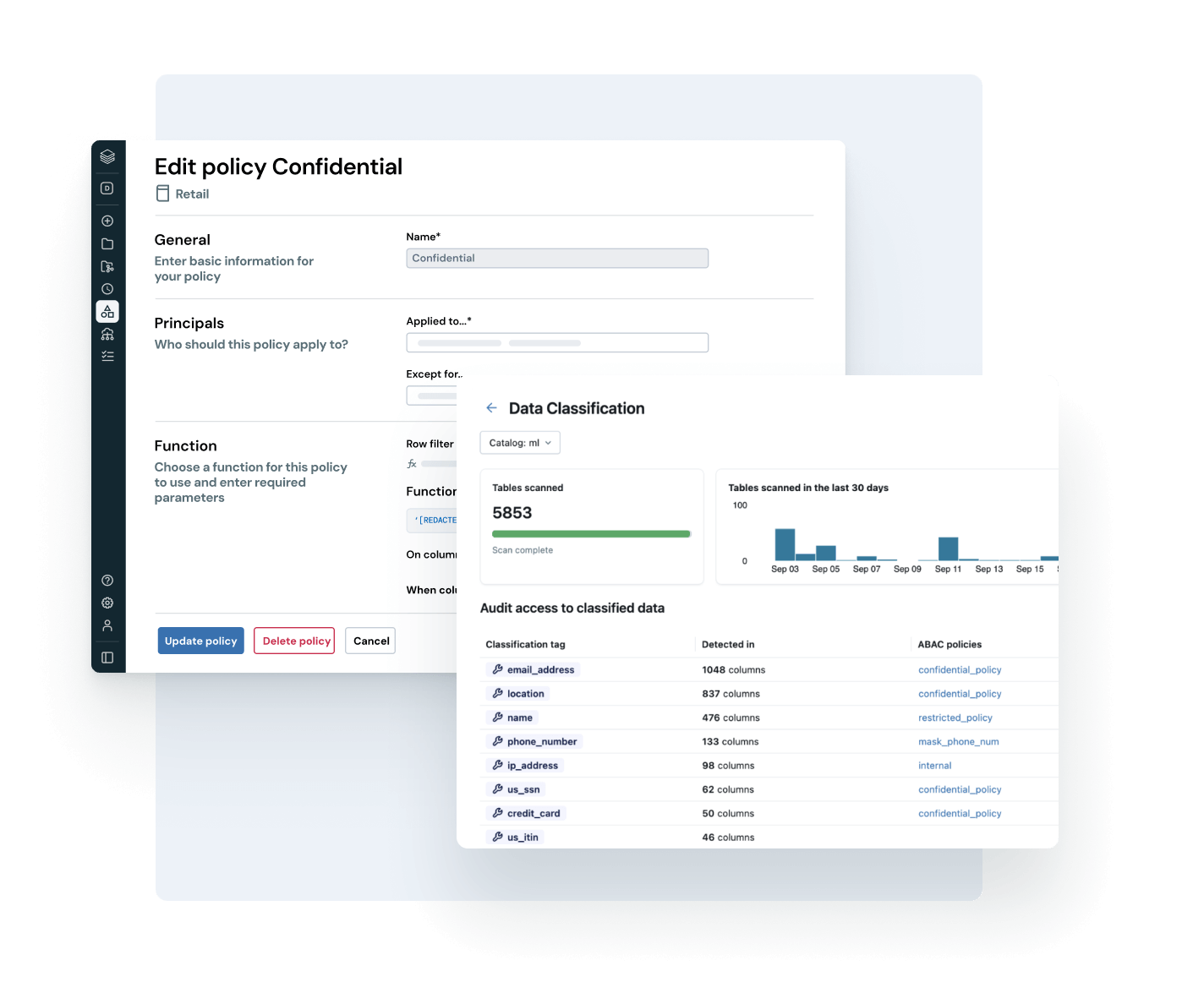

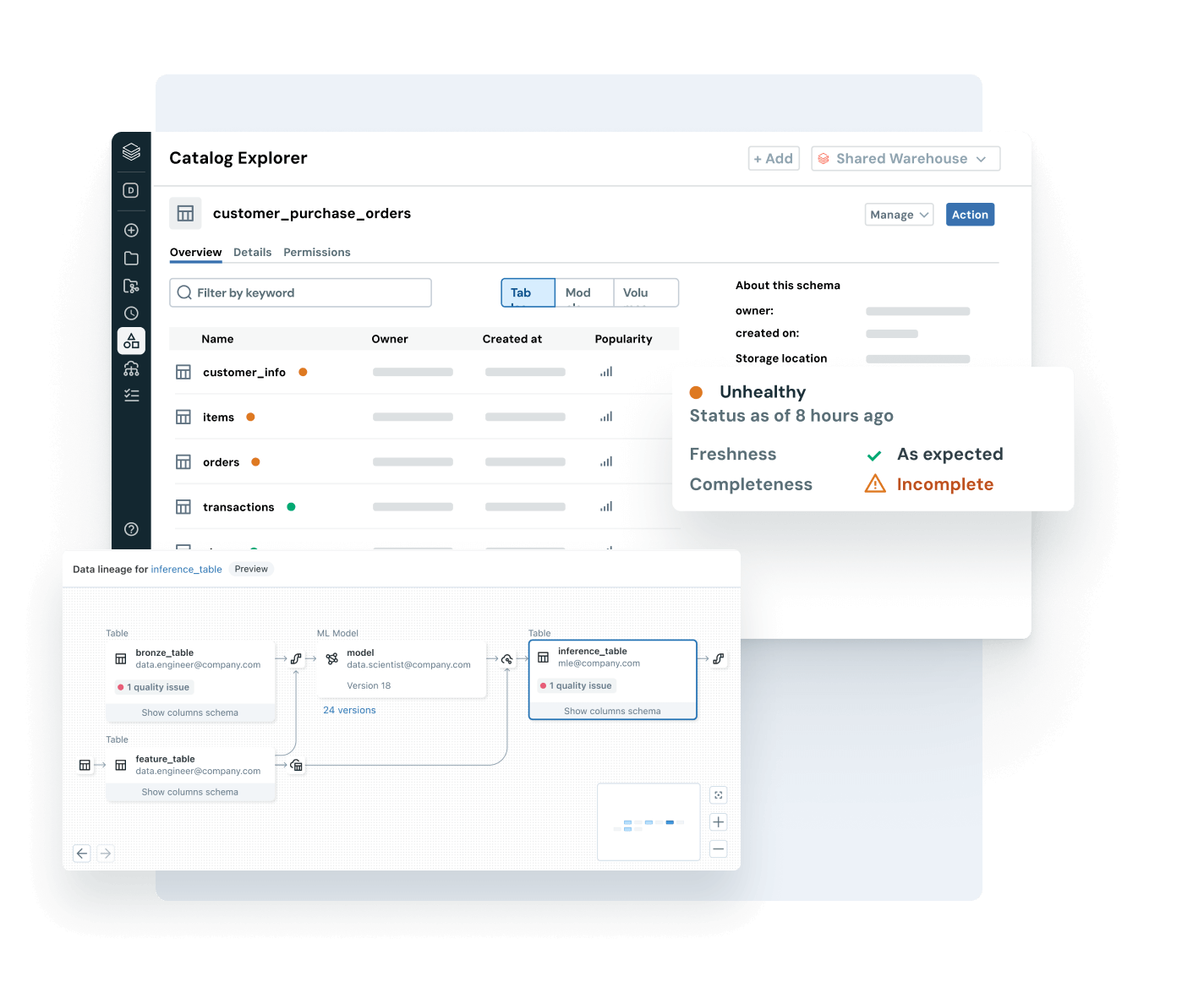

Stellen Sie sicher, dass die Daten, die Sie nutzen, aktuell, vollständig und vertrauenswürdig sind.

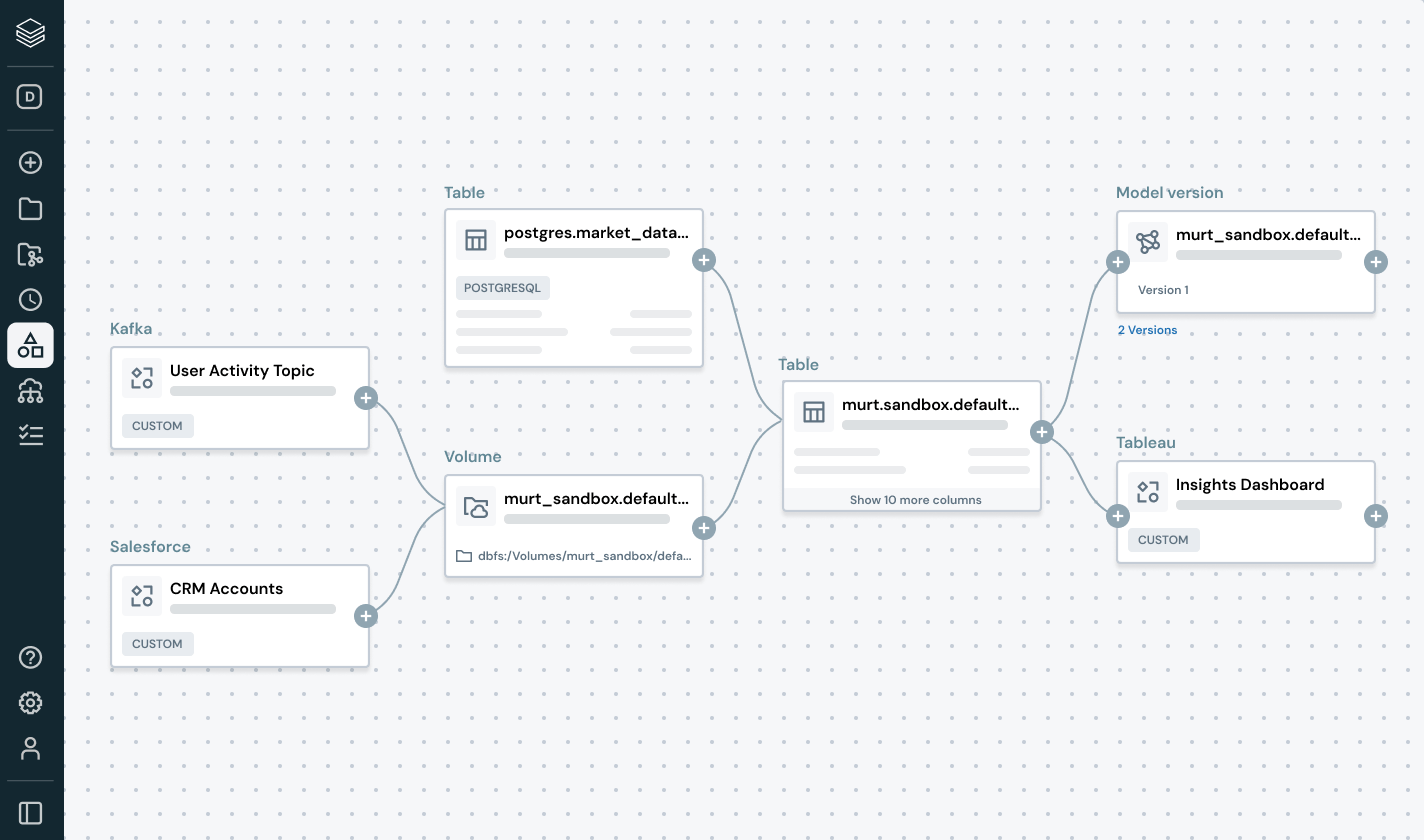

Erkennen und beheben Sie Datenprobleme proaktiv – mit vollständiger Transparenz über Herkunft und Qualitätssignale.

- Überwachen Sie die Datenqualität anhand von Aktualität, Vollständigkeit und Anomalieerkennung.

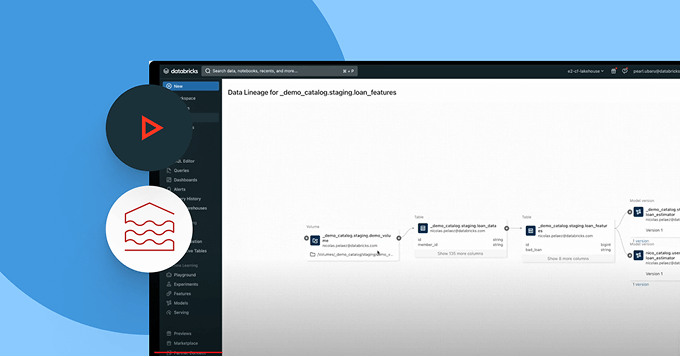

- Verfolgen Sie die Herkunft durchgängig über Pipelines, Modelle und Dashboards hinweg.

- Bewerten Sie die Auswirkungen von defekten Daten- und KI-Pipelines.

- Stärken Sie das Vertrauen, indem Sie Qualitätsinformationen neben jedem Asset anzeigen.

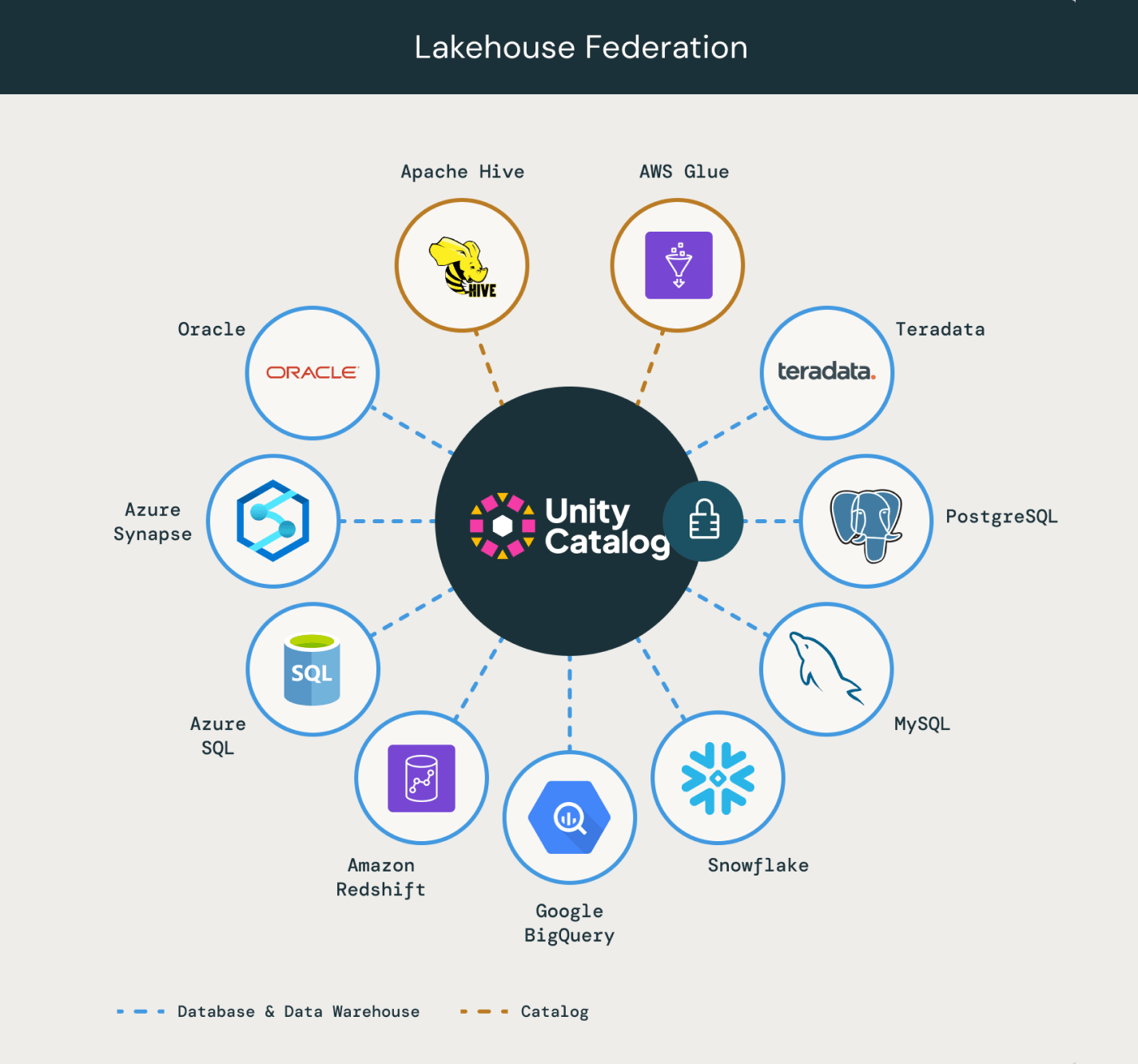

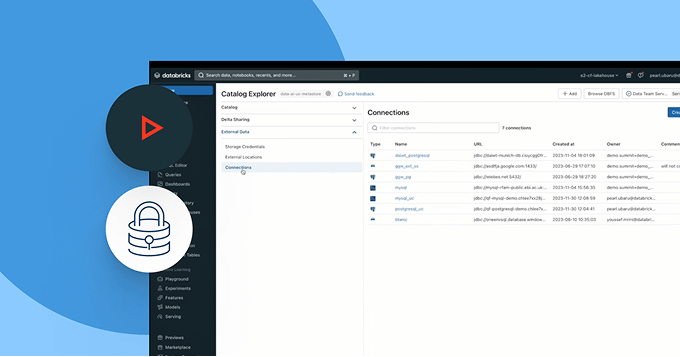

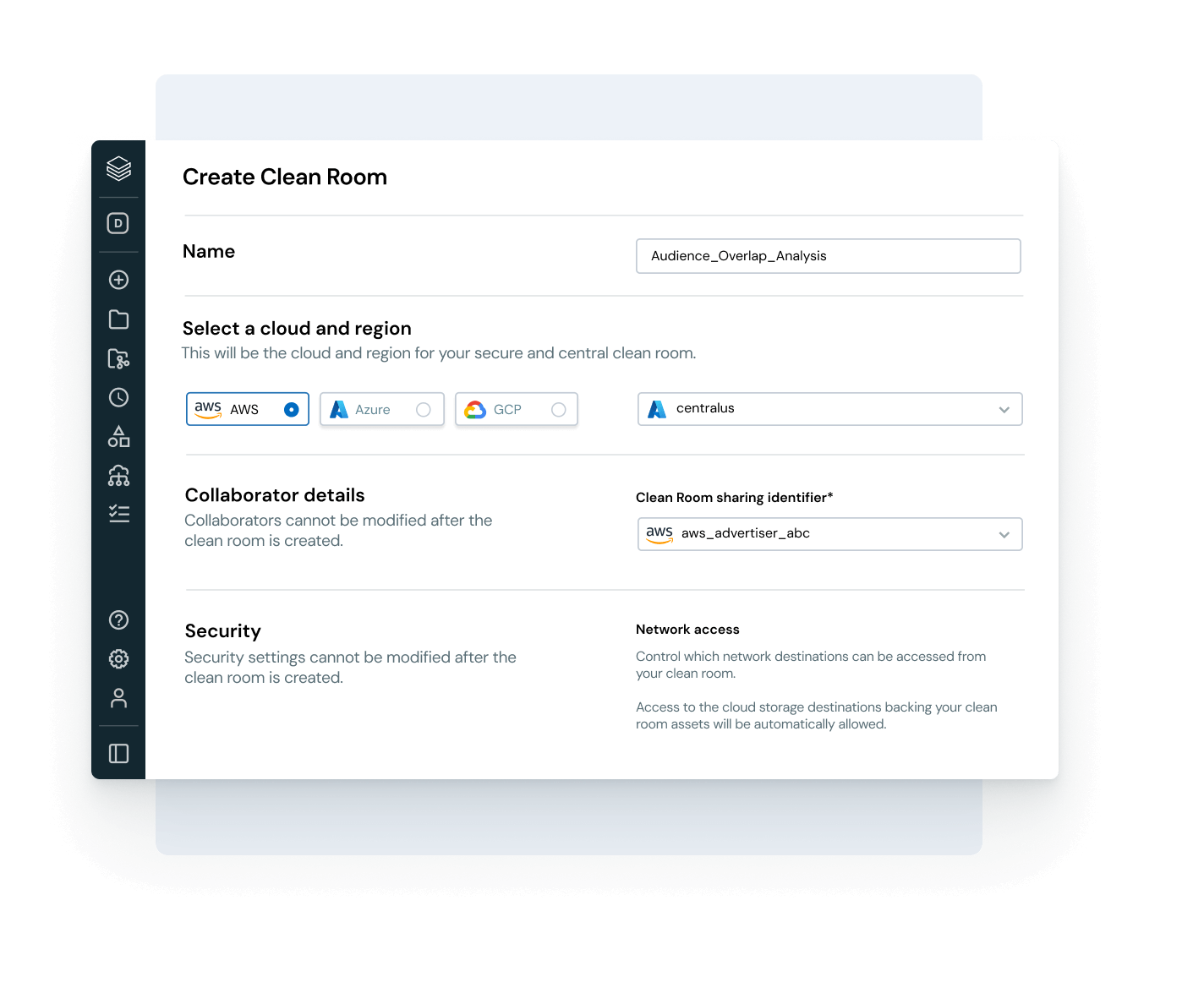

Ermöglichen Sie eine sichere, offene Zusammenarbeit über Clouds und Partner hinweg

Brechen Sie Silos auf und skalieren Sie Daten- und KI-Freigabe - mit vollständiger Kontrolle über die Governance.

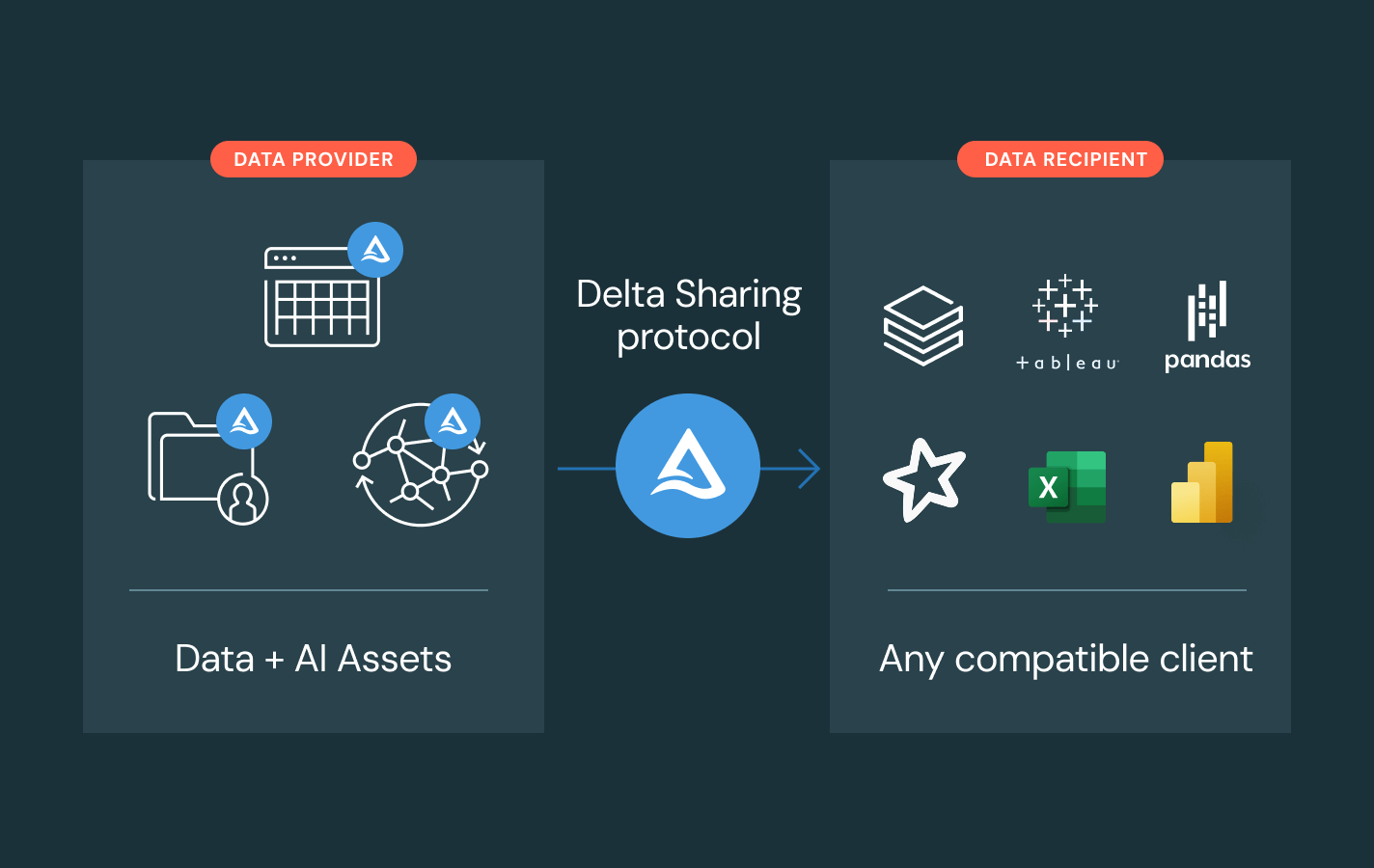

- Teilen Sie geregelte Daten und KI-Ressourcen mit Delta Sharing über Teams, Clouds oder Partner hinweg.

- Nutzen Sie Clean Rooms für sichere, datenschutzfreundliche Zusammenarbeit.

- Vermeiden Sie eine Bindung an einen bestimmten Anbieter durch offene Austauschstandards.

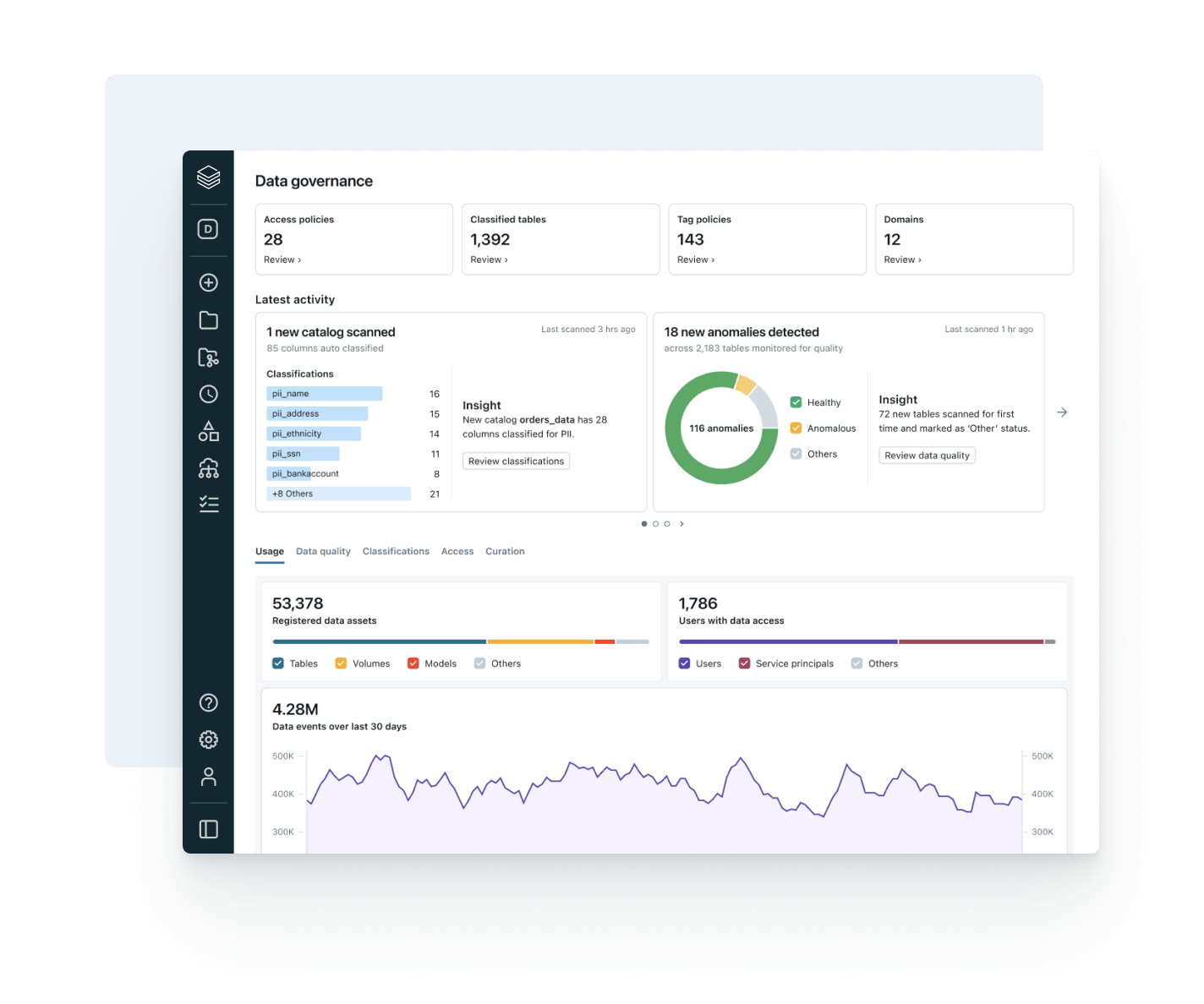

Stimmen Sie Datennutzung gezielt auf Geschäftswert und die Betriebskosten ab.

Nutzen Sie die integrierte Beobachtbarkeit, um Kosten zu optimieren, Governance-Akzeptanz zu fördern und den ROI zu erhöhen.

- Verfolgen Sie Datenverbrauchstrends über Benutzer, Teams und Geschäftsbereiche hinweg.

- Verknüpfen Sie Lineage mit Rechen- und Speicherverbrauch, um Optimierungspotenziale gezielt zu identifizieren.

- Überwachen Sie die Akzeptanz von Richtlinien und Datenzugriffsmuster in einer Benutzeroberfläche.

- Ermöglichen Sie Data Product Owners, den Wert ihrer Daten zu messen und transparent zu berichten.

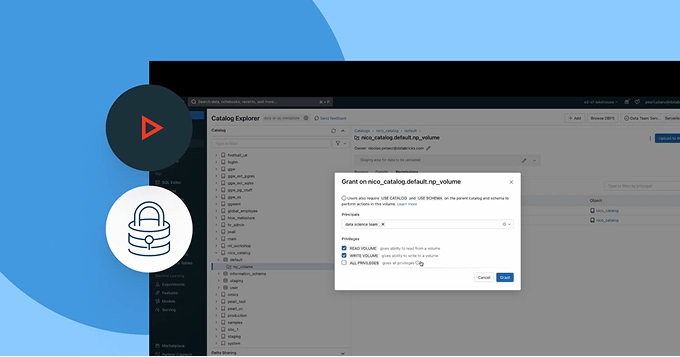

Erkunden Sie die Demos für Unity Catalog

Mehr entdecken

Erkunden Sie Produkte, die die Leistungsfähigkeit des Unity-Katalogs in den Bereichen Governance, Zusammenarbeit und Datenintelligenz erweitern.Databricks Clean Rooms

Analysieren Sie von mehreren Parteien freigegebene Daten, ohne direkten Zugriff auf die Rohdaten zu gewähren.

Databricks Marketplace

Ein offener Marktplatz für Daten sowie KI- und Analyseressourcen wie ML-Modelle oder Notebooks.

Delta-Freigabe

Ein Open-Source-Ansatz für die plattformübergreifende gemeinsame Daten- und KI-Nutzung. Geben Sie Livedaten mit zentralisierter Governance und ohne Replikation frei.

AI/BI Genie

Ein konversationelles Erlebnis, das von generativer KI gesteuert wird, das es Business-Teams ermöglicht, Daten in Echtzeit per natürlicher Sprache zu durchsuchen und eigenständig Insights abzurufen.

Databricks Assistant

Beschreiben Sie Ihre Aufgabe in natürlicher Sprache und lassen Sie Assistant SQL-Abfragen erstellen, komplexen Code erläutern und Fehler automatisch beheben.

Databricks Data Intelligence-Plattform

Entdecken Sie die gesamte Bandbreite der auf der Databricks Data Intelligence Platform verfügbaren Tools zur nahtlosen Integration von Daten und KI in Ihrem Unternehmen.

Wagen Sie den nächsten Schritt

Erkunden Sie die Dokumentation von Unity Catalog

Erhalten Sie detaillierte Anleitungen zu Funktionen, Einrichtung und Best Practices in der Unity Catalog-Dokumentation für AWS, Azure und GCP.

Erkunden Sie Produkt-Demos

Sehen Sie sich Demos zu Unity Catalog an, um zu erfahren, wie Sie Daten und AI-Assets in Ihrem gesamten Bestand steuern, entdecken und teilen können.

Unity Catalog FAQ

Möchten Sie ein Daten- und KI-Unternehmen werden?

Machen Sie die ersten Schritte Ihrer Datentransformation