Effiziente Datenaufnahme in Ihr Lakehouse

Machen Sie den ersten Schritt, um Innovation mit Datenintelligenz freizuschalten.

Schöpfen Sie Wert aus Ihren Daten in nur wenigen einfachen Schritten

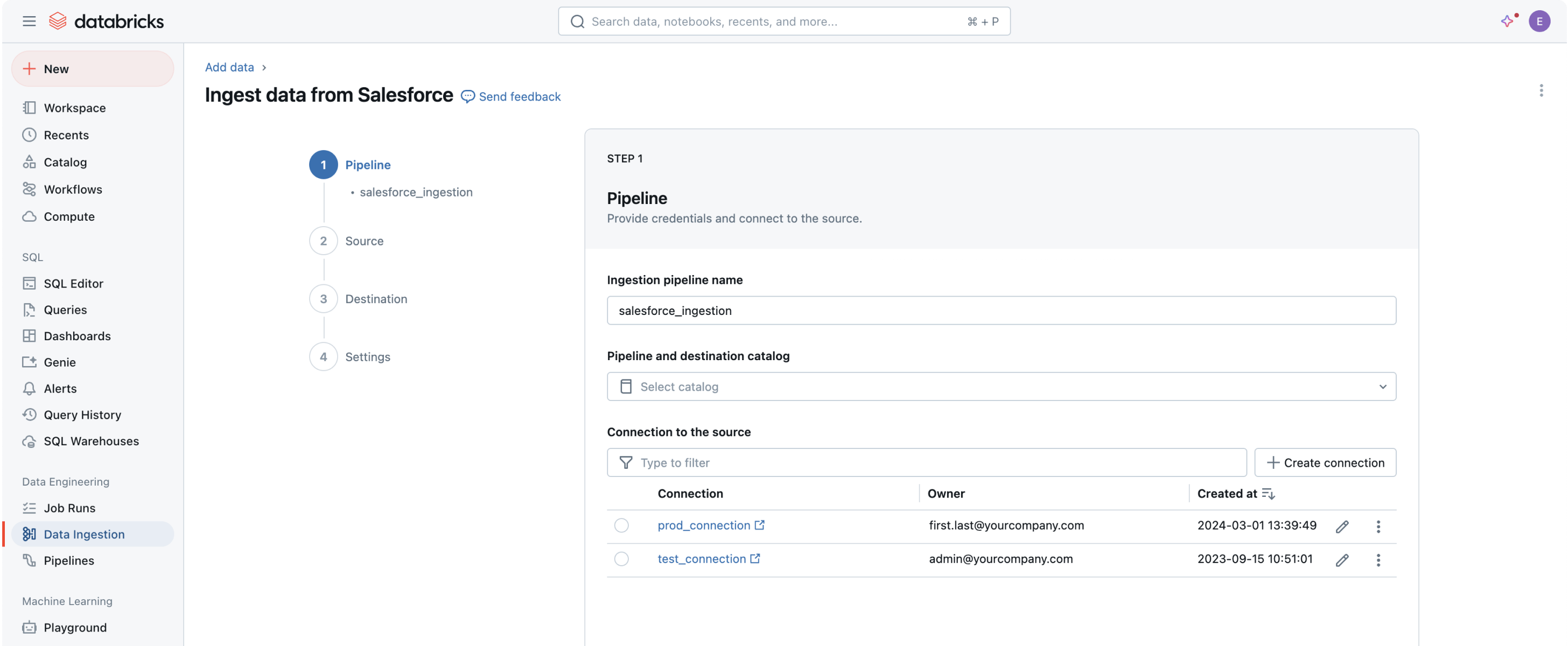

Eingebaute Datenverbindungen sind für beliebte Unternehmensanwendungen, Dateiquellen und Datenbanken verfügbar.Robuste Zuführungsfähigkeiten für beliebte Datenquellen

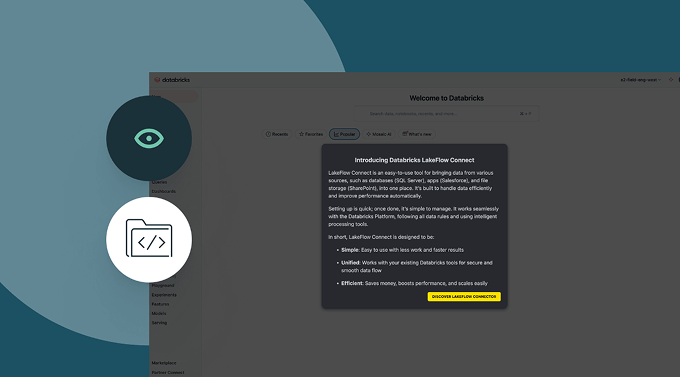

Alle Ihre Daten in die Data Intelligence Plattform zu bringen, ist der erste Schritt, um Wert zu extrahieren und die herausforderndsten Datenprobleme Ihrer Organisation zu lösen.Eine No-Code-Benutzeroberfläche (UI) oder eine einfache API ermöglicht es Datenprofis, sich selbst zu bedienen und spart Stunden an Programmierung.

Datenaufnahme mit Databricks

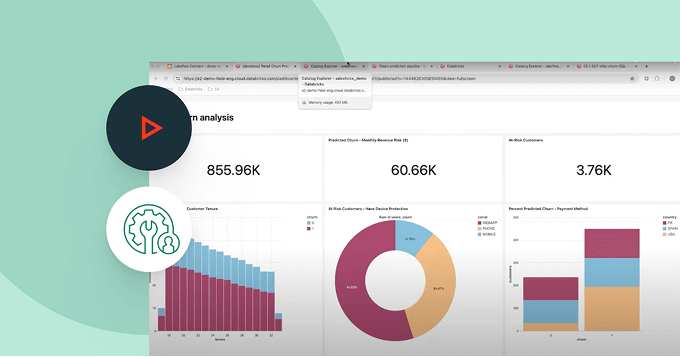

Lösung von Kundenproblemen in einer Reihe von Branchen

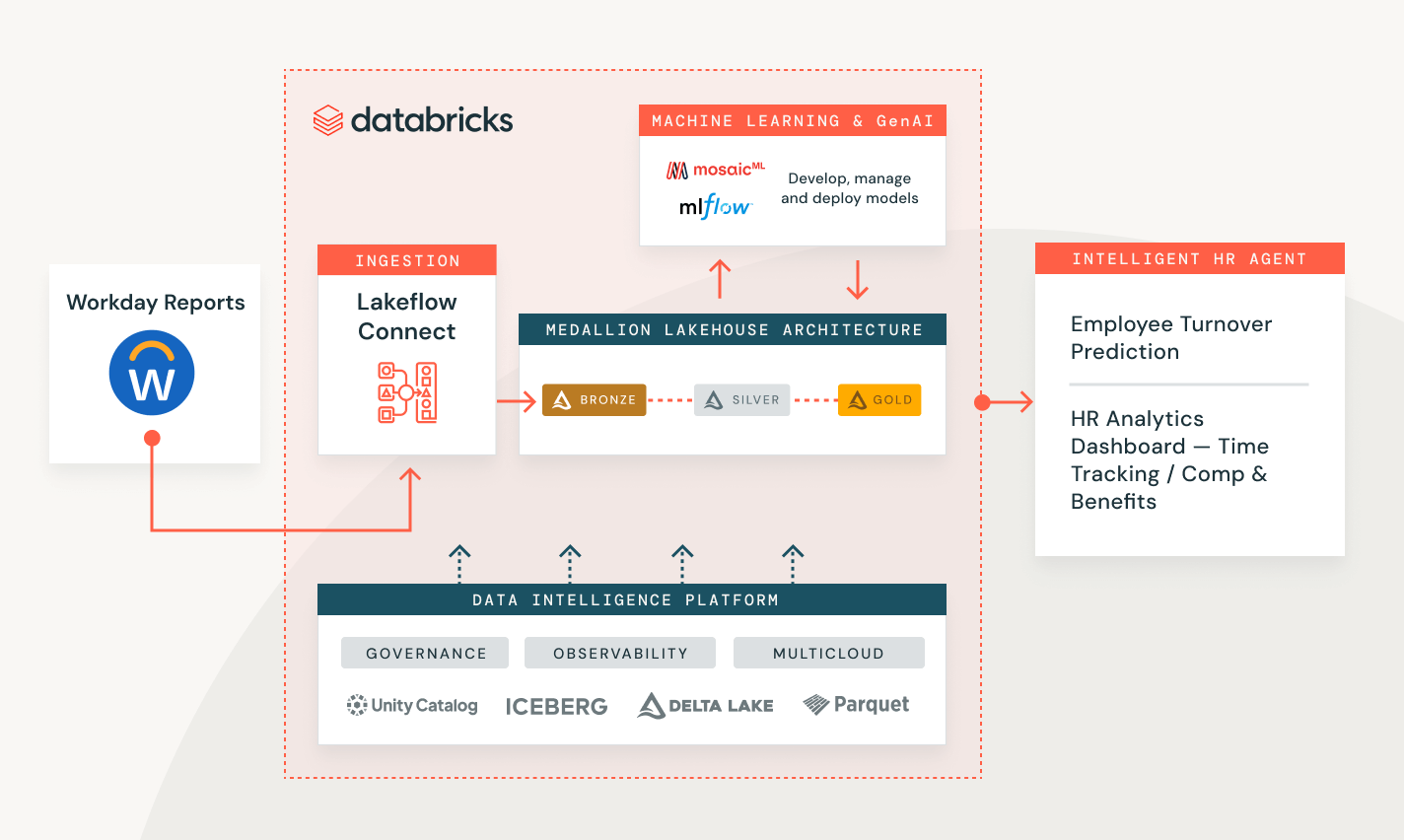

Verstehen Sie die Belegschaft Ihrer Organisation besser mit ganzheitlichen, dynamischen Dashboards

Verwalten Sie Mitarbeiterbesetzung, Zeiterfassung, Vergütung und Vorteile mit einer zentralisierten Datenplattform zur Analyse.

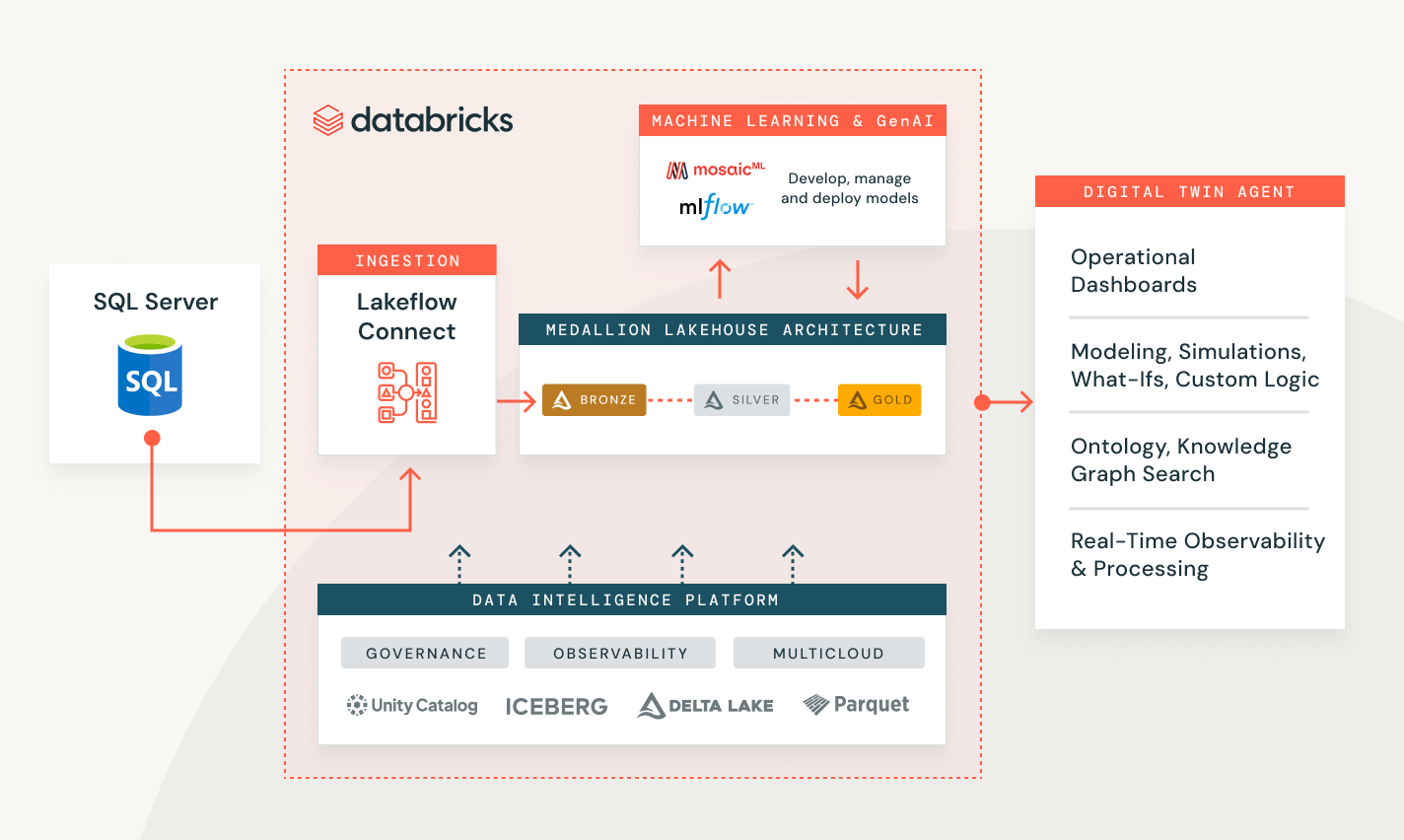

Steigern Sie die betriebliche Effizienz in der Fertigung

Nutzen Sie IoT-Sensordaten für nahezu Echtzeit-Zugriff auf strukturelle und betriebliche Ansichten, die dabei helfen, mehrere nachgelagerte Anwendungen für die Optimierung im großen Maßstab zu aktualisieren.

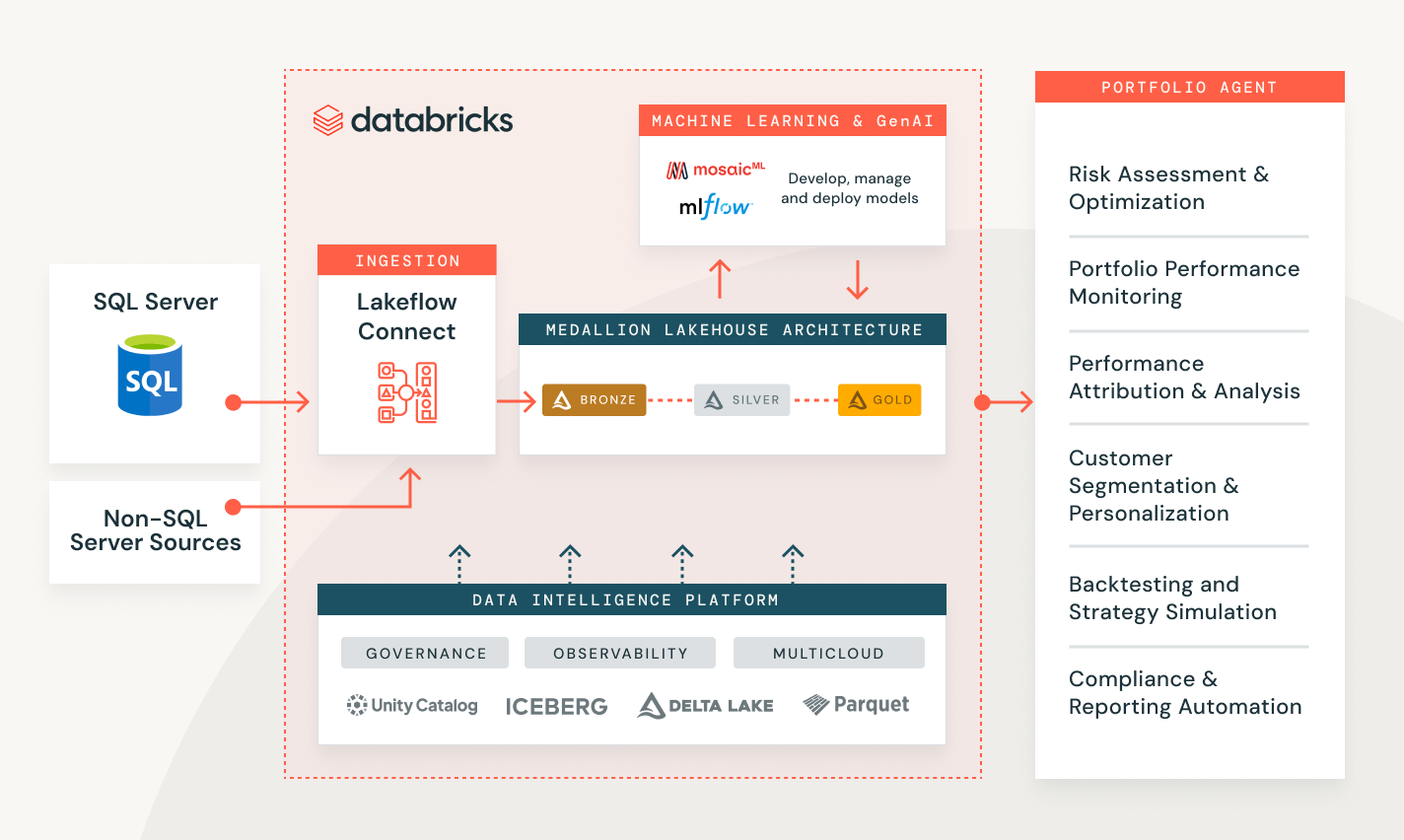

Erzielen Sie eine höhere Rendite (ROI) mit datengesteuerten Anlagestrategien

Konsolidieren Sie alle Ihre Finanzdatenquellen, einschließlich Kapitalmärkte für historische und Prognosemodelle.

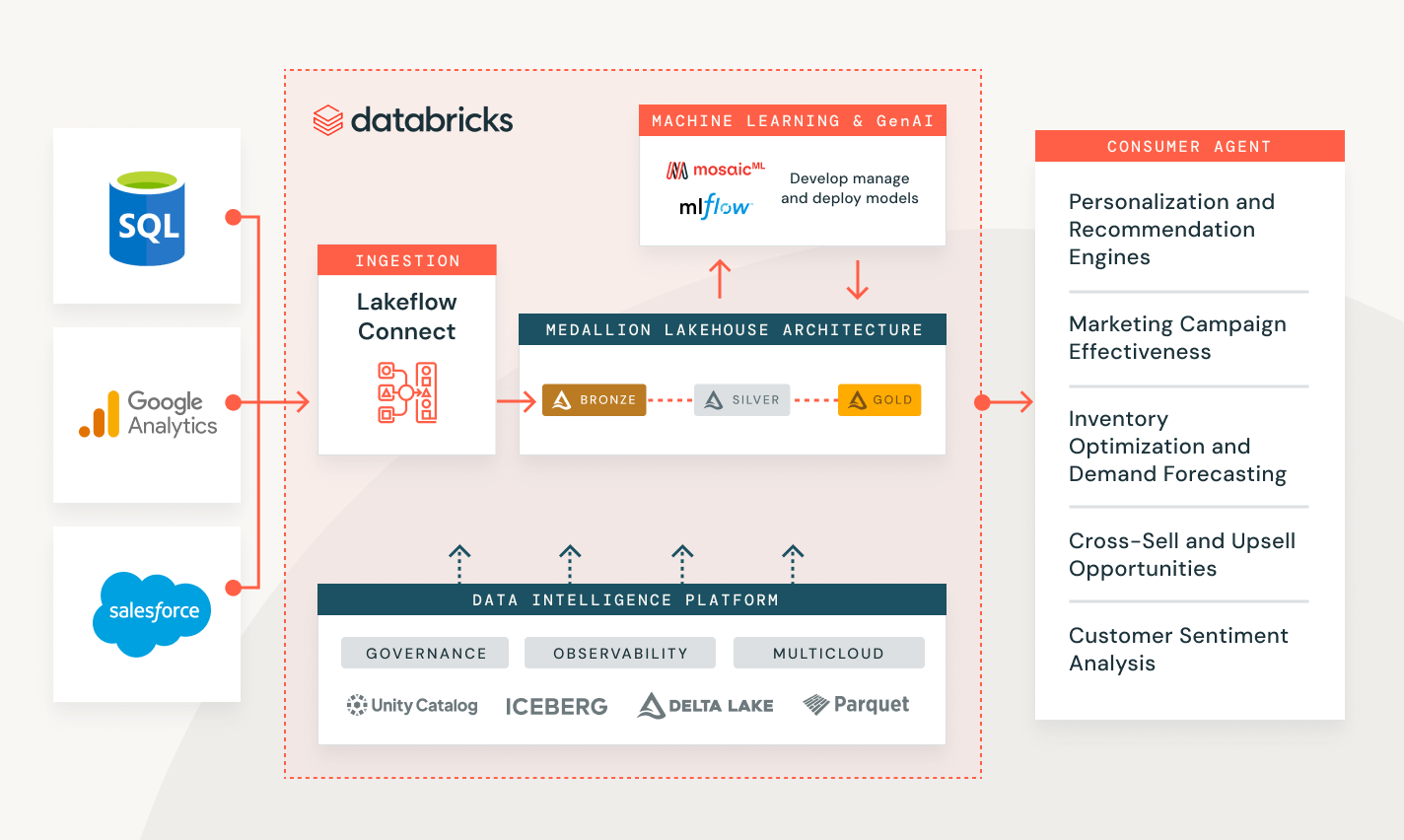

Personalisieren Sie Einkaufserlebnisse basierend auf den Vorlieben der Kunden.

Greifen Sie in nahezu Echtzeit auf alle Berührungspunkte des Verbrauchereinkaufs zu, einschließlich aggregiertem Inventar, Verkauf für Empfehlungen und gezielte Werbeaktionen.

Erkunden Sie Demos zur Datenaufnahme

Ausgaben im Griff dank nutzungsbasierter Abrechnung

Sie zahlen nur für die Produkte, die Sie tatsächlich nutzen – und das sekundengenau.Mehr entdecken

Entdecken Sie weitere integrierte, intelligente Angebote auf der Data Intelligence Platform.Lakeflow Jobs

Statten Sie Teams besser aus, um jeden ETL-, Analyse- und KI-Workflow mit tiefer Observability, hoher Zuverlässigkeit und breiter Unterstützung für verschiedene Aufgaben zu automatisieren und zu orchestrieren.

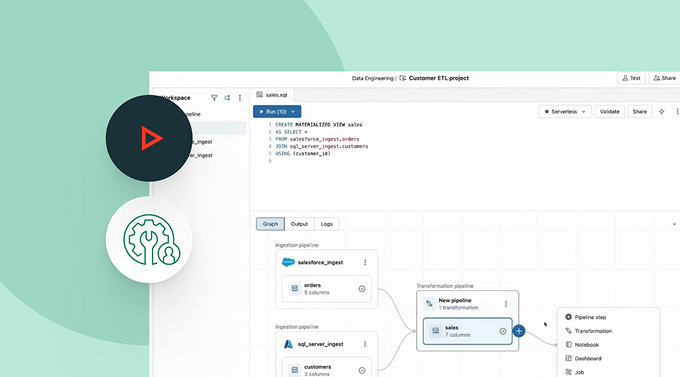

Spark Declarative Pipelines

Vereinfachen Sie Batch- und Streaming-ETL mit automatisierter Datenqualität, Change Data Capture (CDC), Datenaufnahme, Transformation und einheitlicher Governance.

Unity Catalog

Regulieren Sie alle Ihre Datenressourcen nahtlos mit der branchenweit einzigen einheitlichen und offenen Governance-Lösung für Daten und KI, die in die Data Intelligence Platform von Databricks integriert ist.

Delta Lake

Vereinheitlichen Sie die Daten in Ihrem Lakehouse format- und typenübergreifend für alle Ihre Analytics- und KI-Workloads.

Erste Schritte

Erkunden Sie die Dokumentation zur Datenaufnahme

Nehmen Sie Daten aus verschiedenen Quellen auf, über verschiedene Clouds hinweg und über Lakeflow Connect.

Tour Lakeflow Connect

Lakeflow Connect ist jetzt allgemein verfügbar für Salesforce, Workday und SQL Server.

Für eine Vorschau auf andere Connectoren wenden Sie sich bitte an Ihr Databricks-Kontoteam.

FAQ zur Datenaufnahme

Möchten Sie ein Daten- und KI-Unternehmen werden?

Machen Sie die ersten Schritte Ihrer Datentransformation