カスタマーサービスとサポートで大規模言語モデル革命を推進する

Original : Driving a Large Language Model Revolution in Customer Service and Support

翻訳: junichi.maruyama

独自のLLM対応ボットを作りたいですか?エンドツーエンドのソリューションアクセラレータをこちらからダウンロードしてください

OpenAI’s ChatGPT, Google’s Bard や今回の MosaicML’s MPT.のような大規模言語モデル(LLM)の可能性に、ビジネスリーダーは誰もが期待しています。大量のテキストを消化し、その情報に基づいて新しいコンテンツを生成するその能力は、既存のビジネスプロセスを幅広く変革し、これまで人間の専門家が独占していた多くのタスクのスピード、スケール、一貫性を向上させる可能性を秘めています。

この興奮は、エージェント主導のサービスやサポートに依存する分野ほど顕著に感じられるものはありません。このようなテクノロジーが登場する以前は、組織は、企業のさまざまな方針や手順を構成する膨大な文書に精通し、訓練を受けた多数の個人に依存していました。エージェントの担当者は、ルールに従って対応するだけでなく、時にはルールを解釈してドキュメントに明示されていないエッジケースに対応する能力も必要とされました。

代理店のスピードアップには、時間がかかることが多い。 離職率が高いこともあり、こうしたプロセスを支えるさまざまなコールセンターやサポートデスクの人員確保は、以前から課題として認識されていました。 オンラインナレッジベース、対話型音声応答システム(IVR)、前世代のチャットボットにリクエストを委ねる試みは、これらのサービスの消費者に不満や不十分なサービスを与えることが多かった。

しかし、人間のエージェントを訓練するために使用されるのと同じ文書から抽出された知識を組み合わせた事前訓練済みのLLMは、瞬時にスピードアップし、消費者�の需要に完全に一致する規模で展開することができます。これらのモデルは、決して疲れることなく、不運に見舞われることもなく、また、決して失敗することもありません。 この技術の初期段階では、サービスやサポートのやり取りをLLMベースのエージェントに直接任せることはお勧めできませんが、これらの機能は今日、人間のエージェントを補強し、作業のスピード、効率、一貫性、正確性を向上させる指導やサポートを提供し、立ち上げまでの時間を短縮することが完全に可能になっています。 つまり、LLMは、企業がサポートサービスを提供する方法を変革する態勢を整えているのです。

権威ある回答には、企業特有のコンテンツが必要です

このトピックを取り巻く会話では、大規模な言語モデルそのものに注目が集まっていますが、現実には、言語モデルが生成するアウトプットの質は、言語モデルが消費するコンテンツに依存しています。 ほとんどのモデルは、最初に大量の一般的な情報を与えられ、ユーザーのプロンプトや質問に対して、よく練られた、しばしば驚くほど人間的な応答を提供することができます。しかし、LLMが特定の企業で採用されている特定のポリシーや手順に合わせた応答を生成するためには、その詳細を提示し、それらの文書によって形成される特定の文脈の中で応答することを課されなければなりません。

本研究で設計されたほとんどのLLMベースのエージェント(ボット)が採用した戦略は、一般的な指示セットを提供することで、関連文書と判断された文脈から、ユーザーから発せられた質問に対して、フレンドリーで親切でプロフェッショナルな応答を生成することをモデルに課するものです。この3つのパートからなる応答生成のアプローチは、システムの指示とユーザーの質問、関連文書を組み合わせたもので、ボットが組織の期待に沿った応答を合成することを可能にします。

コンテンツマネジメントは最も切実な課題

そこで問題になるのが、与えられた質問に関連する文書をどのように特定するのがベストか、ということです。このトピックに関する技術的な話題の多くは、文書を数値ベクトル(埋め込み)に変換し、高速な類似性検索を実行する戦略に傾きがちですが、主要な課題は、より組織的なものです。

長年にわたり、IT専門家はさまざまな分析機能をサポートするために大規模なデータレポジトリを構築してきましたが、その取り組みの大部分は、さまざまな業務システムを通じて収集された高度に構造化されたデータに焦点を当てていました。データマネジメントとアナリティクスに対するより広範なアプローチの支持者は、組織の情報の80~90%がメッセージ、ドキュメント、オーディオ、ビデオファイルに存在することを当然のように訴えた。

今日、LLMを使った権威ある回答生成のためのコンテキストを提供するために必要な非構造化データ資産は、企業内に散在しています。そのため、組織は生成技術を活用する最善の方法を議論する一方で、関連する非構造化データ資産を集中管理するための戦略を積極的に定義し、ソリューションが承認された時点で、組織が行動できる状態にする必要があります。

Databricksは構造化データと非構造化データの両方に最適なソリューションです

Databricksは、アナリティクスとデータ管理について、より広範な視野を持つことを長年提唱してきました。 私たちの統一されたレイクハウス・プラットフォームを通じて、構造化・非構造化を問わず、すべての情報資産を活用するための一貫した、拡張可能で費用対効果の高い方法を組織に提供することに重点を置いています。これは単なるデータの収集と処理にとどまらず、セキュリティ、ガバナンス、コラボレーションのための豊富な機能を含んでいます。Databricksは、LLMの成功のための基盤を構築するための理想的なプラットフォームであると私たちは信じています。

そして、私たちの能力は、単なるデータ管理にとどまりません。 Databricksは、従来のビジネスアナリティクスに加え、機械学習やAIを受け入れてきた長い歴史があります。 お客様のデータの全領域を管理するための統一されたプラットフォームを提供するのと同様に、ビジネスアナリスト、データサイエンティスト、アプリケーション開発者にも、それが収容するデータの可能性を最大限に引き出すための強力なプラットフォームを提供しています。

このような幅広い機能をサポートするための鍵は、オープンソースのイノベーションを受け入れていることです。 Databricksは、オープンプラットフォームとして一から構築されており、組織は、適切に管理されたデータ基盤を維持しながら、オープンソースコミュニティから生まれた最新かつ最高の機能を活用するために、分析作業を迅速にピボットできるようにします。 そして、このオープンソースの受け入れは、LLMが占める空間ほど大きな影響を与えることはないでしょう。

オープンソースを取り入れることは重要です

最近、プロプライエタリなLLMのイノベーションが盛んですが、私たちや他の多くの人々は、この分野におけるオープンソースコミュニティの急速な台頭を認識しています。最近流出したメモの中で、Googleの上級社員が「我々には堀がないが、OpenAIも同様だ」と嘆いている。OpenAIやGoogleなどのイノベーションは、この分野に集中する初期のスポットライトの多くを吸収していますが、現実には、オープンソースコミュニティはすでに、多くの主流企業がこれらの技術を採用するのを妨げてきた多くの厄介な問題を迅速にキャッチアップして解決する能力を実証しています。ですから、今日、私たちは、これらのクローズドソースソリューションが提供するイノベーションを認識しながらも、ベンダーロックインを避けることによって、組織が今後数年間で方針を転換する柔軟性を保持することが重要であると考えています。

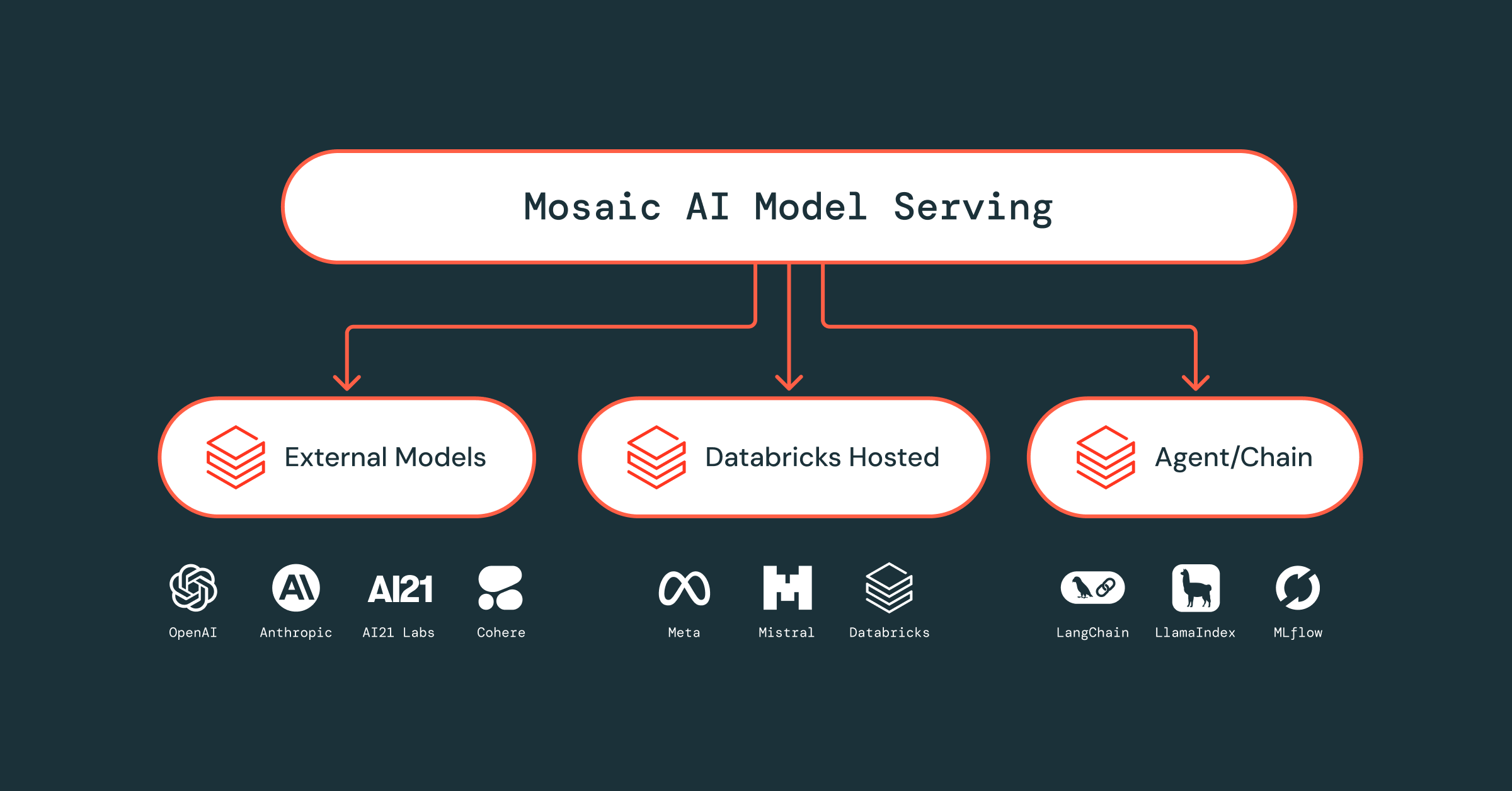

すでに、LLMベースのアプリケーションを開発するための新しい標準が登場しており、Databricksはこれらのサポートをプラットフォーム内に統合しています。 LLMコミュニティが右往左往する中で、企業が情報資産をこれらの技術で容易に接続できるように、今後もさらなる機能強化が行われる予定です。

これは、LLMコミュニティがどこに向かっているのかを受動的に観察するのではなく、この分野のリーダーだと思われている人たちの考え方に直接挑戦する場面も含めて、対話に積極的に参加することで推進されています。 私たちは、社内やお客様とともに、LLMをベースにした数々のソリューションの開発に積極的に取り組んでいます。そして、可能な限り、LLMベースのソリューションがどのように構築されるかを示すコードを無料で公開し続けます。

今すぐLLMベースのチャットボットを構築する

そこで、上記のようなコンテキストに対応したLLMベースのチャットボットソリューションの構築方法を紹介します。 私たちは、私たち自身のナレッジベース(ユーザーが私たちの仕事を再現できるように公開されている)のコンテンツを使用して、LLM技術を活用してカスタマーサポートの質問に対応できるソリューションを構築しました。データ準備、エージェント開発、マイクロサービスへのデプロイなど、この作業の背後にあるステップバイステップのコードは、エージェントを任意の数のアプリケーションに統合することができます(私たちは、このソリューションの内部ビルドをSlackに統合しました)

これらの資産をダウンロードし、Databricksの担当者に連絡して�、LLMをお客様のビジネスプロセスにどのように統合するのが最適かを相談してください。