Databricks上のMeta Llama 3.2の紹介:高速な言語モデルと強力なマルチモーダルモデル

新しいLlama 3.2モデルをチューニングして、エンタープライズのユースケースに対して高品質かつ高速を実現します

公開日: September 25, 2024

によって ダニエル・キング、Hanlin Tang、Patrick Wendell(パトリック・ウェンデル) による投稿

Metaとのパートナーシップを通じて、Llama 3シリーズの最新モデルをDatabricks Data Intelligence Platformでローンチすることを楽しみにしています。このLlama 3.2リリースの小型テキストモデルは、顧客が高速なリアルタイムシステムを構築することを可能にし、大型のマルチモーダルモデルは、Llamaモデルが視覚理解を獲得する初めてのマークです。 両方とも、Databricksの顧客が複合AIシステムを構築するための重要なコンポーネントを提供し、これらのモデルを企業データに接続してデータインテリジェンスを可能にします。

Llamaシリーズの他のモデルと同様に、Llama 3.2モデルは今日からDatabricks Mosaic AIで利用可能で、あなたのデータで安全かつ効率的にチューニングすることができ、簡単にMosaic AI ゲートウェイ と エージェントフレームワークにプラグインすることができます。

今日からDatabricksでLlama 3.2��を使い始めましょう!モデルをデプロイするそして、それをMosaic AI Playgroundで使用し、Mosaic AI Model Trainingを使用して、モデルを自分のデータにカスタマイズします。MetaとDatabricksからのLlama 3.2について深く掘り下げるためのウェビナーに登録してください。

今年、Llamaは10倍の成長を達成し、オープンソースモデルがイノベーションを推進するという私たちの信念をさらに支持しました。Databricks Mosaic AIソリューションと共に、新しいLlama 3.2モデルは、企業の独自データを正確かつ安全に処理することで、組織がデータインテリジェンスを構��築するのを支援します。Databricksとの連携を続け、企業が自社のAIシステムを自社のエンタープライズデータでカスタマイズするのを支援することを楽しみにしています。- アフマド・アルダーレ、GenAI部門長、Meta

Llama 3.2の新機能は何ですか?

Llama 3.2シリーズには、超低レイテンシを必要とするユースケース向けの小型モデルと、新たな視覚理解ユースケースを可能にするマルチモーダルモデルが含まれています。

- Llama-3.2-1B-Instruct とLlama-3.2-3B-Instructは、低レイテンシーと低コストのエンタープライズユースケースのために特別に作られています。彼らは「単純な」タスク、例えばエンティティ抽出、多言語翻訳、要約、RAGなどに優れています。あなたのデータでのチューニングにより、これらのモデルはあなたのビジネスに関連する特定のタスクのための迅速で安価な代替手段となります。

- Llama-3.2-11B-Vision-Instruct と Llama-3.2-90B-Vision-Instruct 企業が強力でオープンなLlamaシリーズを視覚理解タスク、例えばドキュメントの解析や商品説明の生成などに使用できるようにします。

- マルチモーダルモデルには、新しいLlamaガード安全モデル、Llama-Guard-3-11B-Visionが付属しており、マルチモーダルアプリケーションの責任あるデプロイを可能にします。

- すべてのモデルは、超長いドキュメントを処理するために、Llama 3.1シリーズの拡張された128kのコンテキスト長をサポートしています。長いコンテキストは、チャンキングと検索への依存を減らすことで、RAGとエージェンティックなアプリケーションの品質を向上させ、簡素化します。

さらに、Metaは Llama Stackというソフトウェアレイヤーをリリースし、アプリケーションの構築を容易にします。Databricksは、そのAPIをLlama Stackに統合することを楽しみにしています。

より速く、より安価に

Llama 3.2シリーズの新しい小型モデルは、レイテンシとコストに敏感なユースケースにとって優れた新しいオプションを提供します。一般的なAIモデルの全能力を必要としない多くの生成型AIユースケースがあり、データに対するデータインテリジェンスと組み合わせることで、コード補完、リアルタイムの要約、大量のエンティティ抽出など、低レイテンシまたは低コストが必要な新しいユースケースを開くことができます。これはUnity Catalogでアクセス可能で、Databricksで構築したアプリケーションに新しいモデルを簡単にスワップすることができます。特定のタスクでモデルの品質を向上させるために、Meta Llama 3.1 405Bのようなより強力なモデルを使用して、少数のシード例から合成訓練データを生成し、その合成訓練データを使用してLlama 3.2 1Bまたは3Bを微調整し、データに対して高品質で低レイテンシを実現します。これらすべては、Databricks Mosaic AIの統一された体験でアクセス可能です。

DatabricksでのLlama 3.2のファインチューニングは、たった一つのシンプルなコマンドです:

Mosaic AI Modelトレーニングのドキュメントを参照して、詳細情報とチュートリアルをご覧ください!

新しいオープンなマルチモーダルモデル

Llama 3.2シリーズには、視覚的な入力とテキスト入力の両方を可能にする強力な、オープンなマルチモーダルモデルが含まれています。マルチモーダルモデルは、エンタープライズデータインテリジェンスのための多くの新しいユースケースを開きます。ドキュメント処理では、スキャンしたドキュメントとテキスト入力を一緒に分析することで、より完全で正確な分析を提供するために使用できます。eコマースでは、ユーザーが製品の写真をアップロードして、生成された説明に基づいて類似のアイテムを見つける視覚的な検索を可能にします。マーケティングチームにとって、これらのモデルは画像に基づいてソーシャルメディアのキャプションを生成するようなタスクを効率化します。これらのモデルの使用を提供できることを嬉しく思いますDatabricksで、このフロントでのさらなる情報をお待ちください!

ここに、Llama 3.2にテーブルをJSON表現に解析させる例があります:

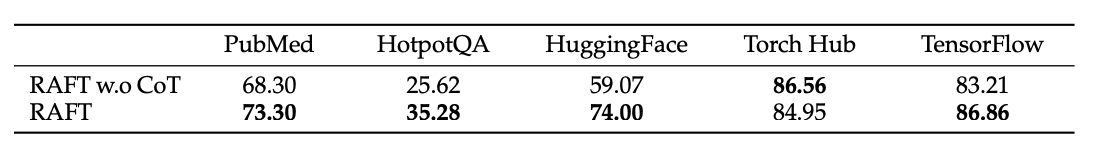

画像(RAFT論文の表2):

プロンプト:テーブルをJSON表現にパースします。

出力:

顧客がDatabricksとオープンモデルでイノベーションを生み出す

多くのDatabricksの顧客がすでにLlama 3のモデルを活用して、GenAIの取り組みを推進しています。皆がLlama 3.2で何をするのか楽しみにしています。

- “Databricksのスケーラブルなモデル管理機能により、私たちは先進的なオープンソースLLMのMeta Llamaを効率的に統合し、新しいAI技術を迅速に顧客に提供することが可能になりました。” - Bryan McCann, 共同創設者/CTO, You.com

- “Databricks Mosaic AIは、私たちが先進的なAIと効果的なデータ管理との強力な関係を示す強化サービスをクライアントに提供することを可能にし、Meta Llamaのような最先端のGenAI技術を簡単に統合することができます。” - データ分析部門副社長、Colin Wenngatz、MNP

- “Databricks Data Intelligence Platformは、私たちがMeta Llamaのような最先端のAIモデルを自社の環境内で安全にデプロイすることを可能にし、機密データを露出することなく行うことができます。 このレベルのコントロールは、データプライバシーの維持とヘルスケア基準の遵守に不可欠です。” - Navdeep Alam, 最高技術責任者, Abacus Insights

- "Databricks Mosaic AIのおかげで、私たちはプロンプトの最適化と指示の微調整をオーケストレーションし、専門的なコーパスからドメイン固有の言語を取り込むオープンソースのLLM、例えばMeta Llamaの性能を向上させ、行動シミュレーション分析のパフォーマンスを向上させ、運用効率を向上させることができました。" - クリス・コフリン、シニアマネージャー、DDI

Databricks Mosaic AIのLlama 3.2を始める

こちらのデプロイメントの手順に従って、ワークスペースから直接Llama 3.2を試してみてください。詳細は以下のリソースを参照してください:

- MetaのLlama 3.2のローンチブログ投稿を読む

- こちらのマルチモーダルノートブック

- Foundationモデルを探索してくださいスタートガイド

- Mosaic AIモデルトレーニングを訪れてドキュメントあなたのデータでのファインチューニングを始めるために

- 大量のデータにLLMを適用するAI機能

- Agent Framework and Evaluationを��使用して、生産品質のAgenticおよびRAGアプリを構築する

- こちらをご覧ください 微調整 と 提供 の価格ページ

次の Databricks GenAIウェビナー に参加してください。10/8/24:データインテリジェンスへのシフト。MetaのVP、Ash JhaveriがオープンソースAIとMeta Llamaモデルの未来について話します