Hochwertige KI-Agent-Systeme entwickeln und implementier

Verbinden Sie Ihre Daten sicher mit beliebigen KI-Modellen, um zielgenau fachspezifische Anwendu

ERFOLGREICHE SPITZENTEAMS DANK MOSAIC AI

Die einzige Unified Platform für Agent-Systeme

Schluss jetzt mit generischen KI-Modellen. Databricks bietet alle Tools, die Ihnen den Aufbau von Agent-Systemen ermöglichen, um korrekte datengestützte Ergebnisse zu erhalten.44 % Steigerung bei der Genauigkeit

10 Mio. $ Produktivitätssteigerung

96 % Treffsicherheit bei den Antworten

Tools für umfassende KI-Agent-Systeme

Agent Bricks

Bauen Sie KI-Agents, die auf Ihren Unternehmensdaten basieren. Databricks Agent Bricks ermöglicht es Ihnen, Qualität und Kosten zu optimieren – mit synthetischen Daten, individueller Evaluierung und automatischem Tuning.

KI-Gateway

Wenden Sie die Daten-Governance konsequent auf jedes GenAI-Modell in Ihrem Unternehmen an.

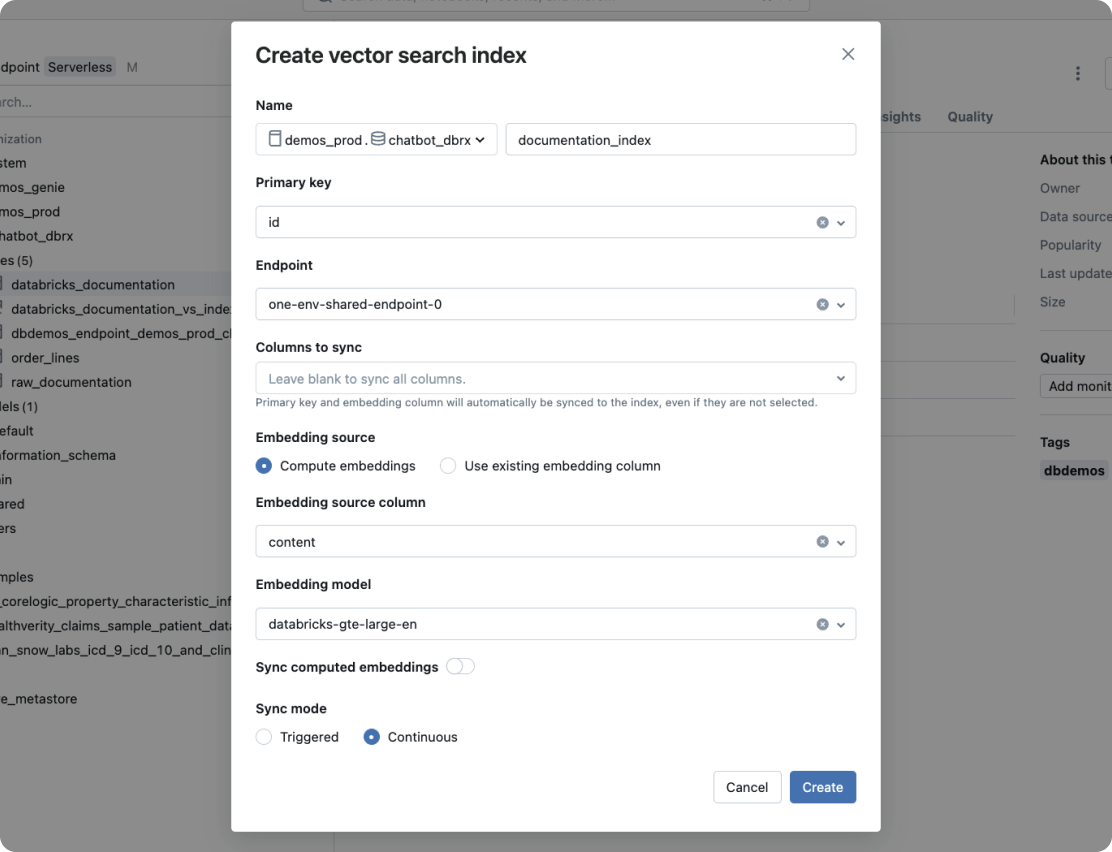

Vector Search

Leistungsstarke Vektordatenbank mit Echtzeitsynchronisierung der Quelldaten.

Agent Framework und Agent Evaluation

Entwickeln Sie mit Agent Framework KI-Agenten in Produktionsqualität. Als integraler Bestandteil des Frameworks stellt Agent Evaluation die Qualität der von Agents generierten Inhalte mittels KI-gestützter Evaluierungen sicher und bietet außerdem eine intuitive Benutzeroberfläche für Feedback durch reale Personen.

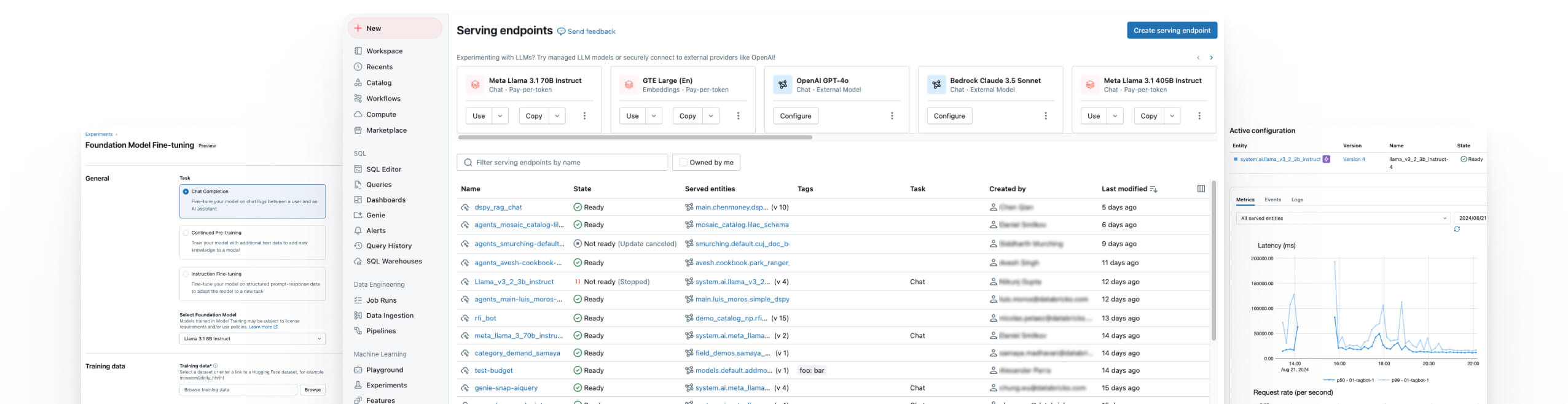

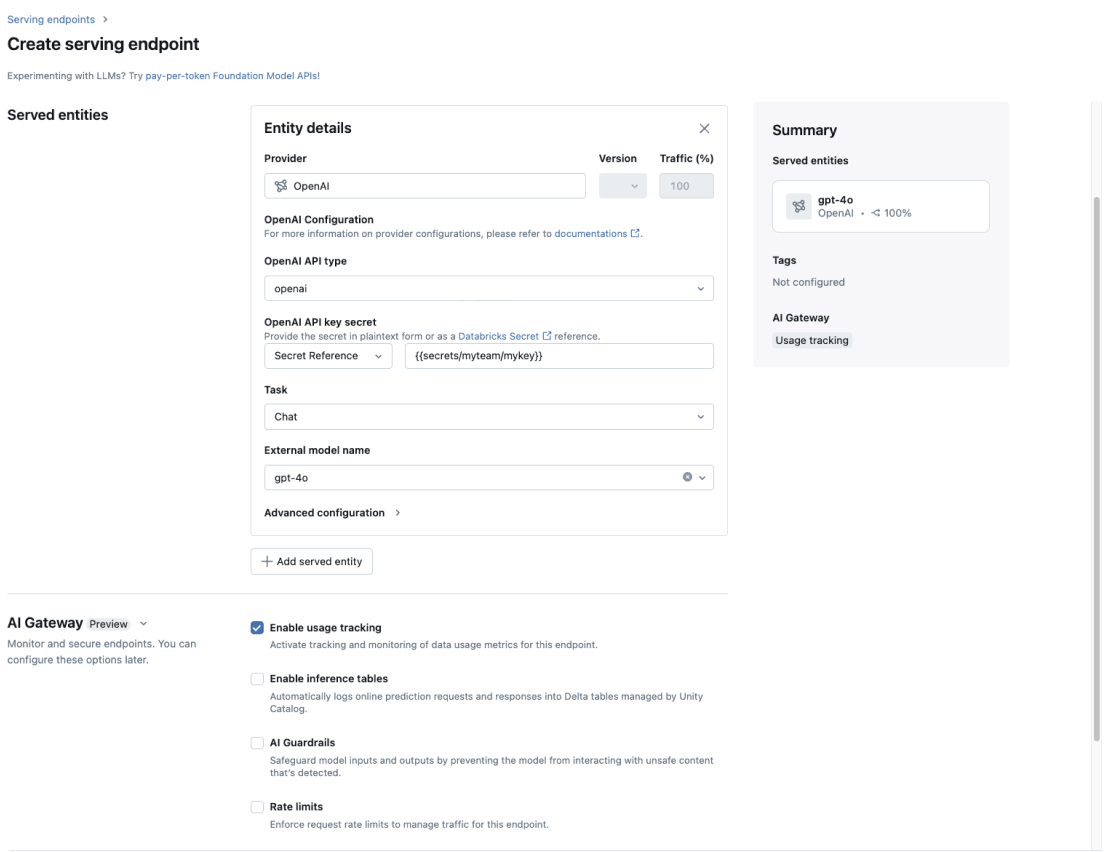

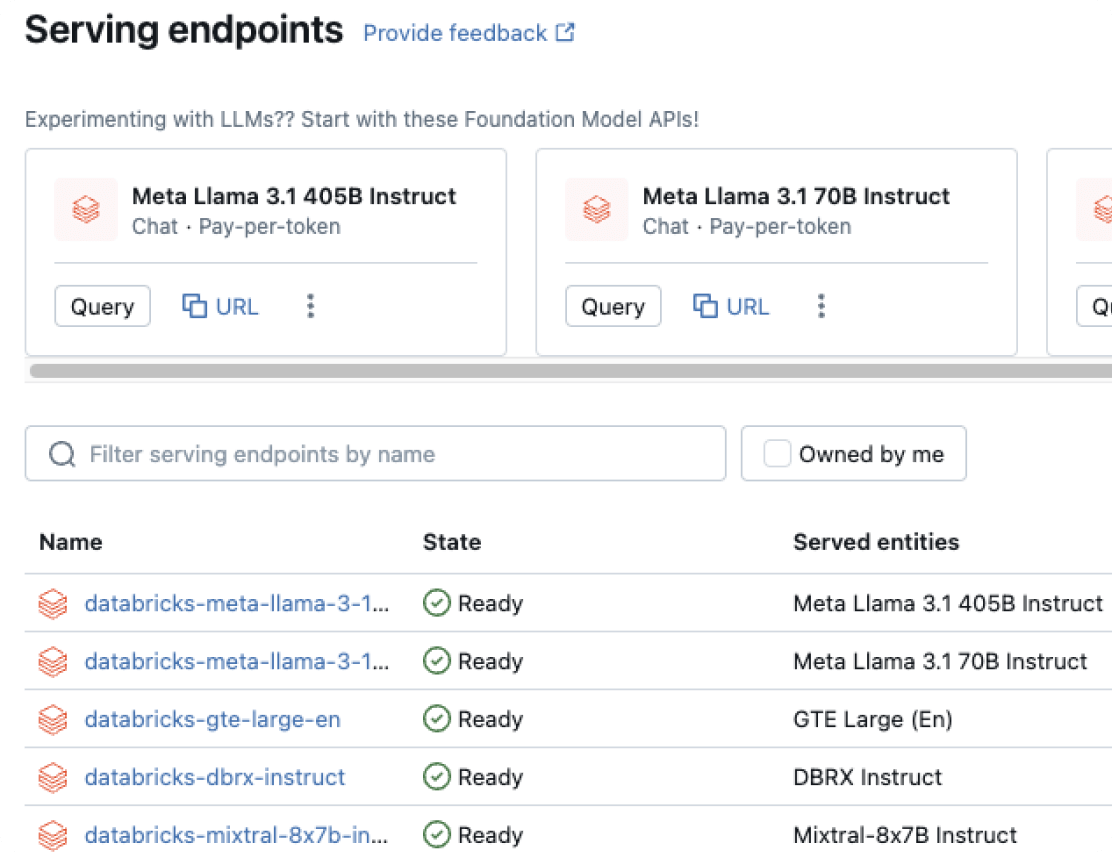

Modellbereitstellung

Einheitliche Implementierung für Agents, GenAI und klassische ML-Modelle.

Model Training

Optimierung von Open-Source-LLMs, Pretraining maßgeschneiderter LLMs und Erstellung klassischer ML-Modelle.

Databricks Notebooks

Steigern Sie die Teamproduktivität mit Databricks Collaborative Notebooks und ermöglichen Sie Echtzeit-Zusammenarbeit und optimierte Data-Science-Workflows.

Managed MLflow

Ergänzt MLflow, eine einheitliche MLOps-Open-Source-Plattform zum Erstellen besserer Modelle und GenAI-Apps, um Zuverlässigkeit, Sicherheit und Skalierbarkeit auf Unternehmensniveau.

Überwachung der Datenqualität

Einfaches, skalierbares Monitoring, das Anomalien erkennt, die Aktualität nachverfolgt und konsistente Qualitätssignale für alle Daten- und KI-Assets liefert.

Die Databricks Data Intelligence-Plattform

Entdecken Sie die gesamte Bandbreite der auf der Databricks Data Intelligence Platform verfügbaren Tools zur nahtlosen Integration von Daten und KI in Ihrem Unternehmen.

Hochwertige Agent-Systeme erstellen

GenAI-Modelle, klassische ML-Modelle und Tools vergleichen und beliebig kombinieren

KI-Modelle effizient verwalten und an Ihre Anforderungen anpassen

Mit Mosaic AI Gateway können Sie Modelle wie OpenAI GPT-4, Meta Llama 3, Anthropic Claude 3 usw. verwalten, die für Ihren Anwendungsfall geeignet sind. Sie können Ihre eigenen benutzerdefinierten Modelle weiter verfeinern oder von Grund auf neu erstellen – seien es Predictive-Modelle oder maßgeschneiderte LLMs. Schließlich können Sie auch KI-Tools erstellen, veröffentlichen und gemeinsam nutzen, um unstrukturierte Daten abzurufen, Code auszuführen oder mit Remote-Diensten zu kommunizieren.

In die Produktion einführen

Effizientere Betriebsabläufe mit einer robusten Lösung für Bereitstellung, MLOps und LLMOps

Mosaic AI Model Serving unterstützt die Implementierung von Agents, Chains, GenAI-Modellen und klassischen ML-Modellen. MLflow als führende Open-Source-Lösung für MLOps und LLMOps bietet Organisationen für alle Modelle Unterstützung bei der Bereitstellung über den gesamten KI-Lebenszyklus vom Training bis zur Implementierung. Es beschleunigt ML- und GenAI-Anwendungsfälle mit einem zuverlässigen Prozess für Datenaufbereitung, Modellentwicklung, Implementierung und Überwachung.

Agent-Leistung im Handumdrehen bewerten und optimieren

Qualität und Zuverlässigkeit Ihrer Agents gewährleisten

Mosaic AI Agent Evaluation stellt eine integrierte Auswertungslösung für Agents dar, die eine beliebige Kombination aus GenAI- und ML-Modellen nutzen. Agent Evaluation misst die Ausgabequalität mit KI-gestützten Judges, die die Antworten bewerten und es ermöglichen, von menschlichen Experten Peer-Feedback zu erhalten. Bei Qualitätsproblemen können Sie die Ursache ermitteln, Behebungsmaßnahmen bewerten und die erneute Implementierung zeitnah vornehmen.

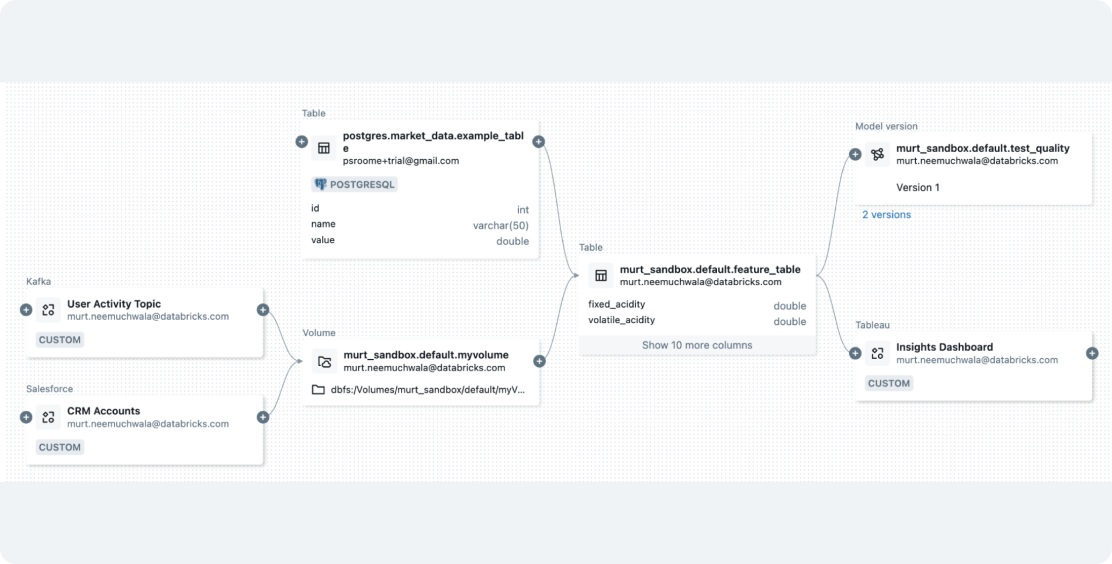

Umfassende Governance für Ihre Agents

Kontrolle und Compliance während des gesamten KI-Workflows aufrechterhalten

Mit Unity Catalog bietet nur Mosaic AI durchgängige Governance für Agents. Sie können Governance und Sicherheitsmaßnahmen auf alle KI-Modelle anwenden, d. h. auch auf solche, die außerhalb von Databricks gehostet werden. Hiermit lassen sich automatisch angemessene Zugriffskontrollen umsetzen, Nutzungsraten begrenzen, schädliche Inhalte unterbinden und die Datenherkunft von den Daten bis zur Implementierung nachverfolgen.

Wagen Sie den nächsten Schritt

Kostenlose GenAI-Schulung

Vertiefen Sie Ihre GenAI-Kenntnisse mit diesem Kurs zum Selbststudium – und erwerben Sie ein branchenweit anerkanntes Abschlusszertifikat von Databricks.

Einstiegshandbuch

Dieses Tutorial zu KI-Agents begleitet Sie vom Proof-of-Concept (POC) bis hin zu einer hochwertigen, produktionsreifen Anwendung mit Mosaic AI.

Häufig gestellte Fragen zu Mosaic AI

Möchten Sie ein Daten- und KI-Unternehmen werden?

Machen Sie die ersten Schritte Ihrer Transformation