AIモデル共有のGAを発表

組織内、またはクラウド、プラットフォーム、リージョン間でAIモデルの検出、評価、インストール、共有、サービングが可能になります。

Summary

- AIモデル共有は、Delta SharingとDatabricks Marketplaceの新しいAIモデルの両方で一般に利用可能(GA)になりました。* このマイルストーンは2024年1月のパブリックプレビュー発表�に続いており、新たなAIモデル共有の顧客やプロバイダー、例えばBitext、Ripple、Cartesia.aiなどとテストされています。そしてAI21 Labs。

- AIモデル共有は、Delta Sharingを使用してAIモデルを安全に共有し、提供することを組織に容易に可能にし、取得、開発、インフラストラクチャの費用を最小限に抑えて総所有コストを削減します。

このブログへの貴重な洞察と貢献に対して、Daniel Benito(CTO、Bitext)、Antonio Valderrabanos(CEO、Bitext)、Chen Wang(リードソリューションアーキテクト、AI21 Labs)、Robbin Jang(アライアンスマネージャー、AI21 Labs)、Alex Godfrey(パートナーマーケティングリード、AI21 Labs)に特別な感謝を述べます。

Databricks Delta SharingとDatabricksマーケットプレイス内のAIモデル共有の一般提供をお知らせすることをうれしく思います。このマイルストーンは、2024年1月のパブリックプレビュー発表に続いています。Public Previewのローンチ以来、我々は新たなAIモデル共有の顧客やプロバイダー、例えばBitext、AI21 Labs、Rippleと共に、AIモデル共有をさらにシンプルにするために取り組んできました。

Delta Sharingを使用して、AIモデルを簡単に共有し、安全に提供することができます�。共有は、組織内またはクラウド、プラットフォーム、地域を超えて外部にも行うことができます。さらに、Databricks Marketplaceには、John Snow Labs、OLA Krutrim、Bitextからの新しい業界特化型AIモデルを含む75以上のAIモデルが登録されています。これには、Databricks DBRX、Llama 3、AI21 Labs、Mistralなどの基礎モデルも含まれます。このブログでは、AIモデル共有のビジネスニーズをレビューし、AI21のJamba 1.5 Mini基盤モデルとBitextモデルによって推進されるユースケースについて深く掘り下げます。

AIモデルは現在、Unity Catalog からすぐに利用できるようになり、ユーザーが効率的にモデルにアクセスし、デプロイするプロセスが合理化されています。この開発はユーザー体験を単純化するだけでなく、AIモデルのアクセシビリティを向上させ、さまざまなプラットフォームや地域でのシームレスな統合とデプロイメントを支援します。

AIモデル共有の3つの利点

これが、初期の採用者やローンチパートナーとのDatabricksとのAIモデル共有の3つの利点です

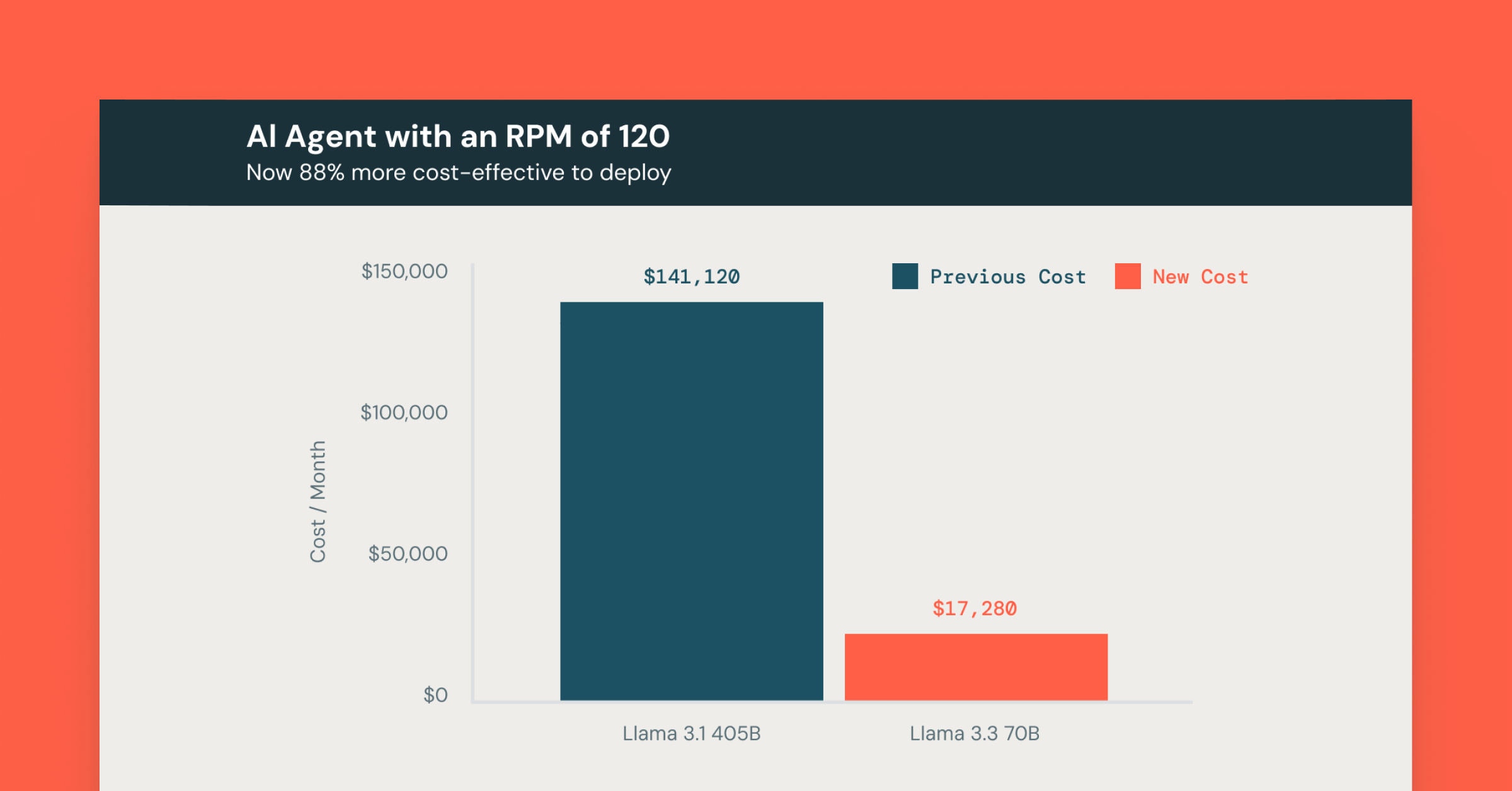

- 低コスト: Delta Sharingを用いたAIモデルの共有は、取得、開発、インフラストラクチャの費用を最小限に抑えることで、総所有コストを削減します。組織は、事前に構築されたモデルやサードパーティのモデルを、Delta SharedまたはDatabricks Marketplaceからアクセスし、初期�投資と開発時間を削減することができます。Delta Sharingを用いてクラウドやプラットフォーム間でモデルを共有することで、インフラの使用を最適化し、冗長性と費用を削減しながら、モデルをエンドユーザーに近い場所にデプロイして遅延を最小限に抑えます。

- 製品品質:Delta Sharingを使用すると、顧客のユースケースに適したモデルを取得し、それらをAIライフサイクル全体のための単一のプラットフォームで強化することができます。モデルをDatabricks Mosaic AIプラットフォームに共有することで、顧客はAIとガバナンス機能にアクセスし、任意のモデルを製品化することができます。これには、モデルの提供から微調整までのエンドツーエンドのモデル開発機能、およびUnity Catalogのセキュリティと管理機能(リネージとLakehouse Monitoringなど)が含まれており、モデルと関連データに対する高い信頼性を確保します。

- 完全なコントロール:サードパーティのモデルと作業する際、AIモデル共有は、対応するモデルとデータセットに対する完全なコントロールを持つことを可能にします。Delta Sharingでは、顧客がモデルパッケージ全体を取得できるため、モデルとデータは顧客のインフラ内に残り、顧客の管理下にあります。顧客の代わりにモデルを提供するプロバイダーに機密データを送る必要はありません。

では、AIモデル共有はどのように機能するのでしょうか?

AIモデル共有はDelta Sharingによって支えられています。プロバイダーは、Delta Sharingを直接使用してAIモデルを顧客と共有するか、またはDatabricks Marketplaceにリストアップすることで共有することができます。これもDelta Sharingを使用します。

Delta Sharingは、必要な場所でAIモデルを簡単に使用することを可能にします。モデルはどこでも訓練でき、手動で移動させることなくどこでも使用できます。モデルの重み(つまり、AIモデルが学習中に学んだパラメータは、自動的にサービングエンドポイント(つまり、モデルが「存在する」場所)に引き込まれます。これにより、各モデルのトレーニングや微調整後の煩雑なモデル移動が不要となり、真実の単一ソースを保証し、サービングプロセスを合理化します。例えば、顧客は最も安価なトレーニングインフラストラクチャを提供するクラウドと地域でモデルを訓練し、その後、エンドユーザーに近い別の地域でモデルを提供することで、推論遅延(つまり、AIモデルがデータを処理し結果を提供するまでの時間)を最小限に抑えることができます。

Databricksマーケットプレイスは、Delta Sharingによって駆動され、75以上のAIモデルを簡単に見つけて使用することができます。これらのモデルはあたかもあなたのローカルシステム上にあるかのように設定でき、Delta Sharingはそれらをデプロイメントやアップグレード中に自動的に更新します。知識ベースの管理などのタスクのために、自分のデータを使用してモデルをカスタマイズすることもできます。プロバイダーとして、モデルをすべてのDatabricksクライアントと共有するためには1つのコピーだけが必要��です。

ビジネスへの影響は何ですか?

AIモデル共有のパブリックプレビューが2024年1月に発表されて以来、私たちはいくつかの顧客やパートナーと協力して、AIモデル共有が組織に大幅なコスト削減をもたらすことを確認してきました。

「私たちは一部の製品で強化学習(RL)モデルを使用しています。教師あり学習モデルと比較して、RLモデルは訓練時間が長く、訓練プロセスには多くのランダム性が含まれています。これらのRLモデルは、3つのワークスペースにAWSの別々の地域でデプロイする必要があります。モデル共有により、一つのRLモデルを再訓練することなく、またはモデルを移動するための煩雑な手順なしに、複数のワークスペースで利用できます。" — Mihir Mavalankar マシンラーニングエンジニア、Ripple

AI21 LabsのJamba 1.5 Mini:大規模なコンテキストAIモデルをDatabricksマーケットプレイスに導入

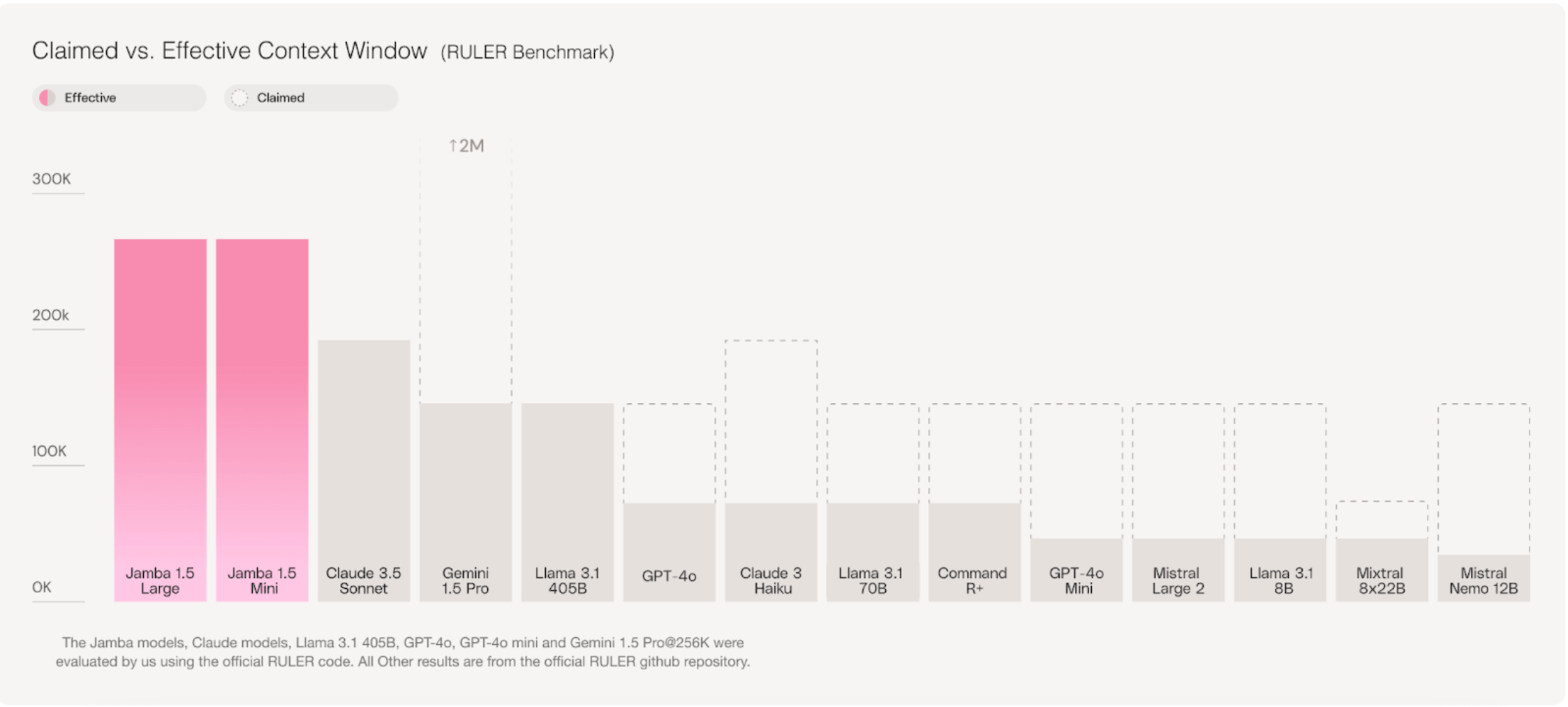

AI21 Labsは、生成AIと大規模言語モデルのリーダーであり、Jamba 1.5 Mini、Jamba 1.5モデルファミリーの一部をDatabricksマーケットプレイスに公開しました。AI21 LabsのJamba 1.5 Miniは、エンタープライズ向けのAI言語モデルに対する新しいアプローチを導入します。その革新的なハイブリッドMamba-Transformerアーキテクチャは、256Kトークンの効果的なコンテキストウィンドウを可能にし、優れた速度と品質を実現します。Miniの計算効率の最適化により、単一のGPUで最大140Kトークンのコンテキスト長を処理することができます。

"AI21 Labsは、Jamba 1.5 MiniがDatabricks Marketplaceに登場したことをお知らせします。Delta Sharingを使用すると、企業は私たちのMamba-Transformerアーキテクチャにアクセスでき、256Kのコンテキストウィンドウを特長としています。これにより、変革的なAIソリューションのための優れた速度と品質が確保されます。 — Pankaj Dugar、SVP&GM、AI21 Labs

AIモデルにおける256Kトークン効果的コンテキストウィンドウとは、モデルが一度に256,000トークンのテキストを処理し考慮する能力を指します。これは重要なことで、AI21 Modelsモデルが大規模で複雑なデータセットを扱うことを可能にし、長大なドキュメントや複雑なデータ重視のワークフローなど、広範で詳細な情報を理解し分析する必要があるタスクに特に有用で、任意のRAGベースのワークフローの検索ステージを強化します。Jambaのハイブリッドアーキテクチャは、通常、TransformerベースのLLMの主張するコンテキストウィンドウで見られるような、コンテキストが増えるにつれてモデルの品質が低下することを防ぎます。

このビデオチュートリアルをご覧ください。Databricks MarketplaceからAI21 Jamba 1.5 Miniモデルを取得し、それを微調整し、提供する方法を示しています。

ユースケース

Jamba 1.5 Miniの256kコンテキストウィンドウは、モデルが一度に800ページ相当のテキストを効率的に処理できることを意味します。これらは、異なる業界のDatabricksの顧客がこれらのモデルをどのように使用できるかのいくつかの例です

- 文書処理:顧客はJamba 1.5 Miniを使用して、長いレポート、契約、または研究論文を素早く要約することができます。金融機関にとって、これらのモデルは、収益報告書を要約したり、長い金融文書から市場のトレンドを分析したり、規制申告書から関連情報を抽出することができます

- エージェントワークフローの強化:医療提供者のために、このモデルは複数の患者データソースを分析し、治療の推奨を提供することで複雑な医療決定プロセスを支援することができます。

- 検索補強生成(RAG)プロセスの改善:小売企業向けのRAGシステムでは、製品情報や顧客履歴の幅広い範囲を考慮することで、モデルは顧客の問い合わせに対するより正確で文脈に適した回答を生成す�ることができます。

Bitext Verticalized AI ModelsがDatabricks Marketplaceでどのように顧客のオンボーディングを改善するか

Bitextは、Databricksマーケットプレイスで事前に訓練された垂直モデルを提供しています。これらのモデルは、Mistral-7B-Instruct-v0.2モデルのバージョンで、チャットボット、バーチャルアシスタント、リテールバンキング領域のコパイロットの作成に微調整されており、顧客に対して迅速かつ正確な銀行ニーズに関する回答を提供します。これらのモデルは、GPT、Llama、Mistral、Jamba、OpenELMなど、任意の基盤モデルのファミリーに対して作成することができます。

ユースケース:AIを用いたオンボーディングの改善

主要なソーシャルトレーディングアプリが、ユーザーオンボーディング中に高いドロップアウト率を経験していました。それは、静的なフォームを会話型、直感的でパーソナライズされたユーザーエクスペリエンスに変えるために、Bitextの事前学習済みのバンキングモデルを活用し、オンボーディングプロセスを刷新しました。

Bitextは、垂直化されたAIモデルを顧客と共有しました。そのモデルを基に、データサイエンティストが一般的なFAQなどの顧客固有のデータを用いて初期の微調整を行いました。このステップにより、モデルはユーザーベースの独自の要件と言語を理解することが確認されました。これに続いて、Databricks Mosaic AIを用いた高度なファインチューニングが行われました。

Bitextモデルが微調整された後、Databricks AIモデルサービングを使用してデプロイされました。

- ファインチューニングされたモデルはUnityカタログに登録されました

- エンドポイントが作成されました。

- モデルはエンドポイントにデプロイされました

この協力は、ソーシャルファイナンスセクター内のユーザーインタラクションに新たな基準を設け、顧客エンゲージメントとリテンションを大幅に向上させました。共有AIモデルによるスタートアップのおかげで、実装全体が2週間以内に完了しました。

Databricks MarketplaceからBitext Verticalized AI Modelをインストールし、微調整する方法を示すデモをここでご覧ください。

「大量の訓練データが必要な一般的なモデルとは異なり、特定の業界向けの特化したモデルから始めると、カスタマイズに必要なデータが減ります。これにより、顧客はカスタマイズされたAIモデルを迅速にデプロイできます。私たちはAIモデル共有にとても興奮しています。私たちの特化したAIモデルは、Databricksマーケットプレイスで利用可能で、お客様はリソースコスト(データサイエンティストの数の削減と計算要件の低減)を最大60%�削減し、運用の中断(テストとデプロイメントの迅速化)を最大50%節約する経験をしています。" — アントニオ S. ヴァルデラバノス、Bitextの創設者兼CEO

Bitextの2ステップモデルトレーニングアプローチのコスト削減

|

コストコンポーネント |

一般的なLLMアプローチ |

BitextのVerticalized ModelがDatabricksマーケットプレイスに登場 |

コスト削減(%) |

|

バーティカライゼーション |

高 - セクター&使用ケースのための広範な微調整 |

低 - 事前に微調整された垂直LLMから始めます |

60% |

|

会社のデータによるカスタマイズ |

ミディアム - さらなる微調整が必要です |

低 - 特定のカスタマイズが必要 |

30% |

|

トータルトレーニング時間 |

3-6ヶ月 |

1-2ヶ月 |

50-60%の削減 |

|

リソース割り当て |

高 - データサイエンティストと計算能力の増加 |

低 - より少ない集中力 |

40-50% |

|

運用の中断 |

高 - 長期的な統合とテストフェーズ |

低 - 高速なデプロイメント |

50% |

アクションの呼びかけ

AIモデル共有がDelta Sharingと新しいAIモデルのDatabricks Marketplaceの両方で一般に利用可能(GA)になったので、以下をお勧めします:

- データとAIサミットのセッション「新しいAIユースケースの解放」をチェックして、さらなる洞察を得てください。

- Delta Sharingを使用して事前に訓練されたAIモデルをデプロイし、特定のニーズに合わせてカスタマイズする方法を説明するデモをご覧ください。

- Databricksマーケットプレイスを訪れて、利用可能なすべてのAIモデルのリストを閲覧してください。