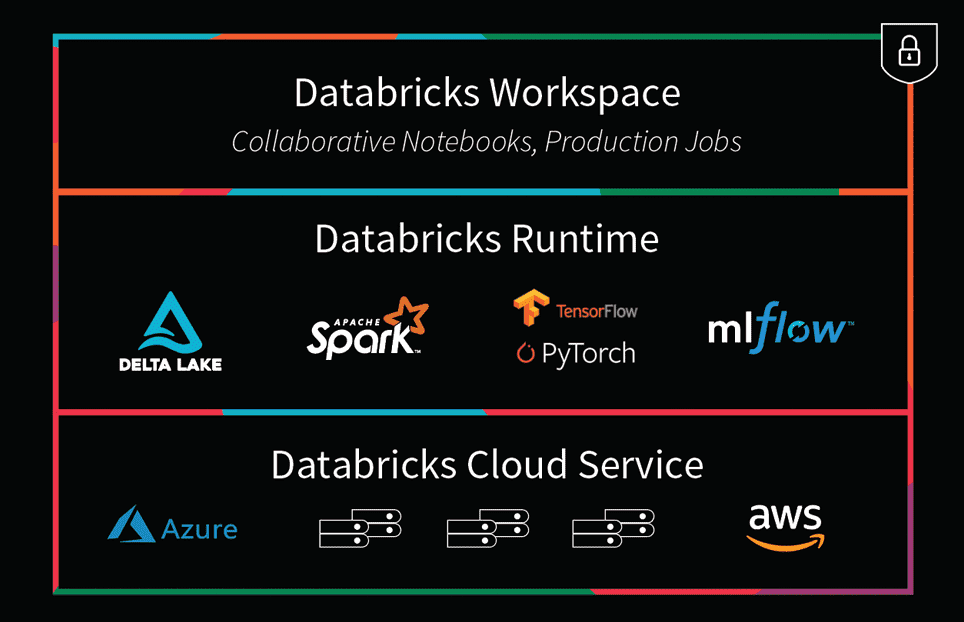

Comparing Apache Spark™ and Databricks

Apache Spark capabilities provide speed, ease of use and breadth of use benefits and include APIs supporting a range of use cases:

- Data integration and ETL

- Interactive analytics

- Machine learning and advanced analytics

- Real-time data processing

Databricks builds on top of Spark and adds:

- Highly reliable and performant data pipelines

- Productive data science at scale

Want to learn more? Visit our platform page.